Introdução

A pesquisa qualitativa é uma atividade situada que localiza o observador no mundo, se compõe por um conjunto de práticas interpretativas e materiais que tornam o mundo visível, transformando-o em uma série de representações, incluindo notas de campo, entrevistas, conversas, fotos, gravações e memorandos. Envolve, portanto, uma abordagem interpretativa, naturalista ao mundo. Isso significa que os pesquisadores qualitativos estudam as coisas em seus ambientes naturais, tentando dar sentido ou interpretar fenômenos nos termos das significações que as pessoas trazem para eles (DENSIN; LINCOLN, 2011).

Essas pesquisas têm como características: o cenário natural, o pesquisador como instrumento fundamental da coleta de dados, o uso de métodos múltiplos, um design que emerge em cada projeto de pesquisa empreendido, foco no significado para os participantes, reflexiva e raciocínio complexo por meio da perspectiva holística (CRESWELL, 2013). Com essa multiplicidade, complexidade de características e seu avanço crescente, os pesquisadores qualitativos se vêm confrontados com diversos desafios.

Primeiro, surge o apelo de diferentes revistas científicas para que, não apenas, seja derrubada a divisão quantitativa/qualitativa (ERCIKAN; ROTH, 2006), mas para que ambos os tipos de estudos sejam complementares e atuem em um movimento circular, podendo seus resultados serem cruzados, compartilhados e complementados um pelo outro (CRESWELL, 2003).

Segundo, outro desafio se refere à possibilidade de utilização de uma diversidade cada vez maior e não previsível de fontes de dados nas pesquisas qualitativas (LEEDY; ORMROD, 2001). Enquanto nas pesquisas quantitativas os dados já são coletados de forma sistematizada, normalmente com instrumentos fechados ou surveys, nas pesquisas qualitativas além das fontes de origem textual, tais como, entrevistas abertas, semiestruturadas, análises documentais, roteiros de observação e relatos autobiográficos, surge a possibilidade de utilização de imagens, áudios, vídeos e ainda os dados virtuais, gerados por meio de fóruns, blogs e redes sociais. Soma-se a isso a necessidade de articular, associar e discutir essas informações com resultados quantitativos.

Consequentemente urge ao pesquisador qualitativo instrumentalizar-se em face desses desafios. O processo de pesquisa por meio da bricolagem já não é mais suficiente (WALTER; BACH, 2015), assim como a descrição individualizada de trechos das falas dos sujeitos nos relatórios de pesquisa. De forma individualizada são infrequentes os cruzamentos dos indicadores levantados pela pesquisa com dados demográficos que poderiam explicar particularidades e especificidades da situação encontrada. Também é raro encontrarmos a descoberta de coocorrências dos indicadores levantados na codificação, e a geração de redes conceituais que nos permitam compreender as nuances e articulações presentes em um resultado qualitativo. É fato que, no contexto de complexidade social em que vivemos, precisamos avançar e buscar novos instrumentos que nos auxiliem a ter uma compreensão mais ampla e, simultaneamente, mais profunda dos resultados de pesquisa qualitativamente descritos.

Questionamentos sobre a necessidade, ou não, de mais instrumentos para a pesquisa qualitativa datam o início dos anos de 1990, quando Tesch (1990) apontava alguns mitos que estavam presentes na tomada de decisão sobre a utilização, ou não, de softwares para pesquisas qualitativas. Mesmo com a evolução dos softwares, há mitos que ainda se fazem presentes. Um dos principais, assinalados por Tesch (1990), e que alguns pesquisadores discretamente manifestam, é o receio de que o software determinaria a condução do processo de análise de dados. Se isso ocorresse de fato, não teríamos inúmeros trabalhos conduzidos em uma mesma área ou em áreas diferentes com o mesmo software, utilizando encaminhamentos metodológicos e procedimentos analíticos tão distintos.

Uma das conclusões de Tesch (1990), e que permanece válida até hoje, é que o conhecimento sobre o objeto de estudo, sobre o método de análise de dados escolhido e a criatividade do pesquisador é que garantirão um uso eficiente do software. Portanto, seria fundamental ao pesquisador tomar decisões sobre seu processo de análise de dados, logo, planejá-lo e conhecê-lo profundamente antes de se aventurar na escolha ou no uso de um software específico (MACMILLAN; KOENIG, 2004).

Esse entendimento nos motivou a conduzir este trabalho apresentado no XII EDUCERE, no qual estabelecemos como objetivo identificar as apropriações do software feitas pelos estudantes na condução do seu processo de análise de dados e os desafios transpostos por eles para essa apropriação.

Para isso, resgatamos pesquisas realizadas por estudantes de Pós-graduação que participaram da disciplina “Análise de dados qualitativos utilizando recursos tecnológicos”, na PUCPR, desde 2004, na qual o uso do software ATLAS.ti era associado à técnica de análise de conteúdo proposta por Bardin (1977; 2006; 2009) e outros casos, de estudantes que participaram de formação para uso do mesmo software por meio de oficinas oferecidas em diversas universidades brasileiras. Trazemos ainda à tona a experiência de quatro ex-alunos de diferentes programas de Pós-graduação1 que utilizaram o software ATLAS.ti em suas pesquisas, aos quais agradecemos formalmente a nobreza em compartilhar com os colegas os anseios, desafios e conquistas nessa etapa de formação como pesquisadores.

Para discutir o processo de apropriação, primeiramente apresentamos algumas alternativas no processo de tratamento de dados qualitativos utilizando o software ATLAS.ti. Na sequência, buscamos relacionar os limites e possibilidades de utilização apresentados nas dissertações e teses produzidas pelos estudantes, às alternativas disponíveis pelo software.

O processo de análise de dados qualitativos utilizando o ATLAS.ti

A análise na pesquisa qualitativa consiste inicialmente na preparação e organização dos dados (logo, textos transcritos, ou imagens, como vídeos e fotografias), para então proceder-se à redução dos dados a temas por meio de um processo de codificação e condensação dos códigos, para finalmente apresentar sua representação em figuras, tabelas, ou em discussão (CRESWELL, 2013).

Contudo, a análise de dados qualitativa pode se iniciar já durante a coleta de dados (MILES; HUBERMAN, 1994), quando o pesquisador ao estar em campo acompanhando, observando ou entrevistando constitui seu diário de bordo (MACHADO, 2016). Esse diário poderá compor o corpus de análise e nele conterão informações e reflexões únicas que poderão ser confrontadas ou enriquecer a análise do material coletado.

Ao descrever o processo de análise via grounded theory ou teoria fundamentada nos dados, Tarozzi (2011) compara a utilização de diário de pesquisa (ou de bordo) com os memorandos (memos). A preocupação do autor, em realizar a diferenciação, está no fato de que ao analisar os dados por meio da grounded theory, o pesquisador qualitativo realiza simultaneamente a coleta e a análise de dados, empreendendo a codificação e categorização em uma perspectiva espiral e não linear, até a saturação teórica e a emersão de uma teoria - por isso a denominação de ancorada ou fundamentada nos dados. O processo de análise é permeado pelo uso de memorandos e também do diário de pesquisa, com funções distintas. Ao primeiro cabe registrar o que “não é óbvio”, os questionamentos, as justificativas e a argumentação que se constroem no e a partir do processo de decisão do pesquisador. Os memorandos são para enfatizar trechos essenciais, destacar as articulações e associações fundamentais para a realização da análise e prestar contas “das perguntas que se fazem aos dados e às categorias e das razões em virtude das quais são dadas apropriadas respostas às mesmas” (TAROZZI, 2011, p. 76). Embora existam momentos nos quais o uso possa coincidir, ao diário de pesquisa cabe mais um acompanhamento pessoal da pesquisa, com autorreflexão e registros que enriqueçam a análise, mas não a constituam em si.

Verifica-se, então, que diferentes estratégias podem ser utilizadas no processo de análise de dados qualitativa, tais como: esboçar ideia; tomar notas; registrar palavras-chaves; identificar códigos; identificar temas; contar palavras; contar frequências de códigos; relacionar categorias; relacionar categoria a um quadro teórico; criar pontos de vistas; e elaborar esquemas de visualização de dados.

Atualmente, diferentes softwares oferecem ferramentas que podem auxiliar o pesquisador na aplicação dessas e outras estratégias, assim como na gestão de seus resultados.

O Quadro 1 evidencia que, embora os softwares de análise de dados disponham de diferentes funcionalidades que podem favorecer a qualidade e o rigor científico no tratamento de dados, são as atribuições do pesquisador que efetivamente são essenciais na interpretação e representação na pesquisa qualitativa. As diversas formas de aplicação do software e sua potencialidade em lidar com grandes volumes de dados são úteis e importantes. Porém, reforçam o quanto é fundamental ao pesquisador desenvolver um plano de análise de dados, coerente com seu problema de pesquisa e que permita a melhor exploração, não apenas dos dados, mas também do suporte oferecido pelo programa.

Quadro 1: Relação entre pesquisador e software de análise de dados qualitativos

| Atribuições do Pesquisador | Atividades relativas ao software de análise de dados |

|---|---|

| Criação e organização dos arquivos com os dados | Atua como banco de dados das informações e documentos de pesquisa. |

| Leitura dos dados e das anotações registradas na etapa de coleta visando uma primeira análise | Possibilita fácil acesso, busca e resgate de dados, sejam eles arquivos de texto, áudio, fotos ou vídeos. Facilita um exame minucioso. |

| Início da codificação, a partir do plano de análise de dados determinado pelo objetivo de pesquisa | Recupera anotações (memos) realizadas ao longo do percurso. |

| Classificação e categorização dos dados, estabelecendo relações e conexão entre os dados, entre os dados e os perfis dos sujeitos pesquisados, com os conceitos teóricos | Permite relacionar e associar os dados, gerando relatórios e imagens (facilitando comparações), assim como frequências de palavras, por exemplo. Dá suporte a apresentação visual dos dados. |

Fonte: as autoras, a partir de CRESWELL (2013)

Entre os softwares de análise de dados qualitativos está o ATLAS.ti, que iniciou seu processo de comercialização em 1993 e tem sua fonte de desenvolvimento localizada em Berlin-Alemanha.

O software ATLAS.ti facilita o processo de análise de dados qualitativos e ajuda a conduzir um processo de análise fundamentado em evidências, além de possibilitar a recuperação dos caminhos de análise percorrido pelo pesquisador (CONTRERAS, 2015). Também auxilia a organizar e manter um banco de dados tanto dos dados brutos (por instrumento de coleta) como dos dados sistematizados visualmente (por sujeitos ou categorizados em relação aos objetivos de pesquisa), o que permitem um acesso mais ágil no momento de análise (MEYER, 2010).

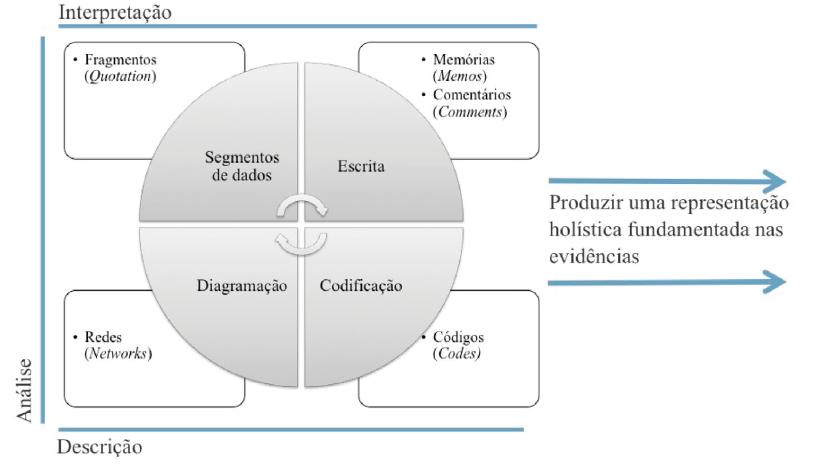

O trabalho no interior do software é interativo, por meio da oferta ao pesquisador de ferramentas para descrição, análise e interpretação dos dados que permitirão produzir uma representação holística fundamentada nas evidências. Isso transcorre por meio dos processos de: segmentação de dados, codificação, escrita e diagramação (Figura 1). Contudo, antes da execução desses processos se dá a preparação dos dados para que se constitua o corpus da pesquisa.

A constituição do corpus se inicia quando o pesquisador começa a organizar fisicamente o material coletado para facilitar o acesso aos documentos, seja por ordem de data de coleta, tipos de fontes, momentos específicos da coleta ou outras formas. Essa organização se dá virtualmente, e começa pela nomenclatura atribuída a cada documento, podendo ser um arquivo de texto do Word (.doc ou .txt), imagens (.jpg), arquivos no formato .pdf, entre outros, visto que ao utilizar o ATLAS.ti este nome pode ser associado aos extratos do documento analisado, permitindo ao leitor conhecer o documento de origem do fragmento2 selecionado na análise.

Outra decisão a ser tomada é quanto ao conteúdo que será inserido em cada arquivo, por exemplo: questionários quando preenchidos em documento Word normalmente são individualizados e inseridos no software em arquivos separados (FERREIRA, 2015); porém, quando são elaborados por ferramentas específicas para realização de surveys, tais como Qualtrics ou Google Forms, geram arquivos no formato Excel, nos quais, cada linha corresponde a um sujeito e cada coluna a uma questão, podendo ser importados pelo ATLAS.ti como survey sendo cada linha tratada como um participante individual. Para entrevistas, o pesquisador terá de tomar a decisão se serão transcritas na íntegra e inseridas em arquivo de texto individualmente ou se serão analisadas por áudio e transcritos apenas os estratos selecionados durante a análise dos dados. Para grupos focais e fóruns de discussão (BUCHI, 2006; SILVA, 2010; SIEVERT, 2013) ou em mensagens trocadas em redes sociais por um grupo (ex. Twitter, Facebook), as discussões são normalmente inseridas em um único arquivo, pois, normalmente deseja-se conhecer o processo de interação ocorrido nas trocas de mensagens.

Buchi (2006) realizou esse tipo de análise com a versão 4.1 do software, o que gerou um trabalho maior de preparação de dados copiando e colando cada mensagem trocada entre os participantes da pesquisa para um documento Word, retirando caracteres especiais e tabulações que pudessem comprometer a visualização dos dados dentro do software. Silva (2010), que já utilizava a versão 5.0, conseguiu extrair todas as mensagens uma única vez do ambiente virtual no qual foi realizado o fórum, ordenando-as alfabeticamente por participante, pois seu problema de pesquisa não se relacionava às interações. Sievert (2013) ao utilizar a versão 7.0 pode copiar as informações do ambiente ordenadas tematicamente, guardando a ordem e interação entre os participantes.

Por esses exemplos, observa-se que, já nessa fase, é essencial o planejamento da organização virtual das informações recolhidas visando atender os objetivos propostos pela pesquisa, caso contrário após a análise o pesquisador não conseguirá fazer os questionamentos necessários para obter do software os cruzamentos esperados. Além desses cuidados, para uma melhor organização da pesquisa é recomendável que seja criada uma pasta que abrigará todos os documentos relacionados ao projeto de pesquisa.

Após essa organização virtual do material a ser analisado, o projeto é criado dentro do software ATLAS.ti, denominado pelo software como Hermeneutic Unit. Ressalta-se que um projeto, ou uma Hermeneutic Unit, deve conter todo o Corpus de análise da pesquisa, todos os documentos que compõem o processo de análise de dados e auxiliarão a responder a questão de pesquisa proposta.

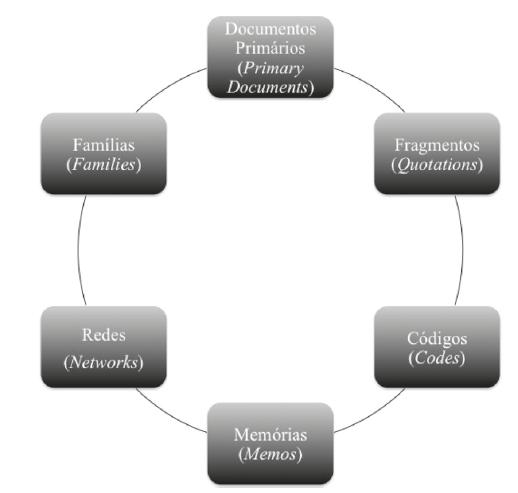

O ATLAS.ti oferece seis objetos (Figura 2) essenciais na fase que Saldaña (2016) denomina de 1º. Ciclo de Codificação em um projeto de análise de dados qualitativos: documentos primários; excertos; códigos; memórias; redes e famílias. Esses objetos coexistem em relação uns aos outros e estão integrados a uma unidade hermenêutica (projeto).

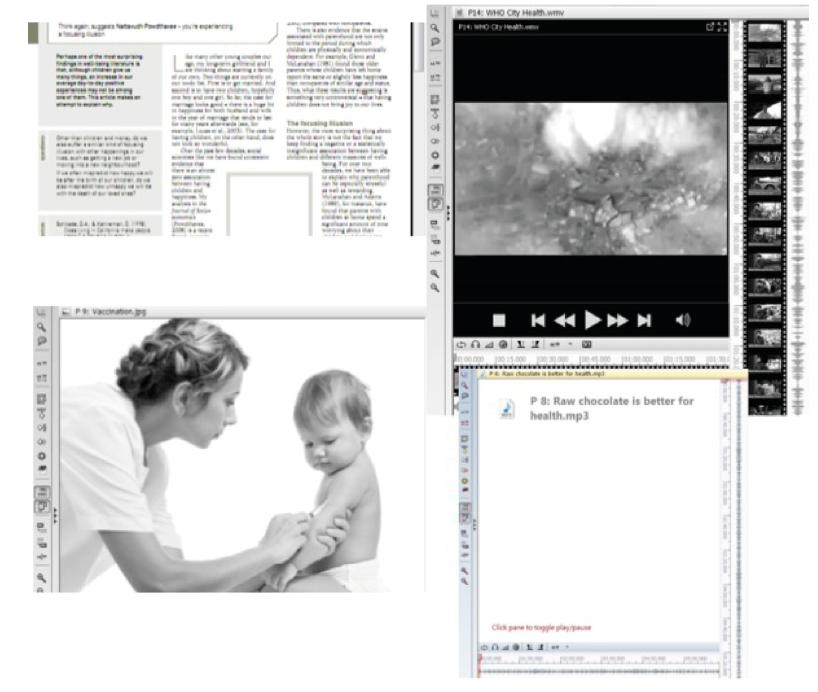

Os documentos primários (Figura 3) são as fontes de dados coletadas no campo de pesquisa, sejam elas questionários, entrevistas, imagens, vídeos e fontes oriundas do Google Earth, não tendo uma limitação de tamanho.

Os fragmentos (Figura 4) são os segmentos de texto, vídeo ou áudio, ou ainda, partes de imagem, de qualquer tamanho que contém algo significativo que possa auxiliar o pesquisador a responder a questão de pesquisa proposta. Eles são objetos independentes e podem, ou não, estar associados a códigos, como também podem estar relacionados entre si no mesmo documento ou entre documentos.

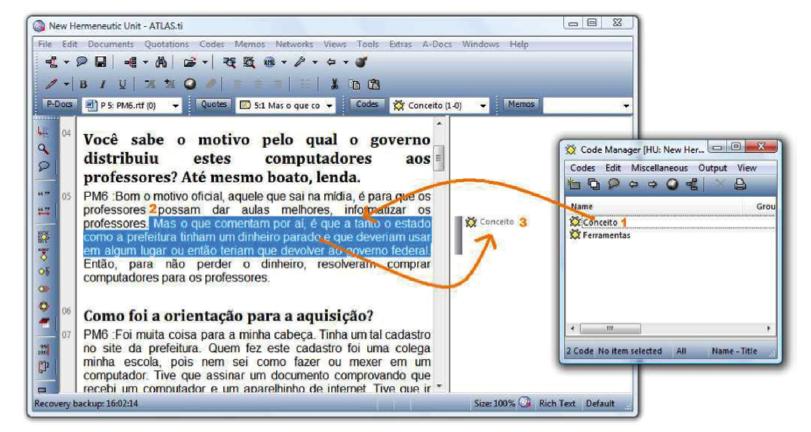

Os códigos (Figura 5) correspondem a uma denominação atribuída pelo pesquisador aos segmentos que possuem características em comum. Saldaña (2016, p. 3) os define como “palavra ou frase curta que simbolicamente atribui, salienta a essência de captura e/ou atributo evocativo para uma porção de dados baseada em linguagem ou visualmente”. Eles normalmente são associados aos fragmentos, mas não obrigatoriamente. Também podem ser agrupados a outros e representados semanticamente.

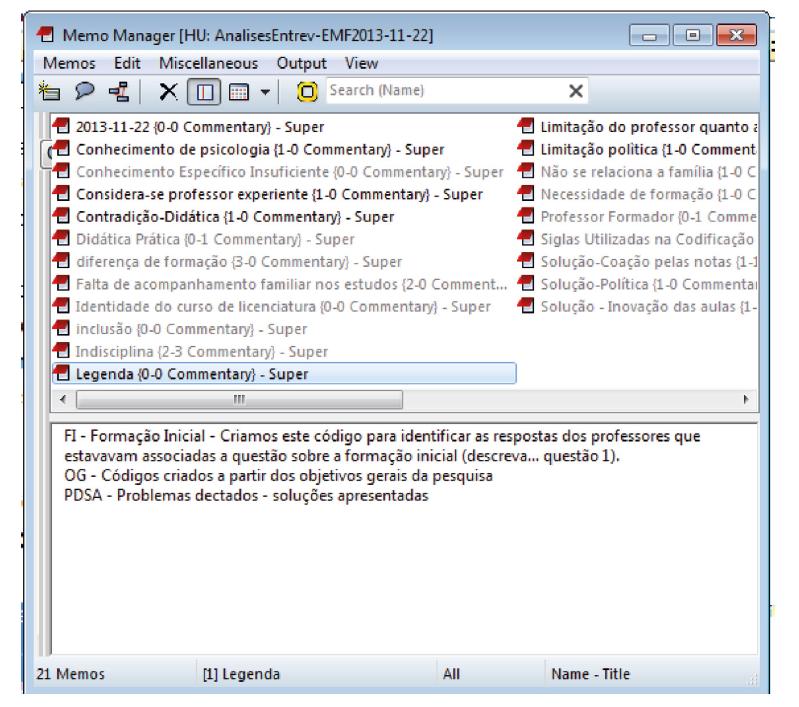

As memos - memórias (Figura 6) são anotações realizadas pelo pesquisador que o ajudarão a compreender o excerto selecionado ou associações feitas relativas a alguma teoria que possa explicar o que foi selecionado, ou ainda qualquer ordem de anotação que possa contribuir para as inferências que serão feitas após a codificação e análise. Para Saldaña (2016, p. 44) “as memos analíticas são de alguma forma comparável a entradas de diário da pesquisa ou blogs, um lugar para ‘Despejar seu cérebro’”. É, portanto, um espaço de integração, para reflexão e busca de sentido. Podem estar ou não associadas aos fragmentos, códigos ou outras memos.

O processo de análise de dados inicia-se pela leitura flutuante e exploração dos documentos inseridos no projeto (BARDIN, 2009) extraindo as unidades de sentido do texto. Essas unidades se referem aos fragmentos que contém informações que possam contribuir para responder a questão de pesquisa. Saldanã (2016) sugere um processo de criação de free quotations3 podendo ser nomeadas pelo seu conteúdo e ainda comentadas utilizando o recurso de criação de memos existente no software. Essas memórias são fundamentais para que se inicie a compreensão dos dados da pesquisa e de algumas ideias que surgem na primeira leitura. Também podem ser questões a serem confirmadas em uma análise mais profunda.

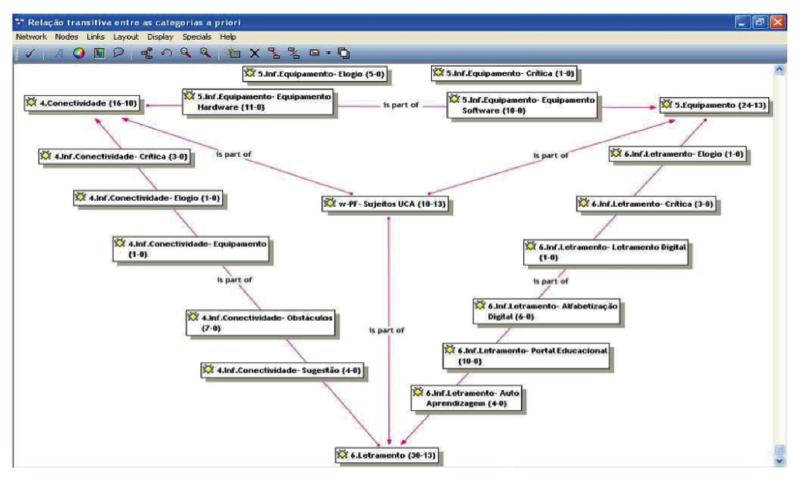

As redes ou networks (Figura 7) são representações gráfica das associações (links) construídos pelo pesquisador durante a análise de dados. Podem ser feitas associações sem definição de tipo e associações tipificada, definidas como redes semânticas. Elas permitem ao pesquisador verificar como as peças se encaixam, ou ainda a elaboração de mapas conceituais e taxonomias.

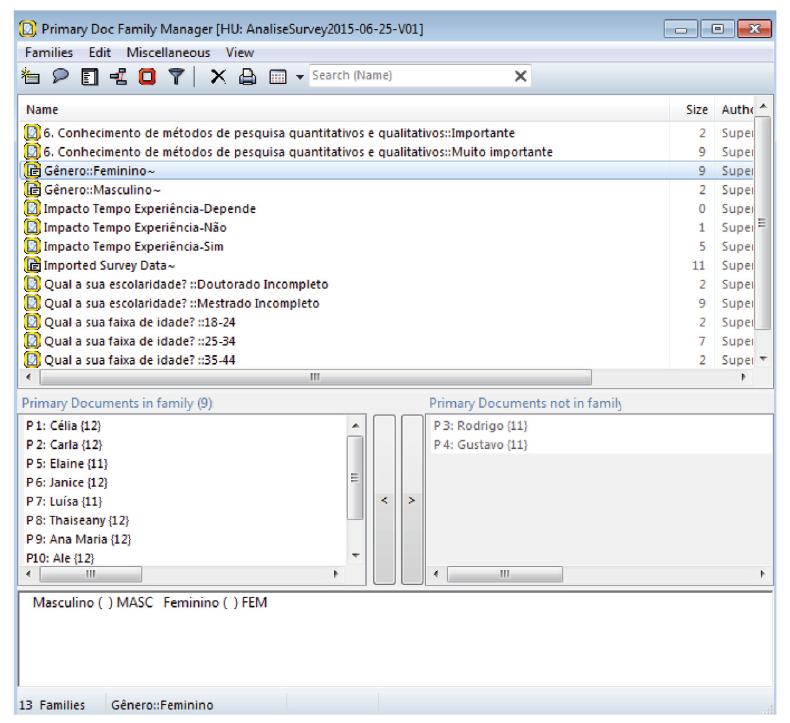

As famílias (Figura 8) são agrupamentos de documentos, códigos ou memos, de acordo com atributos e características compartilhadas e que vão permitir ao pesquisador realizar os questionamentos e cruzamentos necessários dos casos e domínios conceituais.

Os objetos utilizados no primeiro ciclo de codificação, também podem estar presentes no segundo ciclo de codificação, que é o momento no qual o pesquisador buscará desenvolver uma direção categorial, temática, conceitual ou teórica da codificação realizada durante o primeiro ciclo de codificação (SALDAÑA, 2016). Para isso, o pesquisador realiza novas organizações com os códigos, reanalisando os dados, podendo criar novas famílias e códigos.

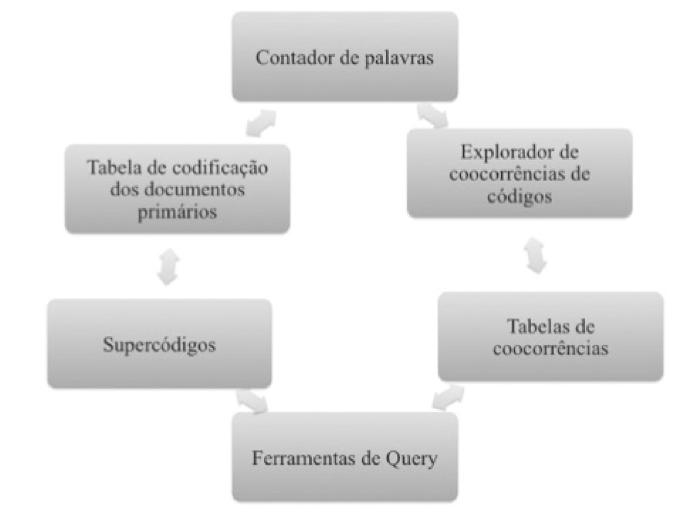

Para auxiliar esse processo, o ATLAS.ti oferece seis ferramentas de análise, sendo três quantitativas: contador de palavras (Figura 9), tabela de coocorrências (LUPEPSO; MEYER; VOSGERAU, 2016), tabela de codificação de documentos primários. E oferece três ferramentas qualitativas: o explorador de coocorrências; ferramentas de questionamentos (Query) e supercódigos.

O uso dessas ferramentas não ocorre de forma sequencial, contudo, apenas o contador de palavras não depende de codificação prévia e pode auxiliar, em alguns casos, na tarefa de codificação, durante o primeiro ciclo de codificação, conforme foi utilizado por Pasinato (2011) e Rossari (2012) e tem por finalidade localizar a incidência de palavras relacionadas a tecnologias digitais em documentos oficiais de educação, para então proceder uma codificação automática dos extratos localizados.

Pela explanação apresentada observa-se que o software para análise de dados qualitativos oferece um grande número de recursos, que combinados podem contemplar infinitos métodos para análise de dados qualitativos. No entanto, isso implica conhecimentos sobre esses métodos e domínio do uso dos recursos impondo novos desafios ao pesquisador em processo de formação.

Desafios para utilização do software na análise de dados qualitativos

Nos relato s dos pesquisadores na palestra apresentada no XII EDUCERE fica evidente que consideram inúmeras as vantagens de terem utilizado o software em suas pesquisas (POCRIFKA, 2012; SIMONIAN, 2012; SIEVERT, 2013; FERREIRA, 2015; LUPEPSO; VOSGERAU; MEYER, 2016). Contudo, também foram unânimes em afirmar que a adoção do software impõe novos desafios, diferentes dos enfrentados pelos colegas que aplicaram o método tradicional de bricolagem e não utilizaram o programa na realização da análise.

Com o intuito de interligar a coleta e a análise, e dar suporte a uma primeira experiência com uso de software de análise de dados qualitativos, Meyer (2010) utilizou o diário de bordo nas duas etapas (Figura 10). Porém com ênfase no registro da história de sua análise, descrevendo cada uma das decisões tomadas e que definiram o seu plano de análise de dados, integrando os objetivos específicos, as observações relativas à aplicação dos instrumentos e até mesmo dúvidas acerca do uso do software de análise de dados qualitativos. A opção pelo diário de bordo surgiu da inexperiência e a consequente insegurança em relação ao processo e ao programa, assim como na tentativa de assegurar o rigor científico, além de subsidiar a redação da metodologia no relatório final da pesquisa.

O diário também registra o passo a passo do que está sendo realizado, permitindo que no período seguinte, o pesquisador saiba exatamente qual tarefa estava realizando a fim de que possa organizar as atividades a serem realizadas na empreitada a ser iniciada. Evidencia-se também um uso do diário de bordo tanto na superação de dúvidas operacionais sobre o programa, quanto na reflexão sobre a análise. O pesquisador descreve seus pensamentos e suas ideias, com a finalidade de, por meio do autoestudo, conseguir elucidar as questões que permeiam o processo de tomada de decisão na análise de dados e recorrer à pesquisa bibliográfica (Figura 11).

A Figura 11 também evidencia que os memos, que serão mencionados a seguir, não necessariamente substituem a utilização do diário de bordo. Apesar de serem anotações ou comentários empreendidos no decorrer da análise, eles atuam como prévias reflexões preliminares que podem conduzir análise dos dados. Entretanto, os memos não têm um uso operacional, portanto, não atuam para demarcar as atividades realizadas, os problemas ou as dúvidas.

Outro desafio se refere ao manuseio de ferramentas Windows, complementares na etapa de preparação de dados, como no caso do Word, Excel (para utilização do recurso de importação de surveys) e mesmo o cuidado na organização de pastas. Como alguns deles (POCRIFKA, 2012; SIMONIAN, 2012) utilizaram a versão 6.0 do software existiam cuidados especiais a serem tomados com a nomenclatura de arquivos, pastas e ainda com a localização virtual dos documentos primários, o que os obrigava a ter um domínio maior do Windows Explorer, o não é muito comum em algumas áreas das Ciências Humanas e levavam, nessa época, alguns alunos a desistirem da utilização, por não conseguirem organizar e localizar seus dados dentro do computador.

Essas dificuldades foram resolvidas na versão 7.0, ao se acoplar as fontes de dados (primary documents) na própria biblioteca do projeto, portanto Sievert (2013), Ferreira (2015) e Lupepso, Vosgerau e Meyer (2016) não compartilharam da mesma ansiedade. Contudo, ainda existem softwares cuja fonte de dados não fica dentro do projeto e implicam um cuidado maior na criação e movimentação de pastas, elemento este a ser considerado ao se escolher um software para análise de dados.

Ainda na fase de preparação, Ferreira (2015) apresenta uma contribuição fundamental na escolha da plataforma a ser utilizada. O autor detinha certa experiência no uso do software ATLAS.ti em atividades acadêmicas empreendidas em disciplina. Ao ter o contato com o ATLAS.ti na versão MAC, adquiriu a licença de dois anos, mesmo sendo um usuário recente do Macbook. A justificativa foi a facilidade de manuseio, usabilidade e localização das ferramentas.

Para a escolha das técnicas de análise Simonian (2012), Pocrifka (2012), Sievert (2013) e Ferreira (2015) em suas pesquisas utilizaram Bardin (2009), assim como grande parte dos estudos qualitativos brasileiros (SILVA et al., 2013). Os pesquisadores são unânimes ao afirmarem que muitas dificuldades que tiveram foram por falta de aprofundamento nos métodos e técnicas de análise de dados. Ferreira (2015), que tinha um grande volume de dados e passou por um exaustivo processo de codificação, relata que, em dado momento, precisou recorrer à elaboração de um protótipo por meio do processo de bricolagem para que com o aprofundamento da leitura de Bardin (2009) tomasse as decisões de agrupamentos e cruzamentos que seriam realizados com o software.

Complementarmente, Simonian (2012) e Pocrifka (2012) tendo utilizado amplamente o software em suas pesquisas de mestrado e retomando sua utilização para a pesquisa realizada no doutorado, garantem que o conhecimento aprofundado de técnicas de codificação, principalmente em formas de ciclos, como apresentadas por Saldaña (2016) podem oferecer mais alternativas para formulação de um plano prévio de análise de dados e uma compreensão melhor do que pode ser encontrado dentro do software.

Considerações Finais

A experiência vivida na palestra, ao trazer para os participantes do XII EDUCERE não apenas questões teóricas sobre as vantagens e desvantagens do uso do ATLAS.ti, mas a partilha de estudantes de Pós- -graduação que desafiaram a si mesmos buscando aprimorar a qualidade de sua pesquisa, foi enriquecedora diante da oitiva dos anseios, dúvidas, desafios e sucessos. Também não se encerrou nas sugestões recebidas pela plateia que podem gerar novos caminhos a serem traçados nas pesquisas, mas especialmente em relação à continuidade do trabalho como formadora de novos pesquisadores qualitativos.

Pudemos confirmar nossas conjecturas ao longo desses 15 anos ensinando e aprendendo sobre o processo de análise de dados qualitativa, que, antes de tudo, o pesquisador precisa compreender e ser capaz de elaborar um plano de análise de dados que o auxilie a responder as questões e subquestões propostas em sua pesquisa, para então buscar no software as alternativas oferecidas para que possa aplicar o caminho previamente planejado. Grande parte da desistência dessa utilização não ocorre por barreiras tecnológicas, mas sim por dificuldades conceituais que não permitem ao estudante-pesquisador em formação visualizar as possiblidades oferecidas pelos softwares.