INTRODUÇÃO

Avaliação ou acreditação do ensino superior? Essa questão é abrangente e apresenta diferentes iniciativas e características dos modelos em atividade no ensino superior pelo mundo. Avaliar a qualidade das Instituições de Ensino Superior (IES), dos cursos oferecidos, dos professores ou dos alunos? Ou avaliar todos? Considerar as boas práticas ou criar um ranking? Qual modelo escolher para estabelecer um sistema de avaliação ou acreditação do ensino superior que tenha aderência à cultura e às práticas pelos países?

Essas são algumas perguntas iniciais para reflexão e introdução às políticas educacionais que procuram delinear as práticas de asseguração de qualidade no ensino superior pelas agências reguladoras responsáveis por sua gestão, independentemente de seus países.

As agências de acreditação e avaliação pelo mundo têm discutido e buscado o desenvolvimento da qualidade do ensino superior mediante iniciativas que procuram avaliar o desempenho dos cursos e dos estudantes. Pode-se exemplificar com as iniciativas como a da Organização para a Cooperação e o Desenvolvimento Econômico (OCDE), que aplica um teste internacional de avaliação do desempenho a alunos recém-formados de graduação (Morgan e Shahjahan, 2014; Richardson e Coates, 2014; Shahjahan, 2013; Shahjahan e Torres, 2013), denominado Assessment of Higher Education Learning Outcomes (AHELO), que mede a efetividade de sistemas de educação e elabora estratégias de auditoria, no intuito de legitimar sua atuação em todo o mundo (Barzelay, 2014; Hanushek, Link e Woessmann, 2013; Lenkeit e Caro, 2014; Morgan e Shahjahan, 2014; Soh, 2014).

Para certificar a qualidade nos processos de avaliação e acreditação pelas agências, existem reconhecidas organizações internacionais como a European Association for Quality Assurance in Higher Education (ENQA) e a Advancing Quality Management Education Worldwide (AACSB), entre inúmeras outras (Blomqvist et al., 2012; Maccari et al., 2014).

Por volta do ano 2000, a Organisation for Economic Co-operation and Development (OECD, 1999) menciona as diferentes culturas entre modelos de acreditação e avaliação e, como exemplo, considera os diferentes padrões de garantia de qualidade entre Estados Unidos e Reino Unido. Em 2009, as discussões inerentes à qualidade e garantia da qualidade aplicadas ao ensino superior continuam a ressaltar a necessidade de promover a cultura da qualidade. Harvey (2009, p. 1) evidencia que a cultura da qualidade tende a ser entendida como resultado de melhores processos internos: “There is increasingly a taken-for-granted view that quality culture is about the development of, and compliance with, processes of internal quality assurance”.Lanares (2008, p. 13) explica que, entre duas formas em que as IES podem desenvolver a qualidade como cultura, deve-se preferir a segunda delas, em que a continuidade da cultura tende a facilitar a mudança:

In some cases, the institution will introduce quality assurance. This will imply new values which will have to be integrated in the organizational culture. In other ones, the creation of quality assurance will start from the existing quality culture. Once finalized, quality assurance will in turn influence and modify the quality culture.

Esse cenário de análise parecer fluir em direção às previsões de Lamarra e Centeno (2016, p. 138), quando afirmam que os processos de garantia de qualidade na América Latina têm sido fortemente influenciados pelos ocorridos anteriormente na América do Norte (Estados Unidos e Canadá) e na Europa.

A EVOLUÇÃO DA ACCOUNTABILITY E DA QUALIDADE NOS SISTEMAS DE AVALIAÇÃO

Harvey e Askling (2003) afirmam que foi nos anos de 1990 que a busca pela qualidade emergiu no cenário do ensino superior. Assim, veio à tona o imperativo de se apresentar eficiência e efetividade nos serviços públicos, oriundo dos ideais da New Public Management (NPM) (Hood, 1989; Pollitt, 1993), não sendo possível a isenção das IES dessa nova exigência de produzir mais com menos custos (Bleiklie, 1998). As IES passaram a incorporar essas mudanças (Askling e Henkel, 1988) na tentativa de acompanhar a ascensão do “The Evaluative State” (Neave, 1988) cultivando a qualidade, a eficiência e a cultura empreendedora no ensino superior.

Nesse status quo, Santos (2011) posiciona o ensino superior como uma responsabilidade pública e ressalta a importância de governos e sociedade de zelarem pela sua qualidade, o que ocorreu pela necessidade de garantir a qualidade das IES por meio dos poderes públicos, fato que pode ser evidenciado em diversos modelos de acreditação baseados na autorregulação. A abordagem de responsabilização dos governos pela qualidade do ensino superior, sua acreditação e avaliação tem sido ressaltada nas diversas comunidades acadêmicas (Bleiklie, 1998; Cret, 2011; Deem, 1998; Neave, 1998; Stensaker et al., 2011).

Em suma, têm-se assistido à evolução dos modelos e sistemas de avaliação e de garantia da qualidade de forma globalizada. O governo de cada país tem adaptado suas regras, melhorias e órgãos de controle de forma diferenciada. Por exemplo, o uso dos processos de avaliação na Comunidade Europeia (ENQA, 2005, 2007, 2009; Rosa et al., 2011), os processos de acreditação nos Estados Unidos (Eaton, 2009, 2012; Harvey, 1995, 2002; Massy, 2005) e os sistemas de avaliação híbridos ou alternados na América Latina e países do Leste Europeu (Brasil, 2004; Lamarra, 2006, 2007; Santos, 2011).

No contexto do ensino superior brasileiro, Polidori (2009, p. 440-441) ressalta que as reformas ocorridas durante o governo de Fernando Henrique Cardoso (1995-2003) culminaram na privatização ou concessão ao setor privado da execução de funções e serviços públicos, incluindo-se a educação superior. A partir desse marco, denominado por Felix (2008) de “construção da avaliação emancipatória”, a implantação do Sistema Nacional de Avaliação da Educação Superior (SINAES) passou a ter o objetivo de desenvolver, no país, uma política de avaliação aderente à sua realidade sui generis.

De certa forma, essas mudanças tentaram ajustar o cenário brasileiro às sugestões do relatório publicado pelo Observatory on Borderless Higher Education:

priorizando o conhecimento para o desenvolvimento da nação;

incluindo alterações de forma racional no ensino superior;

diminuindo relações desiguais entre países em desenvolvimento;

implantando políticas de democratização do acesso e qualidade do ensino superior;

combatendo a visão errônea de priorização da educação básica em detrimento do ensino superior (Naidoo, 2007, p. 2-9).

Quanto ao crescimento desenfreado do ensino superior na América Latina, Lamarra e Cóppola (2007, p. 18) e Lamarra e Centeno (2016, p. 137) afirmam que foram criados diversos tipos de IES universitárias e não universitárias,1 em sua maioria privadas, como tentativa de atender à demanda crescente do mercado, mas que nesse cenário não foram previamente pensados critérios de qualidade e de pertinência institucional. Essa afirmativa reforça a necessidade de criação de um modelo de avaliação do ensino superior capaz de fornecer resposta às demandas emergentes, sem perder o foco na qualidade.

Essas iniciativas consolidaram uma proposta de implantação de um modelo de qualidade no ensino superior brasileiro que vai de encontro ao modelo de supervisão estatal, que segundo Neave e Van Vught (1994), reconhece que o estado tem dificuldade e ineficiência de controlar um sistema dinâmico de educação superior massificado, complexo e em constante mutação.

Em síntese, a proposta seguiu a tendência internacional de transformar o governo em um órgão regulador do ensino superior, não mais atuando como controlador, para isso tendo idealizado a implantação do SINAES. Para Amaral e Magalhães (2001), esse modelo de ensino superior permite poucas intervenções nas decisões diárias das IES em virtude de sua autonomia,2 limitando-se ao governo a tarefa posterior de direção, supervisão e avaliação de desempenho.

No biênio 2015-2017, o modelo brasileiro de avaliação passou a ter um papel de destaque no processo de avaliação da qualidade do ensino superior no âmbito do Mercado Comum do Sul (Mercosul):3 a escolha do Instituto Nacional de Estudos e Pesquisas Educacionais “Anísio Teixeira” (INEP) para conduzir a Secretaria da Rede de Agências Nacionais de Acreditação (RANA) (Brasil, 2016a),4 que compõe o Sistema de Acreditação Regional de Cursos de Graduação do Mercosul (Arcu-Sul).

O Arcu-Sul é resultado de um acordo entre os ministros de Educação da Argentina, Brasil, Paraguai, Uruguai, Bolívia e Chile, homologado pelo Conselho do Mercosul, em 2008. (Argentina, 2008).5

UM PANORAMA DA DIMENSÃO DO ENSINO SUPERIOR BRASILEIRO

Apresenta-se então a situação do ensino superior no país com base nos dados oficiais publicados. Para isso, consideraram-se os microdados do Censo da Educação Superior Brasileira de 2014 (INEP, 2014a); os dados divulgados pelo INEP relativos a 2014 (INEP, 2015) e os microdados do Exame Nacional de Desempenho dos Estudantes (ENADE) de 2014 (INEP, 2014b). Nessa análise, por padronização, foram considerados os dados relativos a 2014 por serem esses os que se encontravam publicados até o início das ações da reforma do ensino superior em 2016.

Com o crescimento desordenado das IES no Brasil entre 1996 e 2003, houve uma evolução do número das 894 instituições existentes, em 1995, para 1.859, em 2003. Subsequentemente, ocorreu a expansão de matrículas no ensino superior, aumentando de aproximadamente 1.759 matrículas em 1995 para 3.887 em 2003 (INEP, 2004a).

O Censo da Educação Superior Brasileira de 2014 (INEP, 2014a) aponta em relatório estatístico, publicado no mês de julho de 2016, que existiam 2.368 IES6 e 7.828.013 matrículas no ensino superior do país (INEP, 2015), conforme representado na Tabela 1.

Tabela 1 - Estatísticas gerais da educação superior do Brasil em 2014.

| Dados do Censo 2014 | Total | IES públicas | IES privadas |

|---|---|---|---|

| Total de IES no país | 2.368 | 298 | 2.070 |

| Educação Superior - graduação | |||

| Cursos | 32.878 | 11.036 | 21.842 |

| Matrículas de estudantes no ensino superior | 7.828.013 | 1.961.002 | 5.867.011 |

| Ingressantes | 3.110.848 | 548.542 | 2.562.306 |

| Concluintes | 1.027.092 | 241.765 | 785.327 |

IES: Instituições de Ensino Superior.

Fonte: Baseado nos microdados do Censo da Educação Superior (INEP, 2014a, 2015).

Elaboração dos autores.

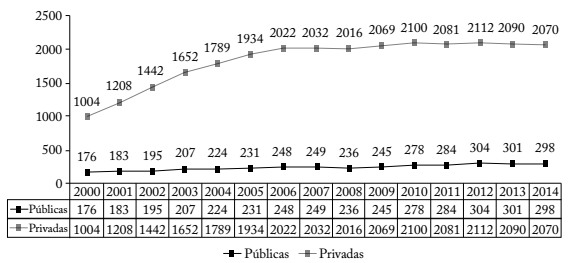

O Gráfico 1 apresenta de forma longitudinal a evolução das IES no país entre os anos de 2000 e 2014. Nota-se que o volume de crescimento do ensino superior ocorreu fortemente entre 2000 e 2006, praticamente duplicando a quantidade de IES privadas e aumentando em 41% o número de IES públicas. Entre 2007 e 2014, enquanto o número de IES privadas praticamente estagnou, as públicas aumentaram em 20%.

Nota: O gráfico destaca, no tempo, a superioridade da oferta de vagas privada em relação às públicas. Fonte: Baseado nos dados do Censo da Educação Superior do INEP (2014a). Elaboração dos autores.

Gráfico 1 - Análise longitudinal da evolução das Instituições de Ensino Superior no país entre os anos 2000-2014.

Ressalte-se que, entre o total de matrículas no ensino superior, 75% referem-se à matrículas em IES privadas, representando que três quartos dos alunos então matriculados nesse nível estudam no ensino privado e suportam o pagamento de mensalidades. Apenas 25% de matrículas dos estudantes são realizadas em IES públicas e sem ônus financeiro.

Em relação ao número de IES, a característica do modelo brasileiro de apresentar um ensino superior predominantemente privado (87,4%) permite a clara evidenciação da pequena proporção de IES públicas (12,6%). Por consequência, estabelece-se a proposição de ensino superior voltado para o “mercado”, em que a maioria das instituições tem como objetivo o lucro, tendo como contraponto a capacidade do governo atual como órgão regulador de um sistema que tende a ser extremamente dinâmico e focado em resultados (quantidade de matrículas).

Considerando a relação total entre docentes e matrículas no ensino superior apresentada na Tabela 2, o resultado demonstra a associação média de um professor para cada 20,4 ingressantes, independentemente do tipo de ensino. Destaca-se na esfera pública que a mesma relação é representada por 1 professor para 12 ingressantes, enquanto nas privadas sobe para 1 professor para 26,6 ingressantes. Evidencia-se a melhor relação professor-aluno ocorrendo no ensino superior público, podendo ser refletida em melhores condições de ensino e, consequentemente, em egressos mais preparados.

Tabela 2 - Estatísticas docentes da educação superior do Brasil em 2014.

| Dados docentes | Total | IES públicas | IES privadas |

|---|---|---|---|

| Docentes em exercício de funções | 383.386 | 163.113 | 220.273 |

| Relação entre docentes e matrículas | 20,4 | 12,0 | 26,6 |

IES: Instituições de Ensino Superior.

Fonte: Baseado nos microdados do Censo da Educação Superior (INEP, 2014a, 2015).

Elaboração dos autores.

Ao considerar o total de cursos em relação ao total de IES, identificou-se que, em média, cada IES no país oferece 14 cursos superiores. Entre os tipos de IES no ensino superior brasileiro, 8,2% são universidades, públicas ou privadas. Destaca-se que estas detêm, juntas, 53,2% das matrículas do ensino superior no país, significando que a maioria das matrículas nesse nível de ensino no país é realizada em universidades.

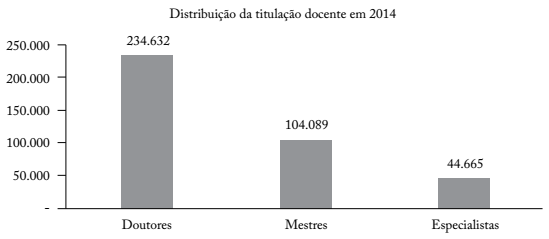

Quanto aos docentes do ensino superior, identificou-se que em 2014 existiam 383.386 docentes em exercício de funções. Destes, 43% atuam em IES públicas e 57% nas instituições privadas (Tabela 2).

Na titulação, 61,2% são doutores, 27,2% são mestres e 11,7% são especialistas (Gráfico 2). A proporção de professores doutores e mestres no ensino superior brasileiro representa 88,4% do total.

Nota: O gráfico destaca a diferença de titulação entre os docentes no país. Fonte: Baseado nos microdados do Censo da Educação Superior (INEP, 2014a, 2015). Elaboração dos autores.

Gráfico 2 - Titulação docente na educação superior do Brasil em 2014.

Em 2014, a titulação docente atuante no ensino superior público7 é representada majoritariamente por doutores (55,8%), seguida por 28,8% de mestres e 15,4% de especialistas. O ensino superior privado é composto prioritariamente por mestres (47%), em seguida por especialistas (33,2%) e, em menor número, por doutores (19,8%).

A Tabela 3 apresenta a evolução da titulação docente entre 2003 e 2014. Nota-se o aumento significativo de 41% do percentual de doutores no país e a respectiva diminuição do percentual de especialistas em 40%, enquanto o percentual de mestres no país permaneceu sem variação significativa, entre 28% em 2003 e 27% em 2014.

Tabela 3 - Evolução da titulação docente entre 2003 e 2014.

| Titulação | 2003 (%) | 2014 (%) |

|---|---|---|

| Doutores | 43,4 | 61,2 |

| Mestres | 28,0 | 27,2 |

| Especialistas | 28,7 | 11,7 |

Fonte: Censo da Educação Superior do Brasil (INEP, 2004a, 2014a).

Elaboração dos autores.

Após apresentado o panorama com dados atuais do ensino superior brasileiro, a próxima seção exibe o modelo de avaliação em vigor no país.

METODOLOGIA

Tendo como pano de fundo os principais modelos europeus e americanos de avaliação em uso pelas agências de acreditação, o entendimento das diferentes políticas educacionais aplicadas ao ensino superior e as diferentes formas de medir a qualidade nos cursos superiores, este estudo propõe explicar, considerando o contexto brasileiro, a atuação e a contribuição da agência de avaliação do ensino superior em dois momentos distintos: o primeiro, com uma análise longitudinal dos resultados das avaliações do ensino superior entre 2004 e 2014, e o segundo momento com a reforma dos indicadores de desempenho iniciada em 2016.

As indagações de partida deste trabalho aderem a esse cenário e vão permitir o desenvolvimento das questões relativas à acreditação, avaliação e qualidade do ensino superior no Brasil:

Quais os resultados dos processos de avaliação externa do ensino superior entre 2004 e 2014?

Como a reforma do modelo de avaliação do ensino superior brasileiro, a modificação dos indicadores de qualidade e a formalização dos processos de seleção dos avaliadores podem influenciar ou determinar melhorias no desempenho das IES e dos cursos de graduação?

Para atingir os objetivos aqui propostos, decidiu-se utilizar como metodologia de investigação a estratégia de triangulação. Por fornecer múltiplas visões e métodos de obtenção de informações, sua utilização pode amenizar problemas de credibilidade em pesquisa (Fielding e Schreier, 2001; Hussein, 2009; Yauch e Steudel, 2003; Tashakkori e Teddlie, 1998) pela combinação de métodos e fontes de dados em aspectos qualitativos e quantitativos.

O desafio de combinar dados quantitativos e qualitativos com diferentes métodos e técnicas estatísticas permite fornecer resultados mais precisos e justificar as correlações inferidas pelas múltiplas perspectivas. Existe ainda uma tendência clássica na literatura em relação aos métodos de investigação na área de ciências sociais pela utilização de múltiplos métodos (Hussein, 2009; Webb et al., 1966).

Ao utilizar a estratégia de triangulação, pode-se enriquecer a análise favorecendo a visualização das múltiplas perspectivas possíveis e facilitar a compreensão e a percepção dos fenômenos. Na pesquisa, foram utilizados dados secundários, incluindo relatórios e estatísticas oficiais fornecidos pelas agências e órgãos de avaliação e acreditação do ensino superior brasileiro: microdados do Censo da Educação Superior Brasileira de 2014 (INEP, 2014b), os dados do INEP relativos a 2014 (INEP, 2015) e os microdados do ENADE de 2014 (INEP, 2014b).

Para entender o funcionamento do modelo de avaliação no contexto brasileiro, exibiremos primeiramente uma visão panorâmica do ensino superior e os resultados longitudinais (2004-2014) das ações de avaliação, para em seguida apresentar a composição estrutural da agência de avaliação/acreditação e, por último, as reformas do modelo a partir do ano de 2016.

O MAPEAMENTO DO MODELO DE AVALIAÇÃO DO ENSINO SUPERIOR PELO SINAES

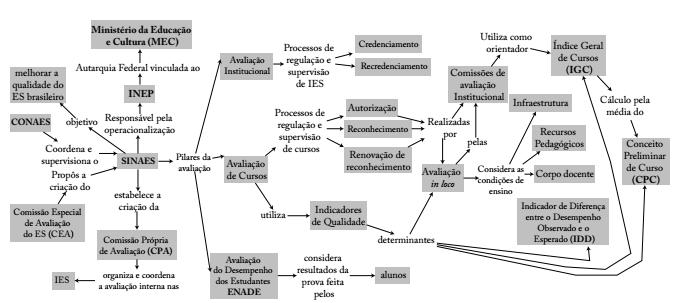

A lei n. 10.861 (Brasil, 2004) do Ministério da Educação (MEC) do Brasil instituiu o SINAES. O SINAES tem o propósito de realizar uma avaliação diagnóstica, formativa e regulatória das IES. É composto por três componentes: a avaliação das IES, dos cursos e do desempenho dos estudantes. Em suma, o SINAES avalia todos os aspectos em torno dos três eixos educacionais: o ensino, a pesquisa, a extensão. Considera para isso a responsabilidade social, o desempenho dos alunos, a gestão da IES, o corpo docente, as instalações, além de outros aspectos (INEP, 2010a, 2010c).

O MEC tem em sua estrutura funcional o INEP como autarquia federal vinculada (INEP, 2010a, p. 1-3) que é responsável por organizar e manter o sistema de informações e estatísticas educacionais, pelo desenvolvimento e coordenação dos sistemas e projetos de avaliação educacional, em todos os níveis e modalidades de ensino superior no país.

Os resultados das avaliações coordenadas pelo SINAES possibilitam um panorama da qualidade dos cursos e das IES no país. Os processos avaliativos são coordenados e supervisionados pela Comissão Nacional de Avaliação da Educação Superior (CONAES). Segundo Polidori, Marinho-Araujo e Barreyro (2006), a CONAES tem como função estabelecer os parâmetros gerais e as diretrizes para a operacionalização do sistema de avaliação, ficando a operacionalização na responsabilidade do INEP.

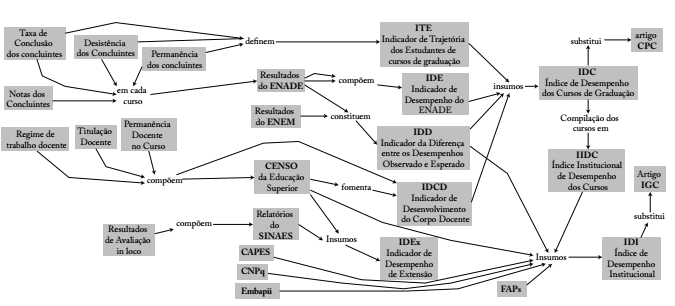

Na Figura 1, o mapeamento conceitual elaborado por Pereira, Machado e Araújo (2015) permite o entendimento sistêmico do processo de avaliação da qualidade do ensino superior no Brasil, foi elaborado considerando a legislação do SINAES e complementado com as contribuições de Pedrosa, Amaral e Knobel (2012) e Verhine, Dantas e Soares (2006).

Nota: O mapeamento ilustra as funções dos principais órgãos responsáveis: MEC, INEP, SINAES, CONAES, destacados em negrito. Permite identificar as relações entre os elementos de avaliação: CPA, ENADE, IGC, CPC e IDD. Fonte: Pereira, Machado e Araújo (2015). Elaboração dos autores.

Figura 1 - Mapeamento conceitual do modelo de avaliação do ensino superior brasileiro.

Em um sistema massificado e complexo como no caso do Brasil, a utilização de um mapa conceitual permite facilitar o entendimento sistêmico de forma simplificada, como em uma análise descritiva.

Destaque-se que os três eixos educacionais8 do modelo de avaliação brasileiro, presentes na Figura 1, são geridos pelo SINAES mediante os pilares avaliativos: avaliação institucional; avaliação de cursos; e avaliação de desempenho dos estudantes.

Em seguida será contextualizada a avaliação institucional interna e externa, apresentadas as novas medidas instituídas pela reforma do modelo, como a Comissão Técnica de Acompanhamento da Avaliação (CTAA) e os novos indicadores e os resultados das ações de avaliação institucional.

OS DESTAQUES DO NOVO MODELO DE AVALIAÇÃO DO ENSINO SUPERIOR PELO SINAES (PÓS-REFORMA)

MUDANÇAS NA AVALIAÇÃO EXTERNA

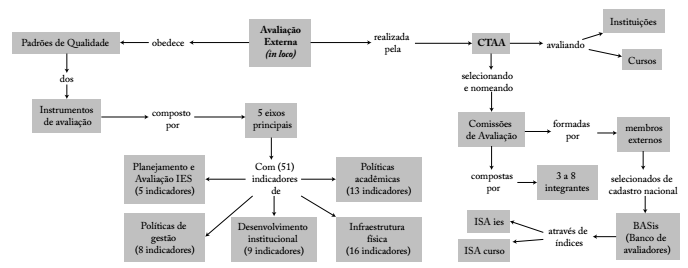

A avaliação externa é realizada por membros externos, nomeados pelo INEP. Sua comissão é constituída por membros da comunidade acadêmica e científica, reconhecidos pela capacidade em sua área e portadores de ampla compreensão das IES. Na avaliação externa são exigidos os padrões mínimos de qualidade para o ensino superior (INEP, 2010d; Ristoff e Giolo, 2006) expressos nos instrumentos de avaliação específicos e nos relatórios das autoavaliações institucionais.

A CTAA é o novo órgão colegiado responsável pelo acompanhamento dos processos periódicos de avaliação institucional externa e de avaliação dos cursos de graduação das IES (Brasil, 2016b, 2006a) (Figura 2).

Nota: Permite identificar a CTAA e suas atribuições. Os padrões de qualidade são divididos em cinco eixos e estão estabelecidos nos instrumentos de avaliação. São avaliados 51 indicadores de qualidade. Fonte: Adaptado de Pereira, Araújo e Machado-Taylor (2018, p. 8). Elaboração dos autores.

Figura 2 - Avaliação externa no modelo de avaliação do ensino superior brasileiro.

Destaca-se a existência de um banco de avaliadores do SINAES (BASis), regulamentado pela portaria n. 1.027, em seu artigo 2º (Brasil, 2006a), que é um cadastro nacional e único de avaliadores do INEP para a constituição de Comissão de Avaliação in loco. O cadastro do BASis era composto por uma relação nominal de 4.495 avaliadores institucionais e 8.992 avaliadores de cursos distribuídos pelo país (Brasil, 2006b, p. 17-67).

Em maio de 2016, a portaria n. 208 (Brasil, 2016c) estabeleceu um procedimento padronizado para seleção dos avaliadores do SINAES. Foram criados dois índices específicos: o Índice de Seleção dos Avaliadores de Curso (ISACURSO) e o Índice de Seleção dos Avaliadores Institucionais (ISAIES).

As duas variáveis que representam maior peso para a seleção dos avaliadores de curso são relativas à experiência na gestão de cursos (25%) e na participação no Núcleo Docente Estruturante (NDE) (25%). Esse critério ressalta a expectativa de seleção de profissionais com know-how acadêmico relevante para o desempenho dessas atividades (Quadro 1).

Quadro 1 - Variáveis que compõem os Índices de Seleção dos Avaliadores: ISACURSO e ISAIES.

|

|

|

|

Utilizada no índice |

|---|---|---|---|

|

|

10% | Condução ou participação em avaliações de curso | ISA CURSO |

|

|

25% | Presidente ou membro integrante | |

|

|

20% | Em cursos de graduação ou pós-graduação | |

|

|

25% | Coordenação ou assessoria de cursos; chefes de instituto | |

|

|

10% | Publicações por ano nos últimos três anos | |

|

|

10% | Condução ou participação em avaliações de curso | |

|

|

10% | Condução ou participação direta em avaliações institucionais | ISA IES |

|

|

20% | Presidente ou membro integrante | |

|

|

20% | Coordenação, presidência ou membro integrante | |

|

|

30% | Cargos de reitoria, pró-reitoria, diretoria, gestão acadêmica ou gestão de qualidade | |

|

|

10% | publicações por ano nos últimos três anos | |

|

|

10% | Emitido por comissão ad hoc do INEP para a IES como resultado da avaliação de Credenciamento/Recredenciamento |

Fonte: Baseado na portaria n. 208 (Brasil, 2016c).

Elaboração dos autores.

O mesmo critério foi adotado para a seleção dos avaliadores institucionais, no entanto a experiência mais pontuada (30%) tem relação com gestão institucional como cargos de direção ou pró-reitoria. As outras duas maiores pontuações consideradas para essa seleção (20% cada) tem a ver com experiência em Comissão Própria de Avaliação (CPA) e NDE (Quadro 1).

Consideradas as variáveis e seus critérios, os modelos estatísticos para cálculo dos índices ISACURSO e ISAIES são apresentados nas Equações 1 e 2:

Será estabelecido um ranking com as distâncias entre os candidatos, e os classificados serão capacitados e elegíveis para designação nas comissões de avaliação externa (Brasil, 2016c, p. 5-8).

Evidencia-se na composição dos modelos a priorização de competências de gestão para a avaliação. Em ambos os modelos, o peso é superior à metade do peso total de cada índice. Por exemplo, no ISA CURSO , verifica-se que o peso para ExpNDE é de 25% somado à ExpGC, com peso de 25%, e ExpAC, peso de 10%, o que eleva a necessidade de competências de gestão para 60% do índice. No ISAIES, a proporção de competências de gestão chega a 80% do indicador quando somamos o peso individual de cada índice (ExpAI (10%) + ExpNDE (20%) + ExpCPA (20%) + ExpGA (30%) = 80%).

Em março de 2018, foi publicado no Diário Oficial da União edital com ofertas de novas vagas para avaliadores, o edital número 13, de 6 de março de 2018, com uma chamada pública para a seleção de 11.973 docentes do ensino superior para ampliação do BASis. Os novos avaliadores começaram a ser homologados por meio de portarias publicadas no Diário Oficial da União entre agosto e setembro de 2018. A partir de então, no Brasil, o BASis é composto por 25.460 avaliadores.

OS EIXOS AVALIATIVOS E SEUS INDICADORES

O instrumento de avaliação institucional externa é público e deve subsidiar os atos de credenciamento, recredenciamento e transformação da organização acadêmica.9 Nesse instrumento estão organizados os cinco eixos que contemplam as dez dimensões avaliadas pelo SINAES.

Para cada dimensão avaliada existem, em média, dez indicadores específicos que são pontuados em escala Likert, de 1 a 5. Ao término do processo avaliativo, os avaliadores apresentam o parecer final, com os indicadores de cada dimensão totalizados automaticamente pelo sistema e com seus pesos específicos.

Em síntese, o conceito final da avaliação externa quanto ao credenciamento/recredenciamento da IES é calculado com base em 51 indicadores avaliados entre os cinco eixos e apresenta uma nota conclusiva que deve ser a substância principal para o parecer final da comissão (Quadro 2).

Quadro 2 - Pesos para credenciamento e recredenciamento de Instituições de Ensino Superior.

| Eixos avaliativos | Credenciamento | Recredenciamento | Quantidade de Indicadores |

|---|---|---|---|

| Eixo 1 - Planejamento e Avaliação Institucional | 10 | 10 | 5 |

| Eixo 2 - Desenvolvimento Institucional | 20 | 20 | 9 |

| Eixo 3 - Políticas Acadêmicas | 20 | 30 | 13 |

| Eixo 4 - Políticas de Gestão | 20 | 20 | 8 |

| Eixo 5 - Infraestrutura Física | 30 | 20 | 16 |

| Total | 100 | 100 | 51 |

Fonte: Adaptado de MEC (2015, p. 32).

Elaboração dos autores.

Nota-se no Quadro 2 que cada eixo apresenta pesos diferentes para atos distintos: credenciamento ou recredenciamento. Por exemplo, verifica-se que a infraestrutura física detém o maior peso (30) quando do credenciamento de uma IES, enquanto no ato de recredenciamento institucional o peso maior (30) incide na adequação das políticas acadêmicas. Ressalte-se que entre os eixos que apresentam o maior peso (Eixos 3 e 5), são ainda os que registram a maior quantidade de indicadores, 13 e 16 respectivamente, entre os 51 no total.

Os cinco eixos avaliativos, demonstrados no Quadro 2, contêm e são inter-relacionados com as dez principais dimensões do SINAES para a avaliação institucional. Deve-se entender que o Eixo 1, além de atender à dimensão de planejamento de avaliação, inclui ainda o relato institucional. O Eixo 2 atende às dimensões de Missão Institucional e Plano de Desenvolvimento Institucional (PDI) e Responsabilidade Social das IES. O Eixo 3 atende às dimensões de Políticas para o Ensino, Pesquisa, Pós-Graduação e Extensão, Comunicação com a Sociedade e Políticas de Atendimento ao Estudante. O Eixo 4 atende às dimensões de Políticas Técnicas-Administrativas e Docentes, Organização e Gestão da IES e Sustentabilidade Financeira. O Eixo 5 atende à dimensão de Infraestrutura Física.

OS NOVOS INDICADORES DE DESEMPENHO BASEADOS NOS RESULTADOS DOS ESTUDANTES

Nesse último pilar, o momento é de reforma. A partir da publicação da portaria normativa n. 8 (Brasil, 2016d), em 28 de abril, o MEC criou novos indicadores de qualidade para a educação superior no país. Para esse desafio foi instituído um grupo de trabalho para elaboração da metodologia para sua implementação: o Grupo de Trabalho de Avaliação do Desempenho da Educação Superior (GTAES). O GTAES10 tem como função trabalhar na elaboração, definição de metodologia dos indicadores de qualidade da educação superior e sua implementação. Foram criados oito novos indicadores (Quadro 3).

Quadro 3 - Novos indicadores utilizados na avaliação dos estudantes a partir de 2016.

| Indicador | Status | Explicação |

|---|---|---|

| IDE | Novo | Baseado nos resultados do ENADE: considerando o nível de proficiência dos concluintes. Deverá expressar o valor absoluto da média do desempenho estudantil por curso. |

| IDD | Reformulado | Será calculado com base nos resultados do ENEM e do ENADE. |

| ITE | Novo | Acompanhamento da trajetória dos ingressantes. A proposta é utilizar as taxas de permanência, desistência e conclusão. |

| IDCD | Novo | Calculado com base no censo sobre o regime de trabalho, titulação e permanência docente no curso. |

| IDC | Novo | Substituto do CPC, utilizando os insumos IDE, IDD, ITE e IDCD. |

| IIDC | Novo | Para cada IES, calculado pela média ponderada das matrículas, do conjunto de IDC dos respectivos cursos de graduação. |

| IDEx | Novo | Será calculado com informações do censo e dos relatórios de avaliação externa in loco do SINAES. |

| IDI | Reformulado | Vai substituir o IGC, com o objetivo de analisar o desenvolvimento institucional em relação ao ensino, pesquisa e extensão. |

IDE: Indicador de Desempenho; IDD: Indicador da Diferença entre os Desempenhos Observado e Esperado; ITE: Indicador de Trajetória dos Estudantes de cursos de graduação; IDCD: Indicador de Desenvolvimento do Corpo Docente; IDC: Índice de Desempenho dos Cursos de Graduação; IIDC: Índice Institucional de Desempenho dos Cursos; IDEx: Indicador de Desempenho de Extensão; IDI: Índice de Desempenho Institucional; ENADE: Exame Nacional de Desempenho dos Estudantes; ENEM: Exame Nacional do Ensino Médio; IES: Instituições de Ensino Superior; SINAES: Sistema Nacional de Avaliação da Educação Superior; ICG: Índice Geral de Cursos.

Notas: Os indicadores têm a função de representar os resultados dos estudantes do ensino superior no país.

Fonte: Brasil (2016d, p. 11-12).

Elaboração dos autores.

O Quadro 3 demonstra se os indicadores apresentados são novos ou modificações dos que já existiam. Apresenta ainda uma explicação dos insumos a serem utilizados para a sua elaboração.

Finalizando esta seção, apresenta-se o mapeamento conceitual dos novos indicadores de qualidade a serem aplicados na educação superior (Figura 3) como uma prospecção gráfica do novo cenário de avaliação do ensino superior. No diagrama poderá ser visualmente facilitado o entendimento das inúmeras interações entre os novos indicadores com a procedência dos dados que irão compor sua análise.

Nota: O diagrama destaca os oito novos indicadores/índices e identifica os insumos a serem utilizados para sua elaboração. Fonte: Adaptado de Pereira, Araújo e Machado-Taylor (2018). Elaboração dos autores.

Figura 3 - Novos indicadores de qualidade da educação superior brasileira.

Conhecidas as dimensões da avaliação realizada pelo SINAES no ensino superior brasileiro e as mudanças em curso, a próxima seção irá apresentar os resultados das ações avaliativas realizadas de forma longitudinal no país.

ANÁLISE DOS RESULTADOS DAS AVALIAÇÕES DO ENSINO SUPERIOR NO PAÍS

Para esta análise, foram utilizados os dados das avaliações realizadas pelo INEP relativos às avaliações institucionais e de curso realizadas em in loco fornecidas pela Coordenação Geral de Avaliação de Cursos de Graduação e de Instituições de Educação Superior (CGACGIES) da Diretoria de Avaliação da Educação Superior (DAES) do INEP.

Buscando uma visão comparada, foram acrescidos os microdados do ENADE (INEP, 2004c, 2005, 2006, 2007, 2008, 2009, 2010b, 2011, 2012, 2013, 2014a). As informações foram filtradas e, em seguida, sintetizadas e ordenadas. São apresentadas na Tabela 4 de forma longitudinal, relativas ao período compreendido entre os anos de 2004 a 2014.

Tabela 4 - Estatísticas gerais da avaliação do ensino superior do Brasil entre 2004 e 2014.

| Avaliações Realizadas in loco | 2004 | 2005 | 2006 | 2007 | 2008 | 2009 | 2010 | 2011 | 2012 | 2013 | 2014 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| IES | 11 | 21 | 109 | 198 | 422 | 670 | 931 | 539 | 243 | 732 | 628 |

| Cursos de graduação | 1.908 | 2.628 | 3.134 | 2.302 | 2.287 | 580 | 3.169 | 4.670 | 4.317 | 3.977 | 5.019 |

Fonte: CGACGIES/DAES (INEP, 2004c, 2005, 2006, 2007, 2008, 2009, 2010b, 2011, 2012, 2013, 2014a).

Elaboração dos autores.

Considere-se, por exemplo, os dados relativos ao ano de 2010. Enquanto o ENADE avaliou os estudantes de 4.281 cursos, foram avaliados in loco pelo INEP o total de 4.100 ações, sendo 3.169 cursos de graduação e 931 IES. Apenas com essas informações não é possível inferir o conteúdo dessas avaliações, sendo necessário o detalhamento das ações avaliativas. Para isto, recorre-se a Tabela 5, que apresenta, por tipo de ação, como foram distribuídas as ações in loco dentro do processo de avaliação institucional e de cursos.

Tabela 5 - Confrontação de ações de avaliação de cursos realizadas pelo INEP em 2010.

|

|

Conceitos dos cursos avaliados | Total | |||||

|---|---|---|---|---|---|---|---|

| SC | 1 | 2 | 3 | 4 | 5 | ||

| Autorização | 3 | 0 | 15 | 256 | 500 | 130 | 904 |

| Autorização em EaD | 0 | 0 | 0 | 8 | 22 | 3 | 33 |

| Reconhecimento | 181 | 2 | 17 | 556 | 776 | 106 | 1.638 |

| Renovação de reconhecimento | 0 | 7 | 58 | 377 | 112 | 9 | 563 |

| Reavaliação | 31 | 0 | 0 | 0 | 0 | 0 | 31 |

| Total | 215 | 9 | 90 | 1.197 | 1.410 | 248 | 3.169 |

SC: sem conceito; EaD: Educação a distância.

Fonte: Baseado em dados do CGACGIES/DAES (INEP, 2010).

Elaboração dos autores.

Verifica-se, a partir da análise da Tabela 5, que o maior volume de ações de avaliação realizada pelo INEP foi concentrado nos cursos que obtiveram conceitos 3 (1.197 ações) e 4 (1.410 ações). Quanto às principais ações relacionadas aos cursos, verifica-se que, predominantemente naquele ano, ocorreram avaliações in loco para primeiros reconhecimentos de cursos (1.638), 937 autorizações de funcionamento de novos cursos e 563 renovações de reconhecimento de cursos.

Quanto às ações de avaliação institucional apresentadas na Tabela 6, nota-se a predominâncias de ações de recredenciamento de 719 IES, seguidas por 134 avaliações para novos credenciamentos de IES.

Tabela 6 - Confrontação de ações de avaliação institucional realizadas pelo INEP em 2010.

|

|

Conceitos institucionais | Total | |||||

|---|---|---|---|---|---|---|---|

| SC | 1 | 2 | 3 | 4 | 5 | ||

| Credenciamento | 0 | 0 | 6 | 74 | 45 | 9 | 134 |

| Credenciamento em EaD | 0 | 0 | 1 | 18 | 42 | 17 | 78 |

| Recredenciamento | 0 | 2 | 61 | 521 | 126 | 9 | 719 |

| Total | 0 | 2 | 68 | 613 | 213 | 35 | 931 |

SC: sem conceito; EaD: educação a distância.

Fonte: Baseado em dados do CGACGIES/DAES (INEP, 2010).

Elaboração dos autores.

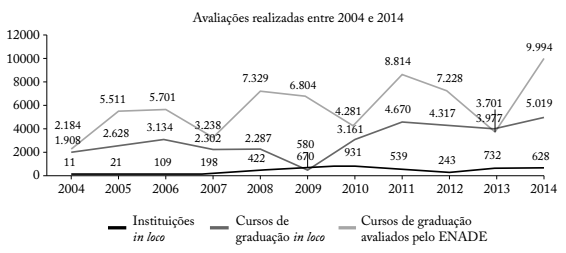

O Gráfico 3 ilustra longitudinalmente a evolução das avaliações realizadas pelo INEP. Permite também uma visão sistêmica de suas variações entre avaliações in loco x avaliações censitárias do ENADE. Na representação gráfica, consegue-se perceber que a política adotada pelo INEP, de dispensar de avaliação in loco os cursos que obtiveram conceitos 3 a 5 no ENADE, diminuiu o volume de avaliações e favoreceu, de forma qualitativa, o desempenho das ações avaliativas.

Notas: O gráfico destaca a quantidade superior de avaliações de cursos realizada de forma censitária pelo ENADE ao comparar com as ações de avaliação in loco de cursos de graduação realizadas pelas comissões de avaliação do INEP. Fonte: As informações dos cursos de graduação avaliados pelo ENADE são oriundas dos microdados do ENADE, em todas as suas edições (INEP, 2004c, 2005, 2006, 2007, 2008, 2009, 2010b, 2011, 2012, 2013, 2014a). Elaboração dos autores.

Gráfico 3 - Análise longitudinal da evolução das avaliações in loco relativas a cursos superiores e de Instituições de Ensino Superior no país entre os anos 2000-2014.

Importante ressaltar que em um sistema massificado, como no caso do Brasil, com um universo de 32.878 cursos superiores em 2014, a política de avaliações in loco, entre 2004 e 2014, permitiu serem avaliados uma média anual de 3.089 cursos e 409 IES.

Com essa realidade, justificou-se a criação do banco de avaliadores BASis e sua composição. A impressão inicial de que o volume de avaliadores de curso e institucionais anteriormente mencionada no país pudesse ser exagerado passa a ser refutada ao considerar uma base anual média de 3.500 avaliações in loco na realidade brasileira.

Ressalte-se ainda que as comissões de avaliação são formadas por uma equipe de três a oito integrantes, conforme explicado no mapeamento de avaliação constante na Figura 2. Dessa maneira, o BASis almeja garantir que a base de avaliadores selecionados esteja disponível e preparada para as visitas de auditoria, apresentando resultados que podem impactar diretamente na qualidade do ensino superior no país.

Quanto às avaliações censitárias do ENADE, a política de ciclos avaliativos estabelecida define que, a cada ano, é avaliado um agrupamento de cursos distintos. Assim, longitudinalmente puderam ser avaliados, por ano, uma média de 5.890 cursos por meio da prova do ENADE aplicada aos estudantes concluintes (Gráfico 4).

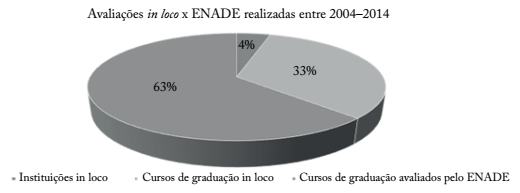

Fonte: Baseado em dados fornecidos pela CGACGIES/DAES/INEP, relativos ao período entre 2004 e 2014, e nos microdados dos cursos de graduação avaliados pelo do ENADE, em todas as suas edições (INEP, 2004c, 2005, 2006, 2007, 2008, 2009, 2010b, 2011, 2012, 2013, 2014a). Elaboração dos autores.

Gráfico 4 - Total de avaliações realizadas entre 2004 e 2014 no país.

Em suma, o Gráfico 4 demonstra que, na história das avaliações realizadas pelo INEP, 63% das avaliações dos cursos de graduação foram realizadas pela prova do ENADE, sem obrigatoriedade de avaliação pelas comissões in loco; 33% dos cursos foram avaliados in loco, para ações de autorização de novos cursos, reconhecimento ou renovação de reconhecimento e, em alguns casos, para reavaliação de cursos; e 4% das avaliações referem-se à avaliações institucionais, para credenciamento ou recredenciamento de IES.

CONSIDERAÇÕES FINAIS

O estudo apresentou o cenário universitário brasileiro, prioritariamente dominado pelas IES privadas como resposta ao crescimento desenfreado que é uma característica do ensino superior na América Latina (Lamarra e Centeno, 2016, p. 137; Lamarra e Cóppola, 2007, p. 18). O sistema implantado pelo governo, por intermédio do SINAES, apresenta derivações do modelo de supervisão estatal (Neave e Van Vught, 1994). A política educacional de transformar o governo em um órgão regulador tem como desafio-chave adaptar mecanismos de controle de qualidade e eficiência a um ensino superior dinâmico e com características mercenárias como massificação, complexidade e constante mutação.

As ações discutidas durante o texto têm mostrado a capacidade de resposta desse modelo às provocações contemporâneas, e a escolha do INEP para a gestão RANA/Arcu-Sul demonstrou o reconhecimento de “suas virtudes” transfronteiriças.

Foi apresentada a organização do SINAES, com seu mapeamento conceitual de funções e responsabilidades. Foram apresentados os três principais componentes ou pilares da política de avaliação brasileira, mas o foco deste estudo foram as políticas de avaliação externa: institucional e de cursos, e as recentes mudanças na avaliação do desempenho dos estudantes. A discussão das mudanças serviu como um marco para comparação do volume de ações avaliativas institucionais.

Ressalta-se que a política inovadora de seleção de avaliadores institucionais e de curso mediante índices (ISAIES e ISACURSO) e sua normalização e operacionalização utilizando o BASis apresenta-se como alternativa viável e fomentadora de garantia de qualidade em um modelo de ensino superior massificado como o brasileiro, no qual ocorrem, em média, 3.500 ações avaliativas externas por ano. A nova política de seleção de avaliadores demonstra um forte accountability no processo de gestão do ensino superior e pode reforçar a reputação dos avaliadores e do modelo como um todo.

De forma pontual, foram apresentados e discutidos como ocorrem, ou deveriam ocorrer, os procedimentos de avaliação in loco, tanto para a avaliação de cursos como para as avaliações institucionais. Foram também conhecidos seus principais indicadores e respectivos pesos na avaliação global de cada unidade avaliada.

Foi apresentado um mapeamento conceitual consolidado que tem a função de explicitar a inter-relação entre as dimensões avaliativas do SINAES, com os indicadores utilizados na avaliação institucional externa.

A avaliação de desempenho dos estudantes pelo ENADE, a partir de maio de 2016, inicia um processo de reforma em que “aposenta” indicadores anteriores “por tempo de serviço prestado” e avança para atender às necessidades de um sistema avaliativo dinâmico e massificado. Os novos indicadores estão sendo trabalhados pelo GTAES e foram mapeados conceitualmente para permitir uma visão do momento de transição.

A combinação dos dados quantitativos, representados pelos microdados da educação superior e do Censo do Ensino Superior, associada à regulamentação qualitativa e descritiva-documental das mudanças propostas no ensino superior brasileiro, permitiu a apresentação de uma visão panorâmica dos resultados do modelo de avaliação brasileiro. Afinal, tratou-se de um sistema composto por 2.368 instituições de ensino, 32.878 cursos superiores, 383.386 docentes em exercício de funções, o que comportou 8 milhões de estudantes no ano de 2014.

Finalmente, após destacar as características principais da atuação do SINAES, confrontou-se com uma análise longitudinal de onze anos, cruzando os dados das avaliações in loco com microdados das avaliações do ENADE. Assim, foi possível validar as políticas de dispensa e/ou obrigação de avaliação in loco e entender como o modelo avaliativo no país tem lidado com a complexidade do ensino superior ao avaliar in loco uma média anual de 3.089 cursos superiores e 409 instituições de ensino.

Portanto, a pergunta no título do artigo, “Remendo novo em roupa velha?”, mostrou que o efeito das reformas do SINAES pode gerar substanciais melhorias na seleção e qualificação mínima de avaliadores. Essa dinâmica pode imputar maior agilidade nas ações de avaliações externas, em conjunto com uma expertise que aumenta o valor moral do processo avaliativo. Os novos indicadores ainda não puderam ser testados e confrontados com os que foram aposentados, mas isso é apenas questão de tempo. Enfim, há sinais de que “os remendos novos” não devem comprometer a “estrutura do tecido da roupa velha”, estando passíveis de expressar sinais de maturidade e de experiência do modelo de avaliação do ensino superior brasileiro.

Como limitações deste estudo, não puderam ser abordadas em sua íntegra as questões relativas ao momento de reforma no terceiro pilar de avaliação de desempenho dos estudantes pelo ENADE. Sabe-se que, a partir de maio de 2016, iniciou-se um processo de reestruturação que aposentou, “por tempo de serviço prestado”, alguns indicadores anteriormente utilizados, modificou alguns indicadores e idealizou novos. Características que almejam promover avanços para atender às necessidades de um sistema avaliativo dinâmico e massificado.

Os novos indicadores estão sendo trabalhados pelo GTAES com base na publicação pelo MEC da portaria normativa n. 8 (Brasil, 2016d), em 28 de abril, mas que, até o momento da finalização da escrita deste artigo, não foram homologados ou publicados.

Como perspectiva para novos estudos, sugere-se a abordagem detalhada dos destaques das mudanças na avaliação dos cursos do ensino superior que neste estudo não puderam ser apresentados por limitações de espaço. Na reforma, foram delineados oitenta indicadores adotados nas dimensões avaliativas dos cursos: Organização didático-pedagógica, Corpo docente e tutorial e Infraestrutura.