INTRODUÇÃO

O Exame Nacional do Ensino Médio (Enem) encontra-se hoje, juntamente com o exame chinês para admissão na universidade (gao kao), entre os maiores testes do mundo quanto ao número de candidatos, contando oito milhões de inscritos em 2015. Sendo um exame voluntário, sua alta atratividade decorre das diversas recompensas a ele atreladas, tais como: admissão na maioria das faculdades públicas do país; obtenção de bolsa ou financiamento para cursar uma faculdade privada; obtenção de certificação de ensino médio (EM), mesmo sem ter frequentado a escola (BRASIL, 2010).

Por tais recompensas, pode-se considerar o Enem o exame de maior valor econômico do Brasil, visto que um resultado positivo traz grandes benefícios ao candidato. Segundo Gomes (2010), o Enem tem gerado efeitos gradativos no trabalho docente e forte impacto mercadológico. O alto valor, por sua vez, acaba criando dificuldades adicionais, como o desenvolvimento de um sistema capaz de garantir segurança para uma logística colossal e também uma importância maior da qualidade do instrumento de avaliação. Mas como garantir essa qualidade?

Uma das principais referências internacionais para a elaboração de testes educacionais e psicológicos é o Standards for educational and psychological testing (AMERICAN EDUCATIONAL RESEARCH ASSOCIATION - AERA; AMERICAN PSYCHOLOGICAL ASSOCIATION - APA; NATIONAL COUNCIL ON MEASUREMENT IN EDUCATION - NCME, 2014), renovado com certa periodicidade por tradicionais instituições americanas. O documento estabelece que os exames devem possuir especificações psicométricas que

indicam as propriedades estatísticas desejadas para os itens (como, por exemplo, dificuldade, discriminação e correlações interitem), assim como as propriedades estatísticas desejadas para todo o teste. (AERA; APA; NCME, 2014, p. 79)

Nesse sentido, cabe perguntar: quais seriam as especificações do Enem?

Diferente do Sistema de Avaliação da Educação Básica (Saeb), parece não haver uma farta documentação detalhando procedimentos para criação, pré-testagem e seleção de itens, ou simplesmente definindo características psicométricas desejáveis para os itens do Enem. Foi encontrado apenas um documento com informações desse tipo - além de informações genéricas sobre o pré-teste de itens presentes em um relatório pedagógico (BRASIL, 2007). O documento intitula-se Exame Nacional do Ensino Médio (Enem): fundamentação teórico-metodológica (BRASIL, 2005). Num dos textos, Fini (2005) explica que os itens do Enem são elaborados em torno de uma situação-problema, e devem conter em seu enunciado as informações necessárias para a tomada de decisão. As alternativas devem ser coerentes com o problema proposto, expressando diferentes graus de entendimento. A prova, por sua vez, deve contar com 20% de itens fáceis, 40% de itens médios e 40% de itens difíceis. Essas proporções podem ter sido alteradas nas versões recentes do Enem, mais focadas na finalidade de seleção para o Ensino Superior. Enfim, em termos psicométricos, Fini esclarece que, após o pré-teste, eram selecionados para a prova os itens com coeficiente bisserial maior do que 0,30.

Neste trabalho, buscou-se contribuir para o debate a respeito da qualidade das avaliações utilizando, principalmente, técnicas psicométricas, das clássicas às modernas. O foco no Enem é decorrente de sua extrema importância hoje: é fundamental saber se as provas são suficientemente boas. Adicionalmente, para contribuir com a qualificação dos professores para o debate, buscou-se também, na medida do possível, explicar de forma mais didática alguns conceitos e técnicas utilizados.

Na primeira seção, resgatam-se alguns conceitos da Teoria Clássica dos Testes (TCT) e da Teoria da Resposta ao Item (TRI) que podem ser úteis para a meta-avaliação e também para educadores em geral. Em seguida, detalha-se os métodos e dados utilizados, incluindo os limites estabelecidos para cada indicador. A seção de resultados inicia com um estudo qualitativo de alguns itens, buscando ilustrar o uso das técnicas psicométricas na prática. Seguem os resultados principais, relativos à meta-avaliação das oito provas do Enem (edições de 2009 e 2011). Por fim, há uma síntese dos resultados principais e algumas considerações sobre a metodologia utilizada e suas possíveis utilidades.

AVALIAR A AVALIAÇÃO

Em educação, há diversas formas e níveis para se conceituar qualidade (TRAVITZKI, 2013a). Os testes padronizados se tornaram uma solução bastante difundida para avaliar a qualidade na educação, talvez por serem objetivos e de baixo custo (MARTÍNEZ ARIAS, 2009). Para garantir a qualidade desses testes - tanto mais necessária quanto maiores as recompensas que eles proporcionam -, há diversos conceitos e técnicas disponíveis para cada contexto e finalidade.

Pode-se analisar, por exemplo, a validade do teste, que seria sua capacidade de mensurar, de fato, a proficiência que se deseja mensurar. Embora haja procedimentos reconhecidos para verificação da validade, esse permanece um conceito polêmico em termos teóricos e empíricos. Segundo Pasquali (2009, p. 995), a validação dos testes

apresenta dificuldades importantes que se situam em três níveis ou momentos do processo de elaboração do instrumento, a saber, ao nível da teoria, da coleta empírica da informação e da própria análise estatística da informação.

Dentre as dificuldades, o autor destaca a irredutibilidade dos princípios de diversas teorias psicológicas,2 além de postulados da análise fatorial que não necessariamente correspondem aos modelos teóricos ou dados empíricos.

Outra propriedade importante é a confiabilidade do teste, que pode ser estimada a partir de um conjunto de respostas utilizando-se diferentes metodologias. De acordo com Kuder e Richardson (1937), as diferentes formulações de confiabilidade se fundamentam nas características de um exame em virtude das correlações positivas entre seus itens. A correlação interitem média pode ser utilizada como indicador de confiabilidade, porém não é sensível ao número de itens do exame, uma variável importante da confiabilidade. Um dos indicadores de confiabilidade mais utilizados é o coeficiente α (CRONBACH, 1951), que articula os dois tipos de informação (correlação interitem e número de itens).

Em geral, considera-se que um valor acima de 0,9 é excelente; acima de 0,7 é aceitável; e valores abaixo de 0,5, inaceitáveis - mas há críticas a essa interpretação (SCHMITT, 1996). Segundo Morris (2011), os testes padronizados em larga escala costumam ter alta confiabilidade, mas podem apresentar baixa validade. Isso pode acontecer, por exemplo, se um teste que tenha objetivo de avaliar a competência em raciocínio científico for composto por itens bem elaborados para avaliar interpretação de texto. Os indicadores de confiabilidade não identificarão qualquer problema no teste, pois os itens se comportam de maneira coerente entre si. No entanto, o teste não mensura aquilo a que se propõe.

Ambas as propriedades se referem ao teste como um todo. Há também propriedades empiricamente observáveis que se referem aos itens. Tais propriedades costumam ser mais informativas ao educador, pois permitem a compreensão não apenas do conjunto de itens, mas também de cada um deles individualmente (maiores detalhes a seguir). Neste trabalho, investigou-se a qualidade técnica do Enem em termos psicométricos, no nível do teste, mas especialmente no nível dos itens. Trata-se, portanto, de uma meta-avaliação do exame. O termo “meta-avaliação” foi introduzido por Michael Scriven, em 1969,3 referindo-se ao ato de se avaliar uma avaliação, com objetivo de evitar distorções e imprecisões que possam prejudicar o processo educativo de crianças e jovens (TUFFLEBEAM, 2001).

A psicometria pode fornecer instrumentos bastante úteis para a meta-avaliação. Destacam-se a seguir três exemplos de estudos brasileiros em que se buscou, como aqui, utilizar técnicas psicométricas para a meta-avaliação em educação.

O primeiro estudo se refere a um exame de medicina, na área de anatomia clínica, em que se avaliou o comportamento empírico de 100 itens de múltipla escolha (SEVERO; TAVARES, 2010). O estudo utilizou algumas medidas de comportamento dos itens, como a carga fatorial padronizada (CFP) e a qualidade de ajuste do modelo (p-valor) dos itens. Os autores consideram de baixa qualidade os itens com CFP menor que 0,30 - o que corresponderia a uma discriminação menor que 0,314 no modelo logístico da TRI. Nos resultados globais, destaca-se a confiabilidade alta (α = 0,85). Embora o estudo tenha confirmado a qualidade do exame, foram encontrados 15 itens de baixa qualidade (15% do total), ou seja, com CFP menor do que 0,3. Além disso, três itens apresentaram p-valor maior ou igual a 0,05 indicando baixa qualidade de ajuste do modelo TRI.

O segundo estudo refere-se ao Exame Nacional de Desempenho dos Estudantes (Enade) na área de psicologia (PRIMI; HUTZ; SILVA, 2011). Diversos aspectos do exame são descritos e analisados, como o perfil da comissão elaboradora de provas, dimensionalidade, matriz de competências e habilidades, relação das habilidades gerais com conteúdos específicos, além de algumas propriedades psicométricas do exame e dos itens. Além de útil para os elaboradores do exame e interessados no tema, o estudo procurou validar a prova, comparando o desempenho de estudantes ingressantes e concluintes do curso - que se mostraram significativamente diferentes. Dentre os resultados do estudo, cabe aqui destacar dois pontos de corte utilizados pelos autores na identificação de itens com comportamento psicométrico abaixo do esperado: a) correlação item-total menor que 0,10; e b) carga fatorial menor que 0,30.

O terceiro estudo, também sobre o Enade (área de pedagogia), tem maior foco nos aspectos psicométricos dos itens, além de apresentar uma interessante revisão dos estudos de meta-avaliação no Brasil (LOPES; VENDRAMINI, 2015). Os autores utilizaram quatro critérios para verificar a qualidade dos itens: a) correlação item-total idealmente acima de 0,3, sendo aceitável acima de 0,2, dependendo dos outros critérios e do conteúdo do item; b) ajuste do modelo (infit e outfit) com valor entre 0,5 e 1,4, e idealmente abaixo de 1,2; c) correspondência entre a distribuição da dificuldade dos itens (limitada ao intervalo de -4 a 4) e a distribuição da proficiência na população; d) carga residual menor que 0,40. A prova foi composta de uma parte geral e outra específica. Dos sete itens relativos ao componente geral, todos apresentaram valores aceitáveis na correlação item-total, no ajuste do modelo e na dificuldade. Em relação à carga residual, dois itens apresentaram valor maior que 0,40 (ou menor que -0,40). No componente específico da prova, foram anulados dois itens pelo Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira (Inep), restando 26 itens válidos. Desses, todos apresentaram ajuste dentro dos limites estabelecidos, e a distribuição da dificuldade acompanhou, de modo geral, a distribuição da proficiência na população. Por outro lado, um item obteve carga residual excessiva, enquanto oito itens (31%) apresentaram correlação item-total abaixo de 0,3.

Na próxima seção, há uma explicação mais detalhada de algumas técnicas e seus usos em avaliações educacionais.

O COMPORTAMENTO EMPÍRICO DOS ITENS

Segundo o documento Standards for educational and psychological testing (AERA; APA; NCME, 2014, itens 4.2, 4.10), os exames devem apresentar especificações psicométricas. Precisam ser documentados diversos aspectos técnicos do teste, tais como o modelo de análise, o ajuste do modelo (no caso da TRI), assim como os critérios para triagem de itens, tais como dificuldade, discriminação, correlação interitem, correlação item-total, além do Funcionamento Diferencial do Item (DIF) entre os maiores grupos. Os métodos de triagem de itens - fundamentais durante o pré-teste - também são úteis a posteriori para meta-avaliação, pois permitem avaliar a qualidade dos itens por seu comportamento empírico.

Há diversos métodos para analisar o comportamento empírico dos itens. Eles podem ser utilizados como critério para avaliar a qualidade dos testes, assim como para outras finalidades, e muitas vezes os resultados convergem entre os métodos (HUDSON, 1991). Há dois grandes grupos de técnicas para analisar os resultados de testes padronizados: aqueles reunidos sob a alcunha da Teoria Clássica dos Testes - que se baseia em conceitos estatísticos mais genéricos, como correlação e porcentagem -, e os da Teoria da Resposta ao Item - com modelos próprios, desenhados especificamente para analisar testes de inteligência, conhecimento ou outras propriedades que não podem ser diretamente observadas (SOARES, 2005). Há diversas formas de se diferenciar esses dois grandes conjuntos de modelos da psicometria, mas é importante ter em mente que “a TRI não é, como se poderia ingenuamente acreditar, um novo enfoque psicométrico, ainda que alcance solucionar certos problemas da TCT” (ANDRIOLA, 2009, p. 322). Ou seja, a TRI não viola os princípios básicos da TCT, apenas adiciona novos princípios que permitem responder novas questões.4

O Enem, em sua primeira década de existência, baseava- -se na TCT, sendo a pontuação de cada aluno correspondente ao percentual de acertos. A partir de 2009, a TRI começou a ser aplicada no exame (ANDRADE; KARINO, 2011), sendo utilizado o modelo logístico de três parâmetros (ML3P). Esse modelo descreve a probabilidade de uma pessoa acertar um item (com parâmetros A, B e C conhecidos), dependendo da sua proficiência.5 A proficiência seria um traço unidimensional, porém não observável: tipicamente, uma característica psicológica. O parâmetro B corresponde ao nível de dificuldade do item, enquanto A define sua discriminação, ou seja, sua capacidade de diferenciar as pessoas com proficiência acima de B das pessoas com proficiência abaixo de B.

O parâmetro C representa a probabilidade de um indivíduo com baixa proficiência responder corretamente a questão, ou seja, a chance de acerto ao acaso (ANDRADE; TAVARES; VALLE, 2000). Nos itens de múltipla escolha com cinco alternativas, esse parâmetro varia em torno de 20%. No modelo logístico de dois parâmetros (ML2P), por sua vez, são estimados apenas os parâmetros A e B - discriminação e dificuldade -, sendo o parâmetro C sempre igual a zero.

Seja qual for o modelo, os parâmetros são estimados para cada item, o que pode ajudar a verificar a qualidade psicométrica de uma prova. Em um exame de seleção, por exemplo, é desejável que o parâmetro A seja alto, especialmente na porção superior da escala de proficiência, permitindo selecionar com acuidade os candidatos mais habilidosos. Também é desejável haver, no conjunto dos itens, uma distribuição equilibrada do parâmetro B ao longo da escala de proficiência. Além disso, a combinação desses dois parâmetros também é importante, pois define o quanto cada item pode ser informativo em cada ponto da escala de proficiência, o que pode ser representado na Curva de Informação do Item (ANDRADE; TAVARES; VALLE, 2000). Por fim, além dos parâmetros e da Curva de Informação do Item, também é possível utilizar como indicador de qualidade a consistência do ajuste dos modelos, a saber, o valor de prova dos modelos de cada item (SEVERO; TAVARES, 2010).

A seguir, detalham-se as técnicas utilizadas como critério de avaliação dos itens neste trabalho.

Correlação item-total

A correlação item-total é a correlação entre o escore do item (no caso, 0 ou 1), e a média do escore no conjunto dos itens (ou nos outros itens). É uma técnica bastante utilizada para verificação da qualidade psicométrica dos itens, servindo por vezes como critério para eliminação de itens potencialmente problemáticos. Uma baixa correlação item- -total sugere que o item não mede o traço latente captado pelo conjunto dos itens. Dependendo do objetivo do teste, do número de itens, da confiabilidade desejada, o mínimo estabelecido para um bom item pode variar. Um estudo para avaliar proficiência em cursos de medicina considerou inadequados os itens cuja correlação item-total fosse inferior a 0,4 (BASS; WILSON; GRIFFITH, 2003). Em outro estudo, analisando um questionário sobre satisfação marital, foi estabelecido um limite mais severo, mínimo de 0,5 (ROACH; FRAZIER; BOWDEN, 1981). Enquanto um terceiro estudo, sobre demência, optou por eliminar apenas os itens com correlação item-total inferior a 0,25 (GILLEARD; GROOM, 1994). Por fim, em um estudo sobre validade e confiabilidade de escalas sobre percepção de saúde para diabéticos, foram excluídos três itens (de um total de 36) que apresentaram correlação item-total menor que 0,3 (KARTAL et al., 2007).

Coeficiente bisserial

O coeficiente bisserial do item, em termos técnicos, está relacionado à correlação entre o acerto no item (0 ou 1) e o escore do examinando na prova. Na verdade, é calculado para todas as alternativas do item (cinco, no caso do Enem), de forma que “um item tem bom desempenho quando esse coeficiente tem valor ‘alto’ positivo associado à alternativa correta e valores negativos associados aos distratores” (ANDRADE; KLEIN, 2005, p. 109). O coeficiente bisserial indica o quanto cada alternativa atraiu os alunos mais proficientes.

No Saeb de 2005, essa técnica foi incluída nos procedimentos para triagem de itens depois do pré-teste. Para o gabarito (alternativa correta), foram encaminhados para análise pedagógica os itens com coeficiente bisserial menor ou igual a 0,15. Além disso, também ficaram retidos

itens com dois coeficientes bisseriais de distratores (alternativas erradas) maiores que 0,10 ou coeficiente bisserial de um distrator maior que a bisserial da alternativa correta. (ANDRADE; LAROS; GOUVEIA, 2010, p. 426)

No Enem, por sua vez,

após análise dos resultados do pré-teste, são selecionadas aquelas que apresentam pertinência mais direta com a habilidade, originalidade e coeficiente bisserial maior de 30. (FINI, 2005, p. 103)

Ao menos esse foi o procedimento adotado na época, e não foram encontrados outros documentos mais recentes descrevendo as especificações psicométricas do Enem. Em 2009, cabe lembrar, o Enem passou por importantes transformações, tais como: reestruturação da Matriz de Referências, consequente mudança nos tipos de prova aplicados (inicia-se em 2009 a divisão do Enem em quatro provas distintas, além da redação), ampliação para dois dias de prova e uso da TRI para análise dos resultados (TRAVITZKI, 2013a).

Discriminação e dificuldade

Para garantir a precisão do teste, é desejável que a discriminação seja alta, para que o item seja mais informativo em certa porção da escala, embora haja evidências de que uma discriminação muito alta possa produzir distorções (MASTERS, 1988). A dificuldade do item, por sua vez, não deve ser muito alta ou muito baixa, caso contrário o item apresenta pouca informação sobre a população analisada.

Tais critérios foram utilizados, por exemplo, no estudo de Alnabhan e Harwell (2001), para avaliar a qualidade de um teste de admissão para faculdade. Os autores se basearam em limites utilizados anteriormente por Muthén, Kao e Burstein (1991). Ajustaram o modelo de dois parâmetros (ML2P) e consideraram adequados os itens que apresentaram: a) dificuldade entre -3 e 3 de desvio padrão; b) discriminação maior do que 0,5 - segundo os autores, um ponto de corte comum nos estudos iniciais -; c) um bom ajuste no modelo TRI (α < 0.05); d) percentual de acerto menor do que 90% (ALNABHAN; HARWELL, 2001). Os resultados apontaram que 30% dos itens não cumpriam pelo menos uma dessas quatro condições. Tais resultados foram enviados a um conjunto de especialistas que decidiria entre modificar ou excluir tais itens futuramente.

Uma classificação do parâmetro A (discriminação) do modelo logístico é apresentada por Baker (2001, p. 34). A discriminação, segundo o autor, poderia ser: nenhuma (0), muito baixa (0,01 a 0,34), baixa (0,35 a 0,64), moderada (0,65 a 1,34), alta (1,35 a 1,69), muito alta (maior que 1,70) ou perfeita (+ infinito). Adicionalmente, Severo e Tavares (2010) consideram que os itens são de baixa qualidade quando a discriminação é menor do que 0,314 (que corresponderia a uma carga fatorial padronizada de 0,30).

MÉTODOS

Software

Neste trabalho foram utilizados apenas softwares livres, como o LibreOffice (escritório) e a plataforma Linux (sistema operacional), para usos mais gerais. Para realização das análises psicométricas com base na TCT e TRI, utilizou-se o R (estatística), que permite a programação e automação de procedimentos customizados.

Uma das vantagens do R é que, por ser um software de desenvolvimento livre e de código aberto, permite análises estatísticas complexas, transparentes e reprodutíveis, na medida em que os dados e o código fonte estejam disponíveis. Além disso, a arquitetura aberta e não proprietária proporciona condições ideais para o trabalho colaborativo, de forma que pessoas em todo mundo estão constantemente criando e testando novos pacotes do R, o que gera grande diversidade de funcionalidades. Os principais pacotes utilizados neste trabalho foram o “ltm” (RIZOPOULOS, 2006), para estimações via TRI, e o “psych” (REVELLE, 2016), para técnicas da TCT.

DADOS

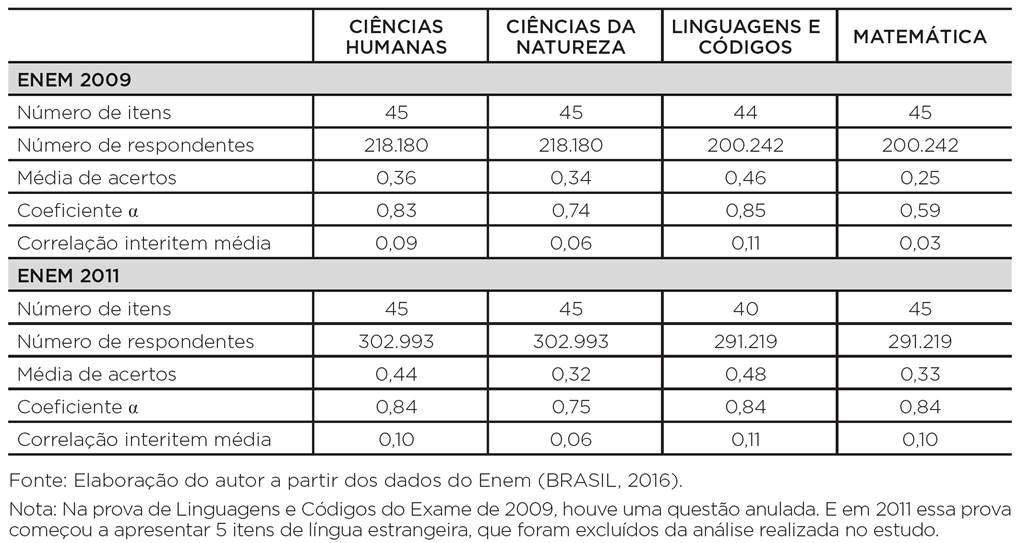

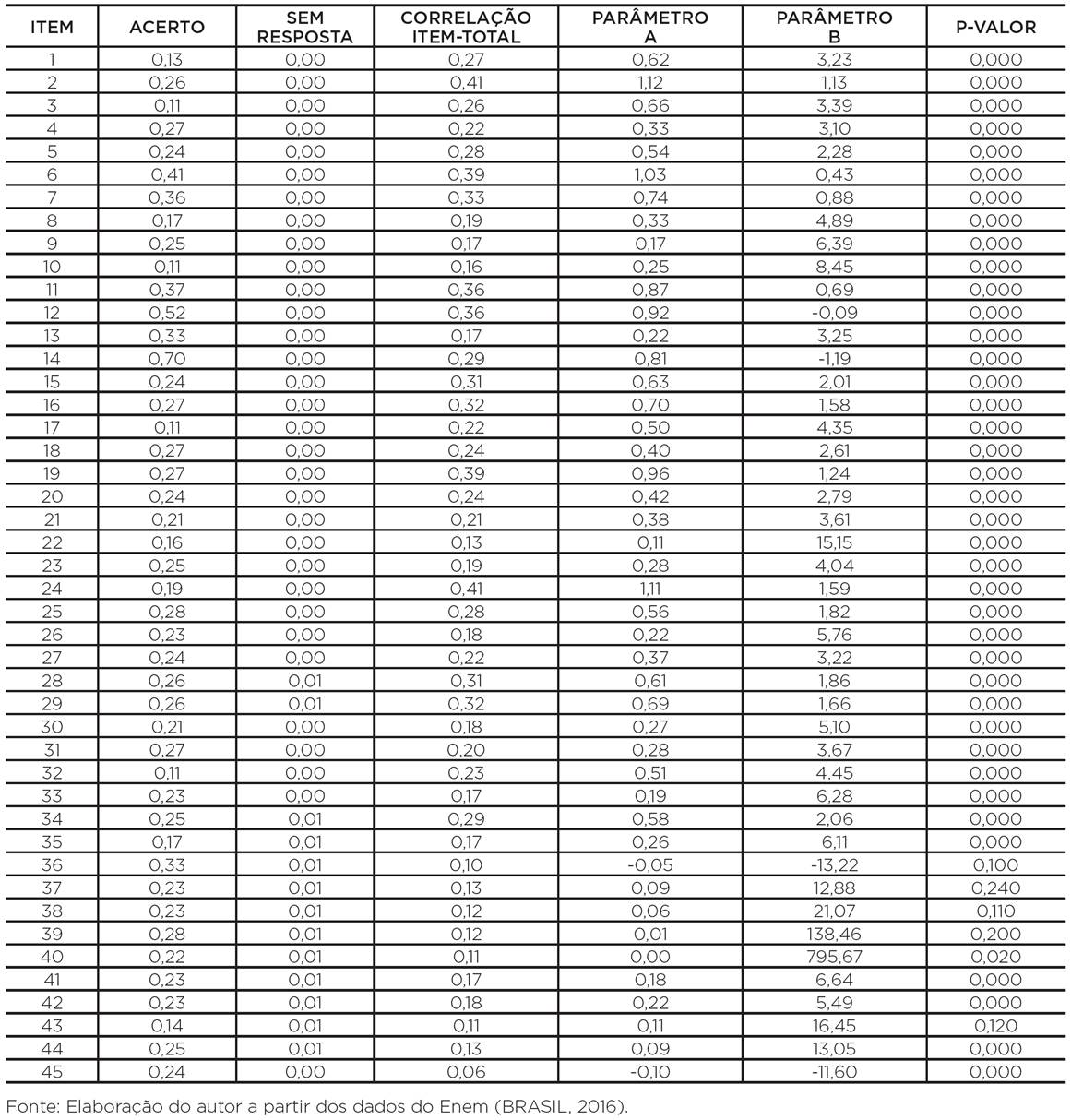

Foram analisados os microdados do Enem de 2009 e 2011. Inicialmente, foi analisado apenas o exame de 2009, por tratar-se da primeira edição do Enem no novo formato.6 Em virtude do “vazamento” da prova em 2009, optou-se por analisar também o de 2011. O exame é composto por quatro provas objetivas, que correspondem às quatro áreas de conhecimento avaliadas: Ciências Humanas (CH), Ciências Naturais (CN), Linguagens e Códigos (LC) e Matemática (MT). A análise psicométrica foi realizada independentemente nas oito provas objetivas, quatro de cada ano. O processo de filtragem reduziu a amostra a menos de 10% do total, como se vê na Tabela 1, para a prova de Ciências Humanas.

Não foram encontrados documentos do Inep explicando certos detalhes metodológicos sobre o cálculo das notas do Enem (por exemplo, se são incluídos todos os registros na calibração dos itens, ou apenas dos concluintes), mas sabe-se que é utilizado o ML3P, que a proficiência é estimada pelo método Expected A Posteriori (EAP),7 e que os cálculos são feitos por três grupos independentes de especialistas (KARINO; BARBOSA, 2012). Na tentativa de garantir a qualidade da análise, os dados foram filtrados segundo quatro critérios: 1) ter estudado em escola regular no EM; 2) ser concluinte do EM; 3) estar presente na prova; 4) ter recebido o caderno azul de prova. A Tabela 1 exemplifica esse recorte da amostra no caso da prova de Ciência Humanas.

Tabela 1: Tamanho da amostra antes e depois do processo de filtragem (provas de Ciências Humanas)

Fonte: Elaboração do autor a partir dos dados do Enem (BRASIL, 2016).

Em relação às provas propriamente ditas, o total foi de 354 itens analisados. Isso porque seriam, a rigor, 180 itens em cada prova, ou seja, 360 itens no total, mas na prova de LC/2011 houve cinco itens relativos à língua estrangeira que foram retirados da análise. Além disso, em LC/2009 há um item anulado no próprio gabarito dos microdados.

Um fato importante que interfere nos resultados é que o ano de 2009 foi certamente peculiar para o Enem, pois houve “vazamento” da prova, e um novo exame precisou ser produzido em curto prazo. Além disso, as mudanças na matriz de referências haviam acabado de ser implementadas; e, portanto, talvez não houvesse itens “de reserva” suficientes no banco de itens para a confecção da segunda prova. Seria esperada, assim, uma qualidade inferior do exame desse ano em relação a outros. Uma hipótese que foi confirmada em nossos resultados.

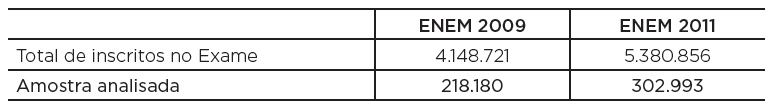

CRITÉRIOS PSICOM ÉTRICOS DO INDICADOR DE QUALIDADE DO ITEM

Para verificar o comportamento empírico dos itens, foram utilizadas técnicas da TCT e da TRI. Para a definição dos limites de cada critério, foram utilizados os referenciais da literatura supracitada, levando também em conta que o Enem é um exame extremamente importante - e deve, portanto, ser um instrumento de alta qualidade.

Tabela 2: Critérios psicométricos utilizados para avaliar a qualidade dos itens das provas objetivas consideradas no estudo

Fonte: Elaboração do autor com base nos dados do Enem (BRASIL, 2016).

Notas: CORR = correlação item-total; BISS = coeficiente bisserial da alternativa correta; o modelo da TRI ajustado foi o ML2PO significado de cada indicador pode ser traduzido, em linguagem mais acessível, nas perguntas:

1. (CORR)8 O item está suficientemente relacionado ao resto da prova?

2. (BISS) A alternativa correta atraiu os mais proficientes?

3. (a) O item discriminou bem no seu nível de proficiência?

4. (FIT) Foi possível ajustar um bom modelo da TRI para este item?

Os dois primeiros indicadores de qualidade do item são provenientes da TCT, enquanto os dois últimos provém da TRI. Seria possível incluir outros indicadores de qualidade, como correlação interitem, amplitude do parâmetro de dificuldade, ou ainda a existência de DIF.

O ML2P, que fornece os indicadores 3 e 4, foi ajustado com as mesmas configurações para as oito provas,9 possibilitando a comparação dos resultados. Seria possível, caso necessário, calibrar de forma mais confiável os itens mal ajustados, com outras configurações ou algoritmos - o que provavelmente ocorreu na análise oficial do Enem.

Além da análise individual de cada indicador, buscou- -se reunir todos em um indicador global simples. Como foi observada correlação entre os três primeiros indicadores, o critério utilizado para o indicador global foi:

RESULTADOS PSICOMÉTRICOS E CONTEÚDO DOS ITENS

Nesta seção analisa-se alguns itens para ilustrar a utilidade das técnicas psicométricas para educadores e formuladores de avaliações. Como o objetivo é investigar certos comportamentos empíricos anômalos, foram selecionados apenas itens com tal característica.

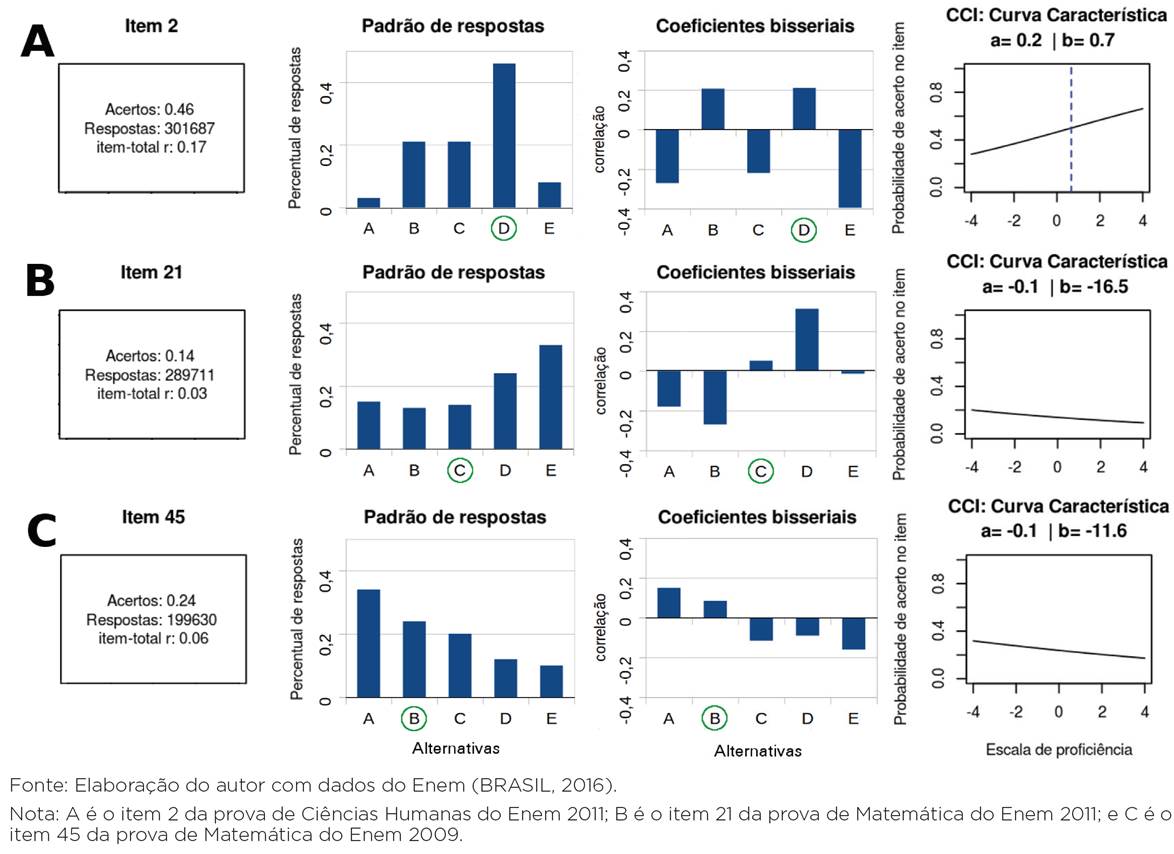

A questão 2 da prova de Ciências Humanas (Figura 1), por exemplo, foi classificada como “duvidosa” em três indicadores, sendo aceitável apenas em termos do FIT. A análise psicométrica revelou que, além disso, em um dos distratores (alternativa B) houve tanta atratividade quanto na alternativa correta (D), o que não seria esperado em um bom item. Ou seja, nas duas alternativas, o coeficiente bisserial ficou em torno de 0,2 (Figura 2A) - o que pode ser considerado alto para um distrator, e baixo para o gabarito.

O enunciado correto (alternativa D) diz que “as normas morais são criadas pelo homem, que concede a si mesmo a lei à qual deve se submeter”, o que parece bastante plausível, embora talvez um pouco idealizado. Contudo, ao notarmos que o enunciado trata inicialmente da “corrupção” e do “distanciamento entre reconhecer e cumprir” como “ambiguidade inerente ao humano”, a hipótese anterior (alternativa D) é tão plausível quanto considerar que “as normas morais são parâmetros idealizados, cujo cumprimento é destituído de obrigação” (alternativa B). É justamente isso que informa o coeficiente bisserial: que as duas alternativas apresentaram a mesma capacidade de atrair os candidatos mais proficientes. Talvez tenha sido esse o motivo pelo qual o item foi classificado como “duvidoso” nos três indicadores.

Ou seja, a análise psicométrica e a leitura do enunciado convergem para o mesmo ponto: o item apresenta duas alternativas plausíveis. Embora não seja desejável em uma prova objetiva, tal duplicidade é bastante comum nas áreas humanas, em especial na filosofia. Diferente das ciências exatas e naturais - em que há grande esforço para se elaborar um único paradigma explicativo e, portanto, uma única resposta considerada correta -, nas ciências humanas e filosofia, é esperado que o aluno aprenda a interpretar a realidade de diversas formas, não necessariamente uma mais verdadeira do que outra. A temática da moral, tratada no item, apresenta diversas tensões internas, e pode ser compreendida sob diferentes perspectivas. O item, curiosamente, mostra duas perspectivas sobre a moral que nos parecem igualmente plausíveis - o que explicaria seu comportamento empírico anômalo. Tais considerações ilustram uma limitação importante das provas objetivas no que se refere a avaliar certas habilidades. O problema proposto pelo item nos parece importante e interessante. Contudo, talvez ele fosse mais bem avaliado com outro tipo de instrumento, como um item dissertativo, uma redação ou mesmo uma prova de múltipla escolha que permitisse ao candidato escolher mais de uma alternativa.

No exemplo do item 2, a psicometria aponta a existência de um distrator demasiadamente atraente, e a análise qualitativa individual do item o confirma - uma evidência da consistência entre ambas as abordagens. A análise psicométrica pode ajudar a confirmar a opinião de educadores e avaliadores a respeito da qualidade dos itens e, no sentido inverso, a observação caso a caso dos itens pode ajudar a confirmar a eficácia da psicometria e interpretar seus resultados.

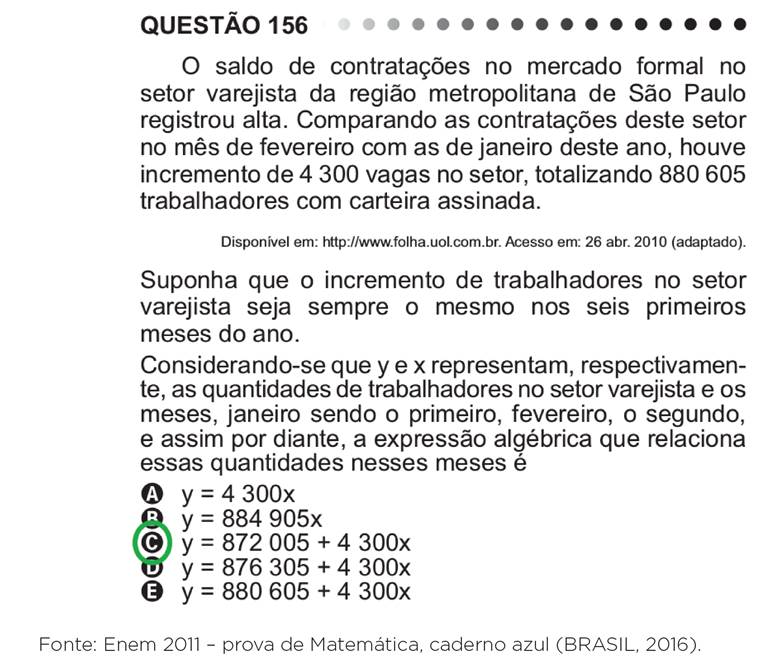

O item 21 da prova de Matemática de 2011 (Figura 3), por sua vez, foi avaliado como “ruim” nos três indicadores (exceto ajuste), sendo portanto considerado “ruim” no indicador global. Ao buscar respondê-lo, uma pessoa com habilidade de usar equações de primeiro grau chegaria, sem grandes dificuldades, à alternativa D. Contudo, para escolher a alternativa correta C, é necessário também que ela seja habilidosa na linguagem escrita, além de ser atenta a pequenos detalhes: como, por exemplo, que o número citado no enunciado (880.605) se refere a fevereiro, e não a janeiro - e que, portanto, x é igual a 2, nesse caso, o que justifica a alternativa C como correta. Os coeficientes bisseriais confirmam a atratividade do distrator D, maior que a da alternativa correta C (Figura 2B).

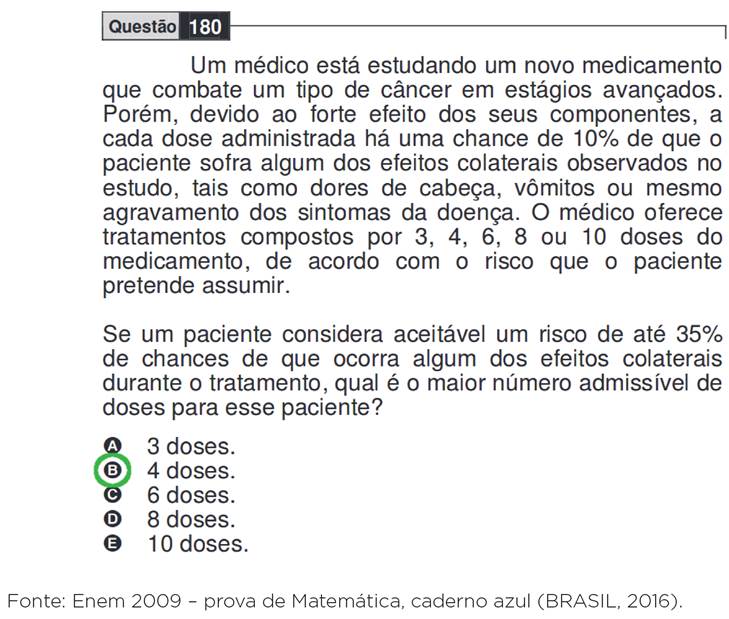

Outro item de Matemática classificado como “ruim” nos três indicadores (exceto ajuste) foi o item 45 da prova de 2009 (Figura 4). Os resultados da análise psicométrica (Figura 2C) sugerem que, mais uma vez, o distrator A atraiu mais os candidatos proficientes do que a alternativa correta B. Embora o item esteja matematicamente correto, a formulação do problema - e as alternativas de resposta - parece ter confundido os candidatos. O item pede que se calcule probabilidades cumulativas partindo de um problema relacionado a remédios. Se o risco de se tomar uma dose é 10%, qual seria o risco de se tomar quatro doses? Aparentemente, seria 40%, como pensaram os candidatos que escolheram a alternativa A. Contudo, para resolver o problema, o candidato deveria calcular a chance de as coisas darem certo, em vez do risco de darem errado. Ou seja, o cálculo correto seria multiplicar 90% por si mesmo quatro vezes (0,94), o que daria um risco em torno de 35%, em vez de 40%.

Em suma, a análise cuidadosa do enunciado dos itens confirma, na maioria dos casos, problemas que foram previamente detectados com técnicas psicométricas quantitativas, mostrando também como a articulação entre metodologias quantitativas e qualitativas pode ser frutífera. As técnicas psicométricas se mostram potencialmente úteis não apenas para gestores e sistemas de avaliação, mas também para os educadores que desejem compreender melhor seus educandos ou saber se suas provas estão bem elaboradas. Evidentemente, reconhecer a eficácia e utilidade das técnicas psicométricas não significa aderir acriticamente a elas nem tampouco que a avaliação educacional se deva reduzir à psicometria. Significa simplesmente que os educadores podem apropriar-se de algumas novas ferramentas que ajudem a resolver velhos e novos problemas.

RESULTADOS PSICOMÉTRICOS E META-AVALIAÇÃO

Dentre as oito provas analisadas, apenas uma apresentou confiabilidade inadequada (α < 0,6): a prova de Matemática de 2009, que também teve a mais alta dificuldade média (Tabela 3). Nota-se também que a prova de Ciências Naturais apresentou, nos dois anos, confiabilidade aceitável, porém próxima do limiar inferior. Se esse fato se confirma em outros anos, mereceria maiores investigações. As provas de Ciências Humanas e Linguagens e Códigos, por outro lado, mostraram-se excelentes em termos de confiabilidade, de acordo com os padrões esperados do coeficiente α.

Cabe notar também que, em todas as provas, a correlação interitem média foi maior do que zero, e não passou de 0,1, sugerindo que não há grande sobreposição entre os itens, de forma a garantir minimamente o pressuposto da independência local, necessário para os modelos da TRI utilizados neste trabalho e também pelo Inep, a partir de 2009. Uma correlação interitem muito alta pode indicar redundância de dois itens (ZAICHKOWSKY, 1994). Por outro lado, uma correlação interitem média de 0,03 confirma a baixa confiabilidade da prova de Matemática de 2009, apontada pelo coeficiente α.

O outro pressuposto, da unidimensionalidade, foi verificado por meio de análise fatorial para um fator, análise da estrutura muito simples (Very Simple Structure) e análise paralela sobre a matriz de correlações tetracóricas dos itens. Em todas as provas, a análise fatorial e a estrutura muito simples mostraram que um fator é suficiente para abarcar a variabilidade das respostas. Há, porém, frequentemente um segundo fator significativo, embora de menor importância, detectado pela análise paralela. De modo geral, esses resultados confirmam o cumprimento dos pressupostos básicos para o uso dos modelos logísticos da TRI.

Em relação ao grau de dificuldade, nota-se, de um modo geral, que nenhuma prova se mostrou fácil, o que seria esperado, de acordo com as especificações do Enem: 20% de itens fáceis; 40%, médios; e 40%, difíceis.10 As provas de Linguagens e Códigos apresentaram nível médio nos dois anos próximo a 50% de acertos. As provas de Ciências da Natureza e Matemática se mostraram consideravelmente difíceis, chegando a 25% de acertos, valor próximo à probabilidade de acerto ao acaso no Enem (20%). De acordo com os princípios da TRI, representados, por exemplo, na Curva de Informação do Teste (ANDRADE; TAVARES; VALLE, 2000), um exame que se concentra na porção superior da escala de proficiência pode ser pouco informativo sobre indivíduos de média e, principalmente, baixa proficiência. É possível, portanto, que o alto número de itens difíceis11 tenha levado à baixa confiabilidade da prova MT/2009, tanto em α quanto na correlação interitem média.

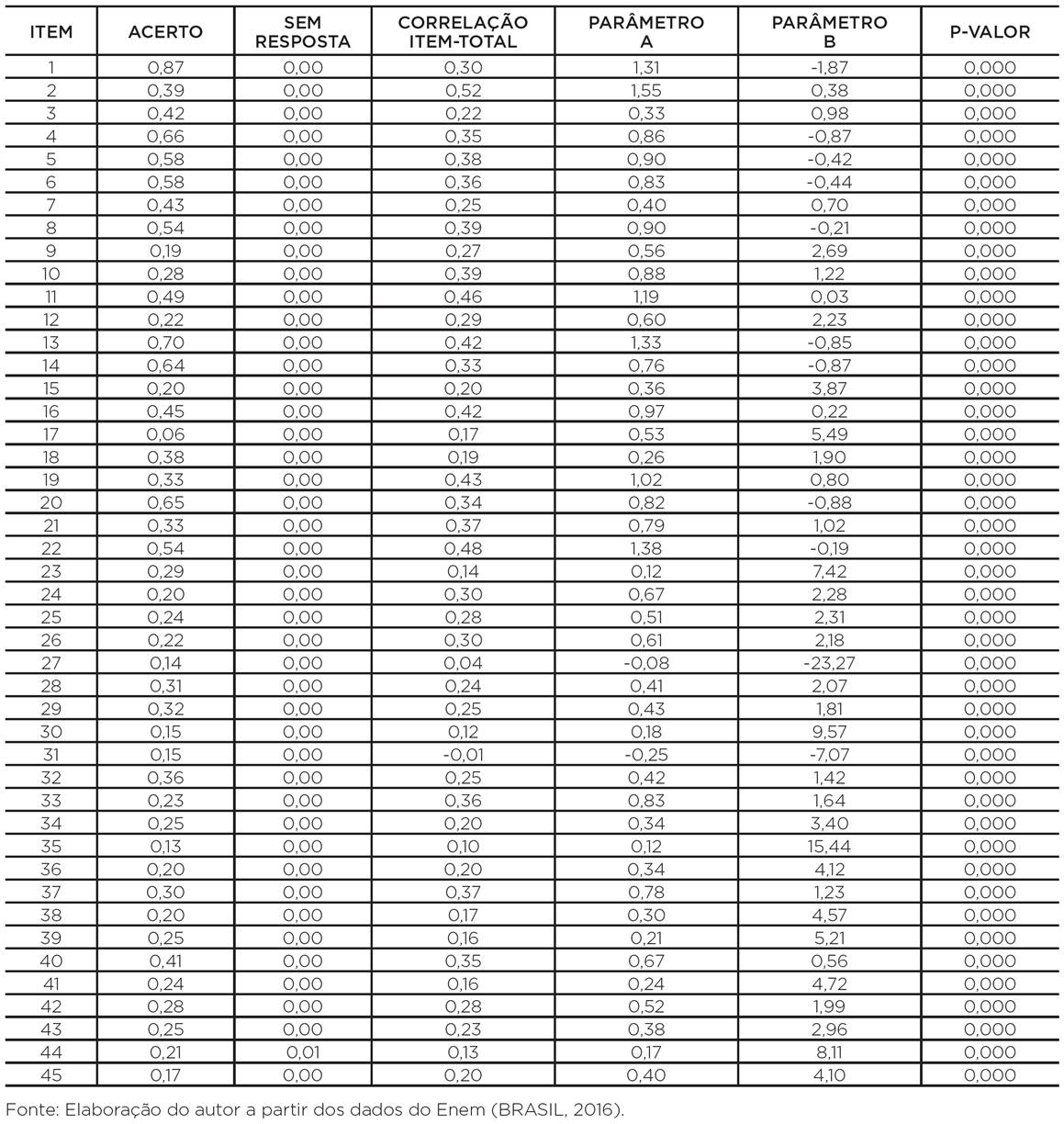

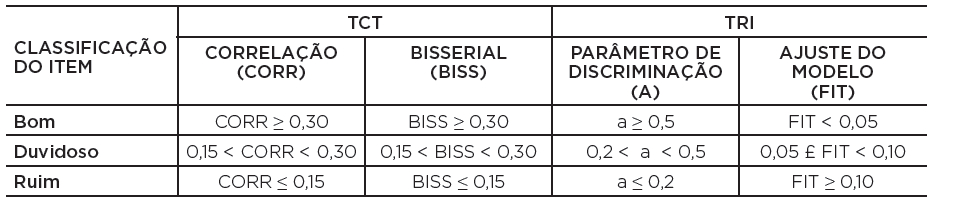

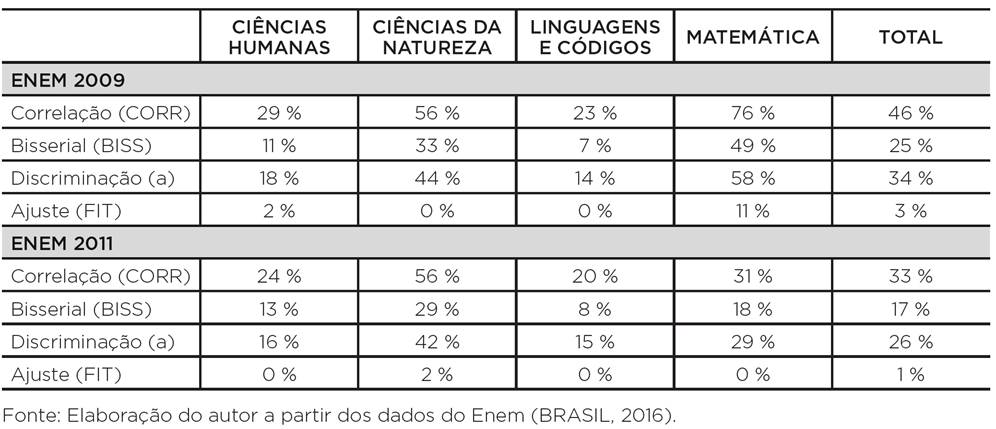

A Tabela 4 sintetiza os resultados gerais para cada indicador, em cada uma das oito provas. O critério que mais detectou itens possivelmente problemáticos foi, nos dois anos, a correlação item-total. Tal fato sugere que os limites adotados nesse critério podem ser demasiadamente rigorosos em relação aos outros; ou, alternativamente, também é possível que tais resultados indiquem certa dificuldade de se elaborar itens coerentes com uma suposta competência geral não observável. A discriminação do item também se mostrou sensível a comportamentos empíricos anômalos, sendo o segundo critério que mais identificou itens duvidosos ou ruins. Por fim, como seria de se esperar, dadas as condições privilegiadas de calibração - como uma grande amostra e número razoável de iterações -, há poucos itens com problema de ajuste. Mas destaca-se o fato de que, dos 45 itens da prova de Matemática de 2009, cinco apresentaram problemas de ajuste no ML2P.

Tabela 4: Porcentagem de itens classificados como duvidosos ou ruins segundo os critérios definidos no estudo, em cada uma das oito provas avaliadas

Nota-se também que, em 2009, houve 82 itens (46% do total) com correlação item-total menor do que 0,3 - condição importante para que um item possa de fato acrescentar algo à prova como um todo. Em 2011, foram identificados 58 itens (33%) com tal característica. Nesse sentido, embora a TRI permita que se produza resultados levando em conta essas diferentes “contribuições” de cada item,12 uma frequência alta de itens pouco coerentes entre si (ou, em termos teóricos, com o construto subjacente à prova como um todo) pode ser considerada, no mínimo, certo desperdício de recursos públicos e privados.

Outra informação pertinente apresentada na Tabela 4 são os itens com bisseriais baixos. Isso porque o limite mínimo estabelecido para um bom item (0,3) corresponde ao limite estabelecido para triagem de itens na elaboração do “antigo Enem” (FINI, 2005). Com efeito, os resultados mostram que, segundo as especificações psicométricas do Enem, houve 45 itens (25%) inadequados na prova de 2009, enquanto em 2011 esse número foi reduzido a 30 (17%).

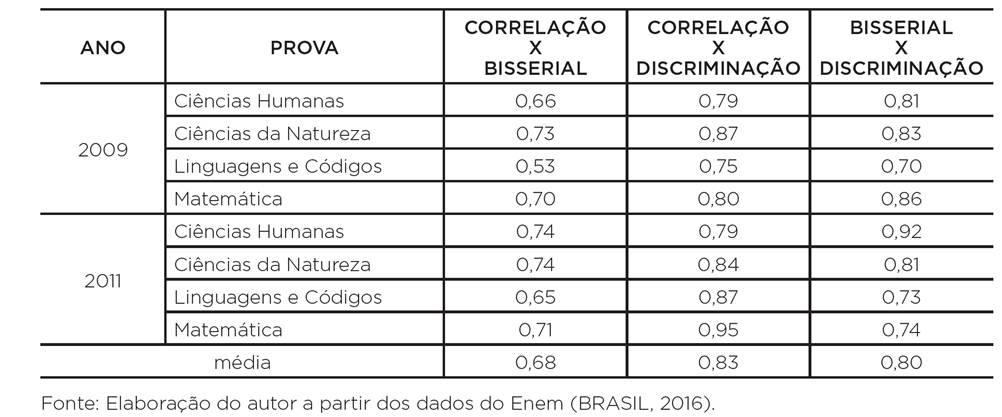

Observando cada indicador separadamente, cabe agora saber como eles se relacionam. A Tabela 5 mostra que há alta correlação entre eles, especialmente nas correlações que envolvem o parâmetro de discriminação - sugerindo que esse indicador poderia reunir, de forma sintética, os resultados do trio (correlação item-total, bisserial e discriminação). Cabe notar também que a correlação entre a correlação item-total e a correlação bisserial se mostrou significativamente mais baixa do que as outras duas, que por sua vez se mostraram semelhantes entre si (Teste T, p<0,01). O ajuste (FIT) não foi incluído por ter menor variância, mas todos os sete itens com problema de ajuste apresentavam problemas nos outros indicadores.

Tabela 5: Correlações de Spearman entre os indicadores psicométricos adotados no estudo, considerando a classificação dos itens em cada um deles como “bom=0”, “duvidoso=1” ou “ruim=2”, para cada uma das oito provas avaliadas

Algumas possíveis explicações, não excludentes entre si, para as altas correlações observadas seriam: os limites estabelecidos nos critérios deste trabalho são adequados e, em alguma medida, correspondentes entre si;13 os três indicadores se referem a características semelhantes dos itens; as três características dos itens mensuradas pelos indicadores podem ser diferentes, mas estão intimamente ligadas na prática.

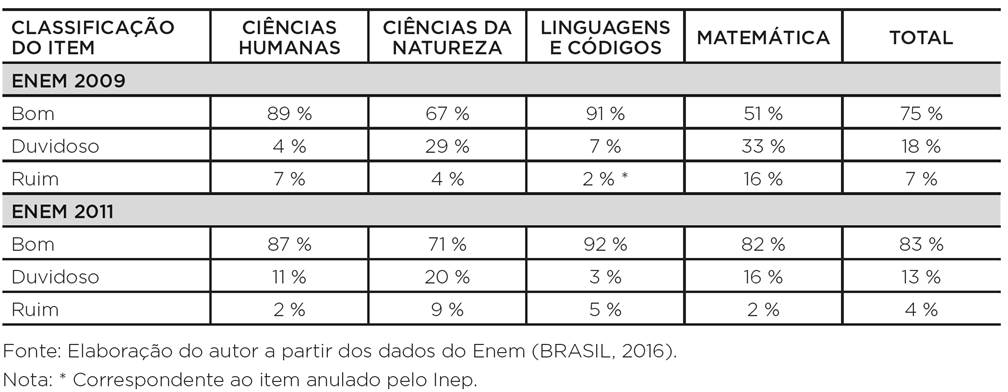

Seja qual for a explicação, a correlação encontrada entre os indicadores nos levou a certas opções no momento de articulá-los em um indicador global de qualidade do item. Foi considerado globalmente “duvidoso” o item avaliado como “duvidoso” em pelo menos três indicadores, ou “ruim” em um ou dois. De forma semelhante, foi considerado globalmente “ruim” o item avaliado como “ruim” em pelo menos três indicadores. Os resultados podem ser conferidos na Tabela 6.

Tabela 6: Porcentagem de itens classificados como bons, duvidosos ou ruins, segundo o indicador global definido no estudo, em cada uma das oito provas avaliadas

Considerando, portanto, o conjunto de itens “duvidosos” e “ruins”, o indicador global apontou um total de 46 itens (25%) com comportamento empírico anômalo no ano de 2009, e 30 itens (17%) em 2011. Resultado praticamente idêntico ao obtido com apenas um dos três indicadores, o bisserial (BISS), segundo o critério estabelecido no “antigo Enem”.

Cabe observar, por fim, que um elemento associado aos problemas de qualidade das provas de Matemática e Ciências da Natureza de 2009 é a posição do item na prova. Em geral, os itens com comportamento anômalo se encontram na parte final do teste (ver Anexo). Uma possível explicação é que os itens anteriores demandassem muito trabalho, levando os candidatos a uma maior exaustão mental (ou menor tempo disponível) ao final da prova. Outra possível explicação, não excludente, é que boa parte dos candidatos tenha deixado de fazer as questões por considerá-las excessivamente difíceis, sendo assim mais produtivo investir o tempo de prova nos outros itens. Ambas explicações estão de acordo com o alto grau de dificuldade observado nessas provas (ver Tabela 3).

CONCLUSÃO

De modo geral, segundo os critérios adotados, o Enem apresentou qualidade adequada em 2011, porém duvidosa em 2009. A confiabilidade da prova de Matemática de 2009 se mostrou abaixo dos limites considerados aceitáveis (α < 0,6).

Por outro lado, as outras sete provas não apresentaram esse problema. É importante levar em conta que, em 2009, um ano de grandes mudanças estruturais, a prova do Enem precisou ser refeita, devido a um “vazamento” de itens.

Um fato talvez relevante é que a prova de Ciências Naturais apresentou indicadores relativamente piores nos dois anos, o que pode sugerir necessidade de revisão de procedimentos para criação e revisão de itens dessa área do conhecimento. A área de Linguagens e Códigos, por sua vez, apresentou os melhores índices nos dois anos.

Para avaliar os itens, utilizou-se quatro indicadores: 1) CORR = correlação item-total; 2) BISS = coeficiente bisserial da alternativa correta; 3) a = Parâmetro a (discriminação) do ML2P; 4) FIT = ajuste ao modelo ML2P. Os três primeiros indicadores apresentaram alta correlação entre si, especialmente com a discriminação. Além disso, os resultados do BISS (coeficiente bisserial da alternativa correta) foram praticamente idênticos (quando vistos de forma geral) aos resultados do indicador global: 25% de itens com comportamento empírico anômalo em 2009, e 17% em 2011. Se considerados apenas os itens avaliados como “ruins” no indicador global, os resultados diminuem para 7% em 2009, e 4% em 2011.

Os resultados das diferentes técnicas utilizadas, de um modo geral, apresentaram considerável coerência entre si, confirmando a robustez das teorias e métodos adotados neste trabalho. É importante destacar, por outro lado, que foram consideradas apenas algumas propriedades psicométricas, como confiabilidade e discriminação, mas não se tratou a questão da validade, por exemplo. É possível, portanto, que itens com comportamento anômalo (segundo os critérios psicométricos aqui adotados) sejam ainda assim importantes devido ao seu conteúdo, caso este contribua significativamente para a validade do teste e sua coerência com a matriz de referência.

De modo geral, nossos resultados confirmam a qualidade técnica do Enem, levando em conta que em 2009 houve circunstâncias singulares que não mais se repetiram. Isso não significa que se deva deixar de aprimorar os procedimentos para criação, revisão e triagem de itens. Pelo contrário, nossos resultados mostram que, mesmo em 2011, houve 17% de itens que, segundo o próprio critério psicométrico do Enem (coeficiente bisserial menor que 0,30), não deveriam ter sido incluídos na prova. Como se trata de um exame bastante importante para o país, qualquer imprecisão de medida pode gerar efeitos indesejáveis.

Vale destacar, ainda, a importância do trabalho realizado pelo Inep ao publicar as informações detalhadas sobre o exame (que incluem todas as respostas de cada aluno nas quatro provas e no questionário socioeconômico, além da documentação técnica), tornando possível grande diversidade de pesquisas nas áreas de educação, psicometria, sociologia, políticas públicas, dentre outras. Ao longo dos anos, o Inep tem primado pela transparência e aprimorado os procedimentos relativos ao Enem. Buscando contribuir nesse sentido, cabe-nos destacar algumas lacunas encontradas durante este estudo. Após uma intensa busca no portal do Inep, restaram algumas questões: 1) Todos os itens são sempre incluídos na estimação da proficiência? Se não, quais são os critérios para exclusão? Se sim, resta a questão dos itens mal ajustados ou que apresentaram correlação item-total negativa. 2) Como é feito o processo de calibração dos itens? Supõe-se que seja no pré-teste, de forma a permitir a comparabilidade das notas entre os anos. Neste caso, que tipo de amostra é utilizada? Ela representa os formandos de ensino médio de escolas regulares, ou outro tipo de população? 3) Quais foram os parâmetros de cada item utilizados na estimação das proficiências? Por que eles não são públicos como os microdados? 4) Quais são os procedimentos utilizados para garantir a qualidade dos itens e da prova, especialmente a partir de 2009?

Por fim, buscou-se neste artigo mostrar também algumas utilidades das técnicas psicométricas, tanto para educadores quanto para a meta-avaliação. Ao ressaltar a importância da psicometria para a educação, não se pressupõe aqui que ela produza resultados inequívocos, ou que a medida numérica seja sempre desejável na avaliação educacional. Tampouco se pressupõe que a educação deva, seja em termos epistemológicos ou práticos, ser reduzida ou submetida à psicometria.

Trata-se, aqui, apenas de esclarecer alguns conceitos da psicometria clássica e moderna, exemplificá-los e aplicá-los em um importante exame nacional, mostrando que há uma “caixa de ferramentas” interessante e útil aos educadores, que parece ainda subaproveitada no cotidiano escolar.