INTRODUÇÃO

Em 2004, foi aprovada a Lei n. 10.861 (BRASIL, 2004a), que instituiu o Sistema Nacional de Avaliação da Educação Superior (Sinaes) e criou a Comissão de Avaliação da Educação Superior (Conaes) para coordená-lo. Considerado uma evolução efetiva no processo de avaliação da educação superior brasileira (WEBER, 2010, p. 1259), o sistema teve como objetivo avaliar as Instituições de Educação Superior (IES), seus cursos de graduação e o desempenho acadêmico dos seus estudantes. Para tanto, estruturou-se em três grandes modalidades:

a Avaliação das IES (Avalies), com o objetivo de identificar o perfil da instituição, sua atuação junto à comunidade, suas ações sociais, seus projetos e programas, utiliza-se de dois procedimentos básicos de avaliação: (i) a autoavaliação, realizada pela Comissão Própria de Avaliação (CPA) - uma comissão interna institucional que trabalha em um universo de dez dimensões a serem avaliadas e que englobam desde os documentos norteadores, como o plano de desenvolvimento institucional e projeto pedagógico institucional, até os aspectos relacionados à sustentabilidade financeira da instituição -; e (ii) a avaliação externa in loco, estabelecida por meio de comissões de especialistas;

a Avaliação dos Cursos de Graduação (ACG), que identifica as condições de ensino oferecidas pela instituição: sua infraestrutura física, salas de aula e laboratórios, assim como seus recursos humanos, em especial o corpo docente e a organização didático- pedagógica. A avaliação é realizada por meio de uma comissão de avaliadores específicos da área do curso que dispõe de um instrumento padrão para a avaliação;

a avaliação do desempenho dos estudantes (Enade), que objetiva estabelecer indicadores de desempenho dos estudantes no âmbito dos conteúdos previstos nas diretrizes curriculares do curso de graduação, bem como das habilidades e competências mínimas requeridas para o exercício profissional de qualidade.

O estabelecimento do novo sistema foi pautado em princípios fundamentais (BRASIL, 2004b, p. 86-93), entre os quais se destacam:

responsabilidade social com a qualidade da educação superior;

reconhecimento da diversidade do sistema;

respeito à identidade, à missão e à história das instituições;

globalidade, isto é, compreensão de que a instituição deve ser avaliada a partir de um conjunto significativo de indicadores de qualidade, vistos em sua relação orgânica e não de forma isolada; e

continuidade do processo avaliativo.

Tais princípios promoveram uma nova visão1 sobre o processo avaliativo institucional. Sinalizava-se a passagem de um modelo de regulação para um modelo de avaliação democrática (CONTERA, 2002, p. 134), em que os processos avaliativos são baseados em colaboração e participação, em vez de um enfoque competitivo, e os indicadores utilizados apontariam para a qualidade institucional como um todo e não apenas para o desempenho; no novo sistema, este estaria representado por apenas uma das modalidades, o Enade.2 A avaliação das IES brasileiras abandonava um modelo quantitativo (o Exame Nacional dos Estudantes) para adotar um modelo misto. Contera (2002, p. 134) destaca que, nesse modelo - autorregulador, do ponto de vista filosófico -,

[...] critica-se a racionalidade instrumental como sendo incapaz de argumentar a qualidade valorativa dos fins com os quais se relaciona. Recupera-se o interesse emancipatório concebido não exclusivamente como o interesse cognoscitivo prático da ciência, como interesse emancipador através da auto-reflexão.

Suas diretrizes caracterizaram essa intenção e, apoiadas em pressupostos tanto acadêmicos quanto políticos, estabeleciam seis pontos-chave: a participação ativa dos sujeitos; os valores acadêmicos fundamentais; o papel das IES como instituições estratégicas para as políticas setoriais nas áreas científica, tecnológica e social; o papel do Estado; o recredenciamento periódico das IES e a implantação de um sistema de avaliação que tivesse como principal objetivo a melhoria da qualidade acadêmica e da gestão institucional (BRASIL, 2004b, p. 10-11).

Por um lado, essas diretrizes apontavam diretamente para um processo de avaliação em que avaliados também seriam avaliadores, de forma que “o sujeito do processo pode ser também objeto de avaliação em determinadas etapas e sempre de acordo com as normas estabelecidas” (DIAS SOBRINHO, 2000, p. 119), o processo fosse marcado pela liberdade institucional de estabelecer seus princípios norteadores e sua relação com a realidade em que se insere, e a figura da universidade fosse considerada parte fundamental no estabelecimento de políticas sociais. Por outro lado, explicitava- se o papel do Estado como agente regulador para a promoção contínua da qualidade da educação superior. Esse delicado equilíbrio entre autonomia institucional em seu processo de autorregulação e regulação externa por meio do Estado é apontado no documento inaugural do novo sistema:

(1) o deslocamento de centro de avaliação de uma prova para um conjunto diversificado de instrumentos, (2) a integração dos instrumentos de avaliação e de informação e dos processos avaliativos desenvolvidos por diferentes órgãos do Ministério da Educação e dos sistemas estaduais, (3) a valorização dos aspectos qualitativos e interpretativos nos processos e instrumentos, (4) a institucionalização de programas permanentes de capacitação de avaliadores, (5) a criação e consolidação da cultura de auto-avaliação nas Instituições de Ensino Superior, e (6) a implantação de processos de meta-avaliação. (RISTOFF, 2004, p. 179)

Ressaltam-se aqui os principais pontos de mudança do Sinaes em relação às práticas avaliativas anteriores: a diversificação de instrumentos para atender à pluralidade institucional; o retorno dos aspectos qualitativos nos processos avaliativos; a natureza contínua desse processo e o aspecto formativo e emancipatório da avaliação, pautado na investigação, autorreflexão e autotransformação institucional. Por meio da interação entre suas três modalidades - a avaliação somativa do processo de ensino, configurada no desempenho dos alunos no Enade, a avaliação por pares para os cursos (ACG) e a avaliação formativa de toda a instituição, por meio do processo contínuo de autoavaliação dirigido pela CPA (Avalies) -, o sistema previa sua autorregulação, a partir de sua meta-avaliação - prevista no item 3.3.3 na proposta original do Sinaes (BRASIL, 2004b, p. 112).

Nesses dez anos de implantação do sistema, a proposta inicial de uma dinâmica entre as modalidades (que efetivasse o processo de avaliação e, consequentemente, obtivesse recortes adequados para a regulação) não ocorreu da maneira idealizada, conforme demonstrado no decorrer deste trabalho. O Enade se transformou na modalidade principal: os índices derivados dos seus resultados foram (e são) utilizados de forma automática nos processos regulatórios de renovação de reconhecimento de curso, e a ACG, somente nos processos de reconhecimento, renovações de reconhecimento em que o curso não é contemplado no Enade ou nos casos em que o Conceito Preliminar de Curso (CPC) não tenha sido satisfatório.

Configura-se aqui uma subordinação da avaliação por pares ao exame de desempenho dos estudantes, tendo em vista o peso que este tem na composição do CPC, como se verá adiante. Quanto à Avalies, sua relação com as duas outras modalidades é fraca ou inexistente. A relação entre a Avalies e a ACG se resume a um único indicador, que trata da inserção da IES no contexto socioeconômico regional, a ser elaborado pela CPA para apreciação da comissão de avaliação externa na ACG. Não ocorre relação direta entre a Avalies e o Enade e nem a Avalies é considerada de alguma forma na construção dos índices de regulação CPC e IGC,3 que incluem insumos voltados ao desempenho dos estudantes e cursos de graduação e pós-graduação.

Espera-se que a Avalies, como processo maior de avaliação frente às duas outras modalidades, utilize os resultados destas em seu processo de autoavaliação. Mas os resultados da Avalies, expostos nos relatórios de autoavaliação publicados bianualmente, não são considerados no processo regulatório, ou seja, findam em si mesmos, não provocando movimentos posteriores no sistema de avaliação. Parte desses relatórios nem poderia ser utilizada para tal fim. Um estudo realizado pelo Instituto Nacional de Pesquisa e Estudos Educacionais Anísio Teixeira (Inep) acerca dos relatórios de autoavaliação mostrou que parte das Comissões Próprias de Avaliação “apontam a falta de compreensão do seu propósito dentro do universo institucional” (BRASIL, 2011, p. 96), e “mais da metade dos relatórios analisados situou-se nas faixas 3 e 4, ou seja, sem a devida análise” (BRASIL, 2011, p. 83).

A proposta original do Sinaes estabelecia outra relação entre as modalidades: a Avalies seria “o instrumento central, organizador da coerência do conjunto” (BRASIL, 2004b, p. 94) e, nesta, o processo de autoavaliação seria “o primeiro instrumento a ser incorporado ao conjunto de instrumentos constitutivos do processo global de regulação e avaliação” (BRASIL, 2004b, p. 103). A autoavaliação articularia dois instrumentos: “a) um auto-estudo segundo o roteiro geral proposto em nível nacional, acrescido de indicadores específicos, projeto pedagógico, institucional, cadastro, censo; e b) o novo instrumento, o Paideia” (BRASIL, 2004b, p. 104). A avaliação externa (a ACG) deveria ser realizada assegurando uma “análise crítica dos relatórios e materiais produzidos na autoavaliação e demais documentos da instituição que tenham interesse para a avaliação institucional” (BRASIL, 2004b, p. 109). A proposta original ainda previa que a Avalies, em sua componente autoavaliativa, e a ACG teriam como base de informação o Paideia. Este teria como requisito básico “se articular a outros procedimentos avaliativos mais amplos e tendentes à compreensão de conjunto dos cursos, das áreas, das instituições, do sistema, especialmente à avaliação institucional” (BRASIL, 2004b, p. 113).

Perceba-se que o Paideia, renomeado como Enade na publicação da lei do Sinaes (BRASIL, 2004a), originalmente era uma modalidade considerada um processo auxiliar da avaliação institucional, a modalidade maior. Sua concepção derivou das críticas apontadas ao antigo exame nacional de cursos que embasaram a proposta original do Sinaes, masque hoje são aplicáveis ao Enade. Citam-se três:

g) a constatação de que os conceitos divulgados à população, supostamente indicativos de qualidade, não expressam a real qualidade dos cursos, gerando desinformação e desorientação do grande público. A distribuição dos intervalos das notas que geram os conceitos atribuídos aos cursos evidenciam que um conceito A não significa, como é de se esperar, um curso de boa qualidade, assim como, um conceito D pode não indicar um curso de má qualidade.

h) a divulgação dos resultados do ENC desvinculados de outros processos avaliativos, atribuindo a ele centralidade no sistema de avaliação e autoridade exclusiva ao comunicar ao grande público a suposta qualidade dos cursos; e i) a adoção de políticas de premiação e punição de instituições com base em conceitos gerados por um instrumento e por uma metodologia deficiente e, portanto, incapazes de expressar com confiabilidade a qualidade dos cursos. (BRASIL, 2004b, p. 62-63)

Nas três afirmativas, há paralelismo com o Enade no que tange à relatividade dos conceitos – em que um conceito 5 em uma determinada área não significará melhor desempenho que um conceito 3 de outra área –; à divulgação do CPC desvinculada do conceito de curso (CC) atribuído pela ACG; e à adoção de medidas como a dispensa de avaliação in loco para novas autorizações de curso conforme o IGC da IES.

Na operacionalização do Sinaes, o Enade tomou a frente às demais modalidades, tanto por sua dimensão quanto por sua característica técnico-instrumental. Na distribuição de esforços, pesou muito o fato de que o universo da Avalies é de cerca de 2.500 IES, o da ACG é de 12.000 cursos e o do Enade, a cada ano, é de quase 200.000 concluintes. Além disso, o princípio cartesiano-positivista da neutralidade não é respeitado na Avalies, na qual avaliador e avaliado se confundem, nem na ACG, na qual o avaliador externo é par do avaliado; já no Enade o desempenho do aluno é considerado medida neutra e suficientemente distante na composição do desempenho institucional. Ademais, o desempenho é um produto mensurável do processo, mais simples de ser apreendido pelo público não especializado do que os juízos de valor. E, por fim, como apontado por Fernandes et al. (2009, p. 6):

A legislação vigente prevê que todos os cursos sejam visitados a cada três anos, o que, dado o grande número de cursos, exigiria uma estrutura muito maior que a disponível. [...] Ao dispensar da visita os cursos com indicador 3, 4 e 5, o CPC viabiliza as avaliações in loco e, por servir de guia para os avaliadores, induz uma maior coerência entre essas avaliações e os indicadores objetivos de qualidade.

Dentre os estudos realizados acerca do Enade, e especificamente do CPC, destacam-se a discussão sobre o processo de avaliação das instituições de educação superior brasileiras no período de 1995 a 2009 e o uso de exames gerais em avaliações de larga escala, conduzida por Dias Sobrinho (2010), e o impacto das mudanças na composição dos pesos do CPC na avaliação das IES (BITTENCOURT et al., 2010).

No entanto, apesar de o CPC ter sido utilizado desde 2008 pela mídia como um índice de classificação da qualidade das IES, não foram realizados estudos suficientes que permitam caracterizar as relações entre os insumos utilizados para o CPC e o desempenho dos estudantes expresso no Enade e, consequentemente, expor a “estrutura” causal entre esses insumos escolhidos como indicadores da qualidade do curso e o índice final dessa qualidade, o desempenho do estudante concluinte.

Diante desse panorama, propôs-se neste estudo uma investigação do Conceito Preliminar de Curso, por meio da relação entre o desempenho aferido no triênio 2008-2010 do Enade e os indicadores de qualidade utilizados em seu cômputo. Com base nisso, pretendeu-se examinar a premissa de que o CPC pode ser generalizado para todo o contexto educacional brasileiro.

Assim, os objetivos do estudo4 foram:

caracterizar o desempenho dos cursos das IES no triênio 2008-2010 do Enade, por meio da nota contínua desse exame;

analisar as relações dos indicadores considerados como insumos, ou seja, as notas padronizadas de mestres, doutores, docentes em regime parcial ou integral, organização didático-pedagógica e infraestrutura, com o desempenho;

analisar as relações entre os tipos de instituições: universidades públicas e privadas, centros universitários privados e faculdades privadas;

estabelecer o grau de generalização do CPC.

Para o alcance desses objetivos, o estudo utilizou técnicas estatísticas e análises qualitativas que serão desenvolvidas nos itens que seguem. Desse modo, o trabalho traz uma breve explicação sobre a constituição do Sinaes e do CPC e a descrição da metodologia utilizada para produção e análise dos dados. Em seguida, apresentam-se a síntese dos principais resultados obtidos e as considerações finais.

O Sinaes e o CPC

O Enade5 consiste em um exame dividido em duas provas: Formação Geral e Componente Específico, além de um questionário socioeconômico de 54 questões que o estudante responde on-line antes de realizar a prova. A prova de formação geral é composta por dez questões, oito de múltipla escolha, com 60% do peso da prova, e duas dissertativas, com 40% do peso da prova. A prova do componente específico contém 30 questões, 27 de múltipla escolha, que compõem 85% do peso da prova, e as três últimas questões dissertativas, com 15% do peso da prova. O desempenho dos estudantes, tanto ingressantes6 quanto concluintes, chamado atualmente de “nota contínua do Enade”, é calculado com base nessas duas provas, com peso de 75% para a prova de componente específico e 25% para a de formação geral.

A partir da nota final calculada,7 constrói-se, para cada curso das áreas que foram avaliadas no exame, outro indicador: o IDD – indicador de diferença entre o desempenho esperado e o observado. Este é construído a partir de uma equação linear que tem como variáveis: a nota contínua do Enade, a proporção de estudantes ingressantes cujo pai e/ou mãe tem nível superior de escolaridade, a razão entre o número de concluintes e o número de ingressantes, a proporção de docentes com título mínimo de doutor, a proporção de docentes com título mínimo de mestre, a proporção de docentes com regime de trabalho integral ou parcial, a proporção de alunos que avaliaram positivamente um aspecto da infraestrutura do curso e a proporção de alunos que avaliaram positivamente um aspecto da organização didático-pedagógica do curso. As notas contínuas do Enade e IDD são convertidas em faixas que variam de 1 a 5, chamadas de conceito Enade e IDD. As duas notas contínuas são utilizadas para a construção do Conceito Preliminar de Curso. Este é calculado a partir da seguinte fórmula:8

CPC = (0,20 * NPD) + (0,05 * NPM) + (0,05 * NPR) + (0,05 * NI) + (0,05 * NO) + (0,30 * NIDD) + (0,15 * NIng) + (0,15 * NConc)

Os insumos descritos a seguir são utilizados para o cálculo da fórmula. NPD, NPM e NPR9 referem-se referem-se às notas padronizadas relativas aos percentuais de doutores, mestres e docentes em regime de tempo integral ou parcial, provenientes do Censo da Educação Superior. As notas padronizadas referentes à infraestrutura (NI) e organização didático-pedagógica (NO) são obtidas no questionário socioeconômico preenchido pelo estudante que presta o Enade. A pergunta do questionário do Enade10 sobre infraestrutura foi a seguinte: “Aulas práticas: os equipamentos disponíveis são suficientes para todos os alunos?”. 11 Já a pergunta sobre a organização didático-pedagógica utilizada foi: “Os planos de ensino contêm todos os seguintes aspectos: objetivos; procedimentos de ensino e avaliação; conteúdos e bibliografia da disciplina?”.12

Os demais insumos são aqueles derivados do Enade, já mencionados anteriormente: NIDD, a nota referente ao IDD (indicador de diferença entre o desempenho esperado e o observado); NIng, a nota dos ingressantes; e NConc, a nota dos concluintes – também padronizados como as demais variáveis.

A fórmula do CPC expõe a lógica de sua construção: o conceito de um curso, de acordo com o cálculo atualmente utilizado, deriva em parte da qualidade do seu corpo docente (30% da nota), aqui expressa pelos percentuais de mestres e doutores e pelo regime de trabalho em tempo parcial e integral, relativizados em desvios da média derivados da transformação normal; da opinião dos estudantes que responderam ao questionário socioeconômico do Enade (15% da nota) representada em duas das 54 questões do formulário; e, majoritariamente, do desempenho expresso pelas notas contínuas do Enade e IDD (55% da nota).

Observa-se a heterogeneidade das variáveis que compõem o CPC como seus insumos: as primeiras consistem em dados objetivos informados pela própria IES; em contrapartida, NI e NO advêm da opinião dos estudantes em relação a somente duas questões do questionário, que pretendem dar indicação acerca da qualidade da infraestrutura e da organização didático-pedagógica do curso. Em síntese, o CPC, que consiste hoje no principal índice da qualidade de um curso utilizado para a regulação da educação superior brasileira, revela essa qualidade por meio de suas duas pontas, quais sejam: a entrada – qualificação docente (NPD e NPM), regime docente (NR), infraestrutura (NI) e organização didático-pedagógica (NO) do curso –; e a saída – desempenho discente aferido em dois momentos (NIng e NConc) e diferença de desempenho agregada (NIDD).

Note-se que o conceito exposto nessa equação, que é utilizada de forma geral por todas as áreas avaliadas pelo Enade, em todo o território nacional, traduz uma relação única estabelecida entre a entrada e a saída. O CPC parte da afirmação de que é possível aferir a qualidade de um curso por meio dessas variáveis, pois elas constituem variáveis mensuráveis do processo de formação do estudante, de tal forma que outras variáveis não produzem modificação suficiente do produto (o desempenho) para que mascarem o efeito das primeiras. E mais, esse processo de entrada e saída tem similaridade nas áreas avaliadas, independentemente, ou pelo menos com pouca influência, de fatores como o contexto regional em que a IES está inserida, sua forma de organização e sua relação com a geração dos recursos necessários para sua existência. Tais premissas são o objeto de estudo da caracterização realizada a seguir.

Metodologia de estudo

A metodologia utilizada se apoiou na ideia de que a avaliação da qualidade de ensino de uma instituição deve se pautar na articulação entre os pressupostos epistemológicos que a fundamentam, o exame de indicadores que expressam essa qualidade e as inter-relações subjetivas que a caracterizam. Considera-se necessária a utilização de medidas, desde que estas não sejam o final do processo avaliativo, pois, como aponta Dias Sobrinho (2000, p. 95), “não basta, portanto, apenas conhecer a estrutura aparente e enumerar os produtos de uma instituição”. É preciso que se faça uma avaliação qualitativa dos resultados provindos dos indicadores quantitativos, para poder conhecer a complexidade de relações pelas quais tais indicadores somente revelam recortes, ou “pontas de icebergs”, da verdadeira estrutura institucional.

O universo da pesquisa foi determinado com base nos resultados publicados pelo Inep referentes ao Enade para as IES brasileiras, constantes das planilhas de conceito preliminar de curso, denominadas CPC decomposto.13 O universo foi delimitado pelo triênio 2008-2010, com o intuito de possibilitar a análise de todas as áreas submetidas ao exame, tendo em vista a natureza trienal do Enade. A escolha de 2010 como o ano final deveu-se à modificação do cálculo do IDD a partir de 2011, quando o desempenho dos estudantes ingressantes no Exame Nacional do Ensino Médio (Enem), e não no Enade, foi utilizado para a construção do índice. Assim, o mesmo modelo de cálculo foi mantido para o ciclo trienal. Procurou-se utilizar a mesma notação das Notas Técnicas publicadas pelo Inep.14 As variáveis coletadas na planilha foram os insumos:

Nota de Professores Doutores (ND);

Nota de Professores com Regime de Dedicação Integral ou Parcial (NR),

Nota referente à Infraestrutura (NI);

Nota referente à Organização Didático-Pedagógica (NO);

e o índice de desempenho:

Como ocorreram modificações nas denominações das variáveis nos três anos de estudo, estas foram padronizadas. Como exemplo, em 2008, as IES eram classificadas, segundo sua categoria administrativa, em federais, estaduais, municipais e privadas. A partir de 2009, a classificação foi reduzida para apenas públicas e privadas. Em razão disso, os dados de 2008 foram recategorizados, de forma que apareceram em 2009 e 2010 distribuídos em instituições públicas e privadas. Esse procedimento de padronização foi adotado sempre que necessário. Um segundo passo foi a retirada de registros de acordo com os seguintes critérios de exclusão:

registros que não contivessem valores para todas as variáveis de estudo. Assim, foram eliminados registros sem CPC, registros que constassem como “sem conceito” e os que tivessem insumos com valores em branco. Alguns registros apresentavam CPC, mas continham um campo em branco em algum insumo. Tais registros também foram eliminados;

registros com nota zero nas variáveis NI e NO. Conforme o cálculo demonstrado na Nota Técnica, considera-se nota zero caso nenhum estudante tenha respondido ao questionário socioeconômico.15 Assim, a nota zero nessas variáveis pode corresponder a duas categorias de resposta: alunos que não responderam e alunos que efetivamente atribuíram valor correspondente a zero na pergunta do questionário. Por isso, optou-se pela eliminação dos registros que contivessem esse dado ambíguo.

No exame das variáveis, não foram observadas as subáreas e, por isso, os resultados apresentados referem-se somente às áreas. Por exemplo, a área de Comunicação Social foi tratada como uma só, e não foram consideradas suas subáreas, tais como Jornalismo, Publicidade e Propaganda, etc.

Das 71 áreas constantes dos três anos avaliados, optou-se por desconsiderar aquelas em que o número de cursos avaliados em todo o Brasil fosse igual ou inferior a 3016 (DEVORE, 2012, p. 210). Com o critério de exclusão, foram mantidas 55 das 71 áreas para a análise de dados.

No modelo de análise, as variáveis insumos – ND, NM, NR, NI e NO – foram consideradas variáveis independentes, e NEnade, variável dependente. Previamente à escolha do método analítico, procedeu-se à averiguação da normalidade17 da distribuição das variáveis dependentes, para cada uma das 55 áreas avaliadas. A relação entre os insumos (variáveis independentes) e o desempenho (variáveis dependentes) foi examinada por meio de regressão linear múltipla (HAIR, 2005, p. 131). Essa técnica tem como fundamento o exame de correlações lineares entre os dois tipos de variáveis. A correlação é positiva quando a variação da variável independente tem o mesmo sentido da variação da variável dependente. Por exemplo, à medida que o percentual de doutores aumenta, aumenta o desempenho dos estudantes. A correlação é negativa quando os sentidos das variações são distintos, como se nota no seguinte exemplo: à medida que o percentual de mestres aumenta, diminui o desempenho dos estudantes.

O exame dessas correlações verifica sua significância, ou seja, a probabilidade de que a relação encontrada tenha sido obtida ao acaso. Para a análise, foi adotado o nível de significância de 5%. Probabilidades menores que o nível de significância indicam relação significativa. O modelo é considerado múltiplo dado que possui mais de uma variável independente, no caso os insumos. O exame da significância das correlações permite inferir quais das variáveis independentes estão mais relacionadas com a variável dependente e, por isso, exercem maior influência sobre esta.

Além disso, a técnica permite o exame de multicolinearidades, ou seja, correlações significativas entre variáveis independentes. Tal fato pode caracterizar confusão na análise dos dados: caso uma variável independente esteja correlacionada com outra, não se saberá a qual delas se deve o efeito sobre a variável dependente. A técnica de regressão examina essas colinearidades e retira a variação devida a essa relação entre variáveis independentes. Dessa forma, é possível examinar o efeito isolado de cada variável independente sobre a dependente, o que é chamado de efeito único. No exame das correlações, esse efeito único pode ser demonstrado por meio da correlação semiparcial, ou seja, aquela correlação dada somente pela relação exclusiva de um insumo com o desempenho avaliado.

A elaboração dos modelos regressivos foi precedida pela observação de diferenças entre os tipos de IES avaliadas, de acordo com a combinação entre a organização acadêmica (universidade, centro universitário ou faculdade) e a categoria administrativa (pública ou privada), assim codificadas:

UniPu – Universidade Pública;

UniPr – Universidade Privada;

CeUPr – Centro Universitário Privado;

FacPr – Faculdade Privada.

As correlações semiparciais significativas entre insumos e desempenho foram retidas para cada área e tipo de IES. Com base na frequência obtida, foram elaborados mapas de associação entre as áreas, insumos e tipos de IES, aplicando-se a técnica multivariada de análise de correspondência simples (HAIR, 2005, p. 441). Desse modo, foi possível observar os agrupamentos das áreas com relação aos insumos e aos tipos de IES. O aplicativo utilizado para a análise e descrição dos resultados foi o STATISTICA, versão 10 (STATSOFT, 2011).

Caracterização das relações entre insumos e desempenho

Uma análise geral dos resultados obtidos das análises descritas no item anterior identificou os insumos com maior frequência de relações significativas. O insumo que apresentou maior frequência de correlações semiparciais entre as áreas foi a nota da infraestrutura (NI) – 28 das 55 áreas avaliadas tiveram pelo menos uma correlação significativa em algum estrato –, seguida pela nota dos doutores (ND) – 26 áreas –, nota da organização didático-pedagógica (NO) – 23 áreas –, nota do regime de trabalho (NR) – 22 áreas – e nota de mestres (NM) – 20 áreas. O resultado foi considerado coerente com o esperado, tendo em vista a colinearidade entre os insumos. As notas de mestres, doutores e regime de trabalho apresentam tendência de correlação positiva entre si, uma vez que as IES com maior percentual de mestres e doutores são aquelas com os maiores percentuais de docentes em regime parcial e integral. Também são esperadas correlações positivas entre NI e NO, pois ambas provêm do questionário socioeconômico do Enade.

Onze áreas não apresentaram correlações significativas entre os insumos e o desempenho: Agronomia, Arquitetura, Fisioterapia, Teatro, Tecnologia em Automação Industrial, Tecnologia em Gestão de Processos Gerenciais, Tecnologia em Gestão Financeira, Tecnologia em Marketing, Tecnologia em Moda, Tecnologia em Redes e Zootecnia. Algumas dessas áreas (Automação Industrial, Moda e Teatro) têm um baixo número de cursos no Brasil, o que pode ter diminuído a probabilidade de se detectarem possíveis correlações. Nove áreas mostraram correlações significativas entre os insumos e o desempenho, independentemente do tipo de IES: Ciências Econômicas, Ciências Sociais, Engenharia VIII, Filosofia, Física, Geografia, Música, Secretariado Executivo e Tecnologia em Gestão de Recursos Humanos. As demais 35 áreas se mostraram dependentes do tipo de IES.

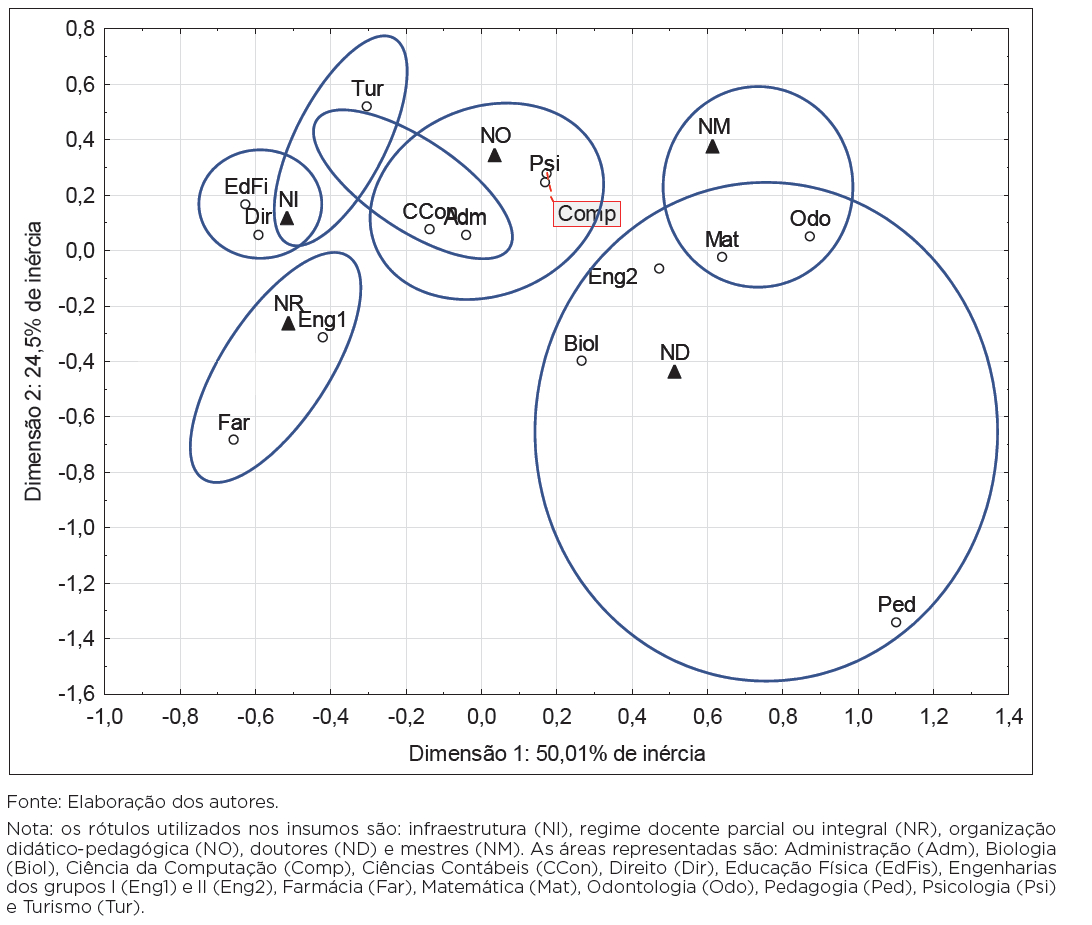

O Gráfico 1, a seguir, sumariza as associações encontradas entre as áreas e os insumos, considerando-se a frequência de ocorrência de correlações semiparciais significativas para as 14 áreas com frequência igual ou maior que cinco. O mapa mostrou mais de 70% de inércia, ou seja, as associações exibidas nas duas dimensões do mapa explicam pelo menos 70% da variabilidade observada, o que pode ser considerado um modelo adequado para demonstrar os resultados obtidos. Observam-se os seguintes grupos:

a nota da infraestrutura (NI) e as áreas de Educação Física e Direito;

a nota do regime de trabalho (NR) e as áreas de Engenharia do Grupo I e Farmácia;

a nota da organização didático-pedagógica (NO) em Ciências Contábeis, Psicologia, Administração e Computação;

a nota de doutores (ND) em Biologia, Engenharia do Grupo II, Matemática, Odontologia e Pedagogia – esta última distante no mapa por ter apresentado correlação somente com esse insumo.

As áreas de Matemática e Odontologia também apresentaram relações com a nota de mestres (NM), e a área de Turismo mostrou relações com igual frequência para a infraestrutura (NI) e a organização didático-pedagógica (NO).

O estudo de Fernandes et al. (2009), realizado para o triênio 2005-2007, já apontava para relações com significâncias distintas entre os insumos, com o percentual de doutores se destacando como aquele com maior frequência nas áreas, e a infraestrutura com importância maior que o regime de trabalho e a organização didático-pedagógica.

Os resultados indicam que os insumos se relacionaram a essas áreas de forma distinta, algumas delas mostrando relação significativa somente para um insumo, como foi o caso da área de Pedagogia

Gráfico 1 – Mapa de correspondência referente a 14 áreas avaliadas no Enade e aos insumos de qualidade considerados pelo CPC

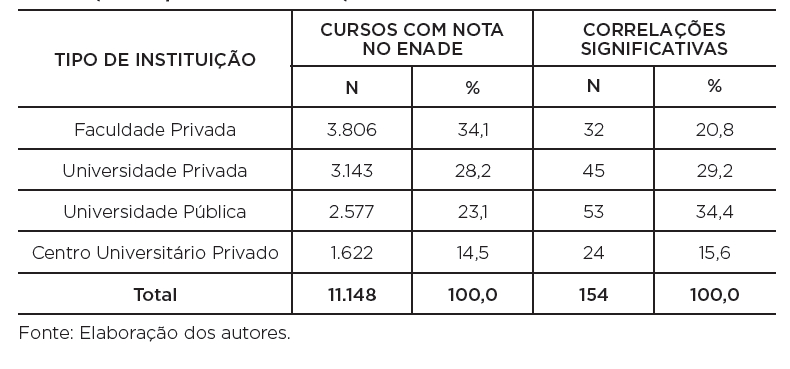

A Tabela 1 sumariza os totais de cursos de acordo com os tipos de IES, ordenados de modo decrescente conforme o percentual de cursos em cada estrato. Os primeiros três estratos detiveram mais de 80% dos cursos avaliados no triênio. Também é possível observar o número absoluto e o percentual de correlações semiparciais significativas para cada estrato. Nota-se que a frequência de correlações para as Faculdades Privadas foi menor que aquela para as universidades e, entre estas, as Universidades Públicas apresentaram maior frequência do que as Privadas.18 Isso demonstra que a relação entre insumos e desempenho tem mais propriedade para as Universidades Públicas do que para as Faculdades Privadas. Conclui-se que a estrutura de relações criada para o Enade contínuo tem maior coerência para o grupo das Universidades do que para as Faculdades e, dentro das Universidades, mais para as Públicas do que para as Privadas.

TABELA 1: Frequências absoluta e relativa de cursos com nota no Enade e de correlações significativas entre os insumos e as 55 áreas avaliadas do Enade no triênio 2008-2010, de acordo com o tipo de instituição superior de educação

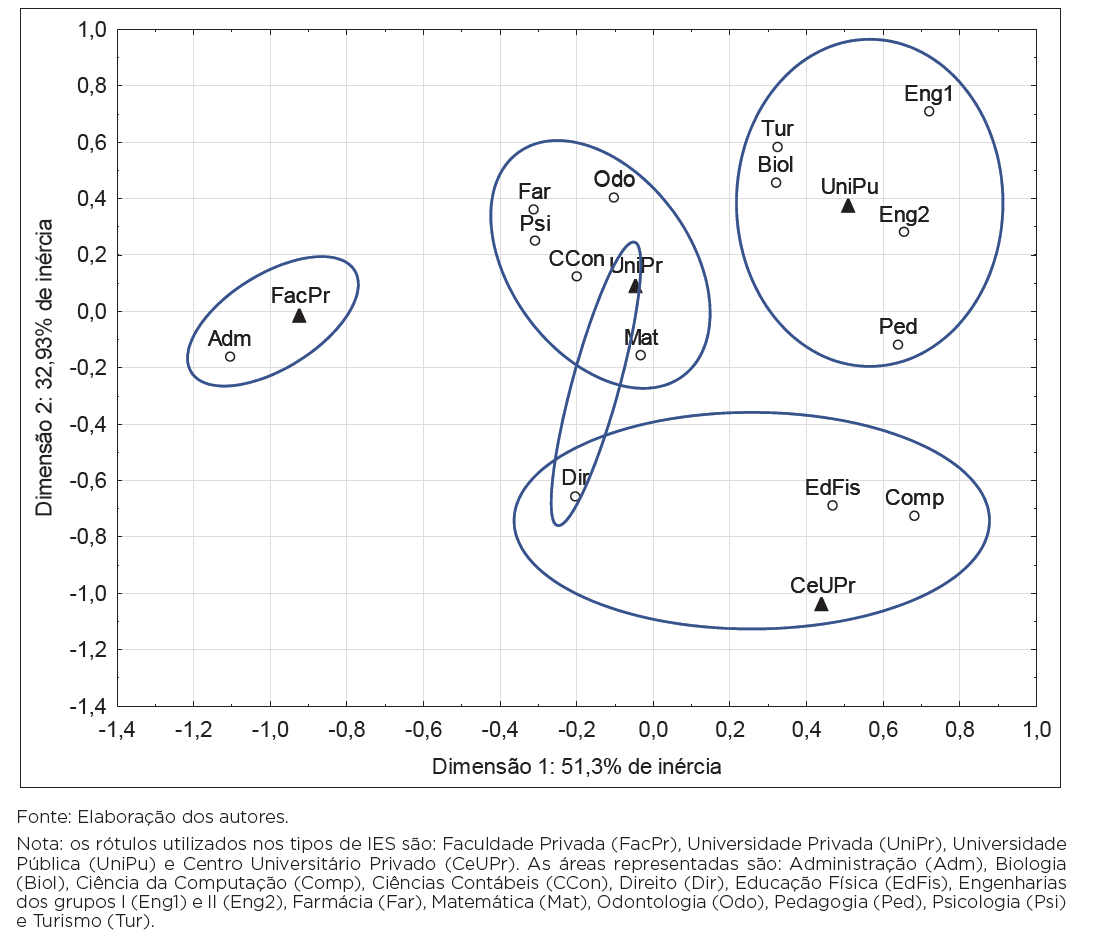

O Gráfico 2 apresenta as associações encontradas entre as áreas e os tipos de IES, considerando-se a frequência de ocorrência de correlações semiparciais significativas. A inércia esteve presente em mais de 80%,19 com um ajuste adequado para explicar os resultados obtidos para as IES. Observam-se os seguintes grupos:

Faculdades Privadas e a área de Administração;

Universidades Privadas e as áreas de Psicologia, Farmácia, Matemática, Odontologia e Ciências Contábeis;

Universidades Públicas e as áreas de Biologia, Engenharia do Grupo I, Engenharia do Grupo II, Turismo e Pedagogia.

Centros Universitários Privados e as áreas de Direito (com parte das correlações também nas Universidades Privadas), Ciência da Computação e Educação Física.

O mapa demonstra a distinção do grupo das Universidades frente aos demais tipos de instituições, com frequência maior de correlações em mais áreas do Enade. Esse resultado revela uma propriedade maior do CPC para esse tipo de instituição do que para os demais.

Gráfico 2 – Mapa de correspondência referente a 14 áreas avaliadas no Enade e aos tipos de instituição de ensino superior

A caracterização demonstrou a existência de relações lineares entre os insumos e o desempenho, estas ocorrendo na maior parte das áreas avaliadas no triênio do Enade. No entanto, essas relações não foram distribuídas equitativamente em relação aos insumos em todas as áreas e tampouco foram homogêneas no universo das instituições de ensino superior.

Considerações finais

As conclusões que podem ser obtidas a partir da caraterização das relações entre insumos e desempenho no Enade são:

a estrutura das relações entre os insumos e o desempenho dos estudantes no Enade, caracterizada pela nota contínua do Enade, depende da área avaliada e da combinação entre a organização acadêmica e a categoria administrativa da IES;

o exame das relações permitiu a identificação de grupos de áreas de cursos nos quais um ou outro insumo obteve correlações mais frequentes com o desempenho;

no desempenho medido pelo Enade contínuo, 11 das 55 áreas avaliadas não apresentaram relações significativas entre os insumos e o desempenho;

em nove áreas, as relações se mostraram independentes da combinação entre organização acadêmica e categoria administrativa;

a nota da infraestrutura e a nota de doutores foram os insumos com correlações semiparciais mais frequentes com o Enade contínuo;

o estrato da combinação entre organização acadêmica e categoria administrativa mostrou maior frequência de correlações para as Universidades; a categoria administrativa “Pública” com maior frequência do que a categoria “Privada”.

Além disso, considerando-se os dois pressupostos pelos quais é calculado o CPC:

o desempenho dos estudantes tem relação direta (e linear) com a titulação e o regime de trabalho do corpo docente e com a percepção dos alunos quanto à presença de equipamentos para aulas práticas (infraestrutura) e completude dos planos de ensino (organização didático-pedagógica);

essa relação é homogênea para o universo da educação superior brasileira, independentemente da área do curso e de sua organização acadêmica ou categoria administrativa.

As conclusões obtidas evidenciaram que o Pressuposto 1 é atendido na maioria das 55 áreas estudadas, mas em 11 delas não foi observada significância para o Enade contínuo. Em relação aos insumos, a nota de doutores e a nota da infraestrutura se destacaram como os mais frequentes, enquanto a nota de mestres foi o insumo menos ocorrente. Essa frequência foi fortemente vinculada à área, contrariamente ao Pressuposto 2. Também foram observadas diferenças entre as regiões federativas, organizações acadêmicas e categorias administrativas. Os resultados apontam que a estrutura de relações subjacente à construção do CPC tem mais propriedade para as Universidades, isso para algumas áreas avaliadas e não para todo o conjunto de áreas.

Considera-se que o CPC não pode ser utilizado como único indicador de qualidade dos cursos de graduação, mesmo que seja para efeitos de regulação. Os resultados mostraram um panorama complexo que precisa ser examinado em detalhe, de forma que o indicador CPC possa ser avaliado qualitativamente dentro do contexto em que foi produzido. Isso significa introduzir na avaliação do CPC as demais variáveis – e especificamente aquelas relacionadas ao contexto da IES (como sua categoria administrativa ou organização acadêmica, aqui investigadas, além de outras que não foram objeto deste estudo) –, de forma a alcançar o que originalmente foi considerado um princípio do novo sistema: “respeito à identidade e à diversidade institucional em um sistema diversificado” (BRASIL, 2004b, p. 89).

Fato é que o exame, ao definir conceitos de curso e média destes para a IES – utilizando-se para isso de um algoritmo que parte da premissa de que a relação entre insumos de qualidade e desempenho existe para todas as áreas de conhecimento dos cursos e pode ser generalizada para todas as IES –, faz com que o sistema seja refém do desempenho, tornando inócuo qualquer resultado advindo dos processos de autoavaliação. Como já afirmado por Lacerda (2015a, p. 100), “centralizar o processo avaliativo na construção de índices é interromper o processo de avaliação em seu início”.

Urge rediscutir os indicadores de qualidade de forma profunda e coerente para que se possam retomar efetivamente aspectos como “a responsabilidade social com a qualidade do ensino superior, a globalidade e a continuidade do processo avaliativo” (BRASIL, 2004b, p. 91).