INTRODUÇÃO

Este trabalho foi desenvolvido no âmbito do Laboratório de Pesquisa em Oportunidades Educacionais (LaPOpE), que investiga os efeitos das políticas de avaliação em larga escala e responsabilização nos sistemas de ensino e suas escolas. Buscamos compreender como professores, gestores escolares e gestores intermediários das redes de ensino apropriam-se dos dados produzidos pelas avaliações e os usam no planejamento educacional. Temos observado que, embora haja resistência e desconhecimento por parte dos profissionais, as percepções positivas vêm se destacando, bem como o esforço por maior compreensão da organização dos sistemas avaliativos.

Entendemos que as avaliações em larga escala não somente contribuem para o monitoramento da qualidade educacional, como fornecem uma ampla gama de informações com potencial para orientar a gestão e as práticas pedagógicas, podendo, nesse sentido, contribuir para a melhoria da aprendizagem dos alunos. Entretanto, essa função pedagógica das avaliações não parece ser bem compreendida e praticada no Brasil e em outros países, tendo em vista alguns aspectos levantados pela literatura da área. Abordaremos pesquisas que vêm mostrando a falta de divulgação e circulação de informações nas redes de ensino (DALY, 2012; SILVA et al., 2013), pouco retorno dos resultados para as escolas (SUPOVITZ, 2012), assim como pouca orientação sobre como utilizá-las no planejamento escolar (BROOKE; CUNHA, 2011; SILVA et al., 2013).

Apesar dos problemas mapeados, a demanda pelo uso de dados cresceu no Brasil e no mundo (LAWN, 2013; SOUZA, 2007). Em função disso, há iniciativas políticas no contexto internacional (MANDINACH; GUMMER, 2013; MARSH, 2012) e também nacional (BROOKE; CUNHA, 2011) que visam a capacitar os profissionais das escolas para o uso dos resultados em favor da melhora do processo de ensino.1 As análises que apresentaremos a seguir sugerem que o desempenho dos alunos tende a melhorar nas escolas nas quais há intervenções para induzir e orientar o uso de dados.

Contudo, as políticas de formação para uso de dados no Brasil ainda são incipientes (BENGIO, 2016). Por isso, nossa hipótese é que os gestores brasileiros conhecem parcialmente os objetivos das avaliações e indicadores educacionais. Esse desconhecimento, associado a outros fatores organizacionais das redes de ensino, tais como modelo de responsabilização, infraestrutura e articulação da rede, acabaria por promover percepções negativas e resistência ao uso dos dados ou mesmo usos superficiais para o aumento artificial dos índices e ganho de prêmios (CERDEIRA, 2015; DIAMOND; SPILLANE, 2004; JENNINGS, 2012).

Partindo dessa hipótese, este artigo tem dois objetivos. O primeiro é analisar os resultados de um curso de formação sobre “o uso de indicadores educacionais”, mapeando os efeitos do conteúdo oferecido nas percepções de gestores escolares. O curso foi oferecido no LaPOpE, ao qual nos filiamos, e é direcionado especificamente para diretores e coordenadores pedagógicos de escolas da rede municipal do Rio de Janeiro. O segundo objetivo é analisar um web survey aplicado a uma amostra de gestores escolares da mesma rede de ensino, a fim de identificar a relação entre o nível de conhecimento e as percepções sobre as avaliações em larga escala, bem como possíveis usos dos indicadores educacionais.2

Neste artigo, procuraremos demonstrar que a ampliação do conhecimento sobre os sistemas de avaliação em larga escala tende a reduzir as resistências e permitir que os gestores incorporem os dados como orientadores de suas ações práticas nas escolas.

USO DE DADOS DAS AVALIAÇÕES EM LARGA ESCALA

As avaliações em larga escala fornecem informações e indicadores cada vez mais utilizados na gestão de sistemas educacionais e também dos estabelecimentos de ensino. De acordo com Lawn (2013), Moreira Neto (2008) e Souza (2007), ainda há dificuldade em interpretar dados das avaliações, sobretudo os estatísticos, mas vem ocorrendo um esforço gradativo de análise, tanto no campo pedagógico quanto na gestão escolar. De maneira geral, os sistemas de avaliação atuais permitem comparar e diagnosticar a situação educacional dos contextos em que são aplicados, a partir de informações detalhadas sobre o desempenho das escolas e, em alguns casos, dos alunos. Nesse cenário, a cobrança por melhorias aumenta, sobretudo se considerarmos outra tendência atual, de associar sistemas de avaliação às políticas de responsabilização.

As tendências mencionadas também são observadas nos sistemas brasileiros de avaliação. Há uma linha de argumentação que defende que a gestão educacional pode utilizar indicadores disponíveis para o planejamento e trabalho pedagógico (SOARES, 2002; SOUZA, 2007). Entretanto, parte dos profissionais da educação apresenta resistências ideológicas e desconhecimento técnico dos objetivos, metas e construção de índices (CERDEIRA; ALMEIDA; COSTA, 2014; ROSISTOLATO; PRADO, 2013). Outra questão a ser considerada é a frequência com que as informações circulam entre esses profissionais e se estas permitem a interpretação adequada, visto que isso pode afetar suas formas de uso.

Alguns países, como Inglaterra e Suécia, por exemplo, enfrentaram resistências pautadas no argumento de que as avaliações em larga escala reproduziam desigualdades e reduziam a autonomia docente. Entretanto, com a introdução da gestão baseada no uso de dados, a resistência parece ter diminuído. Para Landahl e Lundahl (2013), essa mudança de perspectiva se desenvolveu devido à melhora dos resultados educacionais. Movimento semelhante também ocorreu nos Estados Unidos, visto que as avaliações e, sobretudo, as políticas de responsabilização de alto impacto provocaram resistências. Além dos argumentos semelhantes aos já citados, destaca-se a crítica ao estreitamento curricular, tanto nesses países, como no Brasil, provocado pelos testes de múltipla escolha, planejamento em função das datas dos testes, limitação da avaliação interna e treino dos alunos (ARCAS, 2009; BONAMINO; SOUSA, 2012; SILVA et al., 2013; SUPOVITZ, 2012).

Há pelo menos uma década, os Estados Unidos vêm tentando implementar políticas de uso de dados (data use) por meio de capacitações (data literacy). É uma tentativa de informar gestores e professores sobre as possibilidades trazidas pela interpretação, o uso e a tomada de decisões com base em dados sistematicamente produzidos. Essas políticas têm como objetivo melhorar a aprendizagem dos alunos e reduzir desigualdades educacionais.

Um dos fatores que elevou o interesse pela promoção do uso de dados foi o acesso e circulação de informações. Supovitz (2012) afirma que, muitas vezes, os dados não são disponibilizados ou o são de forma limitada. Assim, para elevar o potencial de uso entre os professores e gestores, é recomendável investir na divulgação de informações estatísticas mais “legíveis”. A ausência de informação sobre as políticas de avaliação, a formulação dos testes, o cálculo de metas e índices e critérios de premiação/punição, dentre outros, provavelmente contribuem para a resistência, desconhecimento ou desinteresse pelos dados e seus possíveis usos, tanto no âmbito da escola quanto da rede de ensino em que ela está inserida. Nesse contexto, Daly (2012) destaca a questão da liderança dos gestores (escolares e das redes) como característica fundamental para a divulgação de informações e estímulo ao debate e uso dessas. Seus resultados apontam, ainda, que um bom sistema de articulação entre as escolas e os gestores da rede de ensino não só favorece a circulação de informações, como uma cultura de uso de dados para tomada de decisão, o que tende a melhorar os resultados dos alunos.

Além do desconhecimento, há outros fatores que parecem influenciar no uso dos dados, tais como políticas de avaliação contraditórias, erros e imprecisões nas provas externas, nas estimativas de desempenho e, consequentemente, nos critérios de premiação e/ou punição das escolas. A pesquisa de Morais (2012), por exemplo, evidencia imprecisões nos resultados da Provinha Brasil, tendo em vista que algumas edições apresentaram níveis de dificuldades diferentes, quando deveriam ser semelhantes.

Para Koretz e Jennings (2010), mecanismos de responsabilização têm promovido distorções nos usos, principalmente das políticas de alto impacto, pois tendem a gerar ambientes de trabalho com maior clima de cobrança por resultados. Esse fenômeno também ocorre no Brasil, conforme sinalizam Silva et al. (2013). Para Amaro (2013), os profissionais das escolas vêm sentindo-se mais pressionados, principalmente os professores que lecionam nos anos avaliados. Diamond e Spillane (2004) e Stillman (2011) concordam que pressões intensas podem levar a práticas de fraude, manipulação de dados e treino, denominadas pela literatura como gaming. Os autores indicam que, sob essa pressão intensa, os profissionais tomariam atitudes imediatas, dispostos a elevar rapidamente a pontuação nos testes. Esse tipo de uso de dados pode melhorar o desempenho dos alunos nas provas, mas não contribui para a aprendizagem efetiva e redução de desigualdades educacionais. No entanto, Stillman (2011) defende que uma pressão moderada pode favorecer usos pedagógicos dos dados, na medida em que gera uma tensão produtiva nas escolas. Tais usos se traduzem, por exemplo, no investimento nos alunos e turmas com mais dificuldades e em estratégias para reduzir reprovação e abandono escolar. Contudo, Amaro (2013) alerta que a pressão promovida pelas políticas de responsabilização não é suficiente para promover a divulgação de informações e seus usos pelas escolas. Tais evidências podem justificar a importância de capacitar os profissionais para o uso.

Restam, ainda, restrições e críticas a alguns usos das avaliações em larga escala, com base em aspectos técnicos que essas incorporam e, sobretudo, quanto a políticas que nelas se apoiam. Assim, Gorard (2010) critica a instabilidade de medidas, como as de eficácia docente, ou a adoção de modelagem multinível para estimação de efeito-escola, não por uma recusa de princípio, mas por limitações dos recursos de mensuração presentes nos testes em grande escala e na própria modelagem de análise. Políticas de responsabilização baseadas nessas medidas e modelos tenderiam, segundo tal perspectiva, a conter erros consideráveis, dependendo do tratamento estatístico adotado, gerando decisões não razoáveis quanto a premiações e punições de atores escolares. Em direção semelhante, Berliner (2014) e Holloway-Libel e Amrein-Beardsley (2015) promovem revisões sistemáticas nos Estados Unidos em que afirmam haver pouca sustentação empírica para os modelos de valor agregado, usualmente adotados nas políticas de responsabilização, como geradores de informações sobre eficácia escolar e seus fatores.

Podemos observar que há uma série de fatores contextuais que podem influenciar nas formas de uso dos dados e nas tomadas de decisão pelos profissionais da educação. As pesquisas realizadas no Brasil trazem indícios semelhantes de como ocorre esse uso nas escolas do país. Arcas (2009), Brooke e Cunha (2011), Cerdeira (2015) e Silva et al. (2013) pesquisaram diferentes redes de ensino, encontrando evidências de treinamento para os testes, estreitamento do currículo, falta de divulgação e circulação de informações, imprecisões nos testes e nos critérios de premiação. Em alguns casos, notou-se que profissionais de instâncias de gestão das redes de ensino também se sentiam inseguros para analisar e interpretar os dados, não sendo claros em suas orientações às escolas. Já Souza e Oliveira (2010) observaram que, mesmo quando há um esforço por compreensão e análise dos resultados das avaliações, isso pode ser feito de forma descontextualizada, levando a interpretações e práticas equivocadas.

Por fim, especificamente quanto às possibilidades de uso dos indicadores educacionais incorporados à vida escolar, no que diz respeito às avaliações em larga escala, tanto no Brasil como em outros países, há uma limitação importante na distância temporal entre a aplicação de testes e a disponibilidade de seus resultados. Em geral, quando tal ocorre, turmas já foram recompostas, professores realocados e outros elementos da organização escolar igualmente alterados, de tal forma que os resultados não mais dizem respeito à configuração escolar presente.

INICIATIVAS DE CAPACITAÇÃO PARA O USO DE DADOS

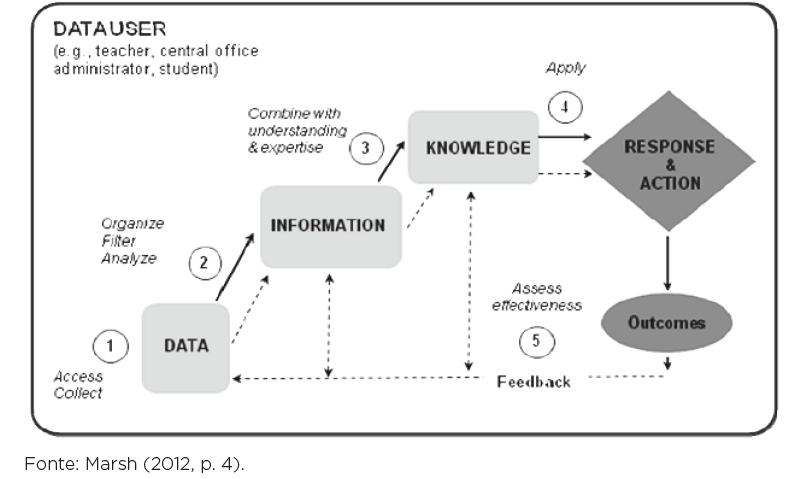

As iniciativas de capacitação de profi ssionais da educação para usos pedagógicos dos dados são denominadas, nos Estados Unidos, de data literacy. A ideia implícita é justamente difundir uma cultura de uso dos dados, promovendo um ciclo de análise contínua com vistas à melhoria dos sistemas educacionais. Marsh (2012) esquematizou um ciclo que chamou de “teoria da ação do uso dos dados”. A Figura 1 mostra que a coleta e o acesso aos dados, quando organizados e analisados, geram informações e conhecimento que, por sua vez, permitem ações e tomada de decisão que produzem resultados. Esses resultados retornam como dados para as escolas, recomeçando o ciclo de usos.

Analisando a dinâmica proposta pela capacitação ou “alfabetização” para o uso de dados, Cerdeira (2015) destaca que primeiro ocorre um processo de formação de especialistas técnicos enviados às escolas com função de apresentar ferramentas de acesso aos dados, promovendo reflexão sobre suas interpretações, e treinar os gestores escolares. De acordo com Mandinach e Gummer (2013), os gestores escolares têm sido o alvo prioritário dessas iniciativas, visto sua posição na hierarquia escolar e capacidade de estimular o corpo docente. Contudo, há investimentos na ampliação desse tipo de formação para professores. Trata-se, portanto, da formação de um conjunto de habilidades e conhecimentos sobre liderança, coleta, análise, divulgação e uso de dados no planejamento educacional, e espera-se que possa promover mudanças positivas nas práticas escolares.

As pesquisas ainda não são conclusivas quanto ao impacto do data literacy nas práticas pedagógicas, mas há indícios de uma associação positiva. Marsh (2012) e Supovitz (2012) mapearam alguns desses resultados, dentre eles o aumento da capacidade de resolver problemas, da compreensão das políticas de avaliação, da segurança no entendimento e uso dos dados, do compartilhamento de informações, da adequação de práticas pedagógicas e desenvolvimento de estratégias rápidas. Marsh (2012) indica que as redes que optaram por continuar subsidiando os profissionais de suas escolas, mesmo após a capacitação, obtiveram resultados mais efetivos, sobretudo nas instituições que incluíram alunos e pais na discussão a respeito de resultados de desempenho. As mudanças foram mais visíveis no âmbito escolar do que na estrutura organizacional das redes de ensino. As pesquisas mostram, ainda, que o desempenho dos alunos aumentou, tanto em leitura quanto em matemática, após as capacitações dos profissionais para o uso de dados, bem como reduziu as práticas de gaming em algumas escolas.

Entretanto, a autora defende que, embora tenha mapeado resultados positivos, não se pode afirmar que foram causados pelas capacitações, pois há pelo menos três aspectos que dificultam o monitoramento dos impactos na gestão escolar e na aprendizagem dos alunos. O primeiro refere-se à rotatividade dos profissionais escolares: alguns fizeram a capacitação quando estavam em uma determinada escola ou função e mudaram depois. Logo, ao tentar avaliar o impacto da escola, verifica-se que os profissionais que estavam lá na época da capacitação já saíram. O segundo sinaliza a falta de tempo dos gestores, que afirmam ter muitas demandas cotidianas, o que dificulta pôr em prática tudo o que aprenderam sobre uso de dados. O terceiro refere-se a pouca autonomia da gestão escolar e das próprias políticas educacionais. Por exemplo, alterações curriculares desejadas que não podem ser efetuadas.

De maneira geral, a rotatividade, o excesso de demandas e a falta de autonomia são aspectos que também aparecem na literatura brasileira sobre gestão escolar. O debate a respeito da importância de utilizar os resultados no planejamento e tomada de decisão também tem sido valorizado. Fernandes et al. (2010) indicam que os profissionais mais bem informados tendem a ser menos resistentes e mais dispostos a utilizar os resultados das avaliações no planejamento educacional e na aprendizagem dos alunos. Porém, ainda estamos iniciando a proposição de políticas educacionais que tenham formação para o uso de dados como um de seus objetivos. Rosistolato, Prado e Fernandez (2014) acreditam que a falta da informação e conhecimento estariam relacionados “à ausência de processos de formação articulados à implementação de políticas de avaliação em larga escala e divulgação de dados educacionais” (p. 85).

A investigação de Bauer et al. (2015) evidencia que os municípios brasileiros vêm formulando e realizando cursos de formação para os profissionais da educação, tendo por base os dados produzidos por avaliações externas. Tais cursos, no entanto, não são necessariamente para capacitá-los para o uso desses dados no cotidiano escolar. Ressaltam, ainda, certa ausência de normatização específica para tais iniciativas. Contudo, existem algumas iniciativas de formação para o uso e divulgação de resultados, mas ainda não são consideradas fundamentais no desenho de políticas brasileiras. Para Brooke e Cunha (2011), o Plano de Intervenção Pedagógica (PIP), da Secretaria da Educação do Estado de Minas Gerais (SEE-MG), é um dos poucos programas brasileiros que visa, de alguma forma, a capacitar os educadores para a apreensão de dados educacionais. Além de estimular os gestores a construir um PIP, pensando em estratégias de melhoria, esse programa visa a

[...] fazer com que as escolas com os piores resultados recebam visitas de uma equipe pedagógica competente para discutir e trabalhar pontualmente as lacunas observadas com os resultados da avaliação. (BROOKE; CUNHA, 2011, p. 32)

Alguns estudos, como o de Simões (2012), observaram que o desempenho dos alunos do ciclo de alfabetização melhorou após a implementação desse programa.

Os estudos como os de Cerdeira (2015) e Silva et al. (2013) também encontraram evidências de usos pedagógicos das avaliações em larga escala nas escolas brasileiras, ou seja, voltados para a aprendizagem, ainda que em menor proporção. Ao passo que a resistência inicial parece ter diminuído, cresce o interesse por aprender sobre as avaliações em larga escala e por monitorar internamente o progresso das turmas e alunos. Ao mesmo tempo, ainda é possível argumentar sobre a ausência de responsabilização interna das equipes escolares e de uma cultura avaliativa e de uso de dados no Brasil. Pesquisas sobre a recepção de políticas de avaliação e responsabilização descrevem relatos de profissionais das escolas que culpam somente as famílias pelos baixos desempenhos, ou ainda professores que culpam gestores e vice-versa. (ALMEIDA, 2013; CERDEIRA, 2013; CERDEIRA; ALMEIDA, 2013; ROSISTOLATO; PRADO, 2013; ROSISTOLATO; VIANA, 2013).

Outro aspecto também destacado pela literatura e já problematizado por Barroso (2005) e Mendonça (2001) diz respeito ao excesso de demandas burocráticas e administrativas dos gestores escolares, que acabam por relegar a segundo plano as responsabilidades propriamente pedagógicas, sem contar a falta ou rotatividade de pessoal. Portanto, ainda que as evidências apontem resultados positivos, a ampliação do uso de dados das avaliações em larga escala depende da resolução de problemas que estrapolam os limites da atuação dos sistemas de avaliação, especificamente relacionados à burocracia educacional e ao capital humano presente nas escolas.

O CURSO DE FORMAÇÃO PARA COMPREENSÃO E USO DOS INDICADORES EDUCACIONAIS

O curso de formação Compreensão e Uso de Indicadores Educacionais fazia parte do projeto Observatório Educação e Cidade.3 Tinha, como proposta central, oferecer aos gestores educacionais da rede municipal do Rio de Janeiro conhecimentos teóricos e técnicos sobre os sistemas de avaliação em larga escala, além de explorar os possíveis usos pedagógicos dessas avaliações e de seus indicadores de qualidade no cotidiano escolar.4

O curso foi realizado entre 2012 e 2014. Foram, ao todo, cinco turmas de gestores escolares, sendo uma a cada semestre, formando o total de 85 profissionais. Neste artigo, analisaremos a turma do segundo semestre de 2013, composta por 20 gestores, sendo 12 diretores, dois diretores adjuntos e seis coordenadores pedagógicos. Todas as participantes eram do sexo feminino.

Quanto à organização, o curso foi dividido da seguinte forma: (i) realização de grupos focais no primeiro dia de aula com os gestores, com o objetivo de mapear suas percepções sobre as avaliações em larga escala e seus conhecimentos teóricos e técnicos; (ii) três módulos de estudos; e (iii) avaliação do curso, com um questionário em que os alunos avaliavam os professores, as aulas e também realizavam a autoavaliação.

Os módulos de estudo tinham objetivos distintos. O primeiro módulo, “Introdução à sociologia e à antropologia da educação: do estranhamento do cotidiano da escola à noção de eficácia escolar”, tinha como objetivo problematizar as representações de senso comum sobre as escolas, os sistemas educacionais e os sujeitos que os integram. A ideia era construir um olhar relativizador sobre temas tornados naturais pelos gestores, como o nível socioeconômico, o comportamento da família, as características estruturais da escola e da carreira docente, que determinam a aprendizagem dos alunos. O segundo módulo, “Medindo, avaliando e discutindo qualidade das escolas”, buscava auxiliar os gestores na compreensão dos indicadores construídos com base nas avaliações em larga escala, especificamente a Prova Brasil. Problematizava os critérios de medição e quantificação dos fenômenos educacionais e discutia o desenho do Sistema de Avaliação da Educação Básica (Saeb), suas possibilidades e limites e os cálculos que geram os resultados dos indicadores das avaliações. O terceiro e último módulo, “Uso de indicadores educacionais para planejamento educacional e escolar”, pretendia explorar as possibilidades trazidas pelo uso de dados na identificação, planejamento e análise dos problemas educacionais, além de refletir sobre como os indicadores gerados pelas avaliações em larga escala podem se tornar instrumentos eficazes para a gestão do planejamento e possíveis tomadas de decisão.

No primeiro dia do curso, realizamos um grupo focal para mapear as percepções dos gestores sobre as avaliações em larga escala e seus conhecimentos teóricos e técnicos. Entre as 20 cursistas, sete mostraram-se inicialmente favoráveis às avaliações em larga escala; dez eram contrárias e três eram neutras. Portanto, metade da turma era contrária. Não havia, no entanto, uma negação absoluta dos sistemas de avaliação em larga escala, mesmo entre aquelas que eram contrárias. É importante entender os argumentos empregados pelas gestoras contrárias para que compreendamos suas perspectivas sobre os sistemas de avaliação e seus resultados.

Um primeiro argumento contrário está relacionado ao processo de estigmatização do corpo discente. As gestoras contrárias acreditavam que o perfil socioeconômico das famílias é o fator determinante para o desempenho dos alunos nas escolas e, por isso, atribuíam-lhe culpa. Elas indicam características das famílias que, em sua visão, influenciam nos resultados da escola. Ticiane,5 por exemplo, justifica o baixo Índice de Desenvolvimento da Educação Básica (Ideb) da sua escola, citando a presença de alunos filhos de famílias nordestinas. Segundo ela, são alunos que entram e saem da escola para retornarem ao Nordeste.

Ticiane: Minha escola é assim, uma escola de itinerantes, que têm um grande número de filhos de porteiros, que vêm lá do [e vão para o] Nordeste.

A gestora acredita que, por esse motivo, a evasão é alta e, consequentemente, seus indicadores de qualidade nas avaliações em larga escala tendem a ser baixos. Outra participante, Diva, faz associação direta entre o desempenho escolar dos alunos e o nível socioeconômico de suas famílias. Para ela, os alunos oriundos de famílias com maior nível socioeconômico tendem a ter melhor desempenho na escola, pois possuem pais mais presentes, o que os diferencia dos demais alunos.

Diva: Por mais que a escola possa ajudar, você sabe que os alunos que são da classe dominante são aqueles que vão se dar melhor na escola, são os mais inteligentes, os melhores, têm bagagem, que possuem a família presente e que vão se superar.

Diva e Ticiane apresentam visões estereotipadas sobre as famílias e os alunos. Ambas acreditam que seus alunos não irão aprender por serem oriundos de famílias populares, classificadas como pobres, tanto economicamente quanto sob aspectos socioculturais. Com base nessa leitura, avaliar não faria sentido porque não haveria nenhuma possibilidade de melhorar o desempenho dos estudantes. Em síntese: os destinos escolares estariam previamente definidos por conta da origem social dos alunos.

O segundo argumento contrário relaciona-se ao primeiro, visto que utiliza a ideia de que as avaliações são problemáticas porque não valorizam a “realidade da escola”. As gestoras acreditavam que esse tipo de avaliação não valorizava a “realidade” e a “identidade” das unidades escolares. Nesse sentido, consideram que os dados das avaliações não representam a qualidade de suas escolas, pois não são pensadas para uma escola em específico. Um dos diálogos registrados no grupo focal explicita essas percepções.

Ticiane: Não é levado em conta [questões específicas das escolas]. É fria [porque não considera as especificidades da escola], como faz na sua, faz na de todo mundo. Então é isso que a gente lá fica muito chateado.

Diva: Não pode ser igual, né?.

Ticiane: Não pode ser igual!

Diva: A escola perde a identidade quando você iguala a todas..

Marília: Você vai igualar uma coisa que não é igual, não pode ser igual e a gente estuda isso o tempo inteiro, né? Não é igual, então essas escolas têm suas particularidades, suas especificidades, e a gente não pode tratar elas da mesma forma […]..

Esse tipo de percepção não foi consensual entre os cursistas e observamos divergências sobre o sentido das avaliações. A coordenadora pedagógica Milena, por exemplo, argumenta que, mesmo que as avaliações sejam elaboradas por profissionais da educação, essas não conseguem pontuar a realidade de cada escola. Já a diretora Antonella argumenta que as avaliações são instrumentos importantes para a compreensão, de forma geral, da educação brasileira.

Milena: Por mais que tenha as pessoas que elaboram estas provas, né? São pessoas da área de educação, foram professores de sala de aula e tudo mais, mas eu acho que cada vivência é uma vivência, cada escola tem a sua própria realidade, então generalizar em torno de um índice com uma avaliação é uma questão muito dificil [...].

Antonella: Bem, eu gostaria de dizer que eu acho importante que haja uma avaliação, eu acho necessário que haja de alguma forma [...]. Mas eu acho importante ter uma avaliação que a gente realmente consiga observar como as escolas no geral estão indo.

As percepções mapeadas nesse primeiro momento mostram que os gestores apresentam argumentos e posições baseados na experiência prática do cotidiano escolar e no que eles classificam como “realidade” específica de cada escola. Há, porém, discordâncias entre eles, o que nos mostra certa tensão e a presença de divergências ao pensarem sobre as avaliações em larga escala. Os gestores de posicionamento favóravel argumentam que as avaliações são instrumentos importantes para a gestão. Já os gestores de posição contrária às avaliações acreditam que não são a melhor forma de compreender a realidade das escolas e sugerem que cada escola deve ter total automia para construir uma espécie de autoavaliação.

Ainda mapeamos outro tipo de negação das avaliações, associado exclusivamente ao desconhecimento sobre o desenho técnico dessas. Havia gestoras que desconheciam os processos de formulação dos indicadores. De certa forma, negavam as avaliações porque não entendiam a lógica interna dos sistemas e suas possibilidades.

Mediadora: Essas avaliações, elas produzem índices, vocês sabem o que significam? Como são calculados estes índices? Vocês fazem ideia?

Elionor: É... Alguns eu já vi. A ideia nós temos. Mas eu não sei não.

Amanda: Não, não sei.

Agnes: Não faço a menor ideia.

Talita: Confesso que eu não entendo [...].

Após a realização dos grupos focais, os gestores participaram das aulas e, ao final, responderam a um questionário em que avaliavam o curso. Esse questionário foi construído para que pudéssemos comparar as percepções iniciais das gestoras com suas visões ao término do curso. Foi possível perceber mudanças nos argumentos apresentados pelas gestoras, que até então se colocavam como contrárias a essas iniciativas..6 Das dez gestoras inicialmente contrárias, quatro não responderam ao questionário, duas mantiveram suas posições e quatro mudaram de perspectiva, tornando-se favoráveis às avaliações. As gestoras de posicionamento favorável mantiveram sua posição e, das três gestoras de posicionamento neutro, uma também se tornou favorável.

Quando analisamos as gestoras nos três momentos do curso – inicial, durante o desenvolvimento das aulas e ao final do curso –, percebemos a progressiva mudança de perspectiva. Essa mudança está relacionada ao conhecimento acumulado durante o curso, especificamente na ênfase sobre a necessidade de relativizar suas visões pessoais sobre os alunos, as famílias e as escolas e sobre o desenho técnico das avaliações.

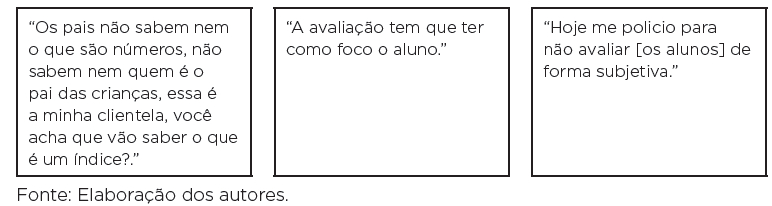

A coordenadora Marília demonstra esse processo. Na Figura 2 fizemos um recorte de três falas suas. No primeiro quadro, da esquerda para a direita, há uma fala realizada durante sua participação no grupo focal. A segunda fala foi realizada durante o segundo módulo do curso e o último quadro sintetiza o ponto de vista da gestora ao final do curso.

É possível observar a mudança de percepção e argumentos durante esses três momentos. No primeiro, observamos a estigmatização dos pais dos alunos por parte da gestora, devido a suas visões sobre o nível de escolaridade e o nível socioeconômico e cultural desses. No segundo momento, a gestora argumenta que o foco da avaliação deve ser o aluno, relativizando suas visões sobre a origem social e direcionando sua atenção para os estudantes. No último momento, observamos uma autocrítica da gestora, ao dizer que após o curso passou a controlar sua forma de avaliar os alunos.

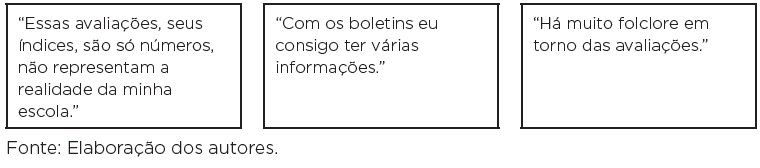

As falas de Milena também indicam sua mudança de perspectiva. De início, ela deslegitimava os “números” produzidos pelas avaliações porque acreditava que eles não permitiam nenhuma análise sobre a realidade de “sua” escola. A gestora ficou surpresa quando conheceu os boletins e entendeu que havia informações que poderiam ampliar sua visão sobre a escola e orientar o planejamento educacional. Ao final, ela aponta que há muito folclore em torno das avaliações. Nesse caso, o curso teria contribuído para desconstruir essas visões folclóricas (Figura 3).

Houve, portanto, mudança na perspectiva das gestoras sobre a estrutura, o desenvolvimento e a potencialidade das avaliações em larga escala e dos dados por elas produzidos. Esse cenário nos permite dizer que a divulgação de informações e esclarecimentos (CERDEIRA, 2015; DALY, 2012; FERNANDES et al., 2010; ROSISTOLATO; PRADO, 2013; SUPOVITZ, 2012), por meio de formação/capacitação para o uso de dados (MANDINACH; GUMMER, 2013; MARSH, 2012), tende a promover o questionamento de visões usuais sobre os sistemas de avaliação, o que confirma parcialmente nossa hipótese sobre a relação entre ampliação de conhecimento e redução de resistências, podendo expandir os usos dos dados educacionais.

Na sequência, apresentaremos os dados do web survey com foco específico na análise do conhecimento apresentado pelos gestores em comparação com suas posições sobre as avaliações externas.

DESCRIÇÃO E ANÁLISE DO WEB SURVEY

Os dados a seguir são provenientes de um web surveyitalic> realizado ao final de 2014 com dirigentes escolares da rede municipal de educação do Rio de Janeiro. Os questionários foram aplicados a uma amostra aleatória de diretores, vice-diretores e coordenadores pedagógicos. Ao final da aplicação, realizada ao longo de dois meses, obtivemos em torno de 170 questionários válidos, em sua grande maioria preenchida por diretores. Coordenadores pedagógicos e vice-diretores forneceram, aproximadamente, 40% das respostas, perfazendo, ainda assim, número suficiente para terem suas respostas analisadas.7

Neste artigo, dadas as limitações de espaço e objetivo, apresentaremos o conjunto de resultados sintéticos e descritivos decorrentes da aplicação da análise de fatorial, método dos componentes principais com rotação ortogonal, quando pertinente, buscando extrair e evidenciar dimensões latentes coerentes com nossas hipóteses de trabalho. Para tal, serão descritas e reduzidas fatorialmente variáveis ordinais. Na maioria dos itens, os respondentes eram solicitados a atribuir pontuação de 0 a 10 em escala ascendente de concordância/afinidade com as afirmativas apresentadas. Em alguns casos, as escalas eram de apenas quatro posições. Essas variáveis correspondem às tentativas de apreensão de opiniões/percepções dos atores investigados acerca de aspectos diversos de suas relações com o mundo das avaliações e dos dados educacionais que atravessa o contexto educacional nos anos recentes.

Não há presunção de que os resultados obtidos sejam efetivamente representativos do universo dos dirigentes escolares da cidade. Afinal, ainda que respeitada a aleatoriedade também nas substituições amostrais efetuadas, nem a determinação do n amostral teve intenção de obter representatividade estatística nem, sobretudo, podemos afastar a ameaça à validade por viés amostral. Afinal, com cerca de 50% apenas da amostra inicial realizada, as substituições sucessivas introduzem o risco claro de inclinações por afeição ao tema central da pesquisa, uma das mais clássicas ameaças à validade interna.

É importante salientar que, na análise exploratória por componentes principais sobre variáveis de opinião expressas em escalas tipo Likert, os coeficientes obtidos para as dimensões a que os conjuntos de variáveis foram reduzidos servem precipuamente para finalidades comparativas. Suas grandezas não medem uma característica palpável, imediatamente associável a uma medida de interpretação direta e universal. Lidamos com opiniões e preferências. Assim, os coeficientes são indicadores comparativos das inclinações das categorias em que os respondentes foram classificados. Tais coeficientes são medidos em desvios-padrão, variando entre negativos e positivos. Quanto mais próximos de 0, menor a afinidade com aquela dimensão latente identificada. Testes de diferença (análise de variância – ANOVA) não parecem relevantes de serem apresentados, dadas as características precipuamente descritivas do presente artigo.

O procedimento de apresentação dos resultados desse web survey será o seguinte: em primeiro lugar, serão expostas as principais dimensões emergentes das análises fatoriais,com a sumária explicação de como foram compostas. Em seguida, será feita a descrição de como se distribuem os coeficientes extraídos para cada uma dessas dimensões, conforme as três funções ocupadas pelos respondentes nas escolas (coordenação, direção e vice-direção). Por fim, haverá a análise de correlação entre tais dimensões, demonstrando a coerência conceitual que parecem guardar.

Quando da concepção do questionário aplicado aos gestores, consideramos as seguintes dimensões relevantes: (i) conhecimento declarado dos indicadores educacionais; (ii) preocupações a que estão afeitos nas escolas; (iii) percepções gerais das avaliações em larga escala; (iv) utilidades reconhecidas para as avaliações em larga escala; (v) usos legitimados para os indicadores escolares; e (vi) sentimentos associados às avaliações em larga escala.

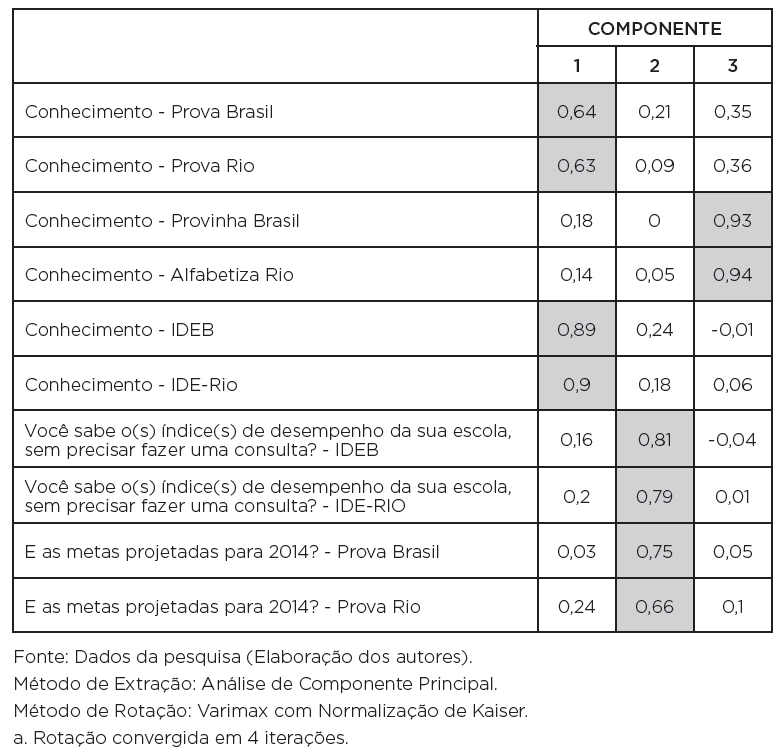

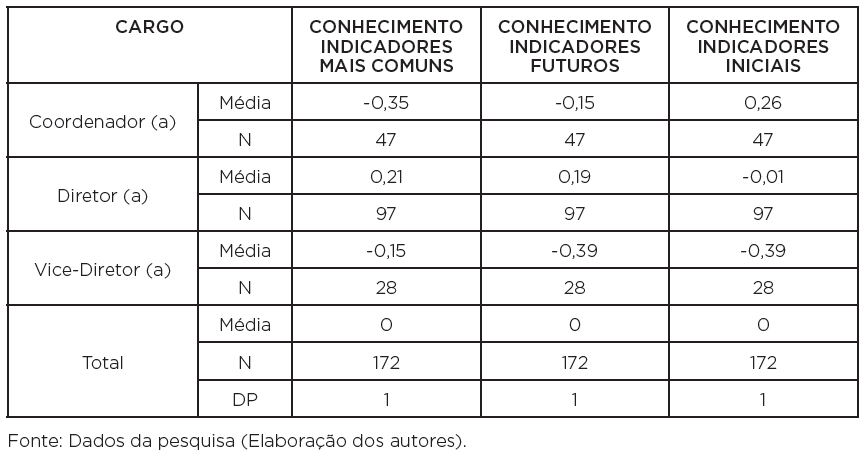

Na primeira dimensão – conhecimento declarado dos indicadores educacionais –, agrupamos um número pequeno de respostas relacionadas ao grau de conhecimento sobre as seguintes avaliações em larga escala: Prova Brasil, Prova Rio, Provinha Brasil e Alfabetiza Rio, assim como o Ideb. Um único fator, contemplando 65% da variância total, foi extraído e elevada a carga fatorial das cinco variáveis. Esse fator demonstra variações no conhecimento autodeclarado pelos respondentes. Em seguida, uma solução mais ampla foi experimentada, acrescendo, a essas cinco variáveis, as declarações de conhecimento dos pesquisados sobre o Índice de Desenvolvimento da Educação do Rio (IDE-Rio) e sobre se saberiam, sem fazer alguma consulta, quais seriam os valores atuais do Ideb e do IDE-Rio de suas escolas, bem como as metas projetadas para 2014 para a Prova Rio e a Prova Brasil. Com dez variáveis incluídas no modelo, o resultado, com aplicação de rotação ortogonal, originou três componentes com significado coerente, explicando 70% da variância total, conforme apresentado no Quadro 1.

Os três componentes extraídos respondem por, em ordem, 25, 24 e 21% da variância total explicada, na solução rotacionada. Os valores destacados para as cargas fatoriais elevadas demonstram grande afinidade entre variáveis que indicam, em sequência: na coluna 1, o conhecimento das avaliações e dos indicadores mais divulgados socialmente e na própria rede (Prova Rio, Prova Brasil, Ideb e IDE-Rio); na segunda coluna, as projeções e índices futuros; na terceira coluna, sintetiza duas avaliações diretamente ligadas ao processo de alfabetização (Provinha Brasil e Alfabetiza Rio).

As variáveis geradas por cada um desses fatores renderam uma clara impressão de coerência, quando extraídas suas médias segundo a função ocupada pelos respondentes, conforme apresentado no Quadro 2. Os coordenadores pedagógicos declaram estar mais atentos ou afins com as avaliações referentes ao processo de alfabetização, o que talvez expresse prioridades que lhes são atribuídas pela política educacional municipal. As direções declaram deter maior conhecimento dos demais indicadores, o que seria coerente com sua função mais abrangente de coordenação e representação institucional em geral. Já as vice-direções expõem uma percepção de maior desconhecimento ou afastamento desses aspectos, quando comparadas às outras funções.

QUADRO 2: Conhecimento de avaliações e indicadores educacionais: escores fatoriais médios, segundo a função

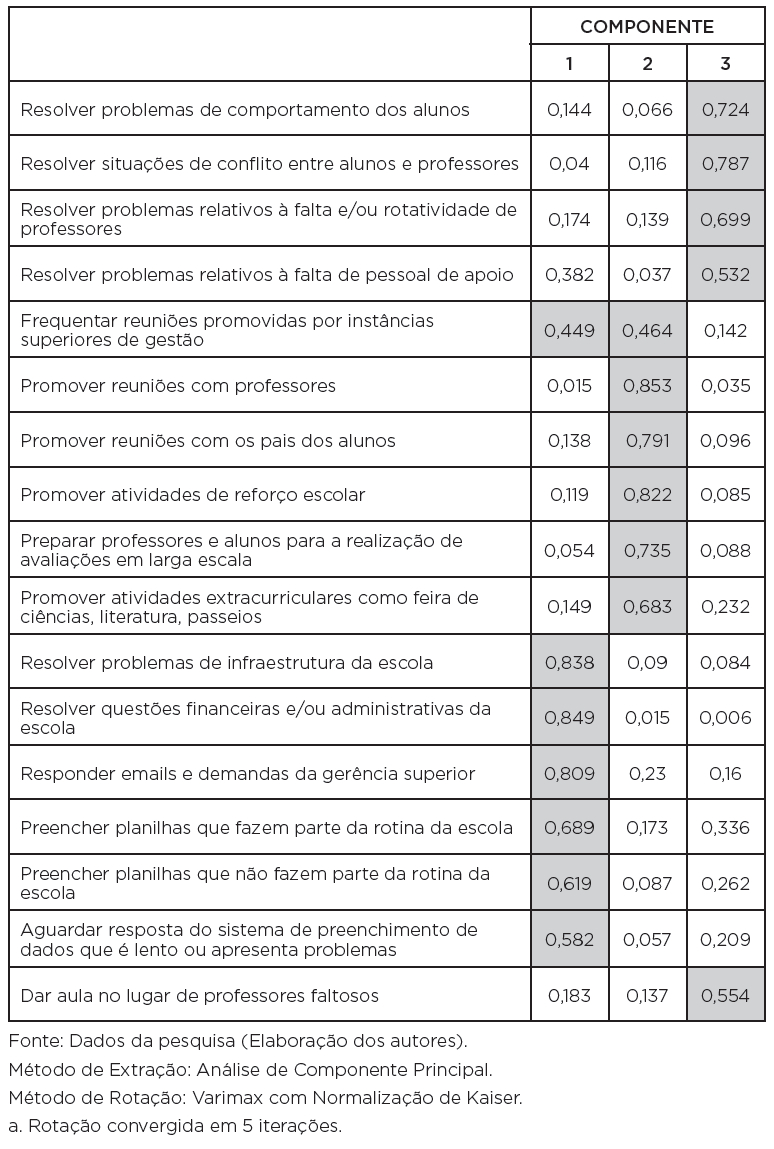

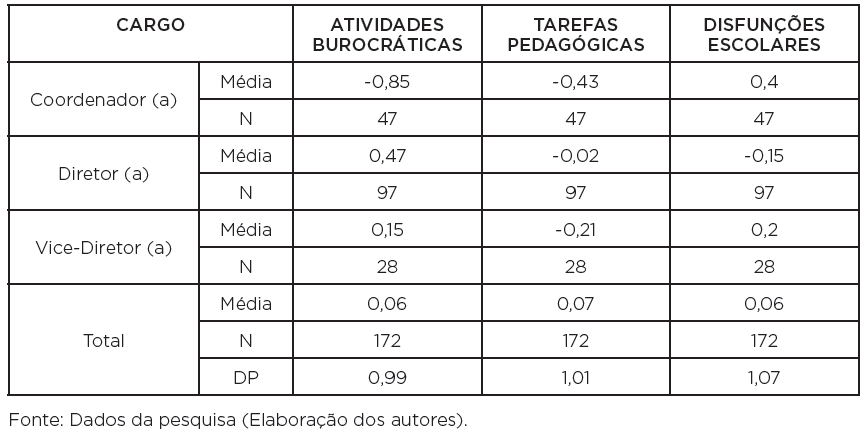

Em busca de verificar a coerência desse achado – que se mostrou constante na pesquisa – aplicamos novamente o procedimento que buscou identificar as atividades que mais consomem seu tempo de trabalho para cada uma das categorias, que incluímos na dimensão 2: preocupações a que estão afeitos nas escolas. O recurso, mais uma vez aplicado, foi a análise de componentes principais. Um conjunto de atividades pré-estabelecido foi apresentado e cada um dos respondentes atribuiu valor de 0 a 10, de menor a maior preocupação/tempo dedicado a elas, conforme apresentado no Quadro 3.

Os três componentes provenientes da análise explicam, respectivamente, 22, 20 e 15% da variância total, adquirem, imediatamente, interpretação coerente e foram, na ordem, categorizados em: atividades burocráticas, tarefas pedagógicas e disfunções escolares. Os escores médios, quando relacionados com a função exercida na escola, foram dispostos no Quadro 4. A divisão de trabalho parece concentrar direções em atividades burocráticas gerais, enquanto coordenações estariam dedicadas às ocupações mais propriamente “pedagógicas”, ao passo que vice-direções parecem mais distantes de todas essas ocupações, exceto pela intervenção em aspectos problemáticos da vida escolar.

Reiteramos o fato que tais indicadores são comparativos e de percepção. De forma alguma medem o tempo dedicado e a implicação real de cada categoria. Entretanto, parecem estar de acordo com os achados de outros autores que sugerem o excesso de atividades atribuídas, de maneira geral, aos gestores escolares (BARROSO, 2005; CARVALHO; OLIVEIRA; LIMA, 2014; MENDONÇA, 2001). Tais atividades têm caráter mais administrativo do que pedagógico, o que levanta a hipótese de que a falta de tempo pode ser um dos fatores que contribui para a apropriação e usos superficiais dos dados educacionais produzidos pelas avaliações em larga escala, especialmente no caso de diretores. Além disso, nossos achados podem auxiliar na compreensão das variações nas informações sobre conhecimento dos indicadores mais gerais ou mais particulares.

QUADRO 4: Atividades que mais consomem tempo de trabalho: escores fatoriais médios, segundo a função

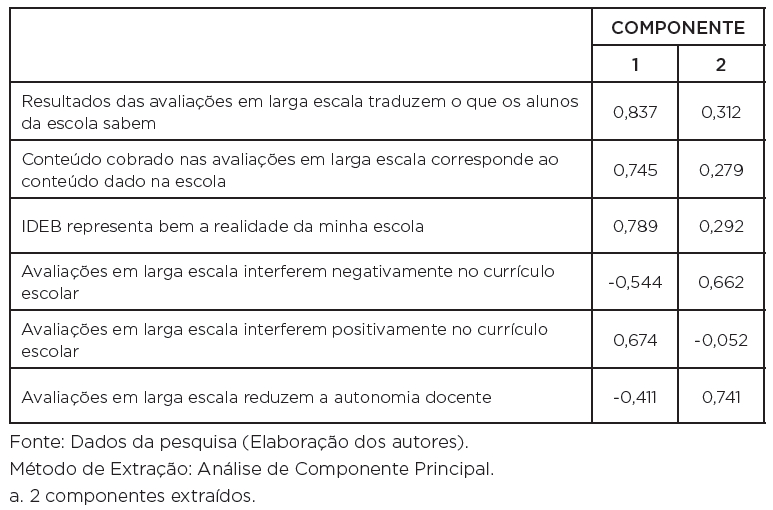

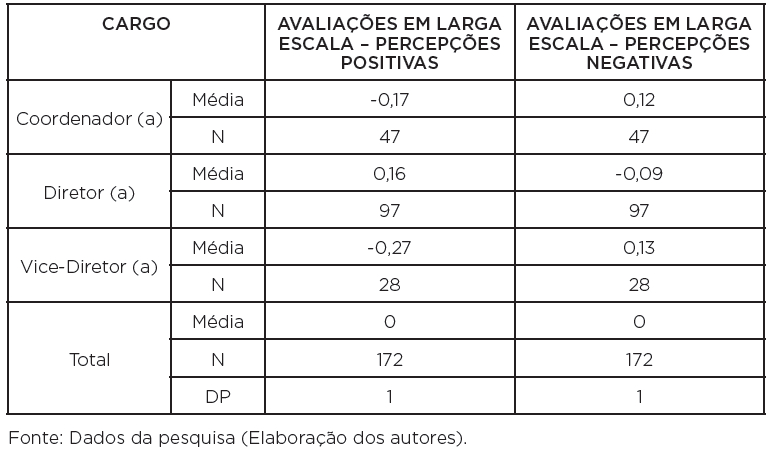

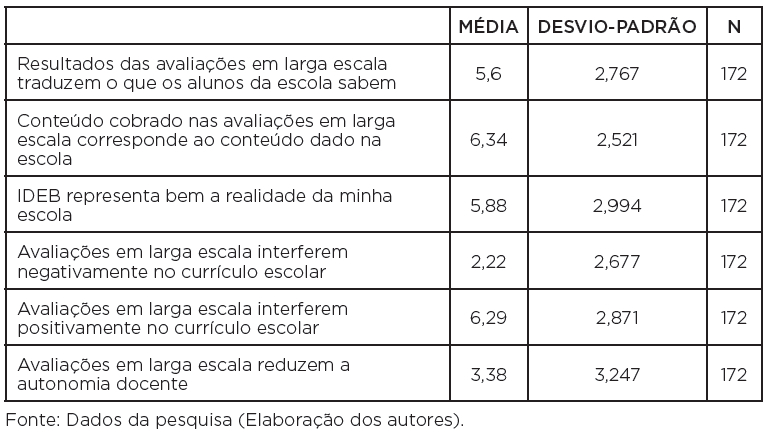

No que diz respeito à dimensão 3 – percepções gerais das avaliações em larga escala –, expressa nas afirmativas relacionadas no Quadro 5, dois componentes emergem, mesmo sem rotação, e respondem, respectivamente, por 47 e 21% da variância explicada: uma apreciação claramente positiva e uma claramente negativa sobre seus conteúdos e significados, conforme destacado pelas cargas fatoriais mais elevadas.

Relacionado com a função exercida pelos respondentes ao web survey, o resultado mostra uma distinção bastante nítida, segundo a função. Ainda que as diferenças entre os escores fatoriais médios não sejam elevadas, há clara distinção nas valorações atribuídas pelas direções, em contraste com coordenações pedagógicas e vice-direções. Portanto, diretores declararam maior conhecimento sobre sistemas avaliativos, índices e metas em geral e apresentaram, também, apreciação predominantemente positiva das avaliações, em um modelo que resultou em variáveis razoavelmente antagônicas, ao menos quanto aos itens que denotariam apreciação diretamente negativa de tais eventos. Coordenações e vices julgam de maneira mais negativa as avaliações em larga escala, conforme o Quadro 6 aponta. Entretanto, estatísticas descritivas das variáveis, presentes no Quadro 7, exibem um resultado interessante: médias bem mais elevadas para os valores atribuídos a variáveis que podem ser consideradas de apreciação positiva das avaliações em larga escala.

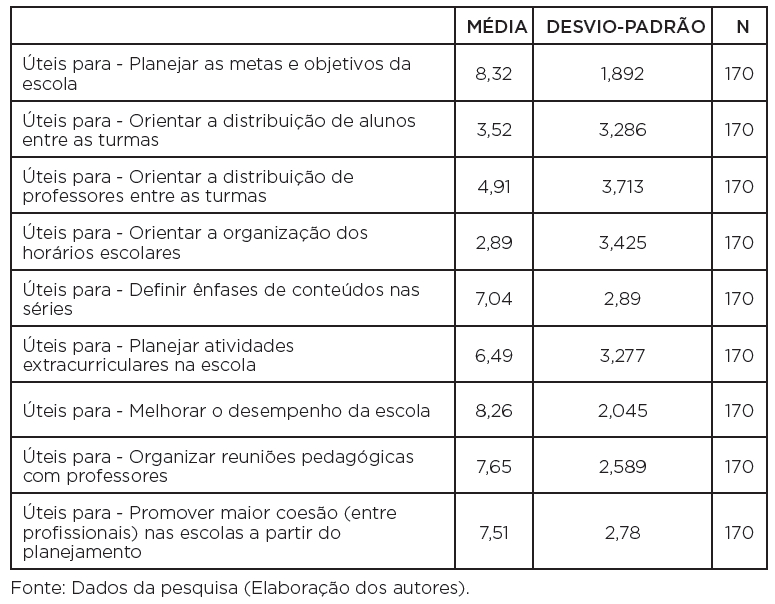

Já com relação à dimensão 4 – utilidades reconhecidas para as avaliações em larga escala –, há boa variação entre ênfases atribuídas a cada variável que buscou medir tal dimensão, conforme mostra o Quadro 8. Destaque para as médias das utilidades percebidas para planejar as metas e objetivos das escolas e melhorar seu desempenho.

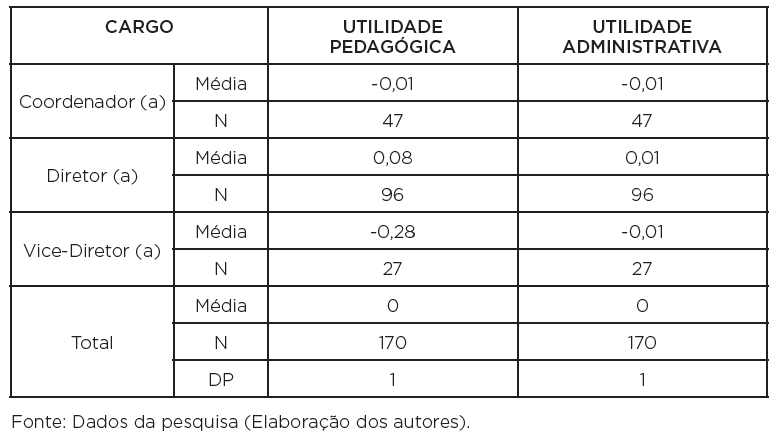

A análise fatorial8 apresentou dois fatores que explicaram 70% da variância. São, de novo, dois elementos aos quais se pode atribuir coerência conceitual. O primeiro denominamos “utilidade pedagógica” e, o segundo, “utilidade administrativa”. Note-se que, em acordo com o conjunto dos resultados, as três variáveis que representam as utilidades mais organizacionais e administrativas são as que obtiveram médias bem inferiores, conforme demonstrado. Quando distribuídas conforme as funções exercidas, o resultado foi de diferenças praticamente inexistentes, exceto para a apreciação inferior da utilidade pedagógica das avaliações, percebida pelas vice-direções, conforme aponta o Quadro 9.

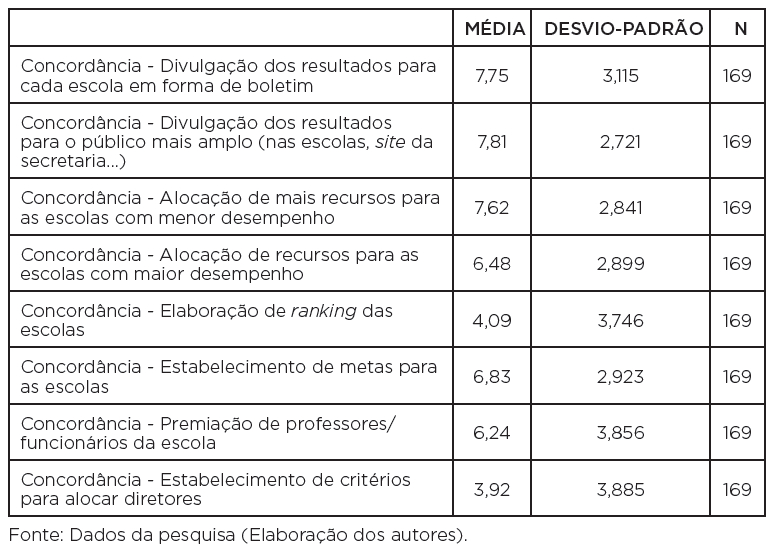

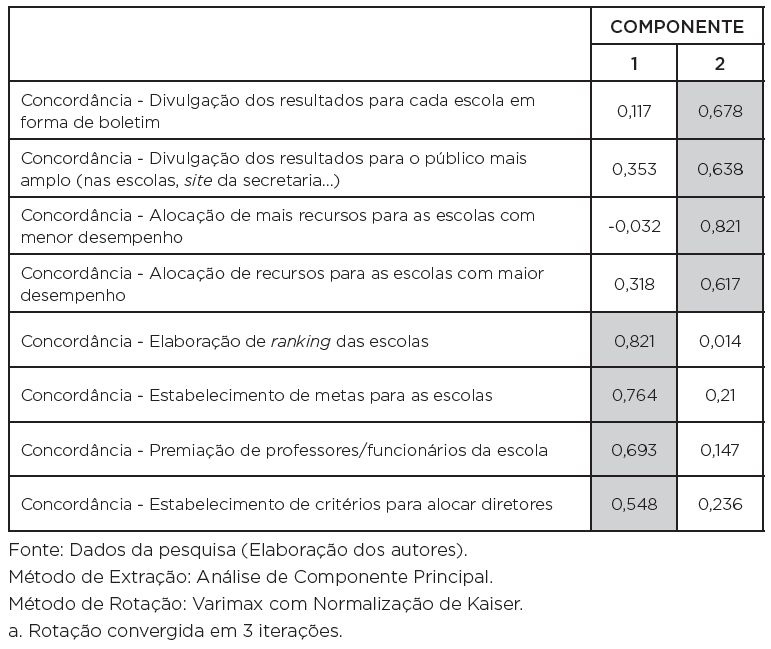

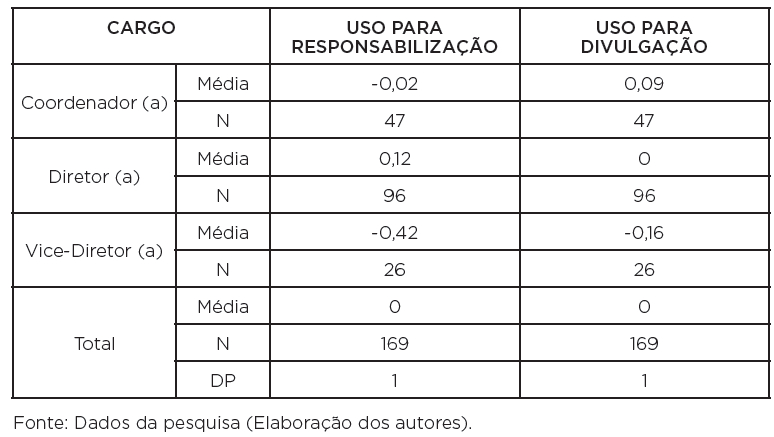

Solicitados a expressar discordância (mais próximo de 0 na escala) ou concordância (mais próximo de 10 na escala) acerca dos usos externos e públicos das avaliações em larga escala, os dirigentes escolares ouvidos manifestaram, mais uma vez, coerência nas respostas, resultando dois componentes bem distintos que explicam 28,5 e 25,5% da variância total, aos quais denominamos “uso para divulgação” e “uso para responsabilização”. A variância explicada, agora, foi menor, atingindo 55% com esses dois fatores resultantes. As únicas posições que se inclinam mais para a discordância são as referentes ao uso para estabelecimento de rankings e para nomeação de direções. As vice-direções destoam um pouco das demais categorias, mais uma vez. Os resultados estão nos quadros 10, 11 e 12.

De maneira geral, as percepções são positivas quanto à utilidade das avaliações e indicadores educacionais. Contudo, novamente percebe-se que os diretores, que declararam maior conhecimento e percepções gerais positivas, podem ser também os mais favoráveis aos usos dos indicadores, na medida em que reconhecem mais utilidade quando comparados aos coordenadores pedagógicos e vice-diretores. As evidências que associam positivamente conhecimento, percepções e usos são semelhantes aos argumentos defendidos por Cerdeira (2015), Cerdeira, Almeida e Costa (2014), Fernandes et al. (2010), Mandinach e Gummer (2013), Marsh (2012), Rosistolato e Prado (2013) e Silva et al. (2013).

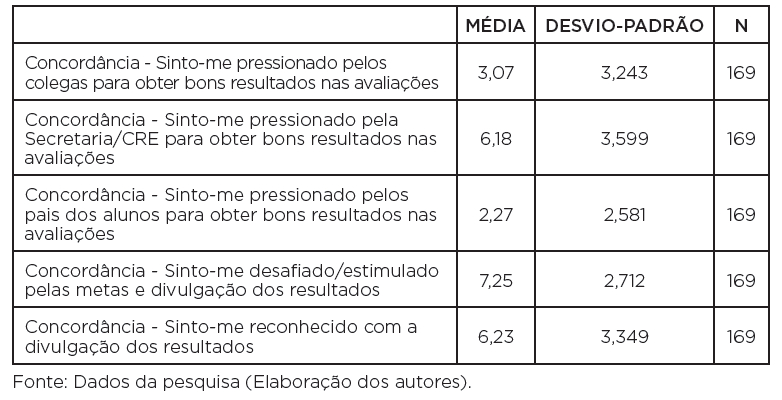

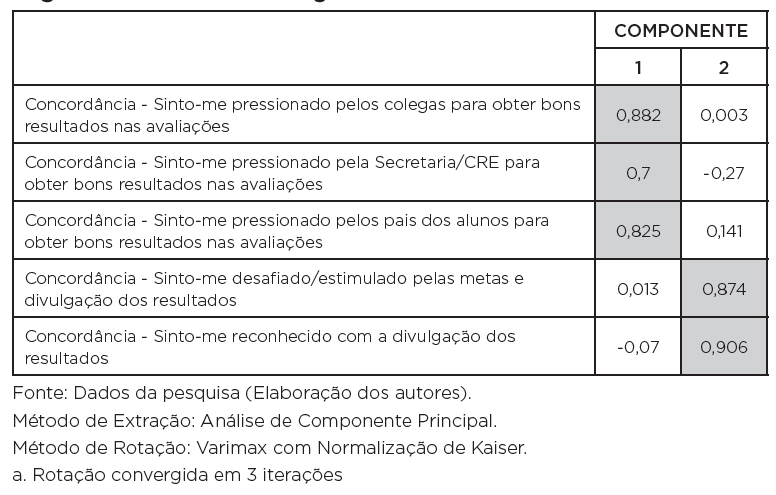

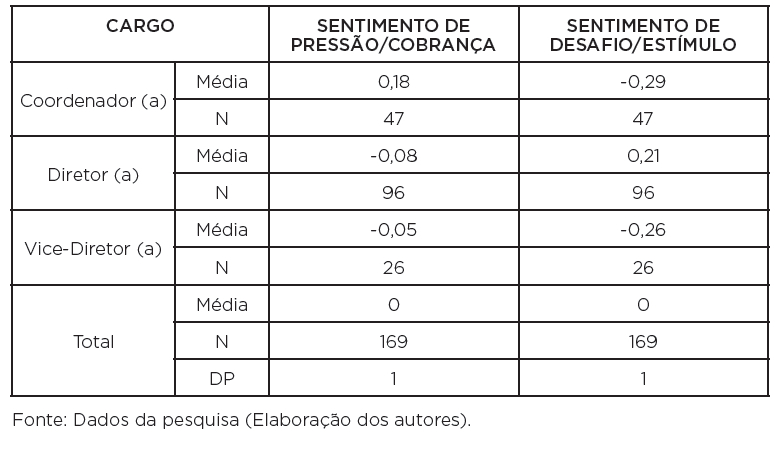

Finalmente, ao tratar da dimensão 5 – sentimentos associados às avaliações em larga escala –, bem como às políticas associadas a elas, os resultados da tentativa de síntese são igualmente interessantes. A descrição de cada uma das variáveis que compôs essa dimensão analítica (expressas em escalas de 0 a 10) resulta em declarações de sentimento predominante de estímulo e reconhecimento, mais do que a possível contrariedade pela exposição a pressões. Aliás, os participantes não expressam sentirem-se pressionados pelos colegas ou pelos pais dos estudantes, o que vai na contramão da démarche prevista pelas políticas de responsabilização no mundo. A pressão parece ser sentida somente a partir dos órgãos superiores da burocracia educacional, o que descortina possíveis discussões sobre políticas de responsabilização e cultura cívica brasileira – ou carioca.

A análise, com a aplicação da rotação, permitiu reduzir a dois fatores que respondem por 39 e 33,5% da variância total explicada de 73% das cinco variáveis descritas no Quadro 13. De novo, há coerência evidente nas respostas.

Os sentimentos de pressão e estímulo/desafio se agruparam e distribuíram-se conforme as médias pelas categorias participantes. As direções, novamente, destoam quanto aos demais, visto que são os que se sentem menos pressionados e mais estimulados da equipe de gestão escolar.

QUADRO 15: Percepções sobre consequências das avaliações em larga escala – sentimento de cobrança/sentimento de desafio/estímulo: escores fatoriais médios, segundo a função

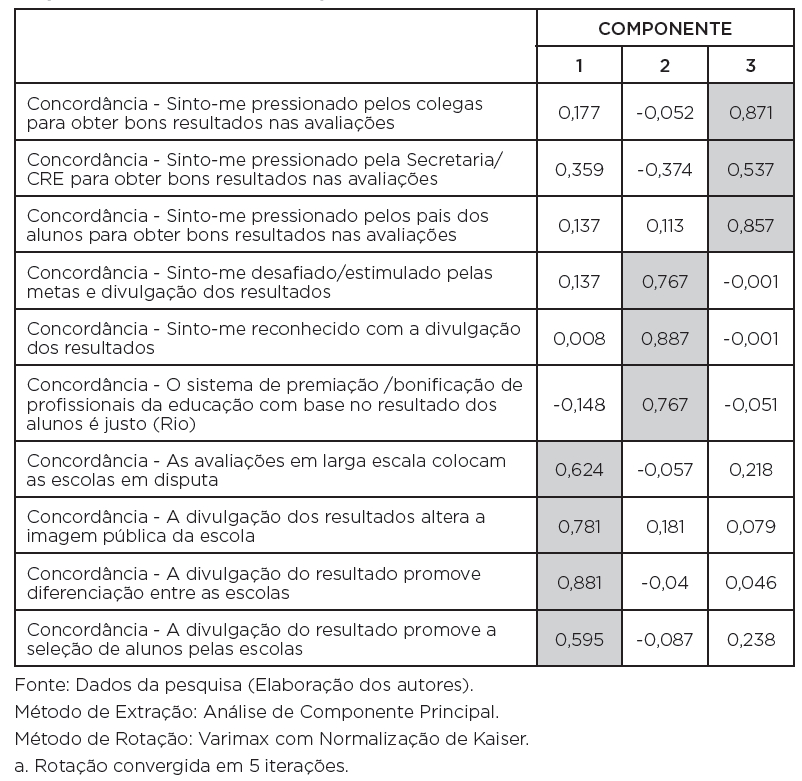

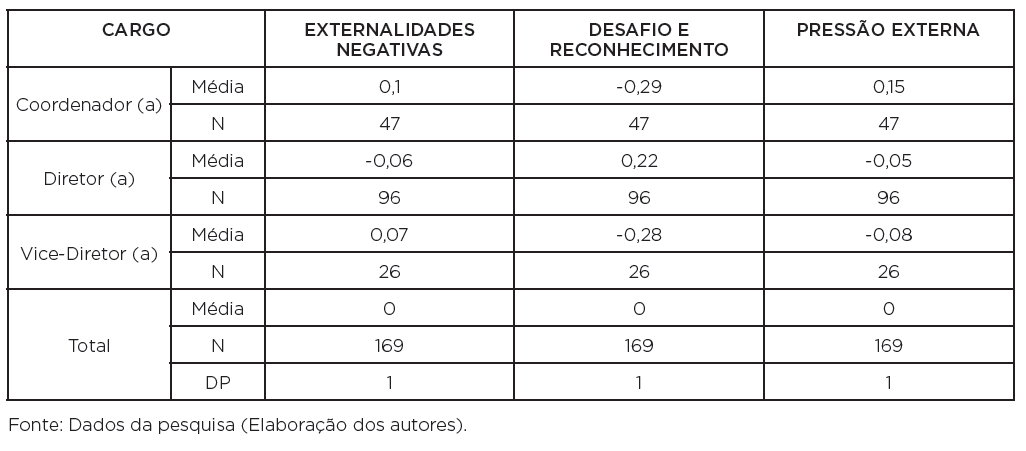

Quando acrescida a matriz da análise acima de outras variáveis que podem ser tomadas como integrantes de uma dimensão que expressa percepções quanto a efeitos das avaliações em larga escala, os fatores encontrados foram igualmente acrescidos de um terceiro fator consistente: a percepção de externalidades negativas provocadas pelas avaliações. Sendo que os três componentes resultantes respondem por, respectivamente, 23, 22 e 19% da variância total explicada. Observa-se, no Quadro 16, como se organizaram as afinidades entre as respostas numéricas atribuídas pelos participantes. A percepção de um potencial dano público às imagens das escolas ou de efeitos segregadores do uso das avaliações, tão presente na literatura acerca do tema, manifestou-se também nesse momento.

Na distribuição por função, exibida no Quadro 17 por seus escores médios, as direções destoam de forma marcante de suas acompanhantes na gestão escolar, mostrando coerência com os dados apresentados no Quadro 15. É interessante, porém, ressaltar que as três categorias têm percepções muito semelhantes quanto a possíveis externalidades negativas.

QUADRO 17: Percepções sobre consequências das avaliações em larga escala - externalidades negativas/desafio e reconhecimento/pressão externa: escores fatoriais médios segundo a função

Ao buscar extrair empiricamente os fatores, encontramos correspondências notáveis com as dimensões teóricas que havíamos projetado. A técnica de análise por componentes principais permite observar afinidades entre variáveis (respostas a itens de nosso questionário), proporcionando que padrões empiricamente constatados demonstrem suposições teóricas. Assim, obtivemos evidências que reforçam nossas concepções teóricas sobre a temática.

Ao contrário do que aparenta o convívio no ambiente acadêmico da área educacional, a rejeição às políticas de produção e uso de indicadores associados com avaliações de proficiência em larga escala não demonstraram sofrer grande rejeição, ao menos em nossa amostra. Claro que não se pode afastar o risco do viés amostral, conforme já assinalado. No entanto, não se trata de uma amostra muito reduzida, especialmente de direções (considerando em torno de 700 o total de escolas de primeiro segmento do ensino fundamental que formavam o universo amostral), e tivemos o cuidado em tentar preservar a aleatoriedade.

O espaço aqui disponível não permite aprofundar as muitas vertentes analíticas possíveis para o questionário aplicado, grande e com diversas dimensões não mencionadas. Assim, além da distribuição dos escores fatoriais demonstrativos de variáveis latentes segundo os cargos ocupados pelos participantes do estudo, muitas outras relações podem ser estabelecidas. Por exemplo, a participação em cursos dedicados ao tema está associada com maior percepção de usos possíveis das avaliações, o que novamente reforça nossas hipóteses de que quanto mais ampla a divulgação de informações e acesso ao conhecimento, menor a probabilidade de resistência e maior a probabilidade de uso dos dados.

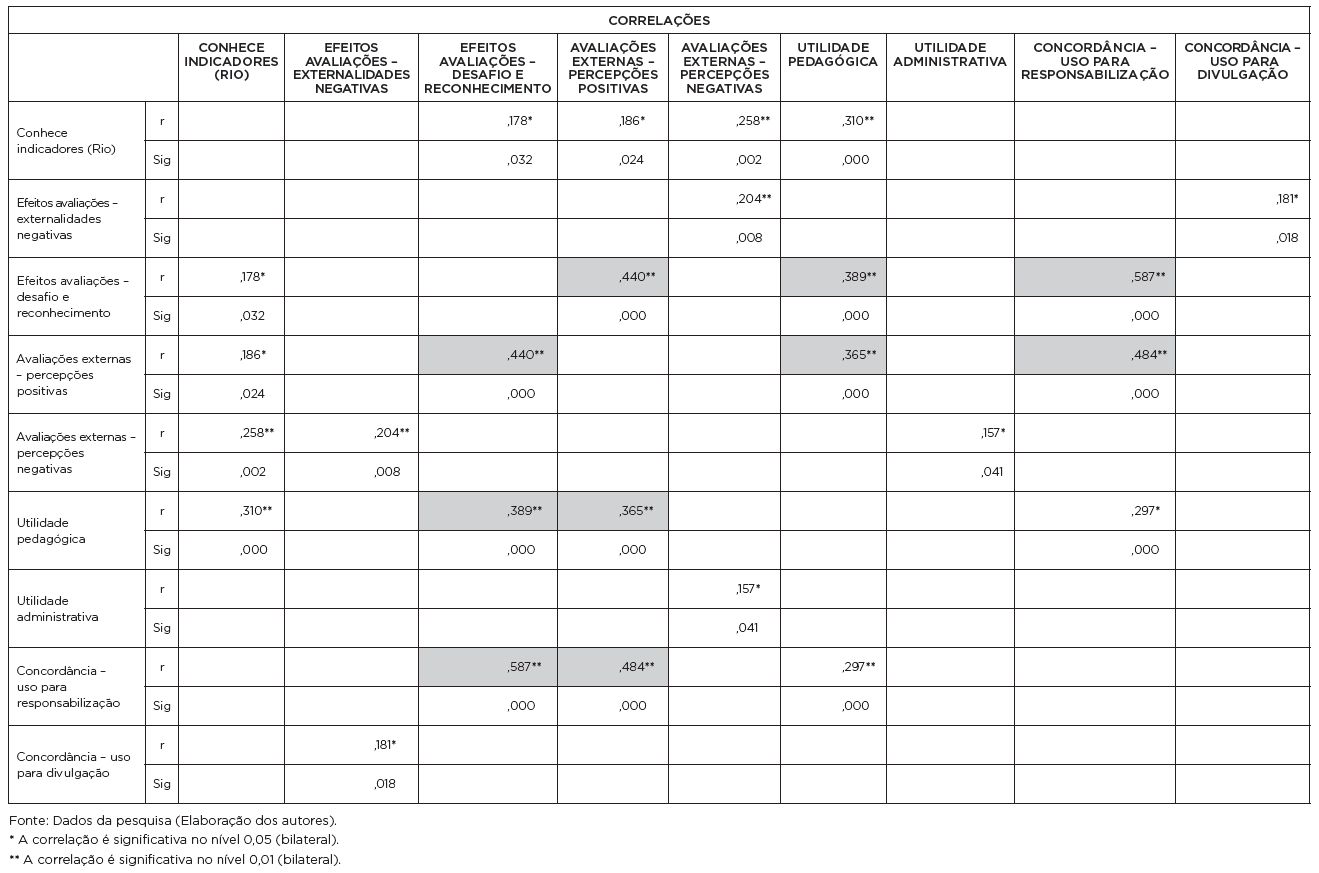

O uso efetivamente dado às informações de avaliação nas escolas também resta a ser analisado e todos guardam relação pertinente com o conhecimento dos indicadores. Enfim, há um escopo bem grande de tratamento do manancial de informações no web survey efetuado. Uma análise de correlação (Pearson) entre os fatores gerados reafirma a coerência das respostas e dos construtos que orientaram as perguntas. Não há coeficientes de correlação muito elevados, mas parece haver consistência no desenho geral.

QUADRO 18: Coeficientes de correlação entre escores gerados a partir das aplicações da análise fatorial por componentes principais

Os coeficientes de correlação destacados são os mais significativos e maiores, lembrando que foram mantidas, na matriz de correlações, apenas as variáveis que apresentaram relações significativas com outra. Por definição, fatores extraídos na mesma análise de componente principal não podem estar correlacionados entre si, r = 0. A observação dos coeficientes reforça a ideia de uma tendência à coerência de um bloco de opinião afim ao uso das avaliações com finalidade pedagógica, ressaltando seu caráter positivo no universo escolar, estimulante aos atores e predisposto às políticas de responsabilização. Passos futuros buscarão ultrapassar o tratamento descritivo, propondo modelagem inferencial que auxilie a interpretação de tais achados.

CONSIDERAÇÕES FINAIS

Neste artigo analisamos as mudanças das percepções de gestores escolares com relação à avaliação em larga escala, em função de sua participação em um curso sobre compreensão e uso de indicadores educacionais. Articulado a isso, analisamos os dados de um web survey realizado também com gestores, buscando associar o conhecimento técnico declarado sobre os sistemas de avaliação nacionais e locais com as percepções declaradas acerca do tema. Foi possível perceber que a participação no curso de formação proporcionou a ampliação do conhecimento técnico dos participantes e a consequente redução da resistência às avaliações, tendo em vista que alguns gestores perceberam as possibilidades de uso dos dados para a melhoria de suas escolas.

Os resultados do web survey, por sua vez, reforçam os achados anteriores, na medida em que os respondentes que declararam ter maior conhecimento técnico sobre o assunto (em geral, diretores) também apresentaram percepções mais positivas e maior tendência ao uso dos resultados das avaliações em larga escala, com objetivo de melhorar o processo de ensino-aprendizagem nas escolas. Portanto, tanto a abordagem qualitativa como a quantitativa permitiram reforçar nossas hipóteses iniciais de que a ampliação do conhecimento sobre sistemas avaliativos – origem, histórico, objetivos, metodologia, cálculo de índices, projeções de metas, etc. – pode reduzir a resistência a essas políticas e favorecer usos pedagógicos dos dados produzidos que não se limitem somente ao uso instrumental com interesse em elevar artificialmente os índices escolares. Resta, porém, o desafio de avançar na discussão, não sobre as percepções, mas sobre a capacidade efetiva dos indicadores educacionais disponíveis, especialmente os de avaliação em larga escala, proverem informações claramente apropriáveis no planejamento pedagógico no nível das classes escolares e também no dos alunos. Esta pesquisa não ambicionou adentrar esse terreno, mas parece-nos pertinente levantar a relevância dessa questão que, supõe-se, pode estar associada com desconhecimento e/ou resistência diante do sistema de informações disponível.