INTRODUÇÃO

Na atualidade, os processos avaliativos realizados em instituições de ensino superior não se restringem à avaliação da aprendizagem do aluno. Os diferentes processos desempenham funções variadas, podendo subsidiar tomada de decisões que envolvem manutenção ou não de cursos, alterar a organização e a reestruturação curricular e fornecer informações sobre a eficácia do ensino e sobre o progresso dos alunos (MOREIRA; GRAVONSKI; ARANDA, 2012). Entretanto, apesar de a avaliação apresentar vários formatos e funções, tradicionalmente o termo traz à mente processos e instrumentos que têm como objetivo a verificação, a comparação, a quantificação da aprendizagem dos alunos, estabelecendo notas e classificando os melhores e os piores estudantes.

Diversos autores da área da didática do ensino superior e de ensino de engenharia (BAZZO; PEREIRA; LINSINGEN, 2000; BOUD, 2018; FERNANDES, 2016; GARCIA, 2009; GODOY, 2000; TAI et al., 2018; WACHOWICZ, 2000) consideram que nos processos de avaliação do rendimento acadêmico no ensino superior predomina a verificação da capacidade de memorização e de transcrição por meio de provas e trabalhos. Esses processos, característicos da pedagogia tradicional, revelam um ensino centrado no professor, que avalia o aluno por uma perspectiva somativa e decide, isoladamente, o que será ensinado e avaliado.

Se aceitarmos como fundamentais para a formação do engenheiro a “[...] promoção de atitude criativa, crítica e ilustrada” (ou fundamentada) (BAZZO; PEREIRA; LINSINGEN, 2000, p. 83), e o fato de que a avaliação é intrínseca ao processo de ensino-aprendizagem, então, muito mais do que buscar a verificação de erros e acertos, a avaliação deveria constituir um ato de reflexão a respeito dos procedimentos empregados para a construção do conhecimento, tanto por parte dos alunos quanto dos professores, sendo um processo e não um fim a ser alcançado (BAZZO; PEREIRA; LINSINGEN, 2000).

Tendo em vista a necessidade de conhecer com maior profundidade como se dá a avaliação do desempenho acadêmico no ensino e de comparar essa realidade com o que é sugerido pela literatura para superar propostas de avaliação já consideradas ineficientes, este estudo se propõe a identificar as estratégias de avaliação mais utilizadas pelos professores de cursos de Engenharia Civil, de Computação, Elétrica, Eletrônica e Mecânica de três campi de uma universidade pública do sul do Brasil.

A TRADIÇÃO DA AVALIAÇÃO NO ENSINO SUPERIOR

A avaliação nas instituições brasileiras de ensino superior segue, em linhas gerais, o modelo tradicional de ensino. Na época da chegada dos jesuítas ao Brasil e da implantação desse modelo de ensino entre os séculos XVI e XVII, o processo de avaliação estabelecido tinha como objetivo a seleção e a classificação dos alunos segundo maior ou menor rendimento, por meio de testes orais ou escritos, que buscavam verificar o conhecimento memorizado (PIMENTA; ANASTASIOU, 2014).

Apesar de todos os esforços para superar as formas tradicionais de avaliar os estudantes do ensino superior nas instituições brasileiras, ainda há remanescentes de um processo no qual prevalece a verificação do acúmulo de conhecimentos e da habilidade de reprodução destes em situações definidas, controladas ou estruturadas (BELHOT, 2005). A capacidade de memorização, de repetição, ainda é verificada por meio de testes de múltipla escolha ou de atividades que exigem a repetição, a transcrição de pensamentos, conceitos, fatos, roteiros de execução, sempre com base no ponto de vista de que o que foi transmitido pelo professor ou o que consta na literatura é correto e indiscutível. Tais práticas têm consequências negativas, e, como argumentam Luckesi et al. (2012, p. 12), “[...] como ferramenta diagnóstica para o crescimento, a avaliação torna-se um instrumento que ameaça e disciplina os alunos por medo [...]” e promove preconceitos e estigmas.

Os professores são responsáveis por conduzir a avaliação dos alunos na sala de aula e ensinar o que consideram que eles devem aprender. Portanto, o conteúdo programático sempre será carregado com os desejos e as impressões pessoais dos professores. Nesse sentido, o que muitas vezes acontece é que as preferências dos professores em determinado assunto se distanciam daquelas dos alunos, de modo que o que é solicitado pelos professores em uma prova muitas vezes não coincide com o que os alunos consideram mais importante e, portanto, a que dedicam mais tempo de estudo (BAZZO; PEREIRA; LINSINGEN, 2000, p. 84).

Como o curso é composto de diferentes disciplinas, o aluno passa a tentar decodificar o pensamento de cada professor, prevendo o que será solicitado na prova e tentando reproduzir o conteúdo técnico-científico conforme os valores do professor, implicitamente embutidos nesse processo. A consequência é a adaptação que o aluno deve fazer para se adequar à forma de pensar do professor. Esse processo de adaptação pode levar os alunos a abdicarem

[...] da possibilidade de realizar a reestruturação de seus próprios modelos de conhecimento em favor das estruturas modelares de seus professores, o que implica submeter-se a um aprendizado desestruturante. Desestruturante no sentido de negar a validade do conhecimento prévio do aluno (suas concepções alternativas) como se, por ser considerado não tecnicamente correto, pudesse ser sumariamente descartado. (BAZZO; PEREIRA; LINSINGEN, 2000, p. 87).

Essa prática de desestruturação do estilo de pensamento se revela, por um lado, em alunos passivos, que simplesmente anotam, decoram, aceitam e reproduzem assuntos apresentados formalmente pelo professor. Por outro lado, revela um professor que repassa conhecimentos estruturados ao longo de anos, que pouco se aventura além dos conhecimentos que considera e que domina, e que tenta verificar se o aluno “emana” os conhecimentos trabalhados em sala de aula sem “contaminações” decorrentes de valores pessoais. Para Bazzo, Pereira e Linsingen (2000, p. 82),

[...] o que normalmente é utilizado como critério de avaliação de conteúdo no ensino de engenharia está quase que exclusivamente centrado em provas (ou testes) [...]. Outras formas de aprendizado - trabalhos práticos, atividades laboratoriais e de campo, relatórios, seminários, etc. - são pouco valorizadas no processo avaliativo, o que pode ser atestado pelo peso que normalmente lhes é atribuído na composição das notas finais, ápice do processo de ensino.

Segundo Boud (19901 apudGODOY, 2000), em uma síntese da produção acadêmica dos anos 1980 e 1990, os principais aspectos abordados pela pesquisa educacional, no que diz respeito à avaliação, revelam que os alunos são: a) avaliados em assuntos que exigem menor nível intelectual, com ênfase na memorização; b) estimulados a dedicar seus estudos a tópicos que serão avaliados, e não àqueles que despertam maior interesse; c) impelidos a adotar estratégias de estudo e de aprendizagem adequadas ao estilo de avaliação do professor; d) induzidos a acreditar que dominam conceitos fundamentais dos conteúdos, pelo fato de terem obtido bom aproveitamento em provas e trabalhos, apesar de algumas pesquisas indicarem que a obtenção de uma pontuação elevada não significa que o aluno tenha domínio de determinado conceito; e) levados a priorizar avaliações das quais receberão notas; e f) impelidos a buscar, no decorrer das aulas, pistas sobre o que será requerido na avaliação.

Esses aspectos mostram que a avaliação tem uma influência importante na aprendizagem dos alunos. Se, por um lado, o modo como o aluno pensa em aprender e estudar determina o modo como ele lida com tarefas e avaliação, por outro lado, a experiência de avaliação dos alunos determina a maneira pela qual o aluno aborda a aprendizagem (futura). A avaliação é, assim, logicamente, mas também empiricamente, uma das características que definem as abordagens dos alunos à aprendizagem (MARTON; SÄLJÖ, 1997).

Para Luckesi et al. (2012, p. 148), o “[...] objetivo da avaliação da aprendizagem é subsidiar o ensino e a aprendizagem”, investigando o que o aluno aprendeu ou não durante o processo de ensino. Isso significa que o processo de avaliação deve fornecer muito mais do que apenas uma nota em seu final. A avaliação deve ser um instrumento de reflexão da prática pedagógica, dos instrumentos e metodologias utilizados em sala de aula.

Os professores e os processos avaliativos

As características necessárias ao futuro profissional de engenharia, muitas vezes apresentadas na literatura da área, dizem respeito ao domínio da linguagem técnica; utilização de equipamentos e materiais cada vez mais sofisticados e diversos; capacidade de comunicar-se bem, de forma oral e escrita; capacidade de observar, interpretar e tomar decisões adequadas a cada caso; capacidade de liderar equipes e estar sempre apto a adquirir e processar novas informações. Contudo, é necessário se perguntar se os professores universitários serão capazes de estimular e de avaliar o desenvolvimento de todos esses “quesitos”. Será que o professor universitário, que tem conhecimento técnico-científico das áreas que leciona, mas que nem sempre está familiarizado com os conhecimentos didático-pedagógicos, será capaz de perceber se o aluno desenvolveu essas características exigidas? (WACHOWICZ, 2000).

Tradicionalmente os professores estão mais familiarizados com a avaliação somativa, que busca verificar a aquisição de conhecimentos técnico-científicos ao final de uma unidade de ensino. Isso, na opinião de Garcia (2009, p. 205), implica “[...] a manutenção de uma antiga e persistente cultura avaliativa que tende a destacar particularmente a utilização de provas escritas para avaliar o grau de aprendizagem dos alunos”.

Os professores precisam saber mais sobre quando e como usar os vários métodos avaliativos, precisam monitorar a eficácia das estratégias que usam, avaliar seu impacto e refletir criticamente sobre os processos avaliativos utilizados em suas disciplinas. Nesse sentido, uma das propostas de avaliação que vem sendo discutida no meio acadêmico é a avaliação formativa.

A avaliação formativa

Conforme estudos desenvolvidos por diversos pesquisadores (ANASTASIOU; ALVES, 2006; BARREIRA et al., 2017; BLACK; WILIAM, 1998; DEPRESBITERIS, 2011; FERNANDES, 2008; FRAILE; CORNEJO, 2012; MOREIRA; GRAVONSKI; ARANDA, 2012; SHUTE, 2008; YORKE, 2003), a avaliação formativa vem sendo bastante estudada e recomendada para os diferentes níveis de ensino, especificamente no ensino de engenharia.

O principal objetivo da avaliação formativa é contribuir para a aprendizagem, por meio da prestação de informações sobre o desempenho do aluno, a partir de ações formais ou informais (YORKE, 2003). A avaliação formativa também pode ser definida como as informações comunicadas ao aluno que se destinam a modificar seu comportamento ou pensamento, com a intenção de incrementar a aprendizagem (SHUTE, 2008, p. 154).

Contudo, a avaliação formativa não se limita a informações prestadas aos alunos, pelo professor, sobre o rendimento da aprendizagem. Ela também se caracteriza por um processo de regulação permanente a fim de melhorar a qualidade do ensino e da aprendizagem (MOREIRA et al., 2015).

Segundo Villas Boas (2000), a avaliação formativa contribui para que os alunos aprendam a aprender, colocando ênfase no processo ensino-aprendizagem, tornando os alunos participantes desse processo, possibilitando o desenvolvimento da autoavaliação, da avaliação por colegas, de forma a auxiliar os alunos a compreenderem melhor a própria aprendizagem.

A avaliação formativa envolve todas as atividades desenvolvidas pelos professores e seus alunos, com o intuito de fornecer informações a serem utilizadas como feedback para reorganizar o trabalho pedagógico (BLACK; WILIAM, 1998). Diante disso, esse modelo de avaliação envolve não somente a ação do docente, mas também a dos alunos, dando a eles a oportunidade de descobrirem suas próprias fragilidades e potencialidades e de criarem suas estratégias e instrumentos para superação das fragilidades, de forma a assumirem algum controle sobre a própria aprendizagem (MOREIRA et al., 2015).

Para Yorke (2003), a avaliação formativa pode ser desenvolvida dentro de um processo formal ou informal. Em ambos, ela pode se ser feita pelos professores, colegas (outros estudantes), coordenadores de curso, supervisores, pedagogos, diretores (dentre outros) e pelos próprios alunos.

A avaliação formativa formal pode ser definida como aquela que ocorre em referência ao planejamento de avaliações especificado nos currículos dos cursos e nos planejamentos das disciplinas. Ela envolve atividades oficiais exigidas dos alunos (provas e demais atividades) e do professor (avaliar as provas e as demais atividades e fornecer feedback). As avaliações formativas formais são tipicamente - mas não exclusivamente - realizadas pelos professores, mas também podem envolver os alunos como avaliadores.

As avaliações formativas informais ocorrem como acontecimentos que não são especificamente estipulados no desenho curricular nem no planejamento da disciplina. Esses eventos dão grande flexibilidade de julgamento ao professor, devendo ser praticados com responsabilidade (VILLAS BOAS, 2000). A modalidade de avaliação formativa informal inclui feedback instantâneo ao aluno durante atividades de aprendizagem, o que legitima comentários do professor sobre materiais elaborados e “arredondamento de notas”, tendo em vista critérios estabelecidos pelo docente. A avaliação formativa informal também pode ocorrer por meio de comentários e pareceres prestados por pares, pela observação do próprio aluno a respeito do seu desempenho, tendo como referência as atividades desenvolvidas por colegas, ou por meio de materiais que esclarecem o seu desempenho.

Não existem estratégias e técnicas exclusivas para a avaliação formativa, mas essa modalidade de avaliação geralmente ocorre por meio de feedbacks e da autoavaliação. O que deve ser observado é que o sistema de avaliação deve ser relevante, significativo para o aluno e coerente com o âmbito em que é aplicado.

METODOLOGIA E PROCEDIMENTOS

Delineamento do estudo

Para o desenvolvimento do estudo foi utilizada uma abordagem de métodos mistos (TASHAKKORI; TEDDLIE, 2003), que é um procedimento para coletar, analisar e misturar ou integrar dados quantitativos e qualitativos em algum estágio do processo de pesquisa em um único estudo (CRESWELL, 2005). A justificativa para a mistura de ambos os tipos de dados é que nem os métodos quantitativos nem os qualitativos são suficientes para capturar as tendências e os detalhes das situações. Quando usados em combinação, os métodos quantitativos e qualitativos se complementam e fornecem um quadro mais completo do problema de pesquisa (GREENE; CARACELLI; GRAHAM, 1989; JOHNSON; TURNER, 2003).

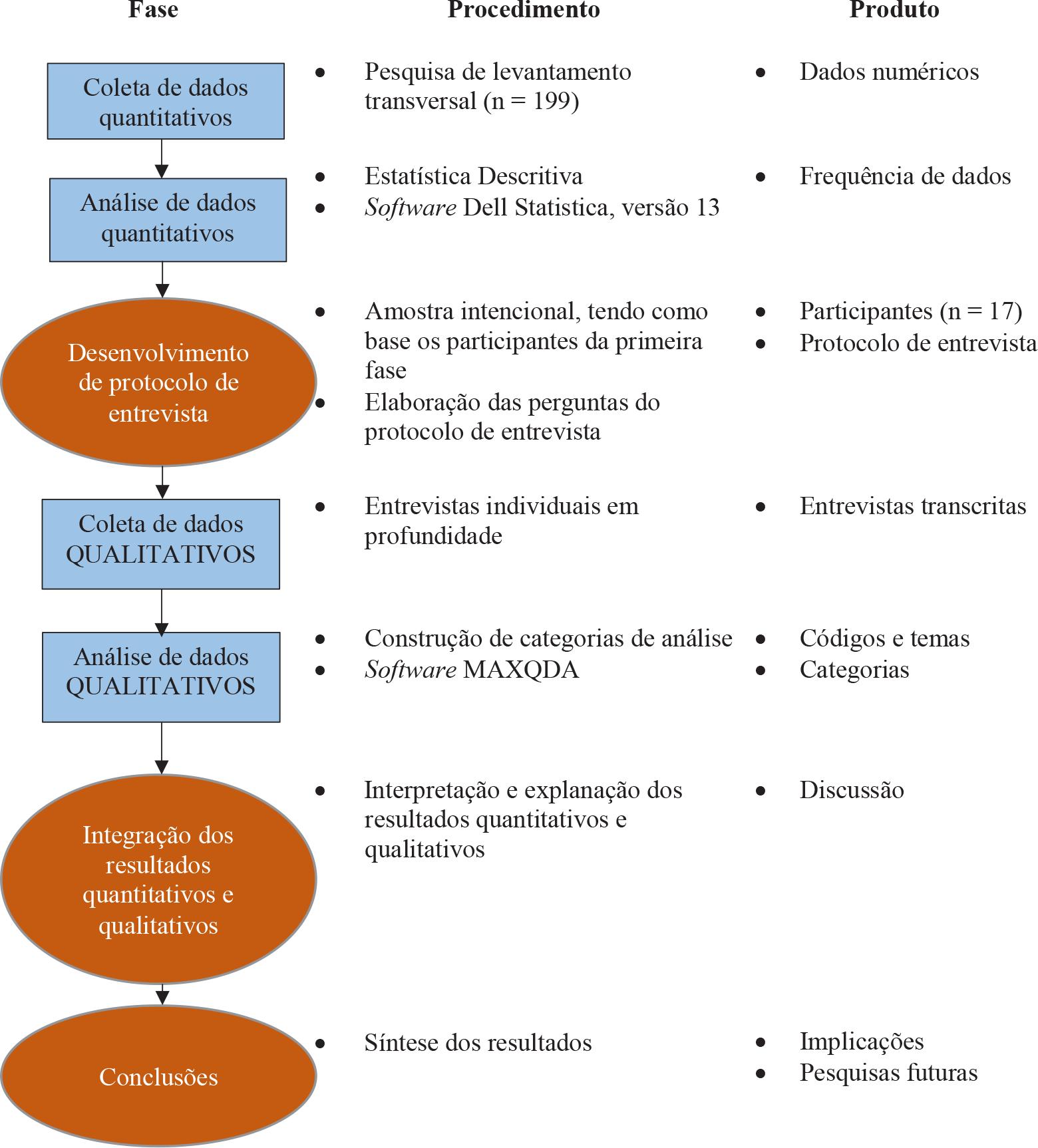

Para o desenvolvimento deste estudo foi adotado o delineamento misto sequencial explanatório composto de duas fases distintas: quantitativa e qualitativa (CRESWELL; PLANO CLARK, 2013). Nessa concepção, os dados quantitativos (numéricos) são recolhidos e analisados em primeiro lugar, enquanto os dados qualitativos (texto) são recolhidos e analisados em sequência e ajudam a explicar ou a elaborar os resultados quantitativos obtidos na primeira fase. A prioridade no estudo foi dada à abordagem qualitativa (CRESWELL et al., 2003), que focou explicações detalhadas dos resultados obtidos na primeira fase, quantitativa. Os resultados das fases quantitativa e qualitativa foram integrados durante a discussão dos resultados de todo o estudo (CRESWELL et al., 2003). A Figura 1 mostra um diagrama detalhado do delineamento misto sequencial explanatório desenvolvido.

Fonte: Elaboração dos autores com base em Creswell e Plano Clark (2013).

FIGURA 1 Diagrama procedural do delineamento misto sequencial explanatório

População e amostra

A população-alvo deste estudo eram 396 professores de disciplinas profissionalizantes e específicas dos cursos de graduação em Engenharia Civil, de Computação, Elétrica, Eletrônica e Mecânica de três campi de uma universidade pública do sul do Brasil. A amostra da fase quantitativa (primeira fase) foi composta de 199 professores selecionados por amostragem não probabilística por julgamento. Na fase qualitativa (segunda fase), dos participantes que responderam ao questionário e assinalaram interesse em participar da fase qualitativa do estudo, 17 professores foram selecionados intencionalmente, utilizando-se a estratégia amostral de variação máxima.

FASE QUANTITATIVA

Coleta de dados

Na fase quantitativa do estudo foi realizada uma pesquisa transversal, utilizando como instrumento de coleta de dados um questionário fechado. O questionário aplicado, uma adaptação do instrumento utilizado por Moreira, Gravonski e Aranda (2012), é composto de três escalas do tipo Likert, que objetivam avaliar diferentes aspectos relacionados às estratégias de ensino, de avaliação e aquisição de habilidades didático-pedagógicas.

Neste artigo são reportados apenas os resultados obtidos com a Escala de Estratégias de Avaliação (Evea), composta de 6 pontos, com âncoras em: 0 (Não se aplica), 1 (Nunca), 2 (Poucas vezes), 3 (Algumas vezes), 4 (Frequentemente) e 5 (Sempre).

As 15 variáveis analisadas foram elencadas com base em estudos de vários pesquisadores da área de didática do ensino superior (ABREU; MASETTO, 1980; ANASTASIOU; ALVES, 2006; BORDENAVE; PEREIRA, 2015; CARVALHO; MARTINEZ, 2005; DEPRESBITERIS; TAVARES, 2009; GIL, 2013; LAGUARDIA; PORTELA; VASCONCELLOS, 2007; LOWMAN, 2004; MENEZES et al., 2019; NUNES; RODRIGUES, 2012; SILVA; SILVA, 2008; VIEIRA, 2013; ZANON; ALTHAUS, 2008).

O questionário foi aplicado no primeiro semestre de 2015. A partir das respostas, os resultados foram obtidos por meio de estatística descritiva e de testes não paramétricos, realizados no software Dell Statistica versão 13.

Análise dos dados

Procedimentos estatísticos foram utilizados para analisar os dados da pesquisa. As informações demográficas de pesquisa e as respostas dos participantes a itens da escala de estratégias de avaliação foram analisadas utilizando-se a contagem de frequência.

Com o objetivo de identificar diferenças estatisticamente significativas entre as médias dos grupos, também foram conduzidos os testes não paramétricos U de Mann-Whitney (para as variáveis de agrupamento formadas por dois grupos - sexo e tipo de graduação) e Kruskal-Wallis (para as variáveis de agrupamento formadas por mais de dois grupos - tempo de atuação no ensino superior e maior titulação acadêmica).

O teste U de Mann-Whitney visa a comparar médias de duas amostras independentes (BRUNI, 2012). Os resultados apresentados na Tabela 4 são expressos pela estatística U e pelo Rank Sum. Na mesma tabela, ainda pode ser visualizado o p-valor (p-valor Z adjusted) relativo ao valor de z corrigido em relação aos empates (SIEGEL, 1981, p. 142).

A respeito do teste Kruskal-Wallis, para Siegel (1981) essa prova é extremamente útil para decidir se k amostras independentes provêm de populações diferentes. Os valores amostrais quase que invariavelmente diferem entre si, e a dificuldade é decidir se essas diferenças representam distinções efetivas entre as populações ou simplesmente variações casuais que podem ser esperadas entre amostras aleatórias de uma mesma população.

Os resultados do teste Kruskal-Wallis (Tabela 5) são expressos pela estatística H, pelo p-valor e pelos valores Rank Sum de cada grupo. Para que seja possível identificar entre quais grupos existem diferenças significativas, são apresentados os p-valores decorrentes dos resultados dos testes de Comparação Múltipla. O software Statistica realiza essas comparações com ajustamento de Bonferroni.

FASE QUALITATIVA

A segunda fase do estudo caracterizou-se como qualitativa. Conforme Moreira e Caleffe (2008, p. 73), esta abordagem de pesquisa “[...] explora as características dos indivíduos e cenários que não podem ser facilmente descritos numericamente. O dado é frequentemente verbal, e é coletado pela observação, descrição e gravação”. A fase qualitativa em um projeto misto sequencial explanatório objetiva auxiliar a interpretação e explicação dos resultados quantitativos iniciais (CRESWELL; PLANO CLARK, 2013; SAMPIERI; COLLADO; LUCIO, 2013).

Desenvolvimento do protocolo de entrevista

A elaboração do protocolo de entrevista utilizado partiu da observação dos resultados obtidos na fase quantitativa. Foram elaboradas questões com o intuito de compreender com maior aprofundamento o que já havia sido respondido de forma objetiva na fase quantitativa. O protocolo de entrevista foi constituído por cinco blocos de perguntas: 1 - Questões iniciais; 2 - Processo de ensino; 3 - Estratégias de ensino; 4 - Estratégias de avaliação; 5 - Aquisição de habilidades didático-pedagógicas. Neste estudo serão discutidas somente as respostas que se referem à utilização das estratégias de avaliação.

Coleta de dados

Para a coleta de dados foi utilizada a técnica de entrevista individual semiestruturada. As entrevistas foram conduzidas no segundo semestre de 2016, com 17 professores. Com a intenção de “[...] capturar as várias variações na amostra e identificar padrões comuns” (MOREIRA; CALEFFE, 2008, p. 175), uma amostra intencional de variação máxima foi utilizada para selecionar os participantes. Cada entrevista foi gravada em áudio e transcrita na íntegra.

Análise dos dados

O método comparativo constante (CHARMAZ, 2009; LEITE, 2015) foi utilizado para analisar os dados qualitativos. O método implica os seguintes passos: a) leitura e releitura das transcrições das entrevistas e das anotações; b) criação de códigos iniciais e códigos focalizados; c) redação de anotações analíticas, denominadas memorandos; d) elaboração de categorias preliminares; e) realização de amostragem teórica, saturação e classificação das categorias; f) redação das categorias de análise.

Resultados

Análise dos dados quantitativos

Informações demográficas

Os participantes do estudo foram comparados nas seguintes características demográficas: campus, sexo, tempo de atuação no ensino superior, tipo de graduação e titulação acadêmica. Os participantes típicos foram: predominantemente homens (85%), em estágio profissional docente avançado (49%), bacharéis (93%) e com o título de doutor (65%) (ver Tabela 1).

TABELA 1 Fase quantitativa da pesquisa - características da amostra

| Variável | Categoria | Frequência | |

|---|---|---|---|

| n | % | ||

| Campus | Campus 1 | 101 | 51 |

| Campus 2 | 71 | 36 | |

| Campus 3 | 27 | 13 | |

| Sexo | Feminino | 30 | 15 |

| Masculino | 169 | 85 | |

| Tempo de atuação no ensino superior | Estágio Inicial (0 a 5 anos) | 59 | 30 |

| Estágio Intermediário (6 a 12 anos) | 42 | 21 | |

| Estágio Avançado (13 anos acima) | 98 | 49 | |

| Tipo de graduação | Bacharelado | 186 | 93 |

| Tecnologia | 13 | 7 | |

| Maior titulação acadêmica | Graduação/Especialização | 12 | 6 |

| Mestrado | 57 | 29 | |

| Doutorado | 130 | 65 | |

| Total (amostra) | 199 | 100 | |

Fonte: Elaboração dos autores.

Análise de frequência dos itens da Escala de Valoração das Estratégias de Avaliação (Evea)

Na Tabela 2 são observados valores correspondentes à identificação da frequência de utilização das estratégias de avaliação.

As estratégias mais utilizadas são: “provas escritas dissertativas”, “trabalhos individuais” e “trabalhos em grupo”. As estratégias menos utilizadas são: “avaliação por portfólios”, “provas orais” e “avaliação interpares”.

TABELA 2 Estratégias de avaliação - frequência de utilização

| Item | Não se aplica | Nunca | Poucas vezes | Algumas vezes | Frequen- temente | Sempre | Ordem |

|---|---|---|---|---|---|---|---|

| Prova escrita dissertativa | 4 | 13 | 17 | 25 | 51 | 89 | 1 |

| 2% | 6% | 8% | 13% | 26% | 45% | ||

| Trabalhos individuais | 2 | 11 | 16 | 41 | 62 | 67 | 2 |

| 1% | 5% | 8% | 21% | 31% | 34% | ||

| Trabalhos em grupo | 0 | 17 | 11 | 50 | 54 | 67 | 3 |

| 0% | 8% | 6% | 25% | 27% | 34% | ||

| Prova prática | 7 | 33 | 27 | 37 | 47 | 48 | 4 |

| 3% | 16% | 14% | 19% | 24% | 24% | ||

| Prova com perguntas fechadas | 5 | 48 | 22 | 30 | 39 | 55 | 5 |

| 2% | 24% | 11% | 15% | 20% | 28% | ||

| Defesa de projetos | 5 | 42 | 16 | 47 | 46 | 43 | 6 |

| 2% | 21% | 8% | 24% | 23% | 22% | ||

| Relatório de atividades | 11 | 43 | 32 | 33 | 35 | 45 | 7 |

| 5% | 21% | 16% | 17% | 18% | 23% | ||

| Apresentação oral | 3 | 38 | 33 | 48 | 47 | 30 | 8 |

| 1% | 19% | 17% | 24% | 24% | 15% | ||

| Elaboração de vídeos, softwares, equipamentos, etc. | 16 | 81 | 31 | 26 | 27 | 18 | 9 |

| 8% | 41% | 15% | 13% | 14% | 9% | ||

| Observação dos alunos | 15 | 78 | 36 | 25 | 26 | 19 | 10 |

| 7% | 39% | 18% | 13% | 13% | 10% | ||

| Autoavaliação | 4 | 113 | 33 | 19 | 16 | 14 | 11 |

| 2% | 57% | 16% | 10% | 8% | 7% | ||

| Avaliações feitas por ambientes virtuais | 5 | 129 | 25 | 23 | 11 | 6 | 12 |

| 2% | 65% | 13% | 12% | 5% | 3% | ||

| Avaliação por portfólios | 29 | 129 | 21 | 11 | 7 | 2 | 13 |

| 15% | 65% | 11% | 5% | 3% | 1% | ||

| Provas orais | 8 | 141 | 30 | 12 | 3 | 5 | 14 |

| 4% | 71% | 15% | 6% | 1% | 3% | ||

| Avaliação interpares | 7 | 140 | 27 | 17 | 5 | 3 | 15 |

| 3% | 70% | 14% | 8% | 3% | 2% |

Fonte: Elaboração dos autores.

A Tabela 3 mostra os resultados relacionados à identificação da vinculação da aprovação/reprovação quanto ao tipo de estratégia de avaliação utilizada. Segundo os resultados obtidos, a aprovação/reprovação dos alunos dos cursos investigados, na maioria das vezes, “depende de provas e de outras estratégias de avaliação”. As variáveis “depende exclusivamente de provas” e “obtida sem provas” são me- nos utilizadas.

TABELA 3 Estratégias de avaliação utilizadas relacionadas à identificação da vinculação aprovação/reprovação - frequência por tipo

| Item | Não se aplica | Nunca | Poucas vezes | Algumas vezes | Frequen- temente | Sempre | Ordem |

|---|---|---|---|---|---|---|---|

| Depende de provas e de outros instrumentos de avaliação | 4 | 6 | 3 | 13 | 32 | 141 | 1 |

| 2% | 3% | 2% | 7% | 16% | 71% | ||

| Depende exclusivamente de provas | 6 | 108 | 36 | 15 | 26 | 8 | 2 |

| 3% | 54% | 18% | 8% | 13% | 4% | ||

| Obtida sem provas | 10 | 145 | 21 | 6 | 10 | 7 | 3 |

| 5% | 73% | 11% | 3% | 5% | 4% |

Fonte: Elaboração dos autores.

Considerando que, empiricamente, muitas vezes, atribui-se o uso de diferentes estratégias às características individuais dos professores (sexo, tempo de atuação no ensino superior, tipo de graduação e maior titulação acadêmica), também foram realizados testes estatísticos não paramétricos, que permitem inferir a percepção das “influências” de aspectos pessoais na definição das estratégias de avaliação utilizadas e da vinculação da aprovação/reprovação ao tipo de estratégia de avaliação utilizada. Os resultados nos quais foram identificadas diferenças estatisticamente significativas são apresentados nas Tabelas 4 e 5.

Em relação à variável de agrupamento “tipo de graduação” (TGRAD), pode-se observar, na Tabela 4, que, para a estratégia “avaliações feitas por meio de ambientes virtuais” (AFAVI), os resultados mostraram que os bacharéis utilizam mais tal estratégia do que os tecnólogos. Entretanto, destaca-se que os resultados mostraram que a maior parte dos professores (65%) “nunca” utiliza essa estratégia de avaliação (ver Tabela 2).

Para a variável de agrupamento “sexo”, somente a variável que avaliava se a aprovação/reprovação “depende exclusivamente de provas” (DEPRO) apresentou diferença estatisticamente significativa, mostrando que essa aprovação/reprovação é utilizada mais vezes pelo sexo masculino (Tabela 4). Entretanto, vale ressaltar que os resultados dessa variável também mostram que para a maior parte dos professores (54%) a aprovação/reprovação “nunca” depende exclusivamente de provas (ver Tabela 3).

A respeito da variável de agrupamento “tempo de atuação no magistério superior”, na Tabela 5 é possível observar diferenças significativas para duas estratégias de avaliação: “autoavaliação” (Aaval) e “entrega de trabalhos individuais” (Etind).

Os resultados para a “autoavaliação” mostram que esta tem sido mais utilizada pelos professores que se encontram em estágio avançado de carreira do que pelos que estão em início de carreira. Merece destaque, no entanto, que a maioria dos professores (57%) assinalou que “nunca” utiliza tal estratégia de avaliação (ver Tabela 2). Importante lembrar que a autoavaliação é uma das estratégias características da avaliação formativa e que objetiva ampliar, no estudante, a capacidade de “[...] avaliar seu próprio desempenho nas atividades de ensino-aprendizagem, com o intuito de desenvolver o senso de autocrítica e de responsabilidade pela aprendizagem pessoal” (MENEZES et al., 2019, p. 32).

A respeito da estratégia “entrega de trabalhos individuais”, os resultados também mostram que esta é mais utilizada por professores em estágio inicial de carreira (1) do que por professores em estágio avançado (3). Também houve diferença significativa entre o grupo de professores em estágio inicial (1) e em estágio intermediá- rio (2). Novamente, o grupo de professores em estágio inicial é o que mais utiliza essa estratégia.

A variável de agrupamento “maior titulação acadêmica” não apresentou diferenças estatísticas significativas para nenhuma das variáveis de teste investigadas.

TABELA 4 Valores do teste Mann-Whitney das estratégias de avaliação que apresentaram diferenças estatisticamente significantes no nível 0,05

| Variável (de) | U | p-valor | Rank Sum | ||

|---|---|---|---|---|---|

| Agrupamento | teste | (Z adjusted) | |||

| TGRAD | AFAVI | 839,5 | 0,03074 | Bacharelado (n = 186) | Tecnologia (n = 13) |

| 18.230,5 | 1.669,5 | ||||

| SEXO | DEPRO | 2011 | 0,048274 | Feminino (n = 30) | Masculino (n = 169) |

| 2.476 | 17.424 | ||||

Fonte: Elaboração dos autores.

TABELA 5 Valores do teste Kruskal-Wallis das estratégias de avaliação que apresentaram diferenças estatisticamente significantes no nível 0,05

| Variável de Agrupamento - Tempo de atuação no ensino superior | ||||||||

|---|---|---|---|---|---|---|---|---|

| Variável de teste | H | p-valor | Rank Sum | Comparações Múltiplas | ||||

| Est. Inicial (1) (n=59) |

Est. Intermediário (2) (n=42) | Est. Avançado (3) (n=98) | 1 e 2 | 1 e 3 | 2 e 3 | |||

| AAVAL | 10,36552 | 0,0056 | 4.877 | 4.227,5 | 1.0795,5 | 0,365151 | 0,011284 | 1 |

| ETIND | 13,7194 | 0,001 | 7.173,5 | 3.526,5 | 9.200 | 0,003641 | 0,010513 | 1 |

Fonte: Elaboração dos autores.

Em resumo, quanto à influência dos aspectos individuais (sexo, tipo de graduação, tempo de atuação no ensino superior ou maior titulação acadêmica) na utilização de estratégias de avaliação ou na vinculação da aprovação/reprovação aos tipos de avaliação utilizados, os resultados mostraram que a maioria não sofreu influência estatisticamente significativa e que, das que sofreram, a maior parte obteve médias que mostram que “nunca” são utilizadas pela maioria dos professores. Somente a estratégia “entrega de trabalhos individuais” obteve média que indica que é utilizada “frequentemente” ou “sempre”.

Análise dos resultados qualitativos

Os principais resultados da fase qualitativa do estudo relacionados às estratégias de avaliação são apresentados a seguir. Os participantes da fase qualitativa foram 17 professores selecionados intencionalmente. A Tabela 6 mostra as características demográficas da amostra.

TABELA 6 Fase qualitativa da pesquisa - características da amostra

| Variável | Categoria | Frequência | |

|---|---|---|---|

| n | % | ||

| Campus | Campus 1 | 9 | 53 |

| Campus 2 | 5 | 29 | |

| Campus 3 | 3 | 18 | |

| Sexo | Feminino | 4 | 24 |

| Masculino | 13 | 76 | |

| Tempo de atuação no ensino superior | Estágio Inicial (0 a 5 anos) | 5 | 29 |

| Estágio Intermediário (6 a 12 anos) | 5 | 29 | |

| Estágio Avançado (13 anos acima) | 7 | 42 | |

| Tipo de graduação | Bacharelado | 16 | 94 |

| Tecnologia | 1 | 6 | |

| Maior titulação acadêmica | Graduação/Especialização | 3 | 18 |

| Mestrado | 2 | 12 | |

| Doutorado | 12 | 70 | |

| Total (amostra) | 17 | 100 | |

Fonte: Elaboração dos autores.

Os principais achados qualitativos apresentados neste artigo dizem respeito à identificação das estratégias de avaliação mais utilizadas e a aproximações e distanciamentos entre as perspectivas tradicional e formativa de avaliação, já discutidas na revisão de literatura.

Para a identificação dos entrevistados, utilizou-se o código E (entrevistado), seguido de um número de 1 a 17, de acordo com a ordem cronológica de realização das entrevistas.

Para entender como, efetivamente, a avaliação dos alunos é realizada, perguntamos aos entrevistados: “quais as estratégias que vocês mais utilizam para avaliar o rendimento acadêmico dos alunos?”. Dezesseis (16) professores relataram que utilizam provas escritas e trabalhos. Esses resultados coincidem com os obtidos na fase quantitativa do estudo.

Na sequência, a fim de aprofundar questões identificadas na fase quantitativa, foi solicitada aos professores uma descrição detalhada da utilização dessas estratégias de avaliação em suas práticas cotidianas.

Ao interpretar os relatos, foi possível identificar que a aplicação de provas visa a verificar o desenvolvimento do raciocínio e da capacidade de aplicação de conceitos adquiridos nas diversas disciplinas para resolver problemas. O relato da E5 exemplifica isso: “Nas provas eu coloco exercícios que, para resolver, os alunos têm que pensar, não só aplicar a fórmula. Se fosse só isso, usava o computador” (E5, engenheira civil).

O relato apresentado demonstra a intenção da professora, por meio de provas, de verificar o desenvolvimento de aspectos cognitivos superiores (análise, estabelecimento de relações, resolução de problemas). Isso sugere que os professores buscam realizar uma prática avaliativa em que a capacidade de memorização não é o principal aspecto a ser avaliado, indo além da perspectiva tradicional da avaliação.

Dos dezessete (17) professores entrevistados, somente um (1) relatou que não utiliza provas em suas avaliações. Ao descrever o motivo de não utilizar provas, o E6 (engenheiro eletricista) considerou que “[...] as provas são avaliações muito pontuais e podem não refletir os conhecimentos dos alunos”, e, por esse motivo, solicita diferentes trabalhos durante o semestre letivo.

Em relação à solicitação de “trabalhos”, é importante esclarecer que esse foi um termo utilizado pelos dezessete (17) professores entrevistados para se referirem a diferentes produções dos alunos, tais como “defesa de projetos”; “elaboração de vídeos, softwares, equipamentos, etc.”; “relatórios de atividades”; “apresentações orais”, estratégias elencadas na primeira fase do estudo, além de outras, como a resolução de listas de exercícios; elaboração de textos, como resenhas e sínteses; organização de eventos; e participação em debates. Um exemplo de trabalho solicitado aos alunos é mencionado no relato do E2.

A ideia é que os alunos “botem a mão na massa”, então eles vão observar caldeiras. Tem um operador que cuida. Então os alunos vão lá, conversam com o operador, veem como é que funciona, verificam a instalação da caldeira, tubo, distribuição do vapor. Fazem uma listagem de equipamentos existentes, com especificações, analisam, e, se tiver algum problema, elaboram possíveis propostas de solução. Aí o que eu solicito a eles: memorial de visitas, dados, equipamentos, documentação fotográfica, análise realizada, como se fosse um relatório. Eu não estou pedindo uma bíblia. Um relatório técnico. (E2, engenheiro mecânico).

Os relatos dos professores também evidenciam que os trabalhos solicitados aos alunos têm a intenção de permitir a verificação da capacidade dos estudantes de identificar, interpretar e aplicar conhecimentos à solução de problemas, envolvendo-os em situações em que é necessário mais do que a capacidade de reproduzir conhecimentos, o que demonstra que os professores têm objetivos que diferem do que é entendido como uma avaliação tradicional.

Além da descrição de como eram realizadas as “provas” e “trabalhos”, também foi solicitado aos professores que explicassem como eram realizadas as “provas práticas”, tendo em vista que 48% dos participantes do estudo relataram que utilizavam essa estratégia “frequentemente” ou “sempre”. As respostas revelaram diferentes formas de entendimento a respeito dessa estratégia.

Apesar de nove (9) professores afirmarem que utilizam “provas práticas”, e oito (8) que não as utilizam, enquanto para alguns professores essa estratégia consiste em avaliações realizadas em laboratórios, com a utilização de equipamentos, para outros, provas escritas que envolvem a resolução de cálculos também são consideradas “provas práticas”. Diferentes formas de entender essa estratégia são exemplificadas nos relatos do E7 e da E14:

Eu posso explicar tecnicamente. Eu dou um sinal num arquivo .txt, um sinal eletrônico e peço para os alunos modelarem um sistema. Então eu dou o arquivo, eles abrem no computador e têm que usar uma ferramenta específica para levantar o modelo matemático disso e fazer a sintonia do controlador que eu também dou. É como se eles estivessem diante de uma planta real, só que estão numa simulação. (E7, engenheiro eletrônico).

Como prova prática eu entendo a avaliação da parte da disciplina que envolve cálculo e também a parte da disciplina que é realizada no laboratório. (E14, engenheira civil).

Fica evidente na fala dos professores a falta de consenso em relação ao conceito de “provas práticas”, apesar de esta ser uma estratégia presente no cotidiano da docência no ensino superior.

Em relação a “autoavaliação”, “avaliação interpares” (características da avaliação formativa), “avaliações feitas por meio de ambientes virtuais”, “observação dos alunos”, “portfólios” e “provas orais” (estratégias também discutidas na fase quantitativa do estudo), as respostas mostraram que os professores não as conhecem, que têm um entendimento equivocado sobre elas ou, ainda, que não dominam os recursos necessários para sua utilização. O relato do E9, que trata da utilização da avaliação por meios informatizados, exemplifica a compreensão dos professores sobre essas estratégias.

Nunca usei, nunca usei. O curso do Moodle que eu fiz, eu não consegui colocar em prática. Já tentei. Não deu “liga” porque me dava tanto trabalho para organizar, que eu acabei abandonando. Nos cursos que eu já fiz sobre Moodle, volta e meia eu me perdia naqueles comandos (riso). (E9, licenciado em Física).

Atitudes como a relatada por E9 exemplificam o distanciamento de alguns professores dos recursos tecnológicos que, apesar de disponíveis, nem sempre são considerados por eles como adequados à prática avaliativa.

A fim de identificar se a aprovação do aluno depende mais das avaliações rea- lizadas por meio de provas ou de trabalhos, perguntamos também aos professores: “que valor atribuíam às provas e aos trabalhos?” Dos dezessete (17) professores, nove (9) relataram que atribuíam às provas, na nota final, um valor igual ou menor que aos trabalhos. Isso é exemplificado no relato do E1.

Depende muito do caso, mas geralmente o valor que eu atribuo para a prova é de 40% a 50% da média final. Eu valorizo bastante a questão do trabalho que é feito, do relatório que é entregue. (E1, engenheiro cartógrafo).

O maior valor dado aos trabalhos solicitados foi justificado pelos professores pela necessidade de valorizar o envolvimento dos alunos em atividades que se assemelham às da prática do profissional de engenharia.

A partir de uma perspectiva diferente, oito (8) dos professores entrevistados relataram que atribuem um percentual maior da média às provas. Os motivos apontados para isso foram as características da disciplina e o fato de que, quando os alunos fazem trabalhos, tendem a copiar uns dos outros. Exemplos dessas opiniões foram relatados pela E5 e pelo E10:

Eu faço três provas escritas, individuais, em que os alunos têm que resolver exercícios. Porque eu ainda não vi como avaliar a evolução na minha disciplina sem ser assim. É difícil. (E5, engenheira civil).

Eu estava atribuindo 10% da nota para a lista de exercícios, mas às vezes uns alunos fazem no dia. Copiam tudo de outro colega no dia da entrega. Então eu comecei a baixar os valores da lista de exercício. Atribuí 5% da nota ali. E para as provas eu atribuo os outros 95%. (E10, engenheiro químico).

Para Bazzo, Pereira e Linsingen (2000), no ensino de engenharia as avaliações são quase que exclusivamente centradas em provas, sendo muito pouco valorizadas outras formas de avaliação. Contudo, é possível afirmar que, na amostra investigada, existe equilíbrio entre a utilização das provas e de outras estratégias de avaliação.

A fim de identificar se os professores conheciam a proposta de avaliação formativa, perguntamos a eles se conheciam o termo “avaliação formativa”. Os 17 professores responderam que não conheciam o termo.

Considerando que muitas vezes os professores podem desconhecer terminologias utilizadas na área pedagógica, com a intenção de averiguar se o processo avaliativo desenvolvido pelos professores se identifica com a avaliação formativa, perguntamos se algum tipo de feedback, além da divulgação das notas, era fornecido aos alunos. Quinze (15) dos dezessete (17) professores entrevistados revelaram que, com a intenção de melhorar o processo de ensino-aprendizagem, procuram informar os alunos sobre conteúdos que precisam ser reforçados, condutas que devem ser revistas, entre outras orientações.

Esses feedbacks são realizados de diversas formas: a) a disponibilização periódica das notas, seguida de orientações individuais; b) correção de provas e/ou trabalhos em sala de aula ou anotações no texto da prova ou dos trabalhos; c) orientações coletivas em sala de aula, a respeito do rendimento da turma; d) orientações reali- zadas durante o desenvolvimento de projetos ou apresentações orais; e e) orientações prestadas em horários extraclasse. Exemplos de feedback prestados aos alunos podem ser observados nas falas do E2 e da E12:

Então, o aluno vem [para orientações na sala do professor] uma vez, duas vezes, três vezes, vem quatro vezes, até que ele fez da forma correta, com tudo aquilo que vão exigir dele como engenheiro. (E2, engenheiro mecânico).

É, eu sempre estou fazendo feedbacks, comentando. Quando a gente conversa sobre temas anteriores, quando eu lanço uma questão e fica aquele silêncio, fica aquele clima, ou quando eu lanço uma pergunta e fica aquele silêncio. Aí eu já dou o meu feedback. Eu digo: “Pessoal, não é só prova. Vocês não podem ficar nesse vácuo. Esses conceitos não são só para aquele dia. Esses conceitos são importantes. Vamos retomar”. Daí dou uma chacoalhada. E, se não sai nada, eu volto naquele conceito. (E12, economista).

Considerando que a avaliação formativa não se resume ao fornecimento de informações ao aluno pelo professor, mas também envolve a participação do aluno fornecendo informações que possam contribuir para a reorganização do processo de ensino-aprendizagem, perguntamos ainda aos professores se os alunos, de alguma maneira, se envolviam na definição do processo de ensino desenvolvido. Sobre isso os dezessete (17) professores responderam que as participações dos alunos são eventuais, no decorrer do semestre letivo, e se resumem geralmente a sugestões e solicitações a respeito de prazos de entrega de trabalhos e realização de provas.

A análise dos relatos deixa evidente que, apesar de os professores proporcionarem feedbacks aos alunos com o intuito de modificar a compreensão ou o comportamento e de melhorar a aprendizagem, isso não é suficiente para afirmar que eles utilizam a avaliação formativa, conforme os pressupostos discutidos na revisão de literatura. Para uma prática efetiva de avaliação formativa, seria necessária uma organização proposital por parte do professor que enfatizasse a participação e o autoconhecimento dos alunos no que diz respeito à própria aprendizagem. Essas ações, contudo, não foram identificadas nos relatos dos entrevistados.

A INTEGRAÇÃO DOS RESULTADOS QUANTITATIVOS E QUALITATIVOS

O questionário aplicado na primeira fase do estudo (quantitativa) possibilitou identificar as estratégias de avaliação mais utilizadas pelos professores: as “provas escritas dissertativas”, os “trabalhos individuais” e os “trabalhos em grupo”. Entretanto, quanto aos “trabalhos”, a fase qualitativa propiciou o esclarecimento de que esse termo equivale a estratégias como “defesa de projetos”; “elaboração de vídeos, softwares, equipamentos”; “relatórios de atividades”; “apresentações orais”, entre outras.

A fase qualitativa também permitiu identificar que os professores buscam, por meio das provas escritas dissertativas e dos trabalhos, a verificação de aspectos cognitivos superiores, como a capacidade de buscar informações, interpretar e resolver problemas. Nesse sentido, o processo de avaliação se afasta dos pressupostos de uma metodologia de avaliação tradicional.

A respeito das “provas práticas”, os resultados quantitativos mostraram que 48% dos participantes do estudo utilizam essa estratégia frequentemente ou sempre. Contudo, os resultados qualitativos deixam evidente a falta de consenso, apontando diferentes formas de compreensão dos professores sobre essa estratégia.

Em relação à composição da nota final e ao valor atribuído a provas e trabalhos, os resultados do estudo também sugerem distanciamento da metodologia de avaliação tradicional. Os dados quantitativos mostram que, para 71% dos professores, a aprovação/reprovação dos alunos depende, na maioria das vezes, de provas e de outras estratégias de avaliação. Os achados qualitativos confirmam esse resultado e mostram que a maioria dos professores (16) utiliza provas e trabalhos na composição da nota final.

A fase qualitativa do estudo também evidenciou que o processo de avaliação é centrado no professor, sendo a participação dos alunos limitada a aspectos pontuais, como a negociação de datas; que os professores não compreendem o significado de uma “avaliação formativa” e que não conhecem as estratégias dessa proposta. Nesse sentido, os resultados das duas fases convergem, tendo em vista que na fase quantitativa as estratégias relacionadas à avaliação formativa (autoavaliação e avaliação interpares) estão entre as menos utilizadas.

CONSIDERAÇÕES FINAIS

O objetivo deste artigo foi analisar como acontece a avaliação de desempenho dos acadêmicos na formação de engenheiros. Quanto à utilização de estratégias de avaliação, os relatos mostram que prevalecem as provas dissertativas, sendo pouco utilizadas a autoavaliação, a avaliação por ambientes virtuais, os portfólios, as provas orais ou avaliações interpares.

Quanto aos objetivos da avaliação, os relatos mostram o interesse dos participantes, por meio das avaliações, de verificar aspectos cognitivos superiores, como a capacidade de análise e de resolução de problemas. O fato de haver equilíbrio entre o valor atribuído às provas e aos trabalhos, e também de os trabalhos solicitados não se limitarem ao pedido de transcrições, mas à mobilização de diferentes capacidades como o desenvolvimento da oralidade, da capacidade de observação, de síntese, da criatividade, da capacidade de trabalhar em equipe, deve ser considerado positivo, pois revela um avanço em direção à superação da proposta tradicional da avaliação.

Em relação à condução do processo de avaliação, os resultados mostram que ele é centrado no professor, com pequenas participações dos alunos, seguindo principalmente a lógica somativa de avaliação. Nesse sentido os resultados se assemelham aos observados por Fernandes (2016) e Barreira et al. (2017), que identificaram a predominância de uma avaliação essencialmente centrada no professor, orientada para classificar e/ou certificar.

A respeito da avaliação formativa, o conjunto de resultados das duas fases evidencia que os professores não conhecem a proposta, não utilizam a autoavaliação e a avaliação interpares, apesar de relatarem que muitas vezes utilizam diferentes formas de feedback. Esses resultados coincidem com os relatados por Barreira et al. (2017) em estudo realizado em quatro universidades portuguesas, com 4.972 alunos e 1.013 estudantes no âmbito do projeto Avaliação, Ensino e Aprendizagens no Ensino Superior em Portugal e no Brasil: Realidades e Perspectivas (Avena).

No tocante à influência das características individuais dos professores na utilização das estratégias de avaliação ou da vinculação da aprovação/reprovação aos tipos de estratégia utilizados, os resultados mostram que o sexo, o tipo de graduação e o tempo de atuação no ensino superior e a maior titulação não exerce- ram influência sobre a definição de utilização da maior parte das variáveis de teste investigadas.

Em conjunto, os resultados revelam detalhes dos processos de avaliação que permitem identificar que os professores diversificam as estratégias de avaliação utilizadas e que no processo de avaliação buscam verificar aspectos cognitivos superiores, além da capacidade de memorização e repetição. Apesar disso, o processo de avaliação é centrado no professor e não corresponde a conhecimentos pautados em discussões atuais da área da didática do ensino superior e de ensino de engenharia.

Finalmente, em relação ao delineamento de estudo adotado, o conjunto de resultados deixa evidente que estudos somente quantitativos ou qualitativos não seriam suficientes. Os resultados se complementam, possibilitando a obtenção de novas interpretações a respeito da utilização de estratégias de avaliação no ensino superior.