INTRODUÇÃO

O pensamento computacional (PC) vem sendo estudado nos últimos anos sob diferentes perspectivas, e várias iniciativas têm surgido no intuito de implementar o PC em currículos escolares de diversos países. No entanto, a comunidade científica ainda não adotou uma definição formal congruente para o PC.

Nos últimos anos, o PC vem sendo apresentado como um conjunto de habilidades para solução de problemas que deve ser desenvolvido pelas novas gerações de estudantes (BOCCONI et al., 2016), uma percepção já defendida na década de 1970 por Papert (1971). Jeanette Wing (2006) afirmou que o PC envolve a solução de problemas, o design de sistemas e a compreensão do comportamento humano, baseando-se nos conceitos fundamentais da ciência da computação. Desde então, apesar de os especialistas concordarem a respeito da relevância do desenvolvimento do PC para a formação do indivíduo, sua definição ainda não é consenso entre os pesquisadores da área (KALELIOGLU; GÜLBAHAR; KUKUL, 2016). A partir de todas essas discussões, neste artigo é adotada a definição de pensamento computacional como sendo uma extensão da capacidade humana de resolução de problemas, que se fundamenta nos conceitos e práticas relacionados à construção, ao uso e à avaliação de algoritmos, no reconhecimento de padrões, na decomposição de problemas e na abstração.

Com a popularização do termo “pensamento computacional”, as discussões sobre a maneira de introduzi-lo na educação básica se ampliaram. Segundo Raabe, Zorzo e Blikstein (2020), diversas iniciativas de introdução ao PC têm sido realizadas nos últimos anos, envolvendo pesquisadores de escolas e universidades em diferentes níveis educacionais. Para implementar com êxito o ensino de PC nas escolas, no entanto, é imprescindível projetar instrumentos e métodos de avaliação adequados para diagnosticar e acompanhar o desempenho dos estudantes (KONG; ABELSON; LAI, 2019). A validação de instrumentos de avaliação do PC é extremamente relevante e urgente porque, sem ferramentas de avaliação confiáveis e válidas, o PC pode perder seu potencial de ingressar nos currículos educacionais (ROMÁN-GONZÁLEZ; PÉREZ-GONZÁLEZ; JIMÉNEZ-FERNÁNDEZ, 2017).

Nos Estados Unidos, a Computer Science Teachers Association (CSTA) e a International Society for Technology in Education (ISTE) trabalharam de forma colaborativa para desenvolver materiais que possam auxiliar professores no ensino do PC. Apresentaram, então, uma definição operacional do PC com os seguintes conceitos computacionais: coleta, análise e representação de dados; decomposição de problemas; abstração; algoritmos e procedimentos; automação; simulação e paralelismo (INTERNATIONAL SOCIETY FOR TECHNOLOGY IN EDUCATION - ISTE; COMPUTER SCIENCE TEACHERS ASSOCIATION - CSTA, 2011). Os conceitos apresentados representam características que um indivíduo deve demonstrar no processo de resolução de problemas. Brackmann (2017) apresenta uma pesquisa em que aponta organizações que são referência em computação no mundo, e estas concordam com a definição de quatro conceitos fundamentais considerados pilares para o PC:

Decomposição: quebrar um problema ou sistema complexo em partes menores e mais propensas a serem solucionadas.

Reconhecimento de padrão: procurar similaridades entre problemas, assim como dentro deles.

Abstração: foco nas informações importantes, ignorando as irrelevantes.

Algoritmos: desenvolver um conjunto de passos para a solução de um problema, ou regras para solucionar um problema.

O mesmo autor afirma que o PC é assimilado no dia a dia das pessoas, ainda que sua presença nem sempre seja percebida. Nesse sentido, desenvolver os pilares do PC durante a educação básica pode auxiliar na atitude do indivíduo ao se deparar com um problema. Ainda de acordo com Brackmann (2017), o PC é uma habilidade que qualquer pessoa deve ter, independentemente de sua área de conhecimento ou da atividade profissional.

Nas escolas básicas, a maioria das abordagens de desenvolvimento dos pilares do PC adota o ensino de programação, seja em disciplinas específicas do currículo escolar, seja por atividades extracurriculares, workshops ou minicursos. Para avaliar os pilares do PC desenvolvidos por essas abordagens, são utilizados instrumentos que realizam uma avaliação fechada por meio da análise estática de projetos desenvolvidos pelos estudantes, como o Dr. Scratch (MORENO-LEÓN; ROBLES; ROMÁN- -GONZÁLEZ, 2015), Progression of Early Computational Thinking (PECT) (SEITER; FOREMAN, 2013), CodeMaster (WANGENHEIM et al., 2018) e Quizly (MAIORANA; GIORDANO; MORELLI, 2015), entre outros. Esse tipo de avaliação apresenta algumas limitações. Para desenvolver seus projetos, os estudantes precisam de conhecimento prévio do ambiente ou da linguagem utilizada, com todas as particularidades técnicas. Além disso, esses instrumentos geralmente atuam no código-fonte dos projetos para avaliar o desempenho, normalmente somente depois de o estudante terminar o trabalho.

Outras iniciativas utilizam instrumentos na forma de questionários de múltipla escolha, como o Commutative Assessment Test (WEINTROP; WILENSKY, 2015), o Test for Measuring Basic Programming Abilities (MÜHLING; RUF; HUBWIESER, 2015), o Israel’s Nationwide Exam (ZUR-BARGURY; PÂRV; LANZBERG, 2013) e o Bebras Tasks (DAGIENE; FUTSCHEK, 2008). Esse tipo de teste pontua somente as respostas dos estudantes a questões previamente definidas, sem avaliar o processo cognitivo necessário para a resolução de cada atividade.

Uma abordagem mais abrangente do que essas metodologias fechadas é a utilização de puzzles, um método de ensino baseado em projetos e problemas que desenvolve o pensamento crítico e o raciocínio lógico, independentemente de um domínio específico (FALKNER; SOORIAMURTHI; MICHALEWICZ, 2010; MERRICK, 2010; MICHALEWICZ; MICHALEWICZ, 2008). A pesquisa na literatura não apresentou instrumentos de avaliação do PC que utilizassem essa abordagem.

A abordagem de aprendizado baseada em puzzles (puzzle-based learning - PBL), segundo Falkner, Sooriamurthi e Michalewicz (2010), tem o objetivo de incentivar os estudantes a pensar em como conceber e resolver problemas não estruturados (aqueles que não são encontrados ao final de um capítulo de livro). O objetivo é motivá-los e aumentar a consciência matemática e as habilidades de resolução de problemas, induzindo-os a discutir estratégias de solução. De acordo com os mesmos autores, essa abordagem deve satisfazer alguns critérios:

Independência de contexto: puzzles educacionais não devem estar especificamente vinculados a um único domínio de solução de problemas.

Generalidade: puzzles educacionais desenvolvem princípios universais de solução de problemas, ou seja, o treinamento da habilidade de resolução de problemas deve permitir ao estudante resolver problemas ainda desconhecidos no futuro.

Simplicidade: puzzles educacionais devem ser fáceis de declarar e lembrar, pois isso aumenta a probabilidade de os alunos se lembrarem do método de solução para aplicar em outros problemas no futuro.

Fator eureka: puzzles educacionais devem inicialmente frustrar o solucionador de problemas, mas manter a promessa de resolução. Os solucionadores de problemas geralmente usam a intuição para iniciar sua busca pela solução e, eventualmente, alcançam um “momento eureka” - quando reconhecem o caminho correto para resolver o puzzle e experimentam uma sensação de recompensa por sua esperteza.

Fator de entretenimento: puzzles educacionais devem ser divertidos e envolventes. O entretenimento costuma ser resultado da combinação da simplicidade, frustração, fator eureka e um cenário interessante, com algum contexto lúdico.

A abordagem por puzzles desenvolve habilidades de pensamento crítico e resolução de problemas, além de estabelecer uma conexão entre a capacidade de resolver puzzles e a capacidade de resolver problemas do mundo real. Muitos problemas do mundo real podem ser percebidos como puzzles em grande escala, pois, ao se deparar com um problema no trabalho ou no cotidiano, o indivíduo deve elaborar hipóteses e testar estratégias para resolvê-lo. Nessa perspectiva, ao analisar um questionário objetivo, os estudantes deveriam ter a possibilidade de testar respostas com base em hipóteses experimentadas, ao invés de ter apenas uma chance de acerto que pune uma tentativa sem sucesso.

Nesse contexto, torna-se relevante a proposição de um método eficiente de avaliação do PC baseado em puzzles. A validação de diferentes métodos de avaliação e medição implicam definir operacionalmente o PC como construto. Portanto, avanços na avaliação contribuem para a consolidação do PC como um conceito sólido, pertinente a ser estudado e desenvolvido. A validade refere-se ao fato de um instrumento medir exatamente o que se propõe a medir (ROBERTS; PRIEST; TRAYNOR, 2006; PASQUALI, 2017). Rodrigues (2006) argumenta que deve haver um cuidado para que o teste inclua itens que cubram tão somente o conteúdo a ser avaliado e que revele os processos usados pelo educando para fazê-lo.

O presente artigo apresenta uma etapa de aprimoramento do Computational Thinking Puzzle Test - CT Puzzle Test (GONÇALVES, 2015; COUTO, 2018). Os diferenciais desse instrumento com relação aos instrumentos já existentes residem na avaliação por meio de puzzles, que estimulam o raciocínio lógico e o pensamento crítico, e se caracterizam pela independência de domínio e conhecimento prévio. O CT Puzzle Test avalia o PC por meio da captura das interações do estudante com o instrumento (número de tentativas, quantidade de cliques, tempo de resolução, quantidade de dicas utilizadas, etc.). A partir dessas interações, é realizado o diagnóstico sobre o desenvolvimento do PC no estudante, considerando suas tentativas, erros e acertos até chegar a uma resposta correta. Este trabalho apresenta a constituição de um modelo para análise dos dados de aplicação do CT Puzzle Test a partir da comparação com os resultados do teste Computational Thinking Test - CTt - (ROMÁN-GONZÁLEZ, 2015) em relação aos quatro pilares definidores do PC (Brackman, 2017). A pesquisa ora relatada investiga evidências da validade convergente entre o CT Puzzle Test e o CTt. As motivações em constatar essas evidências foram reafirmar a eficácia do CT Puzzle Test em avaliar o PC e demonstrar que os itens no formato de puzzles e a contemplação da experimentação e teste de hipóteses por meio da captura das interações do estudante com o instrumento constituem uma abordagem válida. Os resultados devem corroborar que o CT Puzzle Test converge com o CTt, que é um teste já em estado avançado de validação.

BACKGROUND - AVALIAÇÃO DO PENSAMENTO COMPUTACIONAL

Ainda não há consenso sobre quais processos de pensamento específicos fazem parte do PC. Muitos autores apontam processos, habilidades e características que o indivíduo deve ter, mas falta um delineamento para se afirmar em que ponto o PC é ciência da computação ou uma habilidade matemática e/ou lógica. Por esse motivo existe a dificuldade no desenvolvimento de um instrumento de avaliação que possa ser utilizado de forma abrangente para medir o desenvolvimento do PC de um indivíduo.

O ensino do PC na educação básica tem recebido atenção em vários países. Muitas das iniciativas existentes utilizam o ensino de programação como ferramenta de apoio ao desenvolvimento dos pilares do PC. Nesse contexto, normalmente são adotadas linguagens de programação baseadas em blocos visuais, como Scratch (https://scratch.mit.edu), Snap! (http://snap.berkeley.edu), App Inventor (http://appinventor.mit.edu/explore), entre outras. Existem, porém, poucas iniciativas para avaliar os pilares do PC no contexto da educação básica (WANGENHEIM et al., 2018). Na maioria dos casos, a avaliação se dá por meio de tarefas de programação usando indicadores relacionados à verificação de assertividade e eficiência de código (SRIKANT; AGGARWAL, 2014; SMITH; CORDOVA, 2005) e/ou estilo de programação (SMITH; CORDOVA, 2005).

Alguns instrumentos de avaliação são adotados na forma de extensões das linguagens de programação, avaliando o código escrito pelo estudante. Alguns exemplos para a linguagem Scratch são o Dr. Scratch (MORENO-LEÓN; ROBLES; ROMÁN-GONZÁLEZ, 2015) ou o Ninja Code Village (OTA; MORIMOTO; KATO, 2016). Essas ferramentas adotam análise de código estático e avaliam tipo e número de blocos usados no programa, quantificando conceitos e práticas de PC, como abstração, lógica, fluxo de controle, etc. Outras ferramentas avaliam projetos de programação em outras linguagens baseadas em blocos, como o Snap! Autograder (BALL; GARCIA, 2016) ou App Inventor Quizly (MAIORANA; GIORDANO; MORELLI, 2015). O foco da maioria dessas abordagens está na avaliação de problemas fechados, com uma solução correta previamente conhecida. Esse tipo de avaliação apresenta algumas limitações, em primeiro lugar, porque as ferramentas geralmente funcionam no código-fonte, normalmente somente depois de o aluno finalizar a atividade. Esse foco no código-fonte também limita a avaliação, de forma que não cobre práticas essenciais do PC, como criatividade e colaboração, e em alguns casos não fornece suporte imediato para o estudante acompanhar seu desempenho durante a resolução das atividades (ROBLES et al., 2018). Em segundo lugar, porque o estudante precisa de treinamento no ambiente de programação adotado, fundamentação técnica e familiaridade com a linguagem utilizada, conhecimentos prévios que são neces- sários para o acesso à avaliação do PC que influenciam no desempenho do estudante que realiza os testes.

Román-González, Moreno-León e Robles (2019) fazem uma análise dos instrumentos de avaliação do PC conforme sua abordagem avaliativa, e os classifica em sete modalidades:

Instrumentos de diagnóstico: visam a medir o nível de aptidão para o PC do sujeito. Podem ser administrados em condição de pré-teste em indivíduos sem nenhuma experiência prévia em programação, e também na condição pós-teste, após uma intervenção educacional, para verificar se a aptidão para o PC foi desenvolvida.

Instrumentos sumativos: aplicados depois de o indivíduo ser exposto a conteúdo e treinamento. Seu principal uso é na condição pós-teste e está vinculado ao ambiente de aprendizado utilizado (linguagem de programação ou conteúdo administrado).

Instrumentos formativo-iterativos: visam a fornecer feedback imediato ao estudante, geralmente de maneira automática, a fim de desenvolver e melhorar suas habilidades. Essas ferramentas não avaliam os indivíduos, mas seus produtos de aprendizado, geralmente projetos de programação. Portanto, essas ferramentas são usadas principalmente durante o processo de aprendizado e são projetadas para um ambiente de programação específico.

Instrumentos de mineração de dados: focados no processo de aprendizado, recuperam e registram a atividade do estudante durante a execução de uma tarefa. Fornecem dados e análises de aprendizado a partir dos quais os processos cognitivos do sujeito podem ser inferidos.

Instrumentos de transferência de habilidades: seu objetivo é avaliar até que ponto os estudantes são capazes de transferir suas habilidades de PC para diferentes tipos de problemas, contextos e situações. Normalmente são avaliações textuais compostas de perguntas relacionadas a contextos do mundo real, e o sujeito deve utilizar conceitos do PC para respondê-las corretamente.

Escalas de percepções e atitudes do PC: visam a avaliar as percepções (por exemplo, de autoeficácia) e atitudes dos sujeitos, não apenas sobre o PC, mas também acerca de questões relacionadas, como computadores, ciência da computação, programação de computadores ou mesmo alfabetização digital.

Avaliação de vocabulário de PC: essas ferramentas pretendem medir vários elementos e dimensões do PC, quando expressas verbalmente pelos sujeitos.

No Brasil, observam-se algumas iniciativas de inclusão do PC no currículo escolar. Rodriguez, Reis e Isotani (2017) apresentam o projeto “Computação e Criatividade: criando jogos digitais usando o Scratch”. O projeto levou estudantes de escolas públicas ao laboratório com o objetivo de estimular o raciocínio lógico para a resolução de problemas por meio da programação de jogos digitais utilizando a ferramenta Scratch. Araujo, Primo e Pernas (2020) adotaram a ferramenta Dr. Scratch para realizar uma avaliação automatizada de projetos em Scratch. A partir dos resultados dessa ferramenta, os autores desenvolveram o OntoScratch, uma representação de conhecimento baseada em ontologias. Esse método permite o acompanhamento da evolução do estudante, por meio da execução de análises temporais e da utilização de modelos de inferência.

França e Silva (2020) identificaram critérios pragmáticos para evidenciar as habilidades de PC. Por meio de uma síntese qualitativa dos resultados da pesquisa, apontaram um conjunto de 16 critérios de avaliação para cada uma das dimensões do PC. Raabe et al. (2017) desenvolveram o CT Puzzle Test, um instrumento de diagnóstico do PC. O instrumento dos autores foca nos elementos constituintes do pensamento computacional, os quais são mensurados pelo desempenho do estudante em atividades de resolução de problemas, planejadas para que não sejam neces- sários conhecimentos prévios de conceitos computacionais.

O esforço brasileiro pelo desenvolvimento de uma metodologia confiável de avaliação do PC também é evidenciado em trabalhos multinacionais envolvendo pesquisadores brasileiros como Brackmann et al. (2017). Os autores apontam melhoria significativa no desempenho de estudantes que vivenciaram atividades de pensamento computacional desplugado e utilizam o instrumento Computational Thinking Test como forma de avaliar comparativamente grupos de estudantes em uma abordagem quase-experimental. Cordenonzi, Del Pino e Cardoso (2021) utilizaram um modelo de referência de pensamento computacional e um método de avaliação. A partir desse método foi possível classificar os sujeitos em: (I) alfabetizados em código; ou (II) pensador computacional desplugado. A abordagem foi validada em uma turma de 20 estudantes brasileiros e uruguaios que participaram de um curso de 20 horas sobre o tema.

Vários pesquisadores têm conduzido revisões sistemáticas da literatura para investigar formas de avaliação do PC. O Quadro 1 sintetiza os instrumentos investigados em três pesquisas (COUTO, 2018; WANGENHEIM et al., 2018; ROMÁN- -GONZÁLEZ; MORENO-LEÓN; ROBLES, 2019):

QUADRO 1 Levantamento de instrumentos de avaliação do pensamento computacional

| Instrumento | Modalidade do instrumento | Modelo de avaliação | Conhecimento prévio |

|---|---|---|---|

| Computational Thinking Test (ROMÁN-GONZÁLEZ, 2015; ROMÁN-GONZÁLEZ et al., 2017) | Diagnóstico | Questionário de múltipla escolha/Perguntas compostas por desafios lógicos | Independente |

| CT Puzzle Test (GONÇALVES, 2015; COUTO, 2018) | Misto | Puzzles apoiados em pilares do PC, no estilo arrastar e soltar, graduação com base no registro de atividades | Independente |

| Scrape (WOLZ et al., 2011) | Sumativo | Graduação de código-fonte concluído | Scratch |

| Fairy Assessment (WERNER et al., 2012) | Sumativo | Graduação da performance em tarefas desenvolvidas com a ferramenta Alice após treinamento, questionário pré e pós-teste | Alice |

| Combined taxonomy tests (MEERBAUM-SALANT et al., 2013) | Sumativo | Aplicação de questionário em pré, ínterim e pós-teste, após treinamento na ferramenta Scratch | Scratch |

| Israel’s Nationwide Exam (ZUR-BARGURY; PÂRV; LANZBERG, 2013) | Sumativo | Questionário de múltipla escolha/Perguntas compostas por trechos de código | Scratch |

| Hairball (FRANKLIN et al., 2013; BOE et al., 2013) | Sumativo | Graduação de código-fonte concluído | Scratch |

| Progression of Early Computational Thinking (SEITER; FOREMAN, 2013) | Sumativo | Graduação de código-fonte concluído | Scratch |

| Commutative Assessment Test (WEINTROP; WILENSKY, 2015) | Sumativo | Questionário de múltipla escolha/Perguntas compostas por trechos de código | Snap!/Java |

| Test for Measuring Basic Programming Abilities (MÜHLING; RUF; HUBWIESER, 2015) | Sumativo | Questionário de Múltipla Escolha/ Perguntas compostas por trechos de código | Linguagem Karel |

| Quizly (MAIORANA; GIORDANO; MORELLI, 2015) | Sumativo | Plataforma de criação de perguntas ou tarefas no ambiente App Inventor com feedback para o estudante em tempo real e registro de atividades | App Inventor |

| Autograder (BALL; GARCIA, 2016; BALL, 2017) | Sumativo | Graduação de código-fonte concluído | Snap! |

| ITCH (JOHNSON, 2016) | Sumativo | Graduação de código-fonte concluído | Scratch |

| Computational Thinking Patterns CTP-Graph (KOH et al., 2010) | Formativo-iterativo | Feedback para o estudante por avaliação de código-fonte concluído | AgentSheets |

| REACT (KOH et al., 2014) | Formativo-iterativo | Feedback para o estudante por avaliação de código-fonte em tempo real | AgentSheets |

| Dr. Scratch (MORENO-LEÓN; ROBLES; ROMÁN-GONZÁLEZ, 2015) | Formativo-iterativo | Feedback para o estudante por avaliação de registro de atividade | Scratch |

| Ninja Code Village (OTA; MORIMOTO; KATO, 2016) | Formativo-iterativo | Feedback para o estudante por avaliação de código-fonte concluído | Scratch |

| Code Master (WANGENHEIM et al., 2018) | Formativo-iterativo | Feedback para o estudante por avaliação de código-fonte concluído | App Inventor/Snap! |

| Shuchi Grover (GROVER et al., 2017; GROVER et al., 2016) | Mineração de dados | Estatística por avaliação de registro de atividade | Fairy Assessment/Alice |

| Kodetu (EGUILUZ et al., 2017) | Mineração de dados | Estatística por avaliação de registro de atividade | Kodetu/Blockly |

| Bebras Tasks (DAGIENE; FUTSCHEK, 2008) | Transferência de habilidades | Questionário de múltipla escolha/Perguntas compostas por desafios lógicos | Independente |

| CTP-Quiz (BASAWAPATNA et al., 2011) | Transferência de habilidades | Questionário com perguntas sobre a relação entre eventos reais e eventos programados em jogos predefinidos desenvolvidos pelos estudantes | AgentSheets |

| Dancing Alice (DAILY et al., 2014) | Transferência de habilidades | Modelagem de movimentos de dança em personagem no ambiente Alice | Alice |

| Computational Thinking Scales - CTS (KORKMAZ et al., 2017) | Escalas de percepções e atitudes | Escala de avaliação sobre a autopercepção do sujeito com relação a conceitos do PC | Independente |

| Computer Programming Self- -Efficacy Scale - CPSES (KUKUL et al., 2017) |

Escalas de percepções e atitudes | Escala de avaliação sobre a autopercepção do sujeito com relação a conceitos de programação | Scratch/Smallbasic |

| Robotics and Engineering Workshop (GROVER, 2011) | Avaliação de vocabulário | Entrevistas em pré e pós-teste após treinamento | Linguagem Logo |

| CT Framework (BRENNAN; RESNICK, 2012) | Misto | Graduação de avaliação de código- -fonte concluído complementada com entrevistas e tarefas de interpretação de código-fonte |

Scratch |

Fonte: Elaboração dos autores com base em Román-González, Moreno-León e Robles (2019), Wangenheim et al. (2018) e Couto (2018).

Cada instrumento aborda a avaliação do PC sob um aspecto diferente. Brennan e Resnick (2012) afirmaram que avaliar as competências computacionais apenas olhando para os programas criados pelos alunos poderia ser visivelmente insuficiente, por isso enfatizaram a necessidade de múltiplos meios de avaliação. Grover (2015) afirma que diferentes tipos de ferramentas complementares de avaliação devem ser sistematicamente combinados para alcançar uma compreensão total e abrangente do PC dos estudantes.

Nesse contexto, o CT Puzzle Test se destaca por combinar algumas das abordagens de avaliação indicadas por Román-González; Moreno-León e Robles (2019) - diagnóstico, formativo-iterativo, sumativo, mineração de dados - e por ser independente de linguagem/ferramenta. O Quadro 2 apresenta como cada abordagem se caracteriza no teste.

QUADRO 2 Características das abordagens de avaliação no CT Puzzle Test

| Abordagem de Avaliação | Características |

|---|---|

| Diagnóstico | Mede o nível de aptidão do PC por meio de escores e pode ser aplicado em formato pré- -teste pois independe de conhecimentos prévios. |

| Formativo-iterativo | Fornece feedback imediato e automático sobre acertos e erros; fornece dicas de reso- lução dos problemas. |

| Sumativo | Pode ser aplicado após o indivíduo passar por instrução (uma disciplina de PC, por exemplo) para medir seu desenvolvimento. |

| Mineração de dados | Registra as interações do indivíduo com o instrumento e permite a análise do pesquisador sobre essas interações (como tempo, tentativas, utilização de dicas, etc.), e não somente os acertos e erros. |

Fonte: Elaboração dos autores.

Além dessas características, o instrumento adota o estilo de pergunta em formato de puzzle ao invés da escolha entre múltiplas respostas apresentadas em questionários tradicionais.

Para estimar a validade do instrumento, Gonçalves (2015) conduziu as seguintes aplicações do teste: para a validade aparente e de conteúdo, o pesquisador utilizou amostras de especialistas do Grupo de Informática na Educação (GIE) da Universidade do Vale do Itajaí (Univali), composto por 22 integrantes, sendo: 11 deles doutores, mestres, doutorandos e mestrandos nas áreas da computação, educação, matemática e psicologia; e 11 estudantes do 1º e 2º ano do ensino médio do Colégio de Aplicação da Universidade e uma turma do 6º período do curso superior de ciência da computação da universidade. Para a validade concorrente, as amostras foram compostas por estudantes do 7º período do curso superior de ciência da computação, do 6º período do curso superior de engenharia da computação e do 1º período do curso superior de psicologia. Para a validade preditiva, 16 estudantes do 9º ano do ensino fundamental da rede municipal de ensino foram expostos ao instrumento. Para a estimativa de fidedignidade foi utilizado o método da consistência interna com o cálculo do coeficiente alpha Cronbach para todas as aplicações do teste. Os métodos de validade convergente e discriminante não foram abordados pelo fato de não haver outro instrumento à época para comparação de resultados. Os esforços de Gonçalves (2015) na investigação da validade e fidedignidade do CT Puzzle Test indicaram evidências fortes de validade do instrumento, no entanto, o próprio autor observa que, para fins estatísticos, a aplicação com mais indivíduos se faz necessária.

MATERIAIS E MÉTODOS

Para verificar a validade convergente do CT Puzzle Test, foi adotado como critério o CTt (ROMÁN-GONZÁLEZ, 2015). Essa etapa não havia sido executada à época do primeiro processo de validação do CT Puzzle Test, por falta de outro instrumento semelhante para ser utilizado como critério, conforme apontou Gonçalves (2015). A escolha do CTt para essa nova etapa de validação se deu por duas razões principais. A primeira é que o CTt foi o teste com mais características em comum com o CT Puzzle Test - é um instrumento que não depende de conhecimento prévio do sujeito, de linguagem de programação ou tecnologia, pode ser facilmente aplicado por ser um instrumento on-line e gera um escore que pode ser comparado com os resultados do CT Puzzle Test. A segunda razão é que o CTt já passou por testes para confirmar sua validade e fidedignidade (ROMÁN-GONZÁLEZ, 2015; ROMÁN-GONZÁLEZ; MORENO-LEÓN; ROBLES, 2017).

CT Puzzle Test

As questões criadas para o instrumento foram baseadas em atividades clássicas sobre resolução de problemas. Questões do Programa de Enriquecimento Instrumental de Feuerstein (2006) e exercícios encontrados em testes de QI foram adaptados para o formato de jogo puzzle para auxiliar a mensurar os pilares do PC.

O CT Puzzle Test é planejado para que não seja necessário nenhum conhecimento prévio para resolvê-lo. Os problemas estão organizados em fases que apresentam um mesmo tipo de mecânica/puzzle, porém com níveis diferentes. O instrumento foi projetado para ser aplicado on-line e utiliza as tecnologias HTML5 e Javascript.

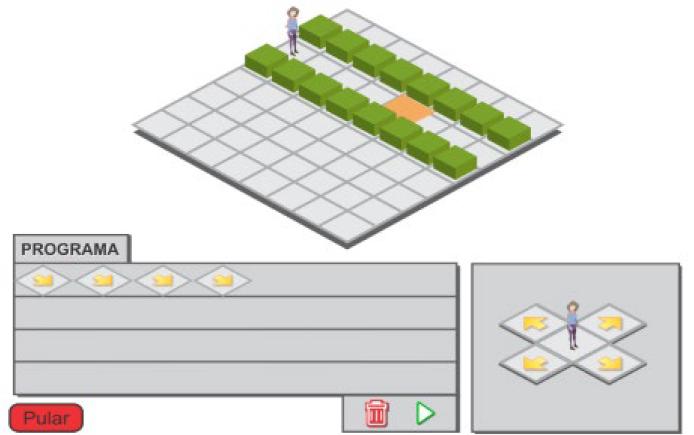

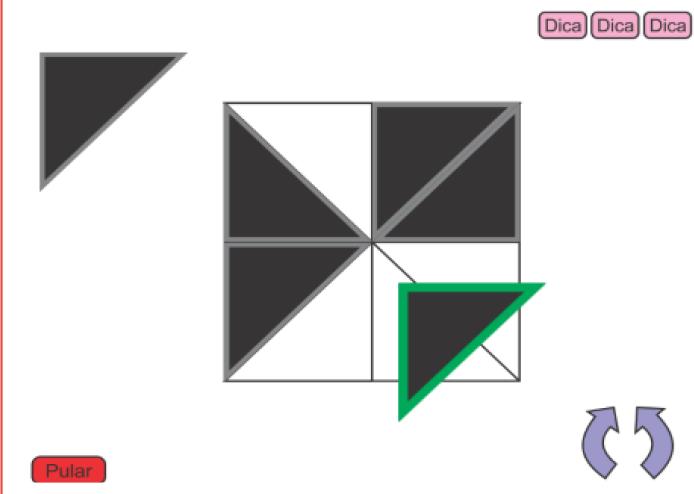

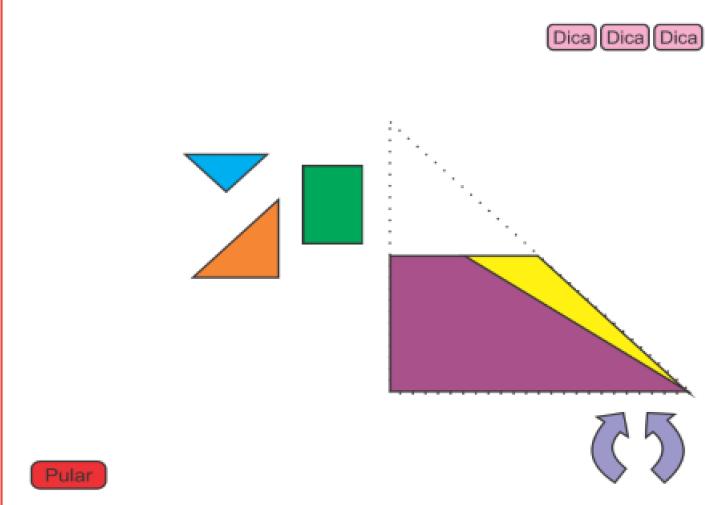

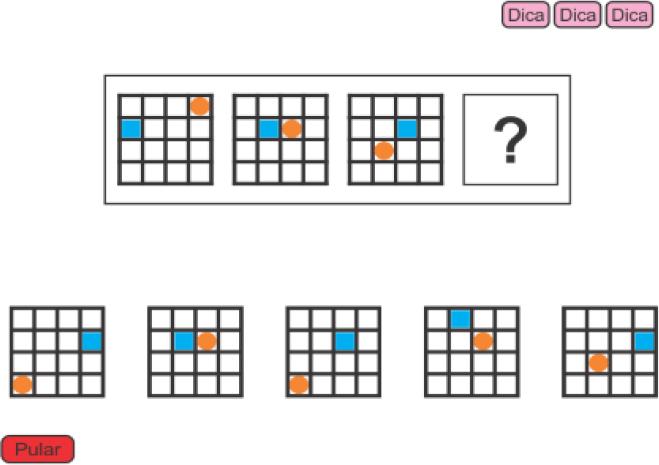

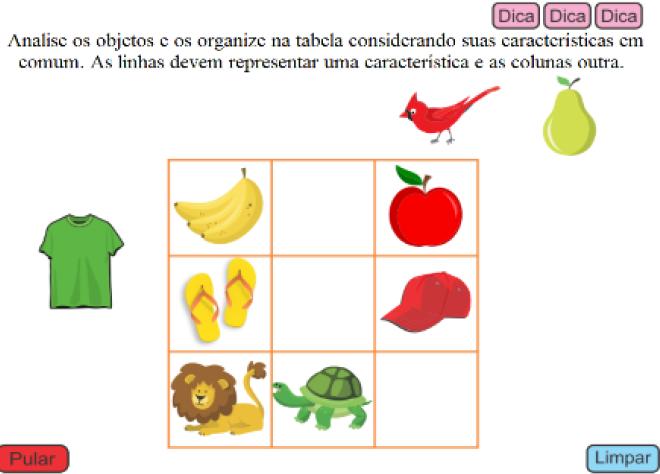

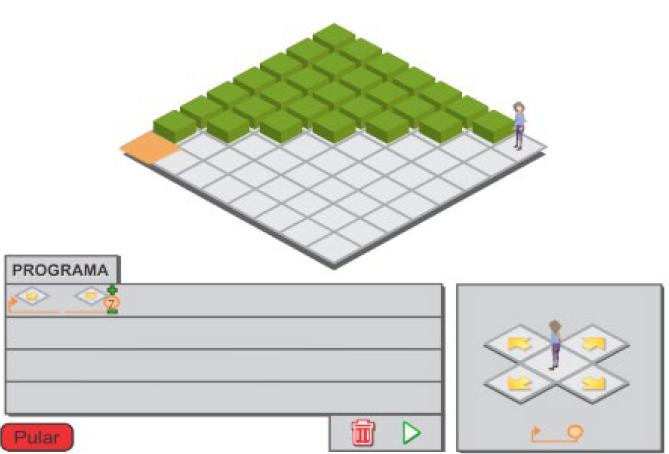

Mecânicas do CT Puzzle Test

Em cada fase do teste, são capturadas variáveis de interação de uso. Na fase 1, por exemplo, são contadas quantas vezes um comando foi removido. A remoção de um comando nesse caso aponta que o aluno cometeu alguma falha e precisou cor- rigir. Isso tem influência na pontuação final. O Quadro 3 apresenta as fases do teste, com uma descrição de suas mecânicas e das interações avaliadas.

QUADRO 3 Fases do CT Puzzle Test

Fonte: Elaboração dos autores.

Em todos os itens das fases está disponível a opção “pular”, para que o estudante avance para o próximo item sem completar o atual, anulando a pontuação do item pulado.

Computational Thinking Test

O CTt (ROMÁN-GONZÁLEZ, 2015) é uma ferramenta de avaliação diagnóstica que consiste em um instrumento de múltipla escolha composto por 28 itens. Cada item aborda um ou mais dos seguintes conceitos computacionais, que aparecem em dificuldade crescente ao longo do teste: instruções e sequências básicas; loops (“repetir vezes”, “repetir até”, “repetir enquanto”); condicionais simples (“se”), condicionais compostas (“se/senão”) e funções simples.

Esses conceitos estão alinhados com os padrões de aprendizagem estabelecidos pela CSTA (2011) para o ensino da ciência da computação. Especificamente, em seu nível 2 (correspondente às séries 6 a 9 no sistema norte-americano), o padrão definido com relação aos conceitos e habilidades computacionais que devem ser dominados nessas idades se caracteriza pela implementação de soluções de problemas usando uma linguagem de programação, incluindo estruturas de repetição, estruturas condicionais, expressões lógicas, variáveis e funções (ISTE; CSTA, 2011).

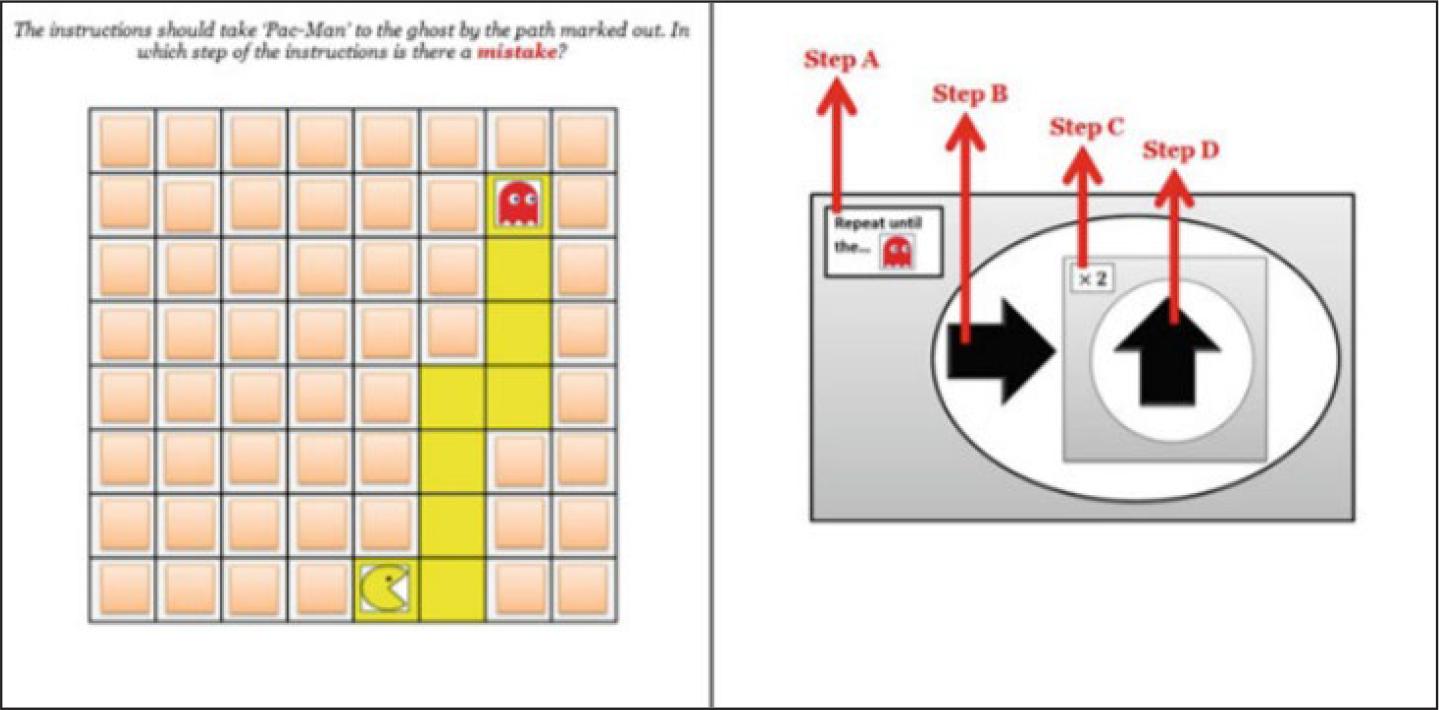

Em cada item, as respostas são representadas em um dos dois estilos: “setas visuais” ou “blocos visuais”. Para ser resolvido, cada item exige ao sujeito uma das seguintes tarefas cognitivas: sequenciar um algoritmo, concluir um algoritmo incompleto ou depurar um algoritmo incorreto. A Figura 1 apresenta um exemplo de item do tipo “setas” que aborda os conceitos de “repetir até” e “repetir vezes”.

Fonte: Román-González (2015).

FIGURA 1 CTt, item #11: loops “repetir até + repetir vezes”; “setas visuais”

Nesse item, o estudante precisa analisar no tabuleiro qual a sequência de passos que o personagem deve percorrer. Do lado direito, um aninhamento de comandos de repetição determina a automatização do movimento do personagem. Porém uma das instruções está incorreta, e o estudante deve ser capaz de identificar o erro.

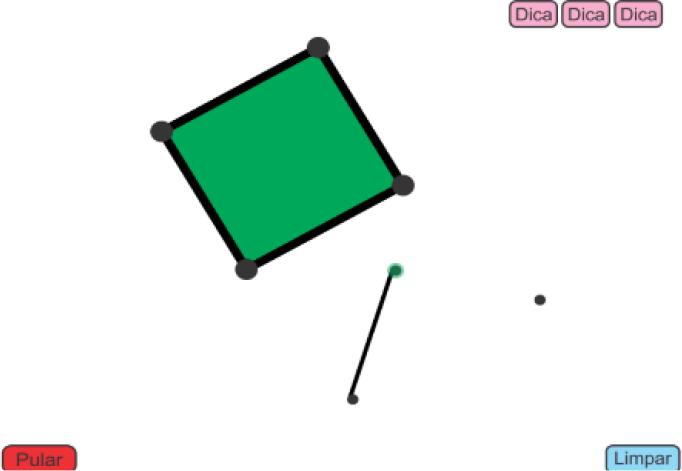

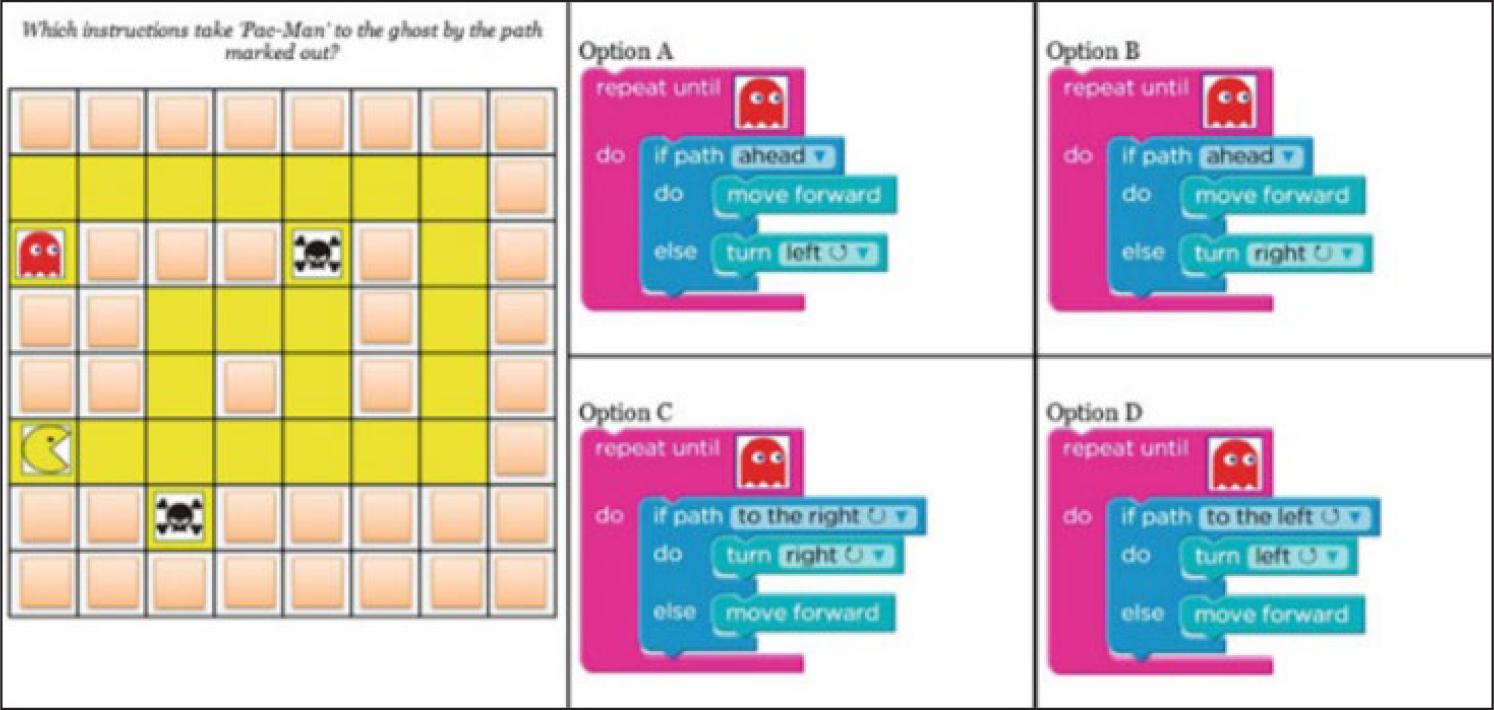

A Figura 2 apresenta um item do tipo “blocos” que aborda os conceitos “repetir até” e condicionais compostas “se/senão”.

Fonte: Román-González (2015).

FIGURA 2 CTt, item #18: loops “repetir até” + condicional “if/else”; “blocos visuais”

Nesse item, novamente o estudante precisa interpretar o caminho que o personagem deve percorrer. Porém, nesse caso, as instruções são apresentadas em formato de bloco de comandos, e o movimento do personagem agora depende dos obstáculos no caminho, que devem ser evitados por meio das estruturas condicionais. Apenas um dos quatro algoritmos está correto, por isso o estudante deve depurar cada opção para identificar a correta.

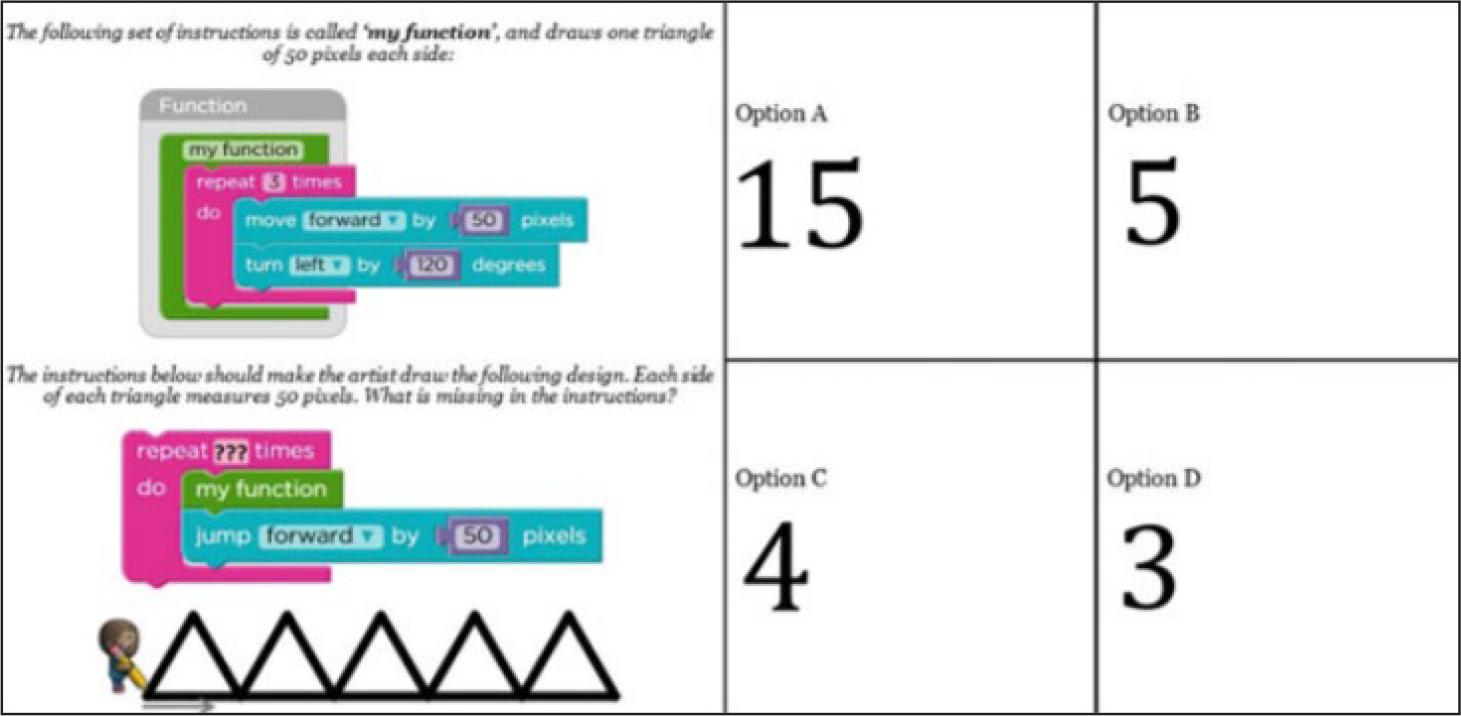

A Figura 3 apresenta um exemplo de item do tipo “bloco” no qual é necessário concluir o algoritmo incompleto.

Fonte: Román-González (2015).

FIGURA 3 CTt, item #26: loops “repetir vezes” + funções simples; “blocos visuais”

Nesse item, é proposto um padrão de desenho que o algoritmo deve produzir, porém falta a informação da quantidade de repetições em uma das etapas do programa. O estudante deve ser capaz de identificar o valor correto da repetição para garantir a execução do desenho, levando em consideração que esse algoritmo está estruturado de forma modular pela implementação do conceito de “funções”.

O teste é aplicado por meio de um formulário on-line e o escore final é obtido pelo cálculo da porcentagem do número de acertos em relação ao total de questões.

O CTt apresentou evidências de validade para avaliar o PC em indivíduos entre 10 e 16 anos. Seu processo de validação foi relatado por Román-González (2016), e algumas etapas desse processo foram descritas em publicações específicas, como a validação de conteúdo (ROMÁN-GONZÁLEZ, 2015), a validação de critério (ROMÁN-GONZÁLEZ; MORENO-LEÓN; ROBLES, 2017) e a validação preditiva (ROMÁN-GONZÁLEZ et al., 2018).

Aplicação dos testes

Para esta etapa da pesquisa, os dois testes foram aplicados em amostras de alunos do 8° a 9° ano do ensino fundamental e do 1° ao 3° ano do ensino médio do Colégio de Aplicação Univali, localizado no município de Itajaí, totalizando 86 estudantes em ambos os testes.

Os testes foram aplicados em laboratórios de informática, em horário regular de aula de cada turma com tempo disponível de 50 minutos para cada aplicação. O CT Puzzle Test foi aplicado no final do quarto bimestre de 2017, enquanto o CTt foi aplicado no final do segundo bimestre de 2018.

Equiparação de critérios de avaliação

Em sua pesquisa, Brackmann (2017) também adotou o CTt como instrumento de avaliação do PC. Com o intuito de alinhar os resultados das aplicações do CTt com os objetivos da pesquisa, o autor relacionou cada item do CTt a pelo menos um dos pilares do PC, por meio da associação dos conceitos computacionais da CSTA, nos quais cada item está apoiado nos conceitos correspondentes no âmbito dos pilares. O Quadro 4 apresenta essa relação dos pilares com os itens do CTt.

QUADRO 4 Itens do CTt e sua relação com os pilares do PC

| Item | Abstração | Decomposição | Reconhecimento de Padrões | Algoritmos |

|---|---|---|---|---|

| 1 | X | X | ||

| 2 | X | X | ||

| 3 | X | X | ||

| 4 | X | X | X | |

| 5 | X | X | X | |

| 6 | X | X | X | |

| 7 | X | X | X | |

| 8 | X | X | ||

| 9 | X | X | ||

| 10 | X | X | X | |

| 11 | X | X | X | X |

| 12 | X | X | X | X |

| 13 | X | X | X | |

| 14 | X | X | X | |

| 15 | X | X | X | X |

| 16 | X | |||

| 17 | X | X | ||

| 18 | X | X | ||

| 19 | X | |||

| 20 | X | X | ||

| 21 | X | X | X | |

| 22 | X | X | X | X |

| 23 | X | X | X | X |

| 24 | X | |||

| 25 | X | X | X | X |

| 26 | X | X | X | X |

| 27 | X | X | X | X |

| 28 | X | X | X | X |

Fonte: Brackmann (2017).

Para comparar os dois testes na atual etapa de validação, os itens do CT Puzzle Test também foram mapeados para os pilares do PC. Para esse mapeamento foi aplicado um algoritmo que combina diversos valores atribuídos aos pesos das variáveis da equação do CT Puzzle Test. A partir dos resultados, foram selecionados os pesos que permitem alcançar a maior correlação possível entre os resultados dos dois testes. Para o elemento “algoritmo”, o maior coeficiente de correlação encontrado foi 0.55, para “abstração” foi 0.53, para “decomposição” foi 0.60, e para “reconhecimento de padrões” foi 0.58.

Finalmente, a distribuição de pesos em cada item, conforme a aderência do item a cada pilar, resultou nos valores apresentados na Tabela 1.

TABELA 1 Pesos em cada fase e respectivos itens do CT Puzzle Test, segundo a aderência aos pilares do PC

| Fase | Pilares do PC | |||

|---|---|---|---|---|

| Abstração | Reconhecimento de padrões | Decomposição | Algoritmos | |

| 1 | 0.1 | 0.1 | 0.45 | 0.4 |

| 2 | 0.4 | 0.4 | 0.2 | 0 |

| 3 | 0.2 | 0.4 | 0.4 | 0 |

| 4 | 0.2 | 0.4 | 0.4 | 0 |

| 5 | 0.2 | 0.4 | 0.4 | 0 |

| 6 | 0.4 | 0.3 | 0.3 | 0 |

| 7 | 0.1 | 0.1 | 0.4 | 0.4 |

Fonte: Elaboração dos autores.

Ao mapear os resultados do CT Puzzle Test para os pilares do PC, foi realizado o cálculo do coeficiente alpha de Cronbach para cada pilar nos dois testes, visando a validar a distribuição dos pesos de cada fase do CT Puzzle Test. A Tabela 2 apresenta os resultados.

TABELA 2 Coeficiente alpha de Cronbach para cada pilar do PC e teste

| Pilar do PC | CT Puzzle Test | CTt |

|---|---|---|

| Algoritmos | 0.66 | 0.80 |

| Abstração | 0.61 | 0.67 |

| Decomposição | 0.75 | 0.69 |

| Reconhecimento de padrões | 0.66 | 0.74 |

| Média | 0.67 | 0.72 |

Fonte: Elaboração dos autores.

Ao calcular a média entre os valores é possível afirmar que são válidos os pesos aplicados no cálculo dos escores CT Puzzle Test, de acordo com o coeficiente alpha de Cronbach de 0.67, próximo ao valor 0.72 alcançado pelo CTt.

Com todos os itens dos dois testes mapeados para os pilares do PC, foi pos- sível realizar a comparação estatística dos escores obtidos nas aplicações de ambos os testes.

ANÁLISE DOS RESULTADOS

Os resultados das aplicações do CT Puzzle Test foram analisados com base na metodologia pelo mapeamento dos quatro pilares do PC sugeridas por Brackmann (2017) e relatadas na subseção “Equiparação de Critérios de Avaliação”. As médias dos escores da amostra são apresentadas na Tabela 3.

TABELA 3 Médias do escores dos estudantes no CT Puzzle Test

| Pilar do PC | Média | Desvio padrão |

|---|---|---|

| Algoritmos | 0.67 | 0.09 |

| Abstração | 0.69 | 0.08 |

| Decomposição | 0.68 | 0.08 |

| Reconhecimento de padrões | 0.72 | 0.09 |

Fonte: Elaboração dos autores.

O cálculo da média a partir dos resultados revela que os estudantes pontuaram escores altos, variando entre 0.67 e 0.72 com desvio-padrão baixo, evidenciando que não houve muita variação nos escores.

Os resultados das aplicações do CTt também utilizaram a metodologia pelo mapeamento dos quatro pilares do PC de Brackmann. A Tabela 4 apresenta os valores das médias do escores da amostra de estudantes que foram submetidos ao CTt.

TABELA 4 Médias dos escores dos estudantes no CTt

| Pilar do PC | Média | Desvio Padrão |

|---|---|---|

| Algoritmos | 0.66 | 0.17 |

| Abstração | 0.62 | 0.17 |

| Decomposição | 0.61 | 0.18 |

| Reconhecimento de Padrões | 0.61 | 0.18 |

Fonte: Elaboração dos autores.

As médias dos estudantes se situam entre 0.61 e 0.66, com desvio-padrão pequeno, mostrando pouca variação nas notas.

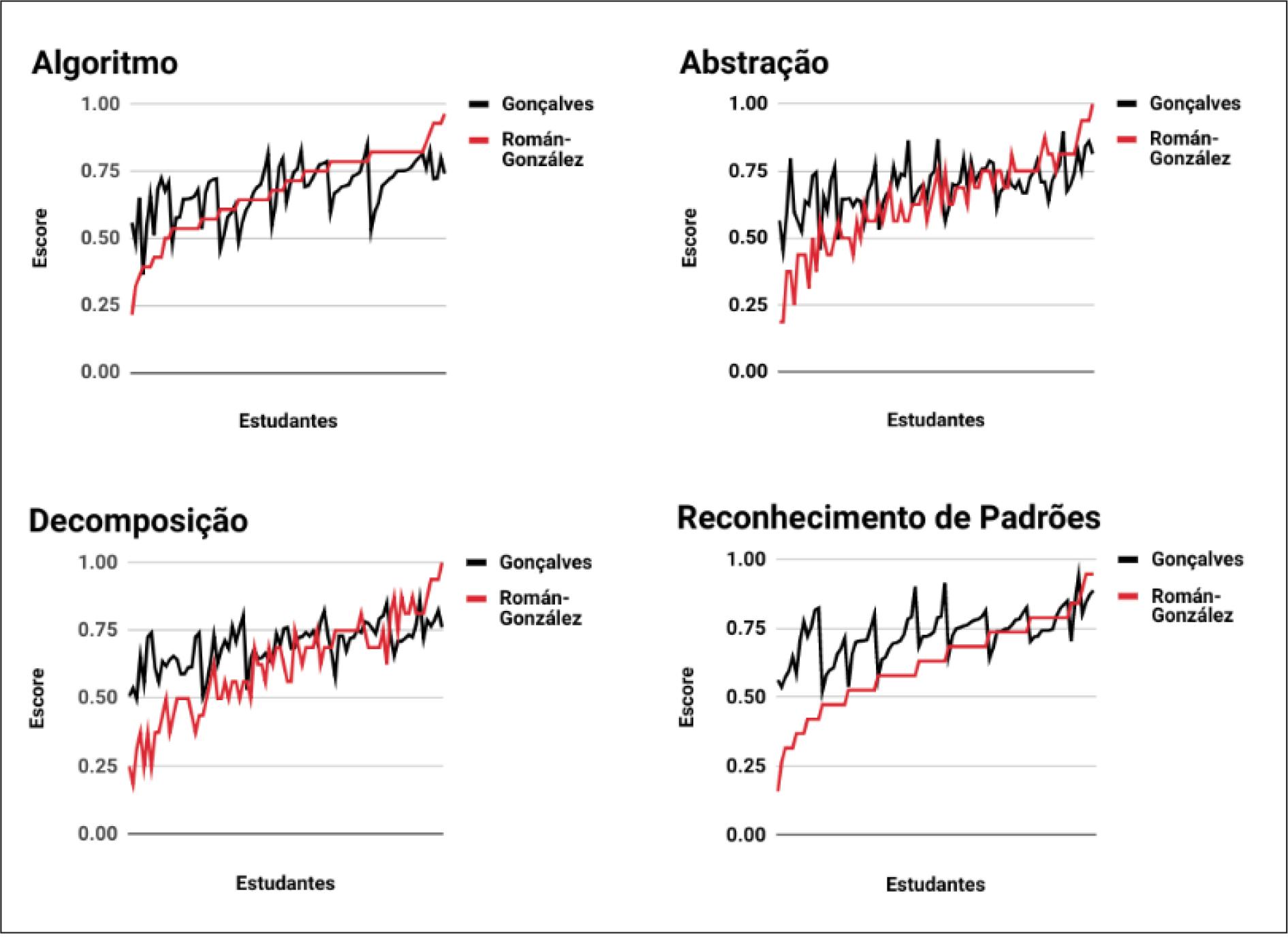

Para investigar evidências de validade convergente entre os testes, foi analisada a distribuição dos escores dos 86 estudantes que participaram de ambos os testes. A Figura 4 apresenta essa distribuição conforme cada pilar do PC.

Fonte: Elaboração dos autores.

FIGURA 4 Distribuição dos escores dos estudantes em cada teste conforme o pilar do PC

Nos gráficos da Figura 4, o eixo X representa os estudantes de maneira individual, e o eixo Y representa o escore que obtiveram no CT Puzzle Test (preto) e no CTt (vermelho). De acordo com a regra de Thumb, as correlações podem ser consideradas como moderadas positivas, pois os valores se posicionam entre 0.5 e 0.7 (HINKLE; WIERSMA; JURS, 2003).

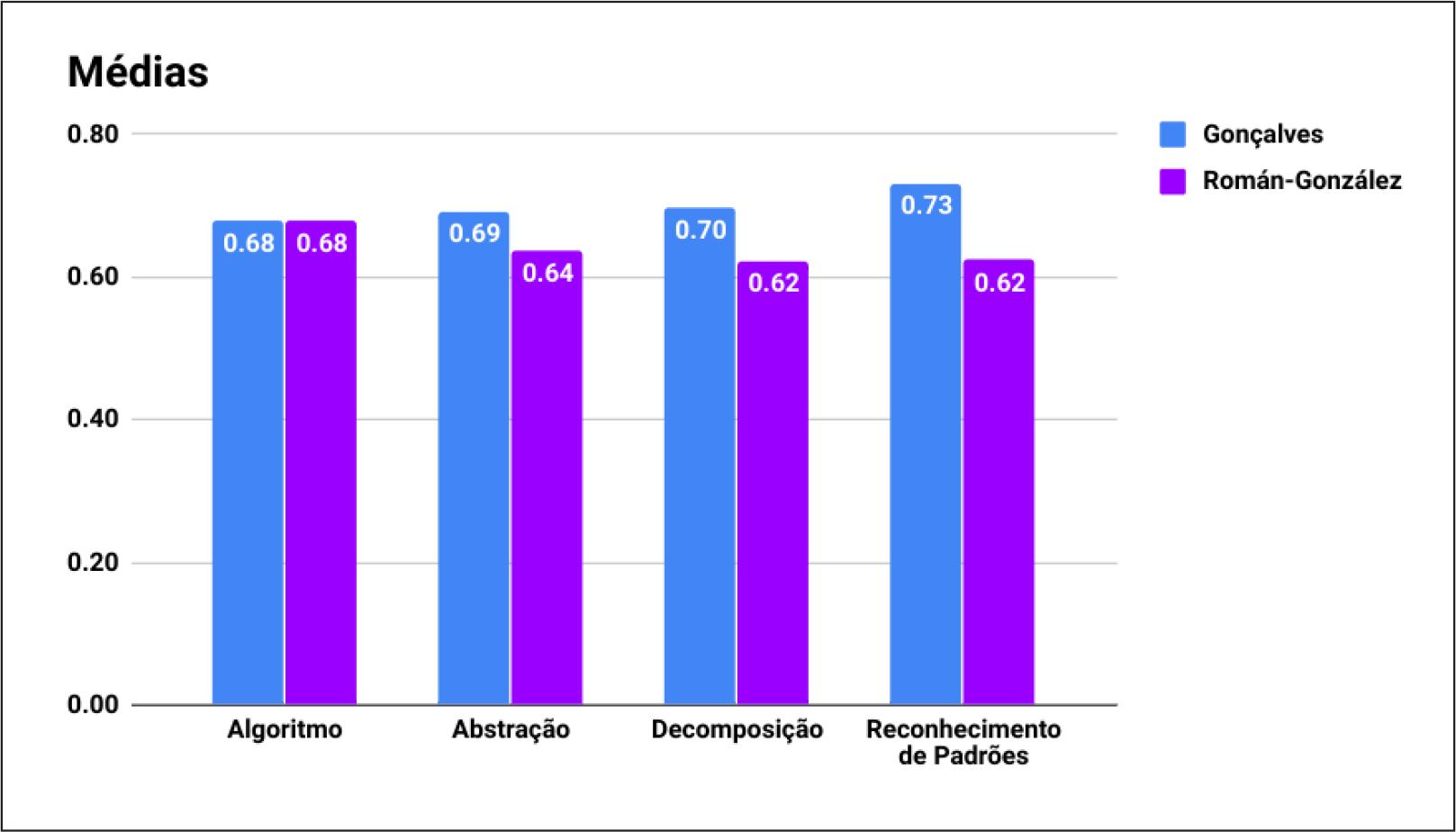

As médias da amostra de estudantes que realizaram os dois testes também foram calculadas. Conforme ilustra a Figura 5, é possível perceber que as médias são iguais na categoria “algoritmo”, e nas restantes elas são muito próximas, com diferença de apenas 0.05 ponto em “abstração”, 0.08 em “decomposição” e 0.11 em “reconhecimento de padrões”.

Fonte: Elaboração dos autores.

FIGURA 5 Médias dos escores dos estudantes da amostra em cada teste, segundo os pilares do PC

Apesar de os dois testes medirem os mesmos pilares do PC, a forma de mensurá-los é diferenciada em cada teste. O CTt apresenta todos os desafios por meio de perguntas de múltipla escolha com quatro opções, enquanto o CT Puzzle Test analisa diversos fatores da resolução, como tempo, número de tentativas e tipos de interação. A abordagem do conteúdo também é diferenciada: o CTt foca exclusivamente em situações relacionadas à lógica de programação (ROMÁN-GONZÁLEZ; MORENO-LEÓN; ROBLES, 2019); o CT Puzzle Test, por sua vez, apresenta situações independentes de domínio como identificação de formas geométricas, progressão de sequências e reconhecimento de padrões, entre outros. O alpha de Cronbach do CT Puzzle Test aprimorado (0.67) é considerado de consistência interna substancial (LANDIS; KOCH, 1977), o que indica a confiabilidade do teste, e, ao apresentar uma correlação moderada com o CTt, aponta forte evidência de sua validade convergente. Portanto os resultados reafirmam a eficácia do CT Puzzle Test em avaliar o PC e demonstram que os itens no formato de puzzles e a contemplação da experimentação e teste de hipóteses por meio da captura das interações do estudante com o instrumento é uma abordagem válida. Contudo, conforme Bittencourt et al. (2011), apesar da validação do instrumento ser uma importante iniciativa para seu aperfeiçoamento, deve-se considerar que o instrumento continue sendo aprimorado em estudos futuros. De acordo com os autores, “[...] não existem instrumentos definitivos e perfeitos, especialmente em se tratando de avaliação educacional” (p. 21).

CONCLUSÕES E PESQUISAS FUTURAS

A consolidação do pensamento computacional como um construto científico tem evoluído com pesquisas em vários lugares do mundo. A ideia de implementar o PC nas escolas como um conjunto de habilidades que todo estudante precisa desenvolver tem recebido atenção de educadores e legisladores, e é fundamental dispor de metodologias de ensino e avaliação adequadas para que o PC se estabeleça com êxito nos currículos escolares. Analisar apenas códigos-fonte de programas finalizados ou adotar questionários compostos de perguntas fechadas com respostas objetivas é insuficiente para avaliar as competências computacionais dos estudantes. Por isso, combinar múltiplas formas de avaliação se faz necessário para alcançar um entendimento completo das habilidades de pensamento computacional de um sujeito. Nesse contexto, este artigo apresentou os resultados da investigação acerca das evidências de convergência entre os testes CT Puzzle Test e CTt. Os resultados demonstraram que são fortes as evidências da eficácia do CT Puzzle Test em avaliar o PC e corroboraram que a abordagem por puzzles e a contemplação da experimentação e teste de hipóteses por meio da captura das interações do estudante com o instrumento é uma abordagem válida para a avaliação do PC. O principal trabalho futuro proposto é a submissão do CT Puzzle Test a um novo e mais completo processo de validação. Novas pesquisas são necessárias a partir das modificações do instrumento em suas últimas etapas de aprimoramento, e uma nova etapa de validação apoiada em novas amostras e em técnicas mais rigorosas será a principal contribuição ao estado atual de evolução do instrumento. Além disso, a sistematização de aplicação do teste, com a definição de diretrizes e documentação de apoio também se faz pertinente para disponibilizar o teste a qualquer pesquisador que tenha interesse em investigar o PC em sua área de atuação.

Outra possibilidade para trabalhos futuros, com base nas melhorias desenvolvidas nesta pesquisa, é projetar novos níveis para as fases existentes no CT Puzzle Test para se obter maior variabilidade dos testes, o que permitirá aplicar o teste mais de uma vez a um mesmo estudante sem o risco do viés de testagem, quando o indivíduo memoriza as respostas do pré-teste para responder o pós-teste.

Por fim, a evolução do CT Puzzle Test representará uma colaboração com a evolução da rede nomológica de desenvolvimento do PC, pois a constatação da existência de correlação entre instrumentos de avaliação que se propõem a avaliar um mesmo construto contribui para explicar até que ponto e por que os construtos teóricos se relacionam. Essas correlações resultam na definição das variáveis moderadoras nas quais elas podem ou não ser observadas, e dependem do desenvolvimento de medidas eficientes e válidas.