INTRODUÇÃO

As duas últimas décadas têm sido especialmente frutíferas em termos de definição de metas e de mudanças legislativas relacionadas ao ensino superior (ES) na Europa. No contexto europeu, além das tendências globalizantes e desafios mundiais, o Processo de Bolonha (PB) gerou uma série de mudanças específicas voltadas para a criação de um Espaço Europeu de Ensino Superior (EEES), promovendo, assim, a comparabilidade dos padrões e da qualidade das qualificações de ensino superior.

Em Portugal, o Decreto-Lei n. 74 (2006) (posteriormente alterado pelo Decreto-Lei n. 107, 2008) estabeleceu a aplicação dos Princípios de Bolonha em instituições de ES. Formalmente, Portugal tem seguido mudanças estruturais nos ciclos de estudo conforme critérios europeus padronizados, e tem implementado um sistema de melhoria de qualidade. As mudanças envolvem uma transição de um sistema baseado na “transmissão de conhecimentos” para um sistema baseado no “desenvolvimento das competências do aluno”, com ênfase no trabalho experimental, no trabalho em projeto, e em habilidades transversais (Decreto-Lei n. 107, 2008). O objetivo dessas mudanças é favorecer ambientes de aprendizado mais competitivos, bem como mudanças nas concepções de ensino (Reimann & Wilson, 2012), reconhecendo o papel central do aluno dentro de uma lógica de autonomia, trabalho em equipe e aprendizado ativo (Segers & Dochy, 2001). O Processo de Bolonha implicou mudanças em várias dimensões, especialmente com relação à flexibilidade curricular e ao trabalho docente e discente (Pereira & Flores, 2016).

Estudos realizados no contexto do ES português têm demostrado o compromisso das instituições de ES com o PB, bem como uma maior cooperação entre Portugal e as instituições de ES europeias (David & Abreu, 2017). Entretanto, algumas contradições também foram identificadas, tais como: a aparente destruição do sistema binário (educação universitária e politécnica) e a complexa preservação da cultura, língua, sistemas de educação e autonomia institucional nacionais (David & Abreu, 2007); a realização bem-sucedida de aspectos mais formais do PB (Veiga & Amaral, 2008) e a manutenção de práticas avaliativas tradicionais (Pires et al., 2013); e a prevalência de práticas não alinhadas com os objetivos de Bolonha (Pires et al., 2013; European Students’ Union [ESU], 2015; Barreira et al., 2015; Pereira et al., 2017; European Commission, 2018). Outros achados dizem respeito a métodos avaliativos mistos (Pires et al., 2013; Pereira et al., 2017; Flores & Pereira, 2019).

Apesar dos resultados positivos, a adaptação de programas de ES à perspectiva de ensino e aprendizado de Bolonha ainda é um desafio. Em alguns casos, práticas avaliativas novas e inovadoras têm sido introduzidas visando a uma abordagem mais centrada no aluno. Entretanto, na maioria dos casos, a avaliação continua a ser uma questão de “emitir declarações acerca dos pontos fracos e fortes dos alunos” (Earl & Katz, 2006, p. 4, tradução nossa).

Tradicionalmente, a avaliação em sala de aula tem se concentrado em sua função somativa, na avaliação e medição do aprendizado, utilizando as informações avaliativas para formular e transmitir julgamentos sobre o desempenho dos alunos, o que pode incentivar comparações e competições (Black & Wiliam, 1998). Por outro lado, a função formativa da avaliação, relacionada a como melhorar o aprendizado dos alunos (Black & Wiliam, 1998), também tem sido destacada.

Embora formas mais tradicionais de avaliação possam ser eficazes em contextos e para fins específicos, elas não são adequadas a todos os objetivos avaliativos, e podem estimular a produção e a memorização (Perrenoud, 1999; Biggs, 2003). Por sua vez, os chamados métodos avaliativos centrados no aluno (Webber & Tschepikow, 2013; Myers & Myers, 2015) permitem o desenvolvimento de habilidades técnicas e de solução de problemas, como a promoção de um maior envolvimento do aluno no processo de aprendizado (Myers & Myers, 2015). Esses métodos implicam tarefas mais globais a serem desenvolvidas ao longo do tempo. Eles podem simultaneamente incluir as dimensões de processo e produto, individuais e coletivas. Além disso, estimulam a autonomia, a colaboração, a responsabilidade, o feedback construtivo, a interação com colegas e outras pessoas envolvidas, a construção do conhecimento (Webber & Tschepikow, 2013), o desenvolvimento de habilidades e o aprofundamento do aprendizado (Brew et al., 2009). Tais métodos incluem, por exemplo, trabalhos experimentais práticos e reflexões (Weber & Tschepikow, 2013; Struyven et al., 2005).

Independentemente da abordagem avaliativa escolhida, é importante lidar “com todos os aspectos da avaliação de maneira integrada” (Black & Wiliam, 2018, p. 552, tradução nossa). A seleção de estratégias avaliativas representa um componente-chave do processo de ensino e aprendizado. Essa seleção deve resultar em um processo de questionamento direcionado a metas no programa ou curso (Hadji, 2001), definindo quais questões devem ser respondidas por meio da avaliação. Portanto é essencial utilizar uma variedade de métodos de avaliação com base em sua adequação aos objetivos de ensino e aprendizado e à natureza do curso e das unidades curriculares (Earl & Katz, 2006; Black & Wiliam, 2018).

Um questionamento eficaz e bem-sucedido, no contexto do EEES, implica uma formulação apropriada dos objetivos e o reconhecimento da avaliação como um dos pilares do processo de ensino e aprendizado. Com o Processo de Bolonha, há uma expectativa de métodos avaliativos mais variados (métodos alternativos, incluindo aqueles que envolvem os alunos) e de adoção de outras abordagens avaliativas, tais como a avaliação para a aprendizagem (McDowell et al., 2011), reconhecendo o papel do feedback no processo de avaliação e aprendizado (Black & Wiliam, 1998; Hattie & Timperley, 2007; Carless et al., 2011). No contexto das práticas centradas no aluno, a literatura também reconhece o papel da sala de aula na organização de ambientes inovadores e facilitadores do aprendizado (Black & Wiliam, 1998) e no desenvolvimento de formas inovadoras de estruturar o ensino e a avaliação (Fernandes, 2015).

Essa visão tem ganhado proeminência no contexto do PB (Flores & Simão, 2007), desafiando os professores a promover oportunidades de aprendizado mais questionadoras, inovadoras e criativas (Zabalza, 2008). Entretanto não está claro se os professores realmente a abraçaram (Webber & Tschepikow, 2013).

Este artigo1 relata pesquisas voltadas para a compreensão de práticas avaliativas do ES após o PB, especialmente no tocante a possíveis mudanças e seu significado, levando em consideração o contexto do ensino universitário.

MÉTODOS

Este artigo baseia-se em uma pesquisa mais ampla, dentro de um doutorado em ciências da educação, financiada pela Fundação para a Ciência e a Tecnologia (Ref. SFRH/BD/103291/2014), sendo tal pesquisa, por sua vez, parte de um projeto mais amplo, intitulado “Assessment in higher education: The potential of alternative methods”, financiado pela Fundação Nacional para a Ciência e a Tecnologia (Ref. PTDC/MHC-CED/2703/2014). O estudo relatado neste artigo busca identificar práticas avaliativas utilizadas por docentes e investigar a influência do PB sobre essas práticas. Em particular, foram abordadas as seguintes questões de pesquisa:

1) Que tipo de práticas avaliativas são utilizadas por docentes portugueses após a implementação do PB?

2) Qual o efeito das características e contextos dos docentes sobre suas respostas à escala de práticas avaliativas?

3) Qual foi a influência do PB sobre o processo de mudança das práticas avaliativas dos docentes?

Foi realizada uma pesquisa em cinco universidades públicas portuguesas, combinando questões abertas e fechadas.

Participantes

O questionário foi aplicado entre fevereiro e julho de 2017 a uma amostra por conveniência, composta de docentes de cinco universidades públicas portuguesas. A amostra era composta de 185 professores de vários ciclos de ensino (graduação, mestrado, mestrado integrado2 e doutorado) em cinco áreas diferentes (ciências exatas, engenharia e ciências tecnológicas, ciências médicas e da saúde, ciências sociais e humanidades). Pouco mais de quatro quintos da amostra (83,8%) lecionavam em programas de graduação; 77,3% lecionavam em programas de mestrado; 41,5% lecionavam em programas de mestrado integrado; 55,8% lecionavam em cursos de doutorado; e 1,7% em outros programas (cursos sem concessão de grau acadêmico, cursos profissionalizantes, entre outros). Os participantes eram principalmente do sexo feminino (47,0%) e com idade acima de 45 anos (55,7%). A maioria era composta de professores associados/assistentes (71,3%), com doutorado (74,6%) e capacitação pedagógica (63,2%). Com relação à experiência como acadêmicos, a maioria tinha mais de 15 anos de experiência (70,8%) (Tabela 1).

TABELA 1 CARACTERÍSTICAS DEMOGRÁFICAS DOS PARTICIPANTES

| CARACTERÍSTICAS DEMOGRÁFICAS | N | % |

|---|---|---|

| Universidade | ||

| A | 36 | 19,5 |

| B | 34 | 18,4 |

| C | 60 | 32,4 |

| D | 36 | 19,5 |

| E | 19 | 10,2 |

| Gênero | ||

| Masculino | 74 | 40,0 |

| Feminino | 87 | 47,0 |

| Sem informação | 24 | 13,0 |

| Idade | ||

| Abaixo de 45 anos | 82 | 44,3 |

| Acima de 45 anos | 103 | 55,7 |

| Ciclo de estudos | ||

| Graduação | ||

| Sim | 155 | 83,8 |

| Não | 30 | 16,2 |

| Mestrado integrado | ||

| Sim | 73 | 39,4 |

| Não | 103 | 55,7 |

| Sem informação | 9 | 4,9 |

| Mestrado | ||

| Sim | 143 | 77,3 |

| Não | 42 | 22,7 |

| Doutorado | ||

| Sim | 101 | 54,6 |

| Não | 80 | 43,2 |

| Sem informação | 4 | 2,2 |

| Área de conhecimento | ||

| Ciências médicas e da saúde | 21 | 11,4 |

| Ciências exatas | 16 | 8,6 |

| Engenharia e ciências tecnológicas | 50 | 27,0 |

| Ciências sociais | 77 | 41,6 |

| Humanidades | 21 | 11,4 |

| Categoria profissional | ||

| Professor titular | 10 | 5,4 |

| Professor associado/adjunto com agregação1 | 19 | 10,3 |

| Professor associado/adjunto | 132 | 71,3 |

| Outro | 24 | 13,0 |

| Experiência em ensino | ||

| Menos de 15 anos | 54 | 29,2 |

| Mais de 15 anos | 131 | 70,8 |

| Capacitação pedagógica | ||

| Sim | 117 | 63,2 |

| Não | 63 | 34,1 |

| Sem informação | 5 | 2,7 |

| Total | 185 | 100,0 |

Fonte: Elaboração das autoras.

1. N.T.: O termo “agregação” refere-se a uma qualificação própria do sistema português de progressão nas carreiras da docência universitária.

Instrumento

A escala “práticas avaliativas” consiste em trinta itens (ver a Tabela A1). A versão utilizada neste estudo é uma adaptação de uma seção do questionário socioprofissional do Inventário de Concepções Avaliativas (CAI, do inglês Conceptions of Assessment Inventory), originalmente utilizado no contexto clínico de enfermagem (Gonçalves, 2016), adaptado para uso com docentes em todo o espectro de disciplinas universitárias. Um grupo de especialistas em ciências da educação avaliou os itens, assegurando seu alinhamento com as diferentes áreas do conhecimento, e foram realizados alguns ajustes (adaptando o texto original ao ensino universitário em geral). Os dados foram complementados com duas questões (fechada e aberta) sobre as possíveis mudanças nas práticas avaliativas: 1) Você mudou sua maneira de avaliar seus alunos ao longo de sua carreira? 2) Em sua opinião, a implementação do PB contribuiu para mudar as práticas de avaliação no ES? Para cada questão, estavam disponíveis as seguintes opções de resposta: sim, não e talvez, e os participantes foram incentivados a justificar suas respostas (questões abertas).

O projeto foi aprovado pela Comissão de Ética para a Investigação em Ciências Sociais e Humanidades da Universidade do Minho (Ref. SECSH 035/2016 e SECSH 036/2016). Todos os participantes foram integralmente informados sobre os objetivos do projeto. Um termo de consentimento e permissão assinado foi obtido junto aos participantes.

ANÁLISE

Foram realizadas análises estatísticas utilizando o software IMB SPSS Statistics 24. A análise fatorial é uma técnica que pode ser utilizada não apenas para entender a estrutura de uma medida, mas também para reduzir os dados a um conjunto mais manejável de variáveis (fatores ou dimensões), mantendo, ao mesmo tempo, o máximo possível de informações originais (Field, 2009). Assim, realizou-se a análise fatorial exploratória (AFE), utilizando a análise de componentes principais com rotação varimax (Field, 2009). Os pressupostos de adequação do tamanho e esfericidade da amostra foram verificados. Neste estudo, essa análise serviu a dois propósitos: (a) obter evidências empíricas para a estrutura subjacente da escala de práticas avaliativas, por meio da identificação de dimensões essenciais baseadas nas intercorrelações entre os itens; e (b) reduzir os dados obtidos nos trinta itens a escores mais manejáveis que fossem interpretáveis e representassem as dimensões essenciais das práticas avaliativas. O número de fatores e itens a serem retidos baseou-se em dois critérios: fatores com eigenvalores maiores do que 1; e itens com cargas fatoriais maiores do que 0,35. A fidelidade das subescalas foi testada utilizando o alfa de Cronbach. Como este é um estudo exploratório, valores de alfa maiores do que 0,60 foram considerados (Hair et al., 2009).

O escore médio dos itens foi calculado para cada dimensão, e foi explorada a relação entre essas dimensões e as características demográficas e profissionais dos participantes. Para investigar os efeitos da idade, gênero, anos de experiência, categoria profissional, área de conhecimento, ciclo de estudos e capacitação pedagógica sobre as práticas avaliativas, foi utilizada a análise multivariada de variância (Manova). Os pressupostos de independência das observações, normalidade univariada e homogeneidade das matrizes de variância-covariância foram garantidos (Field, 2009). Os valores de eta-quadrado parcial (ηp²) foram calculados como medida do tamanho do efeito, considerando as seguintes diretrizes para sua interpretação: efeito pequeno, ηp² > 0,01; efeito médio, ηp² > 0,06; efeito grande, ηp² > 0,14 (Cohen, 1988). Com relação às características demográficas, na variável idade para este subestudo, dois grupos foram considerados para análise: 1) docentes abaixo de 45 anos de idade; 2) docentes acima de 45 anos de idade. Na variável experiência profissional (variáveis profissionais), o tempo de serviço foi somado da seguinte forma: 1) docentes com menos de 15 anos de experiência; 2) docentes com mais de 15 anos de experiência. Os pontos de corte para o agrupamento nas variáveis “idade” e “experiência profissional” foram definidos com base na data de implementação do Processo de Bolonha em Portugal. Assim, docentes mais velhos e com mais anos de experiência tinham maior probabilidade de possuir experiência nos dois períodos (antes e depois do Processo de Bolonha), enquanto entre docentes mais jovens e menos experientes era maior a probabilidade de não haver tal experiência. As categorias profissionais “professor associado com agregação” e “professor adjunto com agregação”, e “professor associado” e “professor adjunto”, e as áreas de conhecimento de ciências exatas e de engenharia e ciências da tecnologia também foram agrupadas a fim de obter unidades de análise mais adequadas.

Dados coletados por meio das questões abertas do questionário foram analisados por meio da análise de conteúdo orientada pelos princípios da completude, representatividade, consistência, exclusividade e relevância (Bardin, 2009), e pelo reconhecimento da natureza interativa da análise de dados (Miles & Huberman, 1994). Foram privilegiadas uma abordagem mista e a definição de categorias mais gerais (Bardin, 2009; Esteves, 2006), articulando uma perspectiva indutiva (caráter emergente dos dados) (Cho & Lee, 2014) a uma perspectiva dedutiva por meio da definição de categorias de análise alinhadas com os objetivos da pesquisa e o referencial teórico (Ezzy, 2002). As categorias de análise eram semânticas (Miles & Huberman, 1994).

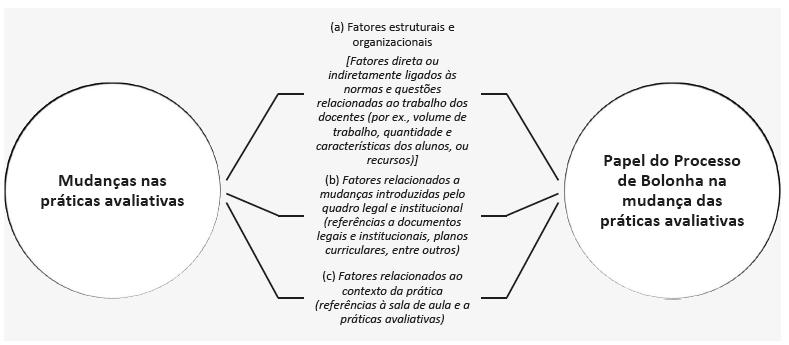

A análise do discurso dos participantes, combinada a uma revisão crítica da literatura, apoiaram as seguintes dimensões centrais: 1) Mudanças nas práticas avaliativas; 2) Influência do PB sobre as mudanças nas práticas avaliativas. Cada dimensão gerou um conjunto de temas e categorias semelhantes ao protocolo do questionário, conforme as respostas “Sim”, “Não” e “Talvez”: (a) fatores estruturais e organizacionais; (b) fatores relacionados às mudanças introduzidas pelo quadro legal e institucional; e (c) fatores relacionados ao contexto da prática. Na primeira categoria, foram consideradas referências a fatores ligados direta ou indiretamente às circunstâncias (mais ou menos desafiadoras) em que se desenvolve o trabalho dos docentes (por exemplo, volume de trabalho, quantidade e características dos alunos, e recursos). Quanto aos fatores ligados às mudanças introduzidas pelo quadro legal e institucional, foram consideradas referências a documentos legais e institucionais, bem como planos curriculares, entre outros. Finalmente, com relação ao contexto da prática, foram incluídas referências à sala de aula e práticas de avaliação.

RESULTADOS

Os resultados da AFE sugeriram que o componente 1 representava o “engajamento e participação dos alunos na avaliação”,3 o componente 2 representava o “uso da avaliação pelos docentes no processo de ensino e aprendizado”,4 e o componente 3 representava a “avaliação como processo determinado por fatores externos”5 (para os resultados detalhados, ver a Tabela A1). Esses três componentes refletem, por um lado, a importância do envolvimento do aluno no processo de avaliação (European Commission, 2013). Por outro lado, refletem como os docentes utilizam a avaliação, reconhecendo que o modo como eles avaliam os alunos (Brown, 2005) e seu uso das informações avaliativas (Earl & Katz, 2006) têm sérias implicações para o aprendizado dos alunos. Contudo, a avaliação não está imune ao contexto, regras e procedimentos externos à sala de aula, na medida em que “as decisões dos professores sobre estratégias avaliativas estão intimamente ligadas às oportunidades e limitações oferecidas pelas decisões normativas e institucionais” (Ion & Cano, 2011, p. 167, tradução nossa). Os três componentes explicaram 46,57% da variância. Todos os itens tiveram cargas fatoriais elevadas no respectivo componente. Os itens de cada fator revelaram uma consistência interna adequada, apoiando a confiabilidade dos escores obtidos. O alfa de Cronbach foi maior do que 0,60 em todos os três componentes (ver a Tabela A1).

A Tabela 2 apresenta os resultados das estatísticas descritivas com relação às práticas avaliativas dos docentes. As práticas associadas ao uso da avaliação no processo de ensino e aprendizado foram as mais utilizadas (ver Tabela 2). Os resultados das estatísticas descritivas também revelam uma tendência positiva no uso de práticas relacionadas ao envolvimento e participação dos alunos no processo de avaliação.

TABELA 2 ESTATÍSTICAS DESCRITIVAS DAS PRÁTICAS AVALIATIVAS DOS PROFESSORES

| N | % | MÍNIMO | MÁXIMO | MÉDIA | DP | MEDIANA | Q1 | Q3 | |

|---|---|---|---|---|---|---|---|---|---|

| 1. Engajamento e participação dos alunos na avaliação | 172 | 93 | 1,29 | 3,93 | 2,71 | 0,49 | 2,71 | 2,43 | 3,00 |

| 2. Uso da avaliação pelo docente no processo de ensino e aprendizado | 172 | 93 | 2,00 | 4,00 | 3,13 | 0,38 | 3,10 | 2,90 | 3,40 |

| 3. Avaliação como processo determinado por fatores externos | 179 | 96,8 | 1,00 | 3,67 | 2,69 | 0,57 | 2,67 | 2,33 | 3,00 |

Fonte: Elaboração das autoras.

Nota: Q1: primeiro quartil; Q3: terceiro quartil; DP (desvio padrão).

As análises Manova indicam que não há efeitos significativos da idade, gênero, anos de experiência como docente, categoria profissional e frequência da capacitação pedagógica dos participantes sobre as diferentes práticas avaliativas. Com relação à influência dos ciclos de estudo na utilização de diferentes práticas avaliativas, os testes multivariados revelaram a ausência de diferenças estatisticamente significativas entre os professores que lecionam nos programas de graduação, mestrado integrado e doutorado (ver a Tabela A2 para as estatísticas descritivas).

No entanto, os resultados da Manova indicaram a existência de diferenças estatisticamente significativas, com tamanho de efeito médio, entre os docentes que lecionam em programa de mestrado e aqueles que não o fazem (WILK’S Δ = 0,931, F(3, 158) = 3,876, p = 0,010, ηp2 = 0,069). Os resultados dos testes univariados permitiram concluir que os docentes que lecionam nesse ciclo de estudos atribuíam mais importância às práticas associadas com o envolvimento e participação dos alunos na avaliação, e às práticas associadas com o uso da avaliação pelos docentes no processo de ensino e aprendizado. Uma menor importância foi atribuída a práticas determinadas por fatores externos (ver Tabela 3).

TABELA 3 RESULTADOS DOS TESTES UNIVARIADOS APLICADOS AO EFEITO DO CICLO DE ESTUDO (MESTRADO) E ÁREA DE CONHECIMENTO SOBRE AS PRÁTICAS AVALIATIVAS

| CICLO DE ESTUDO MESTRADO |

ÁREA DE CONHECIMENTO | |||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Sim M (DP) |

Não M (DP) |

F (gl1, gl2) |

p | ηp 2 | CE & ECT M (DP) |

CMS M (DP) |

CS M (DP) |

H M (DP) |

F (gl1, gl2) |

p | ηp 2 | |

| 1. Engajamento e participação dos alunos na avaliação | 2,76 (0,476) |

2,52 (0,513) |

6,725 (1, 160) |

0,010 | 0,040 | 2,56 (0,459) |

2,72 (0,484) |

2,81 (0,547) |

2,83 (0,233) |

3,080 (3, 158) |

0,029 | 0,055 |

| 2. Uso da avaliação pelos docentes no processo de ensino e aprendizado | 3,17 (0,373) |

3,01 (0,427) |

4,484 (1, 160) |

0,036 | 0,027 | 3,06 (0,391) |

3,10 (0,419) |

3,16 (0,393) |

3,34 (0,257) |

2,548 (3, 158) |

0,058 | 0,046 |

| 3. Avaliação como processo determinado por fatores externos | 2,62 (0,588) |

2,90 (0,482) |

6,519 (1, 160) |

0,012 | 0,039 | 2,82 (0,500) |

2,82 (0,556) |

2,53 (0,631) |

2,67 (0,511) |

3,158 (3, 158) |

0,026 | 0,057 |

Fonte: Elaboração das autoras.

Nota: M (média); DP (desvio padrão); gl (graus de liberdade); p (valor-p); ηp 2 (eta-quadrado parcial); CC (ciências exatas); ECT (engenharia e ciências da tecnologia); CMS (ciências médicas e da saúde); CS (ciências sociais); H (humanidades).

Com relação à área de conhecimento, os testes multivariados revelaram a existência de diferenças estatisticamente significativas, embora com tamanho de efeito pequeno, no uso de diferentes práticas avaliativas (WILK’S Δ = 0,876, F(9, 379,814) = 2,366, p = 0,013, ηp2 = 0,043). Os resultados dos testes univariados (ver a Tabela 3) e as comparações pareadas sugeriram um maior uso de práticas associadas com o envolvimento dos alunos no processo avaliativo por professores que lecionam nas áreas de ciências sociais em comparação com aqueles que lecionam em ciências exatas e em engenharia e ciências da tecnologia (p = 0,031). Também foi possível identificar um maior uso de práticas avaliativas determinadas por fatores externos em professores que lecionam nas áreas de ciências exatas e de engenharia e ciências da tecnologia em comparação com docentes da área de ciências sociais (p = 0,029).

MUDANÇAS NAS PRÁTICAS AVALIATIVAS E O PAPEL DO PROCESSO DE BOLONHA

A avaliação é um ativo estratégico para as organizações de ensino superior. Escolhas acertadas sobre estratégias avaliativas por parte dos professores são um fator crucial para o sucesso acadêmico dos alunos. Uma boa avaliação pode ser mativadora e produtiva para os alunos, ajudando-os a saber “quão bem estão indo, e o que mais podem fazer” (Brown, 1999, p. 3, tradução nossa). Por outro lado, uma má avaliação pode ser “tediosa, sem sentido, cansativa e contraproducente” (Brown, 1999, p. 4, tradução nossa).

Os docentes também foram questionados sobre possíveis mudanças avaliativas após a implementação do PB. A maioria dos participantes (85,9%) afirmou ter mudado a forma de avaliar seus alunos ao longo de sua carreira; 9,8% informaram não ter adotado mudança alguma, e 4,3% responderam “talvez” (ver Tabela 4). Questionados se a implementação do PB contribuiu para mudar suas práticas avaliativas, 47,8% responderam positivamente, 29,1% disseram “não”, e 23,1% responderam “talvez” (ver Tabela 4).

TABELA 4 MUDANÇAS NAS PRÁTICAS AVALIATIVAS E A CONTRIBUIÇÃO DO PB

| Sim | Não | Talvez | Sem informação | Total | ||||

|---|---|---|---|---|---|---|---|---|

| n | % | n | % | n | % | |||

| Modifiquei a forma como avalio meus alunos. | 158 | 85,9 | 18 | 9,8 | 8 | 4,3 | 1 | 185 |

| A implementação do PB contribuiu para mudar minhas práticas avaliativas. | 87 | 47,8 | 53 | 29,1 | 42 | 23,1 | 3 | 185 |

Fonte: Elaboração das autoras.

Mudanças nas práticas avaliativas

Fatores relacionados ao contexto da prática são prevalentes em se tratando de mudanças nas práticas avaliativas. Fatores estruturais e organizacionais são considerados menos influentes (ver Figura 1). A quantidade e características dos alunos, o tipo e conteúdo dos cursos, as condições técnicas e materiais, e o trabalho colaborativo foram os principais fatores relacionados às condições identificadas pelos docentes que afirmaram ter mudado suas práticas avaliativas:

A diminuição no número de alunos por sala permitiu-me oferecer um atendimento mais individualizado (seja em trabalhos individuais ou em grupo) e feedbacks mais regulares e personalizados. O trabalho colaborativo com meus colegas, e o ensino conjunto de cursos específicos também me colocaram em contato com outras práticas avaliativas que venho adotando. (Q59).

Os participantes também identificam mudanças introduzidas pelo quadro legal e institucional, por exemplo, a introdução do PB, mudanças impostas por instituições e processos avaliativos:

O PB favoreceu outras formas de avaliação, além dos exames tradicionais. (Q18).

Como resultado das políticas de ensino, financiamento do ES e aprimoramento em minha carreira acadêmica, fui obrigado a abandonar as aulas de laboratório e/ou práticas. (Q89).

Questões como a importância da experiência de capacitação, a autoaprendizagem, a experiência como docente, experimentações e a introdução de novos modelos avaliativos também foram destacadas:

Por meio do processo de ensino-aprendizado, senti a necessidade, por causa dos resultados, de mudar os critérios, processos e metodologias avaliativas nos anos seguintes, a fim de obter melhores resultados. (Q157).

Tenho diversificado e adaptado minhas estratégias avaliativas aos perfis dos alunos. Tenho também intensificado práticas de autoavaliação e avaliação de alunos em minha prática. (Q168).

Por outro lado, os docentes que não têm modificado suas práticas ressaltam sua falta de poder para introduzir mudanças nas unidades curriculares e a ausência de mudanças no contexto. Com relação aos fatores ligados ao contexto, chama atenção a prevalência da crença de que os docentes avaliam os alunos de forma adequada. Algumas respostas, no entanto, demonstram disposição e necessidade quanto à implementação de mudanças nos processos avaliativos, como ilustram citações abaixo:

Acredito que a forma como avalio continua sendo mais confiável. (Q75).

Até o momento, não tenho modificado minhas práticas avaliativas, mas estou convencido de que, em turmas pequenas, é necessário implementar novas formas de avaliação que possam ajudar os alunos a desenvolver mais habilidades. (Q119).

A influência do contexto, as características dos alunos, o ciclo de estudo, e os conteúdos a ser ensinados foram destacados pelos docentes que responderam “talvez” quando perguntados se haviam mudado suas práticas avaliativas. Mudanças relacionadas aos regulamentos institucionais, o foco no aluno e no processo de ensino e aprendizado, bem como a coexistência de uma diversidade de métodos avaliativos, também foram enfatizados.

Continuo a atribuir grande importância às provas escritas, pois elas me dão a forma mais objetiva e justa de avaliar o trabalho do aluno como um todo. Uma vez que leciono um curso de engenharia, também atribuo grande relevância a trabalhos práticos e experimentais, os quais promovem um aprendizado mais envolvente e proativo. Esse trabalho tende a ser desenvolvido em grupos, pois, em engenharia, também é importante aprimorar a capacidade do aluno de interagir e trabalhar com os outros. (Q84).

O papel do Processo de Bolonha nas práticas avaliativas dos professores

A prática de ensino e aprendizado surge como um fator essencial na contribuição do PB para mudar as práticas avaliativas. No entanto, condições estruturais e organizacionais assumem particular relevância para os participantes que não reconhecem a contribuição do processo para a mudança das práticas avaliativas (ver Figura 1).

A receptividade das instituições a práticas avaliativas inovadoras, as mudanças no perfil dos alunos e a existência de turmas menores foram os principais aspectos destacados pelos participantes que reconheceram o impacto do PB sobre as mudanças nas práticas avaliativas. No entanto, identificou-se também uma deterioração das condições de ensino.

Pois o tipo de aluno que temos nos obriga a tomar medidas para atualizar nossas habilidades de ensino e avaliação. Bolonha criou ou questionou o que estávamos fazendo, e creio que a realidade está mudando. (Q119).

A princípio, creio que Bolonha chamou a atenção para a necessidade de diversificar as formas de avaliação e nos adaptarmos ao “novo” paradigma de aprendizado centrado no aluno. Na prática, com a redução das horas de contato, e com turmas enormes, esse efeito inicial acabou se dissipando em alguns cursos. (Q184).

As mudanças formais impostas por Bolonha (cursos de seis meses, ECTS,6 entre outros) e a padronização dos critérios e programas avaliativos foram enfatizadas pelos participantes. Porém tais mudanças têm apresentado implicações positivas e negativas:

As instituições permitiram aos docentes utilizar métodos menos convencionais, simulações em sala de aula, debates, apresentações utilizando tecnologias, pesquisa-ação, projetos, etc. (Q25).

Creio que as mudanças são majoritariamente em processos formais (por exemplo, documentos/arquivos de curso...) do que, enfim, nas concepções/práticas. A avaliação contínua, por exemplo, é mais comum após Bolonha, mas, muitas vezes, apenas leva a um maior número de critérios avaliativos (por exemplo, aumento no número de provas). (Q177).

Essa ambivalência foi prevalente em suas respostas. A introdução de métodos avaliativos inovadores, com maior foco na participação do aluno, o uso de avaliações formativas e contínuas em detrimento de métodos de avaliação tradicionais, o desenvolvimento de projetos fora da sala de aula e da própria universidade, a avaliação baseada em competências ou feedback foram mudanças positivas destacadas pelos participantes. Coexistiu, porém, uma perspectiva mais negativa, no tocante à redução da carga horária e da duração dos cursos, à uniformização das práticas de ensino, e à falta de profundidade e efetividade nas práticas de ensino e avaliação.

Concordo totalmente, a avaliação se tornou mais direcionada à aquisição de competências (práticas) e, sempre que necessário, ao uso da avaliação contínua, com feedback em todas as avaliações. (Q8).

Embora em muitos casos retórica, ela introduziu a necessidade de pensar sobre o aprendizado e focar em trabalhar com os alunos no desenvolvimento das atividades, e não no velho esquema de aulas teóricas que, hoje em dia (inclusive devido às mudanças tecnológicas), os alunos não mais suportam. (Q172).

Contribuiu de forma muito negativa, com consequências desastrosas. A duração dos cursos está cada vez menos limitada. Na faculdade de direito, muitos alunos terminam o curso de mestrado com menos qualidade e menos conhecimentos do que em programas anteriores. (Q31).

Além disso, o grande número de alunos por classe, as características dos alunos (por exemplo, falta de autonomia), a resistência das universidades ao processo de mudança, a falta de recursos, e a preparação deficiente do próprio sistema foram destacados pelos participantes que consideram que Bolonha não teve impacto sobre as práticas avaliativas:

Na minha opinião, os alunos não assimilaram o espírito da reforma implemen- tada pelo PB. Penso que os alunos não têm a autonomia de estudos e pesquisa exigida pelo PB. (Q91).

Minha experiência é que a universidade resistiu à mudança, seja pela resistência natural de seus atores (docentes, alunos e líderes formais) ou pela falta de recursos materiais e humanos para uma implementação efetiva do PB. (Q165).

Ademais, alguns participantes consideram Bolonha uma “formalidade administrativa”, uma transição formal que modifica os documentos oficiais (por exemplo, planos curriculares), mas não exerce o impacto desejado sobre as práti- cas avaliativas:

Houve uma mudança na terminologia (por exemplo, certas graduações passaram a ser chamados de mestrados), mas, em termos práticos, as mudanças na avaliação parecem ser insignificantes. (Q75).

No que diz respeito à prática de ensino e aprendizado, as mudanças também foram “cosméticas”, o discurso mudou, mas a prática não, e, em alguns casos, as mudanças foram realizadas segundo a conveniência dos diferentes atores. Muitas vezes, quando tais mudanças existem, elas são “mais retóricas do que práticas”, e, em alguns casos, resultaram de esforços individuais e coletivos de professores que tendem a seguir uma lógica mais formativa, embora não necessariamente motivada pelo PB:

As mudanças nas práticas avaliativas foram mais retóricas do que práticas. As mudanças são essencialmente resultantes do trabalho individual e/ou coletivo (grupos disciplinares, equipes, etc.). (Q174).

O número de alunos por classe, a “lógica fechada” de alguns cursos, e os recursos disponíveis foram apontados como fatores estruturais e organizacionais pelos docentes que responderam “talvez”. Esses participantes também destacaram a “semestralização” e condensação dos cursos (mudanças introduzidas pelo quadro legal e institucional), a falta de preparo dos professores e alunos, a ausência de mudanças estruturais em termos de avaliação, e a prevalência da capacitação somativa (o contexto da prática). Foram identificados, ainda, o surgimento de práticas mais formativas, o foco no aluno e no processo de ensino-aprendizado, uma maior preocupação com a avaliação, e uma maior autonomia dos alunos:

Talvez tenha contribuído para uma maior variedade de alunos e para a avaliação contínua, com mais avaliações ao longo do semestre/ano. Mas, em essência, penso que a lógica do exame/prova escrita e trabalhos escritos com apresentações orais foi mantida. (Q74).

Deveria ter contribuído para mudar as práticas avaliativas, mas não tem sido o caso (talvez com algumas exceções), assim como ocorreu com os métodos de ensino. Houve uma adaptação do ensino ao PB, mas não sua real implementação. (Q163).

DISCUSSÃO

O Processo de Bolonha e a criação do EEES desafiaram países europeus, inclusive Portugal, a mudar suas práticas de ensino-aprendizado, focando em pedagogias centradas no aluno, iniciativas baseadas na solução de problemas, e práticas avaliativas inovadoras. Isso exige um ajuste nos padrões tradicionais de ensino e aprendizado baseados na transmissão do conhecimento, bem como um movimento em direção a formas mais inovadoras e criativas de ensino, aprendizado e avaliação. A avaliação deve ser diferenciada para responder de modo positivo à diversidade de origens e habilidades dos alunos (Scott et al., 2014). Este estudo buscou examinar as práticas avaliativas dos docentes e os efeitos da implementação do PB sobre tais práticas. Utilizou-se uma escala de práticas avaliativas docentes. Os resultados sugerem que a medida apresenta propriedades psicométricas adequadas, podendo, portanto, constituir uma ferramenta útil para medir práticas avaliativas docentes no ES. Os resultados também indicam a existência de diversas práticas avaliativas, com uma prevalência das práticas avaliativas dos professores, e uma menor incidência de práticas avaliativas determinadas por fatores externos. Identificou-se também a influência do ciclo de estudos e da área de conhecimento sobre o uso de diferentes práticas avaliativas. Foram também encontradas indicações de que professores que lecionam em programas de mestrado utilizam mais práticas associadas ao envolvimento e participação do aluno na avaliação, bem como práticas avaliativas determinadas mais pelos docentes do que por fatores externos.

Além disso, identificou-se que práticas avaliativas associadas ao envolvimento e participação do aluno na avaliação também eram mais utilizadas por docentes de ciências sociais do que por docentes de ciências exatas e de engenharia e ciências da tecnologia. O estudo também identificou um maior uso de práticas determinadas por fatores externos entre professores de ciências exatas e de engenharia e ciências da tecnologia em comparação com professores de ciências sociais.

Os docentes também questionaram a existência de mudanças em suas práticas avaliativas e a possível contribuição do PB para mudá-las. A maioria dos docentes relataram ter modificado a forma como avaliam os alunos ao longo de suas carreiras; chama a atenção, no entanto, que menos da metade dos participantes reconhece a importância do PB na mudança das práticas avaliativas. Fatores relacionados a aspectos estruturais e organizacionais (por exemplo, número de alunos por classe, condições materiais, semestralização), a mudanças introduzidas pelo quadro legal e institucional (por exemplo, documentos legais e institucionais, planos curriculares, entre outros), e ao contexto da prática (por exemplo, concepções e uso de avaliação) explicam diferenças entre docentes mais otimistas e mais céticos em relação à contribuição do PB para a mudança das práticas avaliativas. Muitos participantes consideram que Bolonha pode não ter sido um momento-chave em termos de mudança, ou, ao menos, desafio a suas práticas avaliativas. No entanto, sua contribuição para a discussão e a atenção dedicada a questões de ensino e aprendizado e, principalmente, avaliativas parece inegável. Esses resultados destacam a complexidade dos cenários da formação universitária (Zabalza, 2004) e da avaliação (Brown & Knight, 1994), bem como a complexidade da adaptação de práticas acadêmicas aos princípios de Bolonha (European Commission, 2018).

Os achados reforçam a importância do uso da avaliação por docentes no processo de ensino e aprendizado - por exemplo, o grau de entendimento sobre uma questão ou tema, ou o papel da avaliação no planejamento de atividades de aprendizado futuras. Nesse contexto, o feedback assume particular relevância para melhorar o aprendizado dos alunos. Os achados também corroboram a contribuição crucial da avaliação e das escolhas e estratégias acertadas pelos docentes para o sucesso do aprendizado dos alunos (Brown, 1999). O papel do engajamento e participação do aluno no processo avaliativo é outro achado relevante. Do ponto de vista da melhoria, e não da medição, a construção participativa dos critérios de avaliação contribui para o entendimento do que se espera, e também para a autorregulação dos alunos (Bonniol & Vial, 1997). O papel dos planos curriculares e a necessidade de medir e atribuir uma classificação ou nota também aparecem, embora com menor relevância, nas práticas avaliativas dos docentes.

Ademais, as vozes dos participantes refletem as diferentes perspectivas internacionais no campo da avaliação, às vezes dentro de uma lógica somativa e de verificação (Perrenoud, 1999), e às vezes em uma lógica avaliativa centrada no aluno (Webber, 2012), reconhecendo a conexão entre concepções e práticas avaliativas, bem como sua influência sobre o aprendizado dos alunos (Gibbs, 1999; Light & Cox, 2003).

O PB representou uma oportunidade de modernização e melhoria do ES. No entanto, há duas visões mutuamente conflitantes: “a opinião de que Bolonha foi uma evolução em direção à criação de melhores condições de aprendizado, com currículos mais adaptados à realidade”, e o argumento de que Bolonha representou “uma simples redução na duração dos programas de graduação e mestrado que, de forma alguma, mudou os programas ou metodologias de ensino” (Justino et al., 2017, p. 1, tradução nossa).

Os achados deste estudo também apontam para uma série de tensões relacionadas ao impacto de Bolonha nas práticas avaliativa em vários níveis: fatores relacionados a características estruturais e organizacionais, a mudanças introduzidas pelo quadro legal e institucional, e ao contexto da prática. O Processo de Bolonha pode ser visto como uma oportunidade para introduzir algumas mudanças necessárias a responder a tais tensões, mas a literatura e os resultados deste projeto de pesquisa mostram a necessidade de uma avaliação mais sistemática e de uma reflexão mais profunda sobre as mudanças ocorridas no currículo, pedagogia e avaliação. O sucesso do PB em termos de como a avaliação é experimentada pelos docentes não está evidente nos dados que emergem deste estudo. No entanto, a ambição do PB é positiva, e mais esforços são necessários por parte das universidades para mitigar uma abordagem avaliativa puramente somativa. Esta pesquisa oferece evidências sobre o papel das condições e volume de trabalho em suas práticas avaliativas, bem como suas concepções sobre ensino, aprendizado e avaliação.

texto em

texto em