Introdução

A pandemia de coronavírus e o consequente isolamento social modificaram as estruturas das instituições de ensino. Toda uma geração pôde testemunhar como “[...] a escola não é somente um prédio” (CANI et al., 2020, p. 24) e que seus limites e barreiras não são físicos, mas sociais e, desde o ano de 2020, também virtuais. Todos os agentes envolvidos na Educação precisaram adaptar-se de algum modo e reinventar-se para dar conta da realidade que, de um dia para o outro, pressionou o desenvolvimento emergencial de tecnologias e metodologias que otimizassem a educação a distância. Nesse contexto, a avaliação adaptada ao ensino remoto, que há muitos anos vem sendo estudada em decorrência da explosão de cursos profissionalizantes e formação superior a distância, tornou-se objeto central na busca por soluções imediatas.

Este trabalho apresenta uma abordagem aplicada à disciplina de Geometria Analítica do curso de Licenciatura em Física do Centro Federal de Educação Tecnológica Celso Suckow da Fonseca (CEFET), campus Nova Friburgo, no estado do Rio de Janeiro, no período entre 2020 e 2021, marcado pelo ensino remoto emergencial devido ao isolamento social provocado pela pandemia. A abordagem visou solucionar o problema do plágio e da desonestidade acadêmica nos processos avaliativos realizados a distância, por meio da individualização de questões, e, teve como efeitos, a flexibilidade e a ampliação do tempo de execução da avaliação, o que auxiliou na redução do estresse do discente, bem como na redução do tempo de produção do instrumento avaliativo por parte do docente. Com isso, estima-se que a abordagem tenha reduzido os impactos negativos que, normalmente, incidem sobre as avaliações individuais e, por consequência, na progressão do aluno.

Para tanto, foi utilizada uma metodologia de modelagem matemática de enunciados de questões, criando provas originais e individualizadas, com as respectivas soluções e gabaritos, diminuindo, assim, as chances de cópia e compartilhamento de respostas. A modelagem do problema foi implementada em planilha eletrônica, o que permitiu o processo de geração em lote das questões e das provas per se, em forma de arquivos em PDF, com gabarito comentado individualizado, o que possibilitou, ainda, que a correção fosse completamente automatizada.

Aprendizagem e avaliação no ambiente on-line

Benson (2003) disserta sobre as correntes classificações da avaliação da aprendizagem que circulam nos estudos em Educação, bem como atividades e instrumentos avaliativos comumente associados a elas. Duas classificações que se encontram em distinção são a avaliação tradicional e avaliação alternativa, de modo que a primeira mede o quanto o aluno-recipiente conseguiu armazenar de conteúdo depositado, enquanto a segunda avalia habilidades de análise, síntese e avaliação do aluno ativo (SPECK, 2002 apud BENSON, 2003, p. 70). Cada uma das classes traz consigo um frame de atividades e instrumentos avaliativos associados.

O método tradicional aparece associado à avaliação quantitativa e classificatória, que se realiza por meio de questões fechadas e individuais.

O método alternativo, por sua vez, associa-se a uma variedade de tipos de avaliação denominados diagnóstico, formativo e somativo, que se diferem primordialmente por seus propósitos e finalidades. A avaliação diagnóstica visa a aferir, antecipadamente, o nível de preparação dos alunos relativo a um tópico; já a avaliação somativa possui objetivo de julgar e atribuir nota ao avaliar em que medida os objetivos de aprendizagem foram alcançados pelo aluno; a avaliação formativa, por sua vez não tem a finalidade de atribuir nota mas de prover feedback acerca do progresso e desenvolvimento no alcance dos objetivos de aprendizagem, podendo não contribuir com a avaliação global (HANSON; MILLINGTON; FREEWOOD, 2001 apud BENSON, 2003, p. 70). Tal método, pelo teor formativo, apresenta-se associado a questões abertas e reflexivas, acrescidas de “[...] noções de aprendizagem social e colaboração [que] incluem atividades em grupo, avaliação por pares, autoavaliação” (BENSON, 2003, p. 70, tradução nossa).

A pandemia de coronavírus fez emergir a necessidade de avaliar a distância e todo o conhecimento prévio acerca da avaliação teve de ser adaptado aos recursos disponíveis. Tal adaptação não ocorreu, contudo, do zero, já que, em decorrência do progressivo crescimento da oferta de cursos superiores a distância, já havia a necessidade e o interesse no desenvolvimento de modelos confiáveis e eficazes de avaliação da aprendizagem adaptados à realidade da educação a distância, de modo que esforços já haviam sido depreendidos e a comunidade acadêmica já contava com uma experiência acumulada em desenvolvimento e aplicação de métodos avaliativos on-line (CARUTH; CARUTH, 2013; KINASH et al., 2015; STONE; ZHENG, 2014). Do mesmo modo, já se teciam reflexões acerca dos componentes e princípios essenciais para uma aferição adequada na dada condição, as quais suscitavam questões tais como a garantia de integridade acadêmica (KEARNS, 2012) contra as práticas do plágio e de desonestidade acadêmica, problemas que muitos consideram se exacerbar na modalidade on-line, pelo fato de não se ver o aluno (BENSON, 2003). Por outro lado, Boitshwarelo, Reedy, Billany (2017) defendem não haver estudos conclusivos sobre a prevalência de desonestidade acadêmica em meios on-line, quando comparados à avaliação presencial convencional. Fato é que a avaliação a distância deve lidar com a possibilidade real de consulta tanto à rede quanto aos pares no enfrentamento ao problema da desonestidade acadêmica em direção a uma aferição mais precisa da aprendizagem individual.

Ademais, alguns segmentos de ensino, como o técnico e o superior possuem objetivos específicos que demandam essa garantia de integridade acadêmica. Guangul et al. (2020) ressaltam o fator classificatório da avaliação somativa, que baseia certificação e progressão nos estudos, como um dos objetivos imediatos do processo avaliativo. No ensino superior e técnico, devido a sua característica de formar profissionais para o trabalho, as expectativas sociais relativas à qualidade da certificação são ainda maiores.

Durante a migração para o ensino remoto, em 2020, para tentar contornar o problema da desonestidade acadêmica, algumas instituições de tradição presencial procuraram lançar mão de recursos disponíveis para adaptar a avaliação somativa presencial através da avaliação síncrona, com monitoramento ao vivo, através de webcams. O monitoramento por câmeras, muitas vezes com gravação, somado à incerteza de acesso à avaliação por conta da falibilidade dos serviços de internet e de dispositivos eletrônicos, do uso de dispositivos e recursos obsoletos, típico de famílias em situação de fragilidade econômica ou social, entre outros problemas específicos do contexto de crise sanitária, tudo isto intensificou o peso emocional da avaliação e apontou as limitações da modalidade síncrona, especialmente para fins classificatórios. Tal vulnerabilidade pode ter contribuído para o agravamento de um dos maiores problemas da avaliação: a questão emocional incidindo sobre a performance na hora da avaliação somativa. O peso decisivo da avaliação classificatória é dito “[...] evocar medo, ansiedade e estresse” (VAUGHAN; CLEVELAND-INNES; GARRISON, 2013 apud CONRAD; OPENO, 2018, p. 17, tradução nossa). Avaliações assíncronas, em oposição, mostraram-se uma opção mais bem adaptada ao contexto em questão por não demandarem que alunos e professor estivessem todos no mesmo ambiente, no mesmo intervalo de tempo, para a realização e entrega da avaliação. Tal modalidade de avaliação on-line permitiu, de certo modo, algumas medidas de adaptação em locais afetados por diversos problemas sociais evidenciados pela pandemia de coronavírus, tais como os apresentados por Rotas e Cahapay (2021), obtidos através da aplicação de questionários.

Guangul et al. (2020) apontam soluções para se obter um melhor diagnóstico utilizando os recursos disponíveis, dificultando a desonestidade acadêmica. Além de ressaltar aspectos essenciais da atribuição da avaliação, a exemplo de instrução clara, prazo razoável para conclusão, atendimento e acompanhamento das dificuldades, bem como a importância da honestidade acadêmica. Os autores sugerem que o professor adapte questões de modo a pressionar que cada aluno resolva e obtenha seus resultados em coerência com sua aprendizagem.

Este trabalho, então, propõe adaptações de questões logrando uma individualização da solução, que garanta, dentro do possível, um resultado individual. O uso de questões fechadas, para tanto, é proposto de forma associada a recursos tecnológicos que permitem que tal instrumento, frequentemente associado à avaliação tradicional, adquira traços formativos, além de benefícios, tais como:

a. Redução do tempo de criação, análise e correção de questões, para que o tempo de trabalho docente seja devidamente distribuído;

b. Redução do tempo de execução da avaliação e estímulo ao pensamento objetivo por parte do discente;

c. Restrição da abrangência de respostas, que podem tornar o processo de verificação demasiadamente complexo e subjetivo, portanto, mais suscetível a inconsistências na atribuição de conceitos e notas;

d. Possibilidade de automatização, tal como proposto neste trabalho, com criação e implementação em lote, sem perder de vista a individualização.

Há que se observar, ainda, as peculiaridades das áreas de conhecimento, especialmente no que tange ao ensino técnico e superior, uma vez que há profissões que, em várias de suas rotinas, demandam maior conhecimento prático e aplicação, a exemplo da disciplina na qual se desenvolveu o objeto deste trabalho, uma disciplina de Geometria Analítica, ofertada em um curso de graduação em Licenciatura em Física. No entanto, a proposta descrita neste artigo pode ser enxergada como framework capaz de viabilizar estratégias de avaliação alternativas que possam ser aplicadas em outras áreas do saber na abordagem de objetos do conhecimento formal e técnico, a exemplo da gramática das línguas.

Estudos anteriores em personalização e individualização de questões

Alguns esforços têm sido feitos na direção de se criar uma maneira viável de se atribuir avaliações individualizadas, de forma que diferentes discentes experimentem questões diferentes ao realizarem um teste. Lazarinis, Green, Person (2010), explicam sobre o funcionamento de um sistema de teste adaptativo computadorizado Computerized Adaptative Test (CAT), que pertence a uma classe de implementação de avaliação via computador que tenta avaliar o nível de instrução de cada aluno, selecionando questões adaptadas às suas características individuais. Havendo implementações que consideram outras variáveis e que são pedagogicamente mais promissoras, os autores propõem uma implementação de um sistema que utiliza critérios mais particulares do próprio aluno, tais como performance, objetivos e conhecimentos prévios, sendo que os critérios e regras são escolhidas pelo educador, e tais regras vão se atualizando dinamicamente à medida que o aluno responde às perguntas da avaliação. Basicamente, esses sistemas imitam o comportamento do educador de forma algorítmica, que ajusta as questões propostas em sua aula de acordo com as dúvidas que os alunos apresentam nas aulas. Essas soluções já foram implementadas por instituições acadêmicas, como a SIETTE, em 2004, e por empresas, como a GRE Exam, em 2006, e a Microsoft, em 1999. Algumas limitações associadas ao CAT foram também apontadas, como o fato de que adaptações de questões baseadas na performance do aluno podem limitar o uso em contextos pedagógicos alternativos.

Chyung et al. (2009) demonstram a aplicação de uma plataforma on-line que apresenta uma plataforma de e-learning, denominada ALEKS, muito conhecida na área de ensino de Ciência, Tecnologia, Engenharia e Matemática (STEM), que apresenta um processo de realização de tarefas sequenciado e com ajuste individual de dificuldade, que considera diferentes estilos de aprendizado, avalia a relação entre tais estilos, características motivacionais e performance acadêmica e provê feedback imediato na realização dos exercícios, ajustando e inserindo novos exercícios à medida que se identificam as dificuldades do discente.

Lazarinis, Green, Person (2010) apresentam sua alternativa, na qual um framework de avaliação é composto por uma série customizável de regras do tipo se-então-senão que são associadas ao conhecimento e objetivos do estudante. Por meio das questões atribuídas e das respostas, o ‘motor de adaptação’ tenta tirar algumas conclusões sobre o real conhecimento do aluno sobre o conteúdo e suas dificuldades em potencial.

Acerca da disponibilidade de questões autênticas, Liberatore (2011) pontua como a quantidade de livros didáticos e bibliografia sugerida para determinadas disciplinas é limitada, além de muitos exercícios e questões cujos desenvolvimento e solução são facilmente encontrados on-line. Com o livre fluxo de informações que a internet permite, muitos alunos conseguem ter fácil acesso a cadernos de soluções de exercícios. Dessa maneira, a utilização de listas de exercícios para verificação de sedimentação do aprendizado de conteúdos fica comprometida, uma vez que não é possível assegurar que respostas corretas dos exercícios advenham de estudos e tentativas individuais de entendimento e consequente solução; se as respostas foram copiadas de outros alunos que as obtiveram através de estudos ou se as respostas apenas foram copiadas de gabaritos disponíveis.

Esse tipo de problema que os professores têm enfrentado pode ser encontrado ao redor do mundo e muitas iniciativas têm surgido na direção de se propor alternativas. Em muitos casos, utiliza-se tecnologia para implementar algum nível de personalização dos exercícios, como a LON-CAPA, sigla para Learning Online Network (LON) with Computer Assisted Personalized Approach (CAPA), ou Rede de Aprendizado On-line com Abordagem de Personalização Assistida por Computador, da Universidade Estadual de Michigan. Nessas abordagens, usualmente a personalização é feita atribuindo-se diferentes exercícios para diferentes alunos ou atribuindo os mesmos exercícios para pequenos grupos de alunos, em que os exercícios mudam de grupo para grupo. Por exemplo, Liberatore (2011), em seu trabalho, explorou uma configuração de exercícios para casa, de modo que um grupo de teste de alunos da disciplina Balanceamento de Material e Energia recebeu dois conjuntos de exercícios: um conjunto de questões do livro usado na disciplina, sob a suposição de que as soluções estavam amplamente disponíveis on-line, e mais um conjunto de exercícios personalizados, entregues semanalmente e escritos à mão; outros dois grupos de controle mantiveram o regime de entrega de exercícios do livro e mais respostas a formulários digitais. Alguns dos exercícios atribuídos que foram personalizados continham versões modificadas dos exercícios do livro, com mudança de números do problema. O grupo que recebeu os exercícios personalizados apresentou menos acertos nesses exercícios, o que poderia estar relacionado não a uma diminuição da aprendizagem, mas o aumento das tentativas de resolução, e, portanto, dos erros, uma vez que as respostas finais não eram iguais a possíveis gabaritos disponíveis. Em outras palavras, o fato de os alunos não terem encontrado soluções prontas na internet pode tê-los pressionado a resolver as questões por conta própria, sem a possibilidade de cópia. Para conseguir implementar essa solução, o autor recorreu à empresa Sapling Learning, que disponibilizou o ambiente on-line para realização do experimento. O banco de questões foi criado pelo autor do artigo e ele ficou responsável por personalizar manualmente as questões, fazendo as modificações nos números a fim de obter resultados diferentes para cada variação de questão. Ao avaliar as diferenças entre as notas finais (composta de lista de exercícios e provas) dos alunos que receberam exercícios personalizados com os que não receberam, verificou-se que os alunos que receberam as questões personalizadas e que, na impossibilidade de cópia, foram pressionados a resolver as questões, tenderam a obter notas finais maiores, o que reforça a tese da personalização como dificultadora do plágio e aliada da aprendizagem.

Experimento avaliativo implementado

Com relação à educação profissional, em muitas interpretações sobre o processo de avaliação, existe a necessidade de segurança de aferição do desempenho individual, visto que uma certificação pretende atestar o conhecimento do discente em relação a um corpo comum de conceitos que sejam necessários ao exercício geral da profissão ou à expertise profissional. Nesse contexto, a personalização, quando concebida no sentido de adaptação ao desempenho pessoal, não parece desejável. Posto isto, este trabalho se direciona aos casos em que é necessário avaliar individualmente e é possível fazê-lo sem incorrer no risco de gerar testes de diferentes dificuldades.

No experimento avaliativo desenvolvido, diferentemente das listas de exercícios desenvolvidas pelos autores mencionados, foram criadas provas contendo questões similares, com variação nos parâmetros numéricos. É importante salientar que o objetivo principal desse experimento foi o de não fornecer, durante o período de ensino emergencial e num cenário de aulas e provas on-line, avaliações com questões idênticas para toda turma. A abordagem de questões individualizadas, nos moldes aqui descritos, pretendeu atuar como procedimento dificultador do processo de simples cópia de respostas entre alunos, embora a cópia dos procedimentos de solução ainda fosse possível em caso de comunicação entre eles. Tendo isso em vista, a implementação dessa solução passou por quatro principais etapas:

i. a idealização de um ambiente de criação e reaproveitamento de questões, com a modelagem dos parâmetros, geração de respostas e criação de gabarito comentado para cada variação da questão;

ii. uma plataforma que permitisse a criação em lote dessas avaliações de maneira o mais automática possível, a fim de se evitar erros humanos de geração de provas, que poderiam ter consequências sérias na validade dos arquivos de prova gerados e da coerência interna de cada questão;

iii. a forma de disponibilização das avaliações;

iv. a correção em lote das avaliações e de forma automática, a fim de evitar erros humanos no processo de correção, principalmente devido ao quantitativo enorme de respostas para cada questão dinâmica.

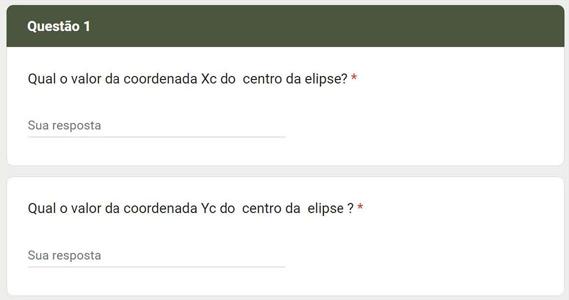

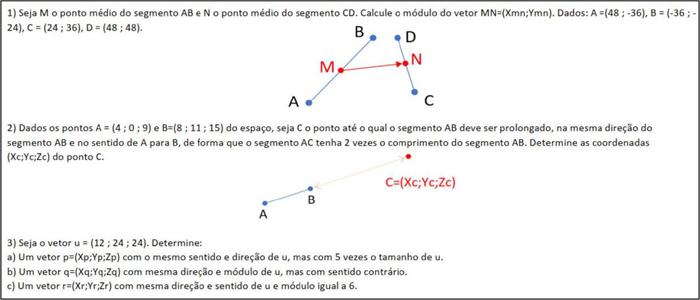

Para conseguir realizar as etapas (i) e (ii), consistindo na idealização de um ambiente que permita a criação e reaproveitamento de questões e automação da geração de variações para cada questão, bem como das respostas finais e gabarito comentado, foi utilizado o programa Microsoft Excel® do Pacote Office 365, uma vez que esse software de planilha eletrônica tem as características de permitir facilmente aplicação e criação de fórmulas e realização de cálculos matemáticos, mudança de texto nas planilhas de acordo com condições todo tipo se...então..., criação de gráficos etc. A implementação em planilha eletrônica consistiu na conversão de questões comuns em questões dinâmicas a partir da identificação de variáveis e constantes na composição do enunciado, o que permitiu a automatização da criação da questão (mediante variação das partes variáveis), bem como a automatização do cálculo das respostas e da emissão de gabarito comentado. A figura 1 mostra um recorte da planilha de questões dinâmicas criada, que consiste basicamente em um conjunto de células; uma célula com o texto dinâmico da questão, em preto e à esquerda; uma célula com o gabarito dinâmico comentado com as respostas, em vermelho e ao centro; e, por fim, algumas células com as variáveis do problema em azul e à direita, que, após serem definidas e calculadas, definem tanto a resposta final de cada questão quanto o texto que compõe a questão e o texto do gabarito. Nesse exemplo, a única variável da questão é a equação geral de cônica, que é um a variável dependente das variáveis Xc, Yc, a e b que estão à direita da figura e que definem a equação, mas não aparecem diretamente no texto, uma vez necessitam ser determinadas a partir da equação para que a questão seja resolvida.

À esquerda (em preto): questão dinâmica. Ao centro (em vermelho): gabarito comentado e dinâmico, com as respostas. À direita (em preto): variáveis independentes do problema.

Fonte: elaborada pelos autores.

Figura 1 Trecho da planilha eletrônica de automação de questão e gabarito

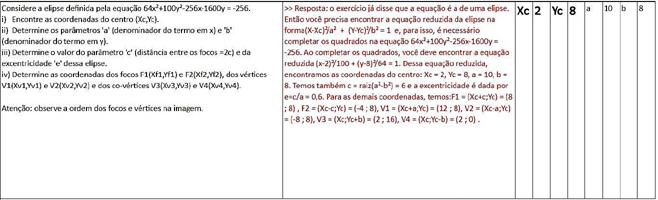

Para produzir avaliações, todas as questões dinâmicas, após configuradas, são colocadas uma após a outra em uma planilha que serve como template, no qual as variáveis são modificadas para cada prova que se deseja gerar. A figura 2 mostra três variações da questão, cujo texto é similar, com exceção da equação de cônica que define o problema e que, por consequência de ser única para cada prova, define também respostas finais fechadas e diferentes. No entanto, o processo para se determinar a resposta é igual para todas as variações, fazendo com que todas as questões geradas possuam mesmo grau de dificuldade. Para que fosse possível organizar as respostas para cada questão encontrada pelos alunos, as respostas foram colhidas através de formulário digital on-line, em que as perguntas fazem referência ao item perguntado em cada questão. A figura 3 mostra as perguntas referentes à questão apresentada na figura 2. Ao invés de incluir todo o texto da questão no formulário on-line, o formulário pede apenas que seja inserido o valor da variável Xc, que é a coordenada do centro da elipse da questão 1.

Fonte: elaborada pelos autores.

Figura 2 Três variações da questão dinâmica sobre a cônica elipse, onde a equação geral é a variável do problema

Após os alunos responderem ao formulário, a prova é então corrigida automaticamente, copiando as respostas dos alunos para uma planilha de respostas corretas de cada prova atribuída. Quando a resposta do aluno é igual à resposta correta, há pontuação do item; do contrário, a resposta é considerada errada. Para questões com resposta decimal, foi programada uma tolerância para a precisão da resposta encontrada pelo aluno. Após a correção da prova e liberação das notas, o aluno recebe uma versão de sua prova individualizada com a questão e o gabarito comentado, para que possa ver o procedimento de resolução e encontrar em qual etapa do processo de resolução ele possa ter cometido algum engano ou se não entendeu como resolver algum item, como mostra a figura 4.

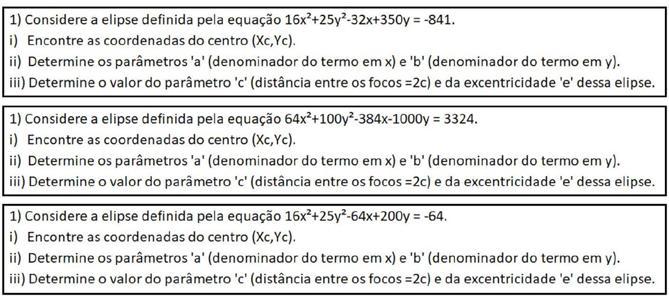

A figura 5 mostra um trecho da primeira prova online da disciplina, envolvendo conceitos mais básicos. Todos os números presentes nas questões são variáveis, sendo diferentes para cada prova. Portanto, embora os procedimentos de solução sejam iguais, cada prova define respostas finais únicas e diferentes para cada uma de suas questões.

Resultados e discussões

É importante salientar que esse procedimento se deu durante as aulas em regime remoto. A comparação entre avaliação tradicional deve ser feita com extrema cautela, pois as condições de ocorrência foram diferentes, e o intuito de tal comparação não é o de generalização. Tendo isso em mente, a fim de se obter alguma estatística que permitisse analisar a implementação da solução de avaliação individualizada, foi feita uma análise das notas finais obtidas pelos alunos da disciplina em alguns semestres. Para tanto, foram consideradas as notas finais dos alunos de três semestres do período de ensino remoto, entre 2020 e 2021, nos quais a proposta de avaliação personalizada foi implementada (Grupo 1, 38 valores), e médias finais dos alunos da disciplina em três semestres, que abrangeram o período pré-pandemia (Grupo 2, 51 valores), entre 2018 e 2019, na qual a avaliação presencial e tradicional foi utilizada. A nota final assume um valor no intervalo [0;10] para ambos os grupos. Ambos os grupos foram submetidos a quatro provas durante o semestre. Somente foram consideradas as notas finais de alunos que fizeram todas as avaliações da disciplina, independentemente de terem sido ou não aprovados. No entanto, uma diferença objetiva, que não pode ser desconsiderada na análise entre as abordagens tradicional e individualizada, consiste no tempo disponível para avaliação. Enquanto na avaliação tradicional em sala de aula o tempo médio de resolução da prova foi de 2 horas e 30 minutos, na avaliação remota o tempo médio entre poder acessar o arquivo de prova e ter de entregar a avaliação foi de 12 horas. As provas consistiram em questões de caráter objetivo, do tipo calcule, determine, encontre. Uma vez que a correção foi implementada de forma automática, pela comparação da resposta dada pelo aluno com a resposta correta da questão, não houve a verificação da resolução do aluno nem conferência manual dos raciocínios individuais, como ocorreu na avaliação do grupo dois (presencial/ tradicional). Para evitar que questões parcialmente corretas em algumas etapas acabassem sendo totalmente desconsideradas numa correção automatizada do tipo certo ou errado, à qual foram submetidas as avaliações do grupo 1, cada questão foi fracionada em várias perguntas sobre valores e cálculos intermediários, a fim de tentar contrabalancear a não verificação do raciocínio desenvolvido.

A fim de comparação, foram calculadas a média e a variância das médias finais para ambos os grupos. O grupo 1 obteve média μ1 =6,90, com desvio-padrão s1 =2,27, e o grupo 2 obteve média μ2 =3,25, com desvio-padrão s2 =2,84. Por fim, as duas amostras de médias finais, da abordagem tradicional e individualizada e remota, foram comparadas por meio de um teste-z para as médias dos dois grupos, cujos resultados podem ser vistos na tabela 1. Considerando a hipótese nula como sendo “H: não há diferenças entre as médias dos dois grupos”, nota-se que o valor de Z obtido é de 6,7469, o que coloca esse resultado na região crítica, com nível de significância α=0,05, indicando que devemos rejeitar a hipótese nula. Portanto, temos indicativo de que a abordagem de avaliação individualizada e remota parece resultar em maiores médias finais entre os alunos que fizeram todas as atividades da disciplina, quando comparada com o grupo que foi submetido ao modelo tradicional de avaliação presencial. No entanto, é importante salientar que não há como garantir que esse efeito de aumento de notas se tenha dado pela individualização das atividades, o que teria forçado os alunos a estudar desde o primeiro instrumento de avaliação e gerado incremento de aprendizagem, uma vez que há outros fatores influenciadores, dentre os quais os mais importantes de se pontuar sejam: (i) maior tempo disponível para resolução; e, (ii) possibilidade de trocas de informação de procedimentos de cálculos entre os alunos, mesmo que as respostas finais sejam diferentes. Entretanto, as provas do grupo 2 (presencial/ tradicional) também contaram com consulta a material/anotações e, consequentemente, a verificação de procedimentos também estava disponível, embora as opções de consulta do grupo 1 (online/ individualizadas) tenham sido mais amplas.

Tabela 1 Teste-z de duas amostras para as médias finais nos semestres analisados

| Grupo 1 | Grupo 2 | |

|---|---|---|

| Avaliação individualizada | Avaliação tradicional | |

| Média | 6,903289474 | 3,249346405 |

| Variância conhecida | 5,131796319 | 8,070969009 |

| Observações | 38 | 51 |

| Hipótese da diferença de média | 0 | |

| z | 6,746904853 | |

| P(Z<=z) uni-caudal | 7,55163E-12 | |

| z crítivo uni-caudal | 1,644853627 | |

| P(Z<=z) bi-caudal | 1,51033E-11 | |

| z crítico bi-caudal | 1,959963985 |

Fonte: Elaborada pelos autores.

Baseando-se nas estatísticas levantadas, há indícios de que a proposta de avaliação individualizada/remota tenha trazido como benefício uma maior média final na disciplina, o que poderia, numa análise mais superficial, ser correlacionado a um maior aprendizado do conteúdo; no entanto, dado que a quantidade de médias analisadas é relativamente pequena, é prudente evitar generalizações. Outro fator a ser considerado é o de que a abordagem descrita não possuía ferramental para garantir a integridade acadêmica na resolução das questões, possibilidade de troca de passo a passo de resolução entre alunos ou o efeito do tempo de resolução da prova, que foi maior no modelo on-line/individualizado, e que, dadas as condições do experimento, seriam impossíveis de se mensurar. É possível notar que a média desse grupo, mesmo sendo substancialmente maior do que a média do grupo da avaliação tradicional, ainda não supera os 70% da nota final. Esse fato pode ser um indicativo de que os alunos tiveram dificuldades em encontrar as questões resolvidas e prontas na internet, tendo sido necessário desenvolver todo o raciocínio de resolução ou ao menos terem de realizar todos os cálculos por conta própria, ainda que tenham utilizado calculadoras ou consultado exercícios similares na internet ou de outros alunos, sem desconsiderar, como dito anteriormente, que o grupo 2 (presencial/tradicional) também tinha a opção de consulta de material ou anotações. É também possível que o fator definidor da média final tenha sido apenas a necessidade individual de se realizar os próprios cálculos, caso tenha havido substancial troca de informações e procedimentos de resolução. Numa visão mais geral, o resultado obtido parece indicar que possíveis desonestidades na realização das provas, e que são esperadas ao se realizar avaliação on-line, foram atenuadas pela individualização da questão e resposta final, algo ao qual uma ocorrência de ceiling effect (médias próximas de 100%) poderiam nos remeter, embora não se possa fazer alegação de causalidade. A não ocorrência de floor effect (maioria das notas próximas do mínimo) indica que as questões provavelmente estavam bem calibradas. A tabela 2 mostra as diferenças de condições de realização das provas nos dois grupos tomados na comparação.

Tabela 2 Diferenças entre prova em regime presencial pré-pandemia e provas on-line individualizadas

| Item | Avaliação Presencial | Avaliação Remota |

|---|---|---|

| Janela de tempo para realização | 2,5 horas | 12 horas (para acesso)2 |

| Permitido consultar material | Sim | Sim |

| Permitido consultar a internet | Não | Sim1 |

| Permitido consultar outros colegas | Não | Sim1 |

| Questões iguais em provas de alunos diferentes | Sim | Não |

| Repostas fechadas | Sim | Sim |

| Raciocínio parcial e correto é pontuado | Sim | Não |

| Fracionamento das questões em cálculos intermediários | Não | Sim |

| Arquivo de gabarito comentado com passo-a-passo | Não | Sim |

| Resolução com passo-a-passo das questões em sala de aula | Sim | Sim |

| Questões similares às resolvidas em sala de aula na explicação do conteúdo | Sim | Sim |

| Tempo de resolução igual para todos os alunos | Sim3 | Não3 |

1Na impossibilidade técnica de monitorar ou impedir consulta, foi considerada permitida.

2O tempo de acesso ao arquivo de prova não necessariamente se iguala ao tempo de realização da prova, sendo apenas o tempo entre o horário em que o arquivo de prova ficou disponível na plataforma e o limite de horário para entrega da atividade.

3Não havia ferramenta para monitorar o tempo de resolução, mas de acordo com as conversas informais com alunos, os tempos totais de resolução foram diferentes.

Fonte: elaborada pelos autores.

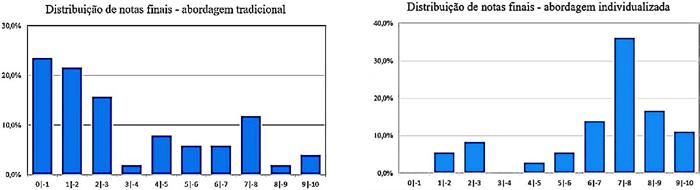

A figura 6 mostra a diferença nas distribuições de notas finais entre o grupo que realizou a prova na abordagem tradicional, nos semestres anteriores ao ensino remoto emergencial e a distribuição de notas entre os alunos que fizeram as provas remotas individualizadas. É fácil observar que ambas as distribuições aparentam uma certa bimodalidade, com a proporção mais expressiva de notas baixas no grupo que realizou a prova tradicional. A abordagem tradicional apresentou floor effect, com grande parte das notas finais agregadas em torno de valores próximos de zero, enquanto a distribuição das notas na abordagem individualizada não apresentou agregação de notas próximas da nota máxima (ceiling effect) ou da nota mínima (floor effect).

Fonte: elaborada pelos autores.

Figura 6 distribuição de notas finais do grupo de alunos que fizeram a prova tradicional (esquerda) e do grupo que fez a prova individualizada (direita)

As avaliações foram disponibilizadas na plataforma Microsoft TEAMS®, utilizada pela instituição de ensino superior. Para gerar os arquivos de prova, foi utilizada uma automação via VBA do Excel para gerar arquivos PDF. Os alunos precisavam acessar a atividade, abrir o PDF com seus nomes e matrículas e fazerem a avaliação em papel. Depois, bastava acessar o link do formulário e digitar as respostas e então fazer o upload das imagens das folhas contendo os cálculos. O nível de dificuldade desse procedimento de entrega de provas não foi considerado maior nem menor do que, por padrão, já estava sendo adotado na instituição desde o início do distanciamento em outras disciplinas. A opção por não utilizar somente o formulário eletrônico se deu pela possibilidade de haver erros e problemas na correção automática, fazendo com que a prova escaneada/ fotografada pelos alunos servisse como um backup do raciocínio desenvolvido. Também por permitir auditar possíveis erros na automação das questões.

Observações, impressões e considerações finais

Apesar da automatização de questões parecer ir na contramão dos princípios de humanização e da personalização que orientam a educação contemporânea, já que a produção em lote é frequentemente associada a metodologias mecanicistas, tal abordagem pode ser grande aliada no processo ensino e de aprendizagem por pretender, ao mesmo tempo, aumentar a originalidade e autenticidade de questões avaliativas e permitir que avaliações somativas sejam feitas em ambientes menos estressantes, com maior janela de tempo, diminuindo as chances de que o diagnóstico da aprendizagem seja prejudicado por fatores como desonestidade acadêmica e incidência de emoções negativas, quando a abordagem avaliativa prevê que seja possível e adequado tal método de verificação de aprendizado.

Quando comparadas avaliação tradicional presencial e avaliação assíncrona online, o tempo é um fator fundamental. Enquanto, na disciplina analisada, a janela de tempo de realização da prova tradicional precisava ser limitada pela quantidade de tempo de aula disponível no dia da prova, a avaliação individualizada e remota possuiu uma janela de tempo de aproximadamente 12 horas, em geral das 12:00 de um dia até as 12:00 do outro dia. O alargamento do prazo não implicou necessariamente em um maior número de horas de realização da prova, mas em uma possibilidade de realizá-la no momento mais oportuno dentro desse prazo. Observando o acesso dos alunos aos arquivos de prova e formulários, houve indícios de que muitos alunos não utilizaram todo o tempo disponível para fazer a prova, mas adaptaram o tempo de realização ao seu próprio tempo disponível. Quando perguntados sobre esta janela de tempo, eles pontuaram que aproveitaram para acessar a avaliação em intervalos no expediente de trabalho, entre prestação de serviços, obrigações pessoais ou entre atividades domésticas realizadas em suas próprias casas. Alguns, ainda, reportaram precisar fazer a prova em duas etapas: uma no horário de almoço do trabalho e outra ao chegar em casa. Também foi reportada pelos alunos a diminuição do estresse causado pela avaliação presencial e tudo o que a envolve, tais como a dificuldade de chegar no horário de início da prova ou de ficar até o final e a sensação de ansiedade para conseguir terminar a avaliação dentro do tempo programado. Além disso, a avaliação feita em casa pode ocorrer em ambiente familiar, potencialmente menos estressante e com mais chances de adequá-la a outras responsabilidades, o que pode ser importante para alguns alunos. Porém, o ambiente de avaliação não controlado introduz inúmeros ruídos de avaliação, possibilidade de outorga de realização da prova a terceiros, impossibilidades técnicas como falta de internet ou computadores e celulares, o que não pode ser desconsiderado ao se discutir sobre a real capacidade da avaliação medir aprendizado.

Quanto à questão da honestidade acadêmica e compartilhamento de respostas, os autores acreditam que, na ausência de resoluções e respostas prontas em gabaritos de livros e na internet, o prazo para a realização da avaliação foi suficiente para que cada um realizasse sua prova, resolvendo suas próprias questões ainda que tenha havido compartilhamento entre os alunos de procedimentos para resolução. De modo geral, as notas máximas foram tão raras quanto no regime tradicional e muitos alunos precisaram fazer a prova final, assim como em outros semestres. No entanto, como observado na figura 5, as notas, em geral, sofreram um deslocamento positivo. Esta abordagem, no entanto, não foi projetada de forma a poder explicar se tal comportamento se deu pela individualização, pela troca de informações entre alunos, pela maior janela de tempo de resolução, pela outorga, a terceiros, de realização da prova ou uma combinação desses ou de outros fatores não previstos. Entretanto, é importante salientar que outras propostas de atividades similares a provas ou listas de exercícios, a serem entregues pelos alunos como tarefas on-line, estariam sujeitas aos mesmos problemas durante o período de ensino emergencial remoto.

Os autores entendem que essa abordagem de automação e individualização de prova deva ser vista como um framework que permite reduzir os efeitos psicológicos e ruídos de julgamento que incidem sobre o diagnóstico da aprendizagem, além de demonstrar uma solução em avaliação não só para períodos de exceção, mas em cursos correntes nas modalidades a distância, híbridos ou em cursos presenciais. A individualização e automação nos moldes feitos nesse trabalho serviram como meio de dificultar desonestidade acadêmica em provas num momento de ensino emergencial, ao mesmo tempo que parece ter favorecido algum nível de colaboração entre estudantes, que reportaram terem ajudado uns aos outros em alguns casos, tendo, contudo, que desenvolver a própria resolução de cada questão. Também permitiu que o processo de correção fosse automático e rápido e sem demandar mais tempo de carga horária docente para correção, embora a implementação tenha demandado considerável tempo. Vale ressaltar que, uma vez criada a prova individualizada, seu reaproveitamento para um próximo semestre ou turma é imediato, pois basta modificar alguns parâmetros na planilha e todos os valores das questões, bem como dos gabaritos, são atualizados imediatamente.

Esse experimento deve ser visto como uma versão beta de uma proposta de individualização. As questões apresentadas aos estudantes foram basicamente as mesmas, mas com diferenças numéricas, pois numa primeira etapa de implementação, era necessário verificar a possibilidade de geração questões similares em lote, com respectivos gabaritos e resoluções com passo a passo. Isso fez com que as provas fossem essencialmente iguais em termos algorítmicos (os passos de resolução são basicamente os mesmos), o que, por um lado, garante que todos os alunos foram avaliados com o mesmo nível de dificuldade, mas que, por outro, significa que um aluno poderia desenvolver o procedimento de resolução, enquanto outros poderiam apenas seguir tais procedimentos, colocando peso efetivo apenas no procedimento de cálculo. Esse efeito foi previsto na etapa de idealização, dada a impossibilidade de se endereçar todos os problemas e consequências numa primeira versão. No entanto, para posterior criação de provas, não só numericamente, mas também com questões e enunciados efetivamente diferentes, como primeira etapa, era necessário verificar se as questões feitas em lote eram efetivas e funcionais. Se algum erro de procedimento fosse detectado após a distribuição das provas, isto poderia invalidar todo a avaliação e demandar correção manual, e a correção manual de inúmeras provas diferentes seria inviável em questão de demanda de tempo. Logo, como primeira etapa de testes, a opção por questões quase idênticas pareceu ser a ideal.

A individualização proposta não necessita ser feita em ambiente on-line ou com os objetivos aqui descritos. As provas podem ser impressas e entregues aos alunos, para serem realizadas no modo tradicional. O educador pode optar por distribuir a atividade como lista de exercícios individualizadas, a fim de preparar os alunos para provas. A atividade individualizada pode ser proposta como atividade em grupo, em que alunos de um mesmo grupo resolvem as mesmas questões, mas grupos diferentes terão respostas diferentes. Uma abordagem pedagógica que valorize a colaboração pode ser feita tendo por base as atividades individualizadas, e a pontuação pode ser uma combinação das respostas corretas obtidas com o grau de conexões que cada estudante desenvolve com seus peers no grupo de trabalho.

Como óbvias limitações dessa proposta, podemos citar: (a) o ambiente de realização da prova não pôde ser controlado pelo avaliador; (b) sem aparato tecnológico, foi impossível validar a identidade de quem realizou a prova, abrindo a possibilidade de realização ser outorgada a terceiros; (c) a implementação em planilha eletrônica demanda muito conhecimento específico, inviabilizando o amplo uso dessa solução sem a implementação de algum tipo de template; (d) construir questões dinâmicas não é de grande dificuldade, mas programar a prova o é, em especial pelo fato de que foi utilizado um software que não foi desenvolvido para este tipo de aplicação; (e) não havia ferramenta disponível para medir o tempo que os alunos passaram com o arquivo de prova aberto, se imprimiram ou se copiaram o arquivo; por fim, (f) discentes com menos obrigações e compromissos terão maior tempo para se dedicar à prova, criando um ponto de inequidade que deve ser considerado ao se planejar uma prova nesses moldes.

Os autores consideram que a experiência de criação de um framework para avaliações individualizadas foi bem-sucedida, embora deva ser vista como uma versão 1.0 desse tipo de abordagem. Muitos problemas foram detectados e sanados no processo. Antes de se prosseguir para questões individualizadas mais elaboradas, teóricas ou subjetivas, serão necessários mais testes utilizando questões fechadas objetivas, uma vez que problemas mais basilares são muito mais facilmente detectados e resolvidos nessas questões.