Serviços Personalizados

Journal

Artigo

Compartilhar

Revista Brasileira de Educação Médica

versão impressa ISSN 0100-5502versão On-line ISSN 1981-5271

Rev. Bras. Educ. Med. vol.45 no.2 Rio de Janeiro 2021 Epub 02-Jun-2021

https://doi.org/10.1590/1981-5271v45.2-20200460.ing

ARTIGO ORIGINAL

OSCE 3D: uma ferramenta virtual de avaliação de habilidades clínicas para tempos de pandemia de coronavírus

1 Centro Universitário Christus, Fortaleza, Ceará, Brasil.

2 Universidade Federal do Ceará, Fortaleza, Ceará, Brasil.

Introdução:

Em tempos de pandemia em que a “estratégia de bloqueio” tem sido adotada, é imprescindível a utilização de inovações utilizando recursos tecnológicos como a criação de instrumentos que possam substituir os métodos tradicionais de ensino-aprendizagem na formação dos profissionais de saúde.

Objetivo:

o objetivo deste estudo foi desenvolver e avaliar a usabilidade de um sistema computacional de simulação interativa realista utilizando tecnologia de imagem tridimensional e realidade virtual com ferramentas computacionais de acesso livre disponíveis na web.

Métodos:

o desenvolvimento de um protótipo (OSCE 3D) baseou-se nas etapas utilizadas para a construção de um software de simulação de um “Serious Game”. Foi utilizada a versão de acesso livre da plataforma Unity Editor 3D (Unity Technologies, versão 2018) para o desenvolvimento de jogos educacionais, software GNU Image Manipulation Program (GIMP, versão 2.10.12), Blender (versão 2.79) e MakeHuman (versão 1.1 .1) para criar texturas e modelos de construção de ambientes 3D. Uma fase experimental para avaliação da usabilidade foi realizada por meio de um questionário baseado na Escala de Usabilidade de Sistema. O estudo foi aprovado pelo Comitê de Ética em Pesquisa da instituição e todos os participantes assinaram o Termo de Consentimento Livre e Esclarecido.

Resultados:

um total de 39 alunos de graduação do 6º semestre de uma universidade privada do Nordeste do Brasil participaram voluntariamente da avaliação do OSCE 3D. A avaliação de usabilidade resultou em pontuação média de 75,4 com margem de erro de 3,2, sendo esta considerada uma boa usabilidade de acordo com a literatura.

Conclusões:

este trabalho permitiu o desenvolvimento de um protótipo de baixo custo, utilizando um sistema de simulação realista tridimensional para avaliação de habilidades clínicas. Este produto, ainda em fase de protótipo, apresentou boa usabilidade.

Palavras-chave: Simulação por Computador; Ensino; Avaliação; Realidade Virtual; Infecções por Coronavírus; Pandemias

Introduction:

In pandemic times, in which the “lockdown strategy” has been adopted, the use of innovations using technological resources such as the creation of instruments that can replace traditional teaching-learning methods in the training of health professionals is essential.

Objective:

the aim of this study was to develop and evaluate the usability of a realistic interactive simulation computer system using three-dimensional imaging technology and virtual reality with free-access computational tools available on the web.

Methods:

the development of a prototype (OSCE 3D) was based on the steps used for the construction of a “Serious Game” simulation software. The free-access version of the Unity Editor 3D platform (Unity Technologies, version 2018), used for developing educational games, the software GNU Image Manipulation Program (GIMP, version 2.10.12), Blender (version 2.79) and MakeHuman (version 1.1.1) were utilized for creating textures and building models of the 3D environments. An experimental phase was carried out to assess usability, through a questionnaire based on the System Usability Scale. The study was approved by the Research Ethics Committee of the institution and all participants signed the Informed Consent Form.

Results:

a total of 39 undergraduate medical students attending the 6th semester of a private university center of northeastern Brazil voluntarily participated in the evaluation of the OSCE 3D. The usability evaluation resulted in a mean score of 75.4 with a margin of error of 3.2, which is considered a good usability score according to the literature.

Conclusions:

this study allowed the development of a low-cost prototype, using a three-dimension realistic simulation system for clinical skills assessment. This product, even in the prototype phase, showed good usability.

Keywords: Computer Simulation; Teaching; Assessment; Virtual Reality; Coronavirus Infections; Pandemics

INTRODUÇÃO

Trabalhar com educação à distância e avaliação à distância em um curso com diversas atividades práticas exige criatividade dos educadores1),(2. Embora a avaliação cognitiva à distância já seja uma realidade em muitas universidades, a avaliação prática das habilidades clínicas tem sido um desafio a ser enfrentado3.

A avaliação do tipo Exame Clínico Objetivo Estruturado (OSCE, do inglês Objective Structured Clinical Examination) passou a ser utilizada mais amplamente na educação médica. No entanto, por ser uma estratégia cara, algumas tentativas de usar a computação e ambientes virtuais para simular situações clínicas começaram a aparecer globalmente. Esses sistemas utilizam diferentes tecnologias para simular o exame clínico estruturado, alguns com interação via texto ou voz, outros através da interação com imagens e vídeos em uma interface intuitiva4),(5.

Estratégias tecnológicas têm sido utilizadas para ampliar e adaptar a educação em saúde. Técnicas e soluções de design de jogos podem ser empregadas para criar a realidade simulada e a experiência de algo real6),(7. Ferramentas para utilizar a avaliação de habilidades clínicas com o uso de computadores já foram descritas. Porém, poucas delas foram validadas ou tiveram seu desenvolvimento descrito e utilizaram plataformas disponíveis na web8),(9. Um OSCE virtual é um conceito novo para a maioria das instituições, portanto, é preciso despender um tempo significativo planejando o formato para atender às necessidades individuais10.

Na avaliação das habilidades clínicas, um experimento bem-sucedido foi realizado, utilizando técnicas de simulação realistas em um ambiente virtual tridimensional (3D), com um sistema simulador interativo de casos clínicos. De acordo com os alunos que participaram do estudo, o sistema melhorou as habilidades de comunicação e profissionalismo3.

Outro simulador com tecnologia imersiva baseada na web, desenvolvido no University Hospital of Cologne, na Alemanha, permitiu a avaliação de habilidades em pacientes cirúrgicos, com impacto no desempenho quando comparado ao OSCE tradicional e com aumento na motivação dos alunos11.

Lidar com a pandemia da COVID-19 e o uso da “estratégia de lockdown” têm sido desafios significativos para a educação médica12),(13. O uso de avaliações com o Exame Clínico Objetivo Estruturado (OSCE) tradicional, com planejamento adequado, foi relatado na Duke-National University Singapore Medical School, durante um período de alto risco de contaminação pela COVID-1914.

Como nossos OSCEs presenciais convencionais foram cancelados devido aos riscos para os alunos, examinadores e pacientes causados pela pandemia da Covid-19, avaliações de comunicação clínica, habilidades práticas e habilidades de exame, por exemplo, tornaram-se um verdadeiro desafio para escolas de saúde. Todos os esforços são necessários para não atrasar a formação de novos médicos, que passarão a compor a força de trabalho da área médica15),(16.

O objetivo deste trabalho foi desenvolver um protótipo que simule o OSCE tradicional, utilizando ferramentas de acesso livre disponíveis na internet, e avaliá-lo quanto à usabilidade por alunos de graduação em medicina.

MÉTODOS

Esta é uma pesquisa aplicada, que desenvolveu o protótipo de uma ferramenta tecnológica utilizando computação gráfica, para uso na avaliação de habilidades clínicas do tipo OSCE, seguida de uma fase experimental que avaliou a usabilidade desse protótipo, de janeiro a novembro de 2019.

Desenvolvimento do protótipo do OSCE 3D

O OSCE 3D foi desenvolvido com a participação de uma equipe multiprofissional composta por três professores de um curso de medicina e um de informática, um analista de sistemas, um programador e um designer gráfico. A composição multiprofissional da equipe de desenvolvimento teve como objetivo construir um sistema que atendesse às necessidades dos alunos no que se refere à autoaprendizagem. Para isso, foi utilizada a metodologia de Co-Design, composta por cinco fases:

Escopo: visão geral dos objetivos de aprendizagem;

Compreensão compartilhada: troca de experiências entre as partes interessadas sobre os cenários, tipos de tecnologias e metodologias pedagógicas como base para o aplicativo;

Brainstorming: esboçando as interfaces primárias para o software;

Refinamento: modelagem das telas do aplicativo, imagens, casos clínicos e desenho das atividades;

Implementação: desenvolvimento interativo do software com entregas incrementais. Durante o processo, as fases III, IV e V foram revisadas ciclicamente para melhorar o sistema17.

O protótipo foi desenvolvido como um simulador baseado em estação de trabalho para ser instalado em um computador e oferecer uma imersão com gráficos tridimensionais (3D), não limitada pela transmissão pela internet. Foi utilizada a versão pessoal de livre acesso para alunos e iniciantes da plataforma Unity Editor 3D (Unity Technologies, versão 2018) para o desenvolvimento de jogos e simulações educacionais. Os softwares adicionais de livre acesso GNU Image Manipulation Program (GIMP, versão 2.10.12), Blender (versão 2.79) e MakeHuman (versão 1.1.1) também foram utilizados para criar texturas e construir modelos de ambientes 3D.

O método utilizado para desenvolver o ambiente virtual do OSCE 3D foi o mesmo para criar jogos de computador em 3D tradicionais com uma abordagem realista dos ‘serious games’18. As etapas utilizadas para desenvolver o protótipo do OSCE 3D foram (1) Conceito de simulação (objetivos, características visuais, tipo de interatividade, descrição dos personagens, material técnico da simulação, modelo de avaliação e feedback); (2) Desenho da interface do usuário, preparação de imagens e texturas do ambiente virtual (botões de interação, seleção de texturas de objetos e materiais na cena); (3) Modelagem em 3D do ambiente e personagens (criação de modelos em 3D, personagens humanos e suas animações); (4) Desenvolvimento da plataforma de simulação (formatação do cenário, importação de objetos e programação do movimento e interatividade do jogador); (5) Criação do sistema de escore e feedback do aluno; e (6) Testes de funcionalidade e ajustes finais.

Desenvolvimento de estações práticas para o protótipo do OSCE 3D

Os principais elementos das estações tradicionais de OSCE foram reproduzidos através de simulação utilizando realidade virtual. Foram coletadas informações clínicas e anatômicas da literatura médica para compor 03 casos clínicos, que foram utilizados para compor as estações do protótipo do OSCE 3D. O espaço físico dos corredores de um laboratório de habilidades clínicas, consultórios médicos com materiais para exames e comandos de porta foram modelados para o ambiente de realidade virtual. Os scripts com as possíveis respostas foram criados para serem apresentados na tela de acordo com a ativação dos dispositivos de interação. Listas de verificação preenchidas automaticamente, de acordo com as opções escolhidas, foram adicionadas ao sistema e apresentadas como feedback ao final de cada estação.

Avaliação do protótipo do OSCE 3D

Esta fase do estudo teve um caráter intervencionista e exploratório, de natureza quantitativa e buscou avaliar a usabilidade do OSCE 3D pelos alunos.

Participantes

Os participantes eram alunos do curso de graduação em medicina da instituição e que estavam cursando o sexto semestre, e foram convidados a participar voluntariamente, selecionados por amostragem não probabilística. De acordo com a literatura, amostras de pelo menos 12 participantes são suficientes para avaliar a usabilidade utilizando o mesmo método aplicado neste estudo19.

A escolha dos alunos do terceiro ano do curso de medicina foi motivada pelo fato de esses alunos já estarem familiarizados com o método tradicional de avaliação do OSCE.

O curso de medicina da instituição teve início em 2006, com 60 alunos por turma (semestre). Desde então, foram realizadas seis avaliações de alunos através dos OSCEs tradicionais a cada ano, para todas as turmas, incluindo o internato.

Avaliação de usabilidade (fase experimental)

Os alunos passaram pelo mesmo processo de preparação para uma avaliação por OSCE tradicional. Antes da avaliação, eles foram confinados e receberam orientações gerais sobre o acesso ao sistema. Em seguida, os alunos foram ao laboratório de informática da instituição e acessaram o protótipo do OSCE 3D. Não houve apoio ou interferência dos pesquisadores para não interferir na avaliação da usabilidade.

Imediatamente após a utilização do sistema, os alunos avaliaram a usabilidade através de um questionário altamente confiável baseado na Escala de Usabilidade do Sistema (SUS, do inglês System Usability Scale)20),(21, validada para o português22, composta por 10 itens, respondida através da escala Likert de 5 pontos para identificar concordância ou discordância23. Os 10 itens do questionário aplicado são: item 1 “Eu usaria este sistema com frequência”; item 2 “Achei o sistema desnecessariamente complexo”; item 3 “Achei o sistema fácil de usar”; item 4 “Acho que precisaria da ajuda do suporte técnico para poder utilizar este sistema”; item 5 “Achei que as várias funções do sistema estavam bem integradas”; item 6 “Achei que havia muitas inconsistências neste sistema”; item 7 “Imagino que a maioria das pessoas aprenderia a usar esse sistema rapidamente”; item 8 “Achei o sistema muito pesado para usar”; item 9 “Me senti muito confiante ao usar o sistema”; e o item 10 “Precisei aprender várias coisas antes de poder continuar usando o aplicativo”.

O cálculo do escore de usabilidade foi obtido somando-se a contribuição individual de cada item. Para itens ímpares, 1 ponto foi subtraído do valor atribuído à resposta. Para os itens pares, o cálculo foi feito subtraindo-se o valor atribuído à resposta do total de 5 pontos. Para o cálculo do escore total, o valor obtido da soma dos itens pares e ímpares foi multiplicado por 2,5. Ao final, o escore total da escala de usabilidade variou entre 0 e 100 pontos23.

Análise estatística

Os dados foram tabulados no programa Microsoft Excel for Windows™ e exportados para análise estatística no programa Statistical Package for the Social Sciences (SPSS), versão 20.0 (IBM). Os dados foram apresentados com frequências absolutas e percentuais. O coeficiente alfa de Cronbach foi utilizado para estimar a confiabilidade dos questionários aplicados, e o limite inferior de 0,70 foi utilizado para confiabilidade aceitável24.

Aspectos éticos

O estudo foi aprovado pelo Comitê de Ética em Pesquisa da instituição, CAAE: 84915418.3.0000.5049, estando em conformidade com a Resolução 466/12 do Conselho Nacional de Saúde e a Declaração de Helsinque. Os sujeitos da pesquisa participaram voluntariamente, após assinatura do Termo de Consentimento Livre e Esclarecido, e não foram identificados, a fim de garantir a confidencialidade das respostas.

RESULTADOS

Protótipo do OSCE 3D

O protótipo do sistema de simulação realista OSCE 3D foi desenvolvido para uso em computadores, na versão offline, para plataforma Windows, com o objetivo de reproduzir a avaliação pelo método OSCE de forma virtual, dirigido a alunos do curso de graduação em medicina. O sistema simula um espaço 3D de um laboratório de habilidades clínicas (Figura 1a).

Fonte: tela do protótipo OSCE 3D capturada pelos autores.

Figura 1a Espaço tridimensional de um laboratório de habilidades clínicas simulado pelo protótipo OSCE 3D.

Os objetos de um consultório médico e as características físicas detalhadas com os movimentos faciais e respiratórios do paciente virtual foram simulados pelo protótipo a fim de obter o máximo de realismo (Figura 1b).

Fonte: tela do protótipo OSCE 3D capturada pelos autores.

Figura 1b Consultório médico e características físicas de um paciente virtual simulado pelo protótipo OSCE 3D.

O movimento do operador dentro do ambiente 3D foi programado para permitir a interação e o exame do paciente virtual com 3 eixos de liberdade: rotação e aproximação (+/- zoom). Este recurso foi adicionado para permitir ao aluno obter o melhor ângulo de visão durante o exame (Figura 1c).

Fonte: tela do protótipo OSCE 3D capturada pelos autores.

Figura 1c Interação de um paciente virtual através dos comandos de rotação e de zoom pelo protótipo OSCE 3D.

A interface de navegação e a interatividade foram realizadas através do uso do mouse e do teclado, com seleção de ícones e textos na tela durante toda a execução para facilitar sua usabilidade. A interação ocorre através de uma barra de tarefas com as opções “Diálogo”, “Examinar”, “Solicitar exames”, “Prescrever” e “Diagnosticar” (Figura 1d). Ao selecionar cada um deles, um menu lateral é aberto com opções a serem selecionadas.

Fonte: tela do protótipo OSCE 3D capturada pelos autores.

Figura 1d Barra de tarefas para interação com um paciente virtual simulado pelo protótipo OSCE 3D.

Ao final de cada estação, uma tela de feedback é apresentada com os escores, as opções selecionadas pelo aluno e a comparação com as opções mais adequadas. Foi adicionado ao sistema um cronômetro de contagem regressiva, que é acionado a partir do momento em que o aluno dá o comando para entrar na estação.

Avaliação da usabilidade do sistema pelos alunos

Um total de 39 alunos avaliaram a usabilidade do protótipo OSCE 3D através do questionário baseado na escala SUS, sendo a maioria do sexo masculino (53,8%), com média de idade de 23,2 ± 0,5 anos, variando de 20 a 38 anos. A avaliação identificou bom grau de usabilidade, com escore médio total de 75,4, variando de 52,5 a 90, com margem de erro de 3,2 e intervalo de confiança de 95% de 72,2 a 78,6.

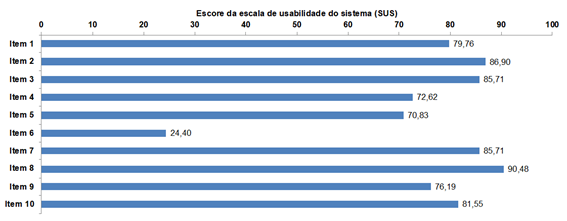

Na análise da resposta individual a cada item do questionário, constatou-se que a maioria deles obteve escore superior a 70 (Gráfico 1). A exceção a esse achado foi o item 6, que apresentou um escore de 24,4, que afirma “Achei que havia muitas inconsistências neste sistema”.

Gráfico 1 Avaliação da usabilidade do protótipo OSCE 3D através do questionário System Usability Scale (SUS) por alunos de graduação em medicina (N = 39).

A análise das respostas ao questionário da escala SUS revelou que elas apresentaram confiabilidade aceitável, com coeficiente alfa de Cronbach de 0,714 para todos os itens.

DISCUSSÃO

Um protótipo foi desenvolvido para uso na avaliação de habilidades clínicas, utilizando tecnologia da computação gráfica. Este protótipo mantém características que são típicas do OSCE tradicional e agrega vantagens próprias dos simuladores virtuais, como o uso de um ambiente lúdico.

A modalidade de simulação baseada em realidade virtual utilizando ambientes 3D tem sido descrita como uma alternativa que pode trazer bons resultados para a aprendizagem e a avaliação na educação em saúde, em comparação com os caros modelos de simuladores físicos26.

Várias plataformas online têm sido utilizadas recentemente para executar OSCEs virtuais, incluindo Microsoft Teams, Zoom, Google Hangouts e Adobe Connect. Cada plataforma tem seus prós e contras e é frequentemente atualizada com novos recursos. Embora seja possível avaliar a maioria das habilidades utilizando uma configuração online, as configurações autênticas podem ajudar os candidatos a se sentirem mais confortáveis, com menos impacto no foco da estação10.

Um estudo realizado recentemente no Children’s Hospital de Cincinnati (EUA) com casos pediátricos avaliou a percepção de alunos do terceiro ano de medicina submetidos a um simulador de casos clínicos, construído com a mesma plataforma de desenvolvimento de jogos (Unity) utilizada neste estudo. Verificou-se que a maioria dos alunos concordou fortemente que as simulações eram clinicamente precisas (97,4%) e que abrangiam os principais objetivos de aprendizagem (100%). Além disso, o simulador de realidade virtual foi mais eficaz do que as aulas tradicionais, ensino à distância e aprendizagem com manequins de baixa fidelidade. Os alunos também identificaram que o treinamento com o simulador virtual foi classificado como igual ou mais eficaz, em termos de aprendizagem, do que os manequins de alta fidelidade e uso de pacientes padronizados. A única modalidade na qual o simulador virtual foi avaliado como menos eficaz foi quando comparado ao ensino à beira do leito26.

Usabilidade

O protótipo desenvolvido neste estudo apresentou boa usabilidade após avaliação por um grupo de alunos de graduação em medicina. A usabilidade é a capacidade do software de ser compreendido, aprendido, operado e atraente para o usuário, quando utilizado sob condições especificadas27. Para validar a usabilidade do protótipo OSCE 3D, foi adotado o questionário padrão de avaliação da escala SUS, que já vem sendo utilizado em estudos para análise de softwares educacionais28),(29.

De acordo com alguns autores, um escore com pontuação superior a 68,5 corresponde a um grau de usabilidade aceitável21. Em outra publicação sobre a interpretação dos resultados obtidos com o questionário da escala SUS, os mesmos autores identificaram que um escore acima de 73 para um software seria considerado como apresentando boa usabilidade30. Na avaliação da usabilidade do protótipo do OSCE 3D, a média do escore da escala SUS foi de 75,4, sendo, portanto, considerado “Bom” de acordo com o método empregado.

Durante a análise por item das respostas obtidas pelo questionário com base na escala SUS, observou-se que o item 6 (“Achei que havia muitas inconsistências neste sistema”) foi o único que obteve um escore médio abaixo de 70. Um estudo anterior que utilizou a escala SUS para avaliar um ambiente virtual de aprendizagem observou interferência no escore devido a falhas técnicas relacionadas à configuração de hardware e rede, que influenciam o uso do sistema31. Esse resultado pode ser uma consequência do viés na interpretação dos alunos do termo “inconsistências no aplicativo”, devido a possíveis instabilidades e travamentos durante a execução do protótipo nas máquinas do laboratório de informática, não adaptadas para computação gráfica.

Uma explicação é que isso depende do nível de experiência ou exposição do “produto”. Outro motivo pode estar relacionado à complexidade do produto32),(33. Em alguns casos, os profissionais precisam se adaptar a um novo sistema e aprender como integrá-lo à sua rotina de trabalho34. Embora a escala SUS seja preferida como o padrão da indústria para avaliação simples e confiável de usabilidade e permita a comparação com a usabilidade de outras tecnologias utilizadas rotineiramente, ela tem limitações. Em particular, seu objetivo é avaliar a satisfação, mais do que as dimensões de eficiência e eficácia35.

Em uma revisão sistemática de ambientes imersivos com pacientes simulados utilizando tecnologia 3D, foram identificadas 13 publicações com relevância na educação médica8. Dessas publicações, apenas cinco realizaram um estudo de validação, um com validade de conteúdo36, dois com satisfação37),(38 e dois com melhoria de desempenho39),(40. Nenhum deles validou a usabilidade do sistema, o que limita nossa comparação com outros estudos sobre sistemas de avaliação de estudantes.

Os estudantes precisam de uma quantidade considerável de treinamento para garantir que seu desempenho não seja afetado pelo formato da avaliação e, em vez disso, reflita sua competência clínica. Além de treinar os candidatos na plataforma virtual OSCE, é necessário treinar os hosts, examinadores e role players. Todos precisam estar familiarizados com a logística de como ele funcionará. As oportunidades futuras também devem incluir feedback obtido dos candidatos e examinadores antes de os resultados serem disponibilizados.

Limitações

Como limitações do estudo, deve-se considerar que ele foi realizado em um único centro universitário e restrito à avaliação de usabilidade. No momento, não foi possível compará-lo com a avaliação de habilidades clínicas através do OSCE tradicional, portanto, não há evidências que apoiem uma ou mais das principais inferências. A ausência de computadores adaptados para uso de softwares de computação gráfica é outro fator que pode ter influenciado a avaliação dos alunos. Além disso, ainda não foi possível, pelo fato de ainda ser um protótipo, avaliar habilidades de comunicação ou de procedimentos.

Outra limitação pode ser o fato de o protótipo ainda não estar acessível online, pois isso implica na necessidade de instalação de um aplicativo e dificulta a atualização.

Inovações

Este estudo é inovador ao descrever as etapas para o desenvolvimento de um simulador 3D baseado em estação de trabalho, não limitado pela transmissão pela internet, com ferramentas computacionais de acesso livre disponíveis na web, que podem ser utilizadas na avaliação de habilidades clínicas como o OSCE.

O protótipo desenvolvido pode favorecer positivamente melhorias em termos de viabilidade econômica, mobilidade, reprodutibilidade, menor necessidade de recursos humanos, logística e espaço físico. Além disso, o sistema OSCE virtual pode ter outras aplicações, como a avaliação formativa, além das aplicações óbvias em situações de pandemia.

CONCLUSÃO

Foi possível desenvolver o protótipo de um ambiente 3D imersivo de simulação realista com computação gráfica, utilizando ferramentas de livre acesso disponíveis na internet e com funcionamento independente da web, que buscou simular uma avaliação do tipo OSCE tradicional. Ele mostrou boa usabilidade.

Por se tratar de uma versão ainda inicial de um método de avaliação virtual de habilidades clínicas, mais estudos são necessários para explorar outros aspectos relacionados à funcionalidade desse protótipo ou de outras versões semelhantes, aplicáveis em tempos de estratégias de lockdown para enfrentar pandemias como a COVID-19.

REFERÊNCIAS

1. Patil NG, Chan Y, Yan H. SARS and its effect on medical education in Hong Kong. Med Educ. 2003;37(12):1127-8. [ Links ]

2. Donkin R, Askew E, Stevenson H. Video feedback and e-Learning enhances laboratory skills and engagement in medical laboratory science students. BMC Med Educ . 2019;19(1):310. [ Links ]

3. Yang W, Hebert D, Kim S, Kang B. MCRDR Knowledge-Based 3D Dialogue Simulation in Clinical Training and Assessment. J Med Syst. 2019;43(7):200. [ Links ]

4. Johnsen K, Dickerson RF, Raij A, Harrison C, Lok B, Stevens AO, et al. Evolving an immersive medical communication skills trainer. Presence: Teleoperators and Virtual Environments. 2006;15:(1):33-46. [ Links ]

5. Courteille O, Bergin R, Stockeld D, Ponzer S, Fors U. The use of a virtual patient case in an OSCE-based exam--a pilot study. Med Teach. 2008;30(3):e66-76. [ Links ]

6. van Gaalen AEJ, Brouwer J, Schönrock-Adema J, Bouwkamp-Timmer T, Jaarsma ADC, Georgiadis JR. Gamification of health professions education: a systematic review. Adv Health Sci Educ Theory Pract. 2020 Oct 31. Epub ahead of print. [ Links ]

7. Middeke A, Anders S, Schuelper M, Raupach T, Schuelper N. Training of clinical reasoning with a Serious Game versus small-group problem-based learning: A prospective study. PLoS One. 2018;13(9):e0203851. [ Links ]

8. Kleinert R, Wahba R, Chang DH, Plum P, Hölscher AH, Stippel DL. 3D immersive patient simulators and their impact on learning success: a thematic review. J Med Internet Res. 2015;17(4):e91. [ Links ]

9. Brossier D, Sauthier M, Alacoque X, Masse B, Eltaani R, Guillois B, et al. Perpetual and Virtual Patients for Cardiorespiratory Physiological Studies. J Pediatr Intensive Care. 2016;5(3):122-8. [ Links ]

10. Hopwood J, Myers G, Sturrock A. Twelve tips for conducting a virtual OSCE. Med Teach . 2020:1-4. [ Links ]

11. Chon SH, Hilgers S, Timmermann F, Dratsch T, Plum PS, Berlth F, et al. Web-Based Immersive Patient Simulator as a Curricular Tool for Objective Structured Clinical Examination Preparation in Surgery: Development and Evaluation. JMIR Serious Games. 2018;6(3):e10693. [ Links ]

12. Li L, Xv Q, Yan J. COVID-19: the need for continuous medical education and training. Lancet Respir Med. 2020;8(4):e23. [ Links ]

13. Mian A, Khan S. Medical education during pandemics: a UK perspective. BMC Med. 2020;18(1):100. [ Links ]

14. Boursicot K, Kemp S, Ong T, Wijaya L, Goh SH, Freeman K, et al. ‘Conducting a high-stakes OSCE in a COVID-19 environment’, Med Ed Publish. 2020;9(1):54. [ Links ]

15. Musa TH, Ahmad T, Khan M, Haroon H, Wei P. Global outbreak of COVID-19: a new challenge? J Infect Dev Ctries. 2020;14(3):244-5. [ Links ]

16. Bedford J, Enria D, Giesecke J, Heymann DL, Ihekweazu C, Kobinger G, et al. WHO Strategic and Technical Advisory Group for Infectious Hazards. COVID-19: towards controlling of a pandemic. Lancet. 2020;395(10229):1015-8. [ Links ]

17. Millard D, Howard Y, Gilbert L, Wills G. Co-design and co-deployment methodologies for innovative m-learning systems. In: Goh TT, (Ed). Multiplatform E-Learning Systems and Technologies: Mobile Devices for Ubiquitous ICT-Based Education. New York: IGI Global 2010. [ Links ]

18. Zyda M. From Visual to Virtual Reality to Games. Computer. 2005;38(9):25-32. [ Links ]

19. Sauro J. A practical guide to the system usability scale: Background, benchmarks & best practices. Measuring Usability LLC 2011. [ Links ]

20. Brooke J. SUS: a “quick and dirty” usability scale. In: Jordan PW, Thomas B, Weerdmeester B, McClelland IL, editors. Usability evaluation in industry. London: Taylor & Francis; 1996. p. 189-94. ISBN: 100748404600 [ Links ]

21. Bangor A, Kortum P, Miller J. An Empirical Evaluation of the System Usability Scale. Int J Hum Comput Interact. 2008;24(6):574-94. [ Links ]

22. Tenório JM, Cohrs FM, Sdepanian VL, Pisa IT, de Marin HF. Desenvolvimento e Avaliacão de um Protocolo Eletrônico para Atendimento e Monitoramento do Paciente com Doença Celíaca. Rev Inform Teór Aplic. 2011;17(2):210-20. [ Links ]

23. Lewis JR, Sauro J. The Factor Structure of the System Usability Scale. In: Kurosu M. (eds) Human Centered Design. HCD 2009. Lecture Notes in Computer Science, vol 5619. Springer, Berlin, Heidelberg 2009. [ Links ]

24. Bonett DG, Wright TA. Cronbach’s alpha reliability: Interval estimation, hypothesis testing, and sample size planning. J Organ Behav. 2014;36(1):3-15. [ Links ]

25. Haerling KA. Cost-Utility Analysis of Virtual and Mannequin-Based Simulation. Simul Healthc 2018;13(1):33-40. [ Links ]

26. Zackoff MW, Real FJ, Cruse B, Davis D, Klein M. Medical Student Perspectives on the use of Immersive Virtual Reality for Clinical Assessment Training. Acad Pediatr. 2019;19(7):849-51. [ Links ]

27. Brooke J. “SUS: a “quick and dirty” usability scale”. In PW Jordan B, Thomas BA, Weerdmeester & AL McClelland (eds.). Usability evaluation in industry . London: Taylor and Francis 1986. [ Links ]

28. Zbick J, Nake I, Milrad M, Jansen M. A web-based framework to design and deploy mobile learning activities: Evaluating its usability, learnability and acceptance. In: 2015 IEEE 15th International Conference on Advanced Learning Technologies (ICALT) p. 88-92. [ Links ]

29. Chung H, Chen S, Kuo M. A study of EFL college students’ acceptance of mobile learning. Procedia - Social and Behavioral Sciences. 2015;176:333-9. [ Links ]

30. Bangor A, Kortum P, Miller J. Determining what individual SUS scores mean: Adding an adjective rating scale. Journal of usability studies. 2009;4(3):114-23. [ Links ]

31. Boucinha RM, Tarouco LMR. Avaliação de Ambiente Virtual de Aprendizagem com o uso do SUS - System Usability Scale. RENOTE Revista Novas Tecnologias na Educação. 2013;11(3):1-10. [ Links ]

32. Borsci S, Federici S, Bacci S, Gnaldi M, Bartolucci F. Assessing user satisfaction in the era of user experience: comparison of the SUS, UMUX, and UMUX-LITE as a function of product experience. Int J Hum Comput Interact . 2015;31(8):484-95. [ Links ]

33. Roxo-Gonçalves M, Martins MAT, Martins MD, Schmitz CAA, Dal Moro RG, D’Avila OP, et al. Perceived usability of a store and forward telehealth platform for diagnosis and management of oral mucosal lesions: A cross-sectional study. PLoS One . 2020;15(6):e0233572. [ Links ]

34. Mol M, van Schaik A, Dozeman E, Ruwaard J, Vis C, Ebert DD, et al. Dimensionality of the system usability scale among professionals using internet-based interventions for depression: a confirmatory factor analysis. BMC Psychiatry. 2020;20(1):218. [ Links ]

35. Melnick ER, Dyrbye LN, Sinsky CA, Trockel M, West CP, Nedelec L, et al. The Association Between Perceived Electronic Health Record Usability and Professional Burnout Among US Physicians. Mayo Clin Proc. 2020;95(3):476-87. [ Links ]

36. Cohen D, Sevdalis N, Patel V, Taylor M, Lee H, Vokes M, et al. Tactical and operational response to major incidents: feasibility and reliability of skills assessment using novel virtual environments. Resuscitation. 2013;84(7):992-8. [ Links ]

37. Heinrichs WL, Youngblood P, Harter PM, Dev P. Simulation for team training and assessment: case studies of online training with virtual worlds. World J Surg. 2008;32(2):161-70. [ Links ]

38. Youngblood P, Harter PM, Srivastava S, Moffett S, Heinrichs WL, Dev P. Design, development, and evaluation of an online virtual emergency department for training trauma teams. Simul Healthc . 2008;3(3):146-53. [ Links ]

39. Funke K, Bonrath E, Mardin WA, Becker JC, Haier J, Senninger N, et al. Blended learning in surgery using the Inmedea Simulator. Langenbecks Arch Surg. 2013;398(2):335-40. [ Links ]

40. Knight JF, Carley S, Tregunna B, Jarvis S, Smithies R, de Freitas S, et al. Serious gaming technology in major incident triage training: a pragmatic controlled trial. Resuscitation . 2010;81(9):1175-9. [ Links ]

Recebido: 04 de Outubro de 2020; Aceito: 28 de Março de 2021

texto em

texto em