INTRODUÇÃO

Com o propósito de contribuir para as discussões em educação na área de Avaliação Educacional, o objetivo desta pesquisa consistiu em analisar como foram usados os resultados do Programa Internacional de Avaliação de Estudantes (PISA), no contexto educacional brasileiro, por parte dos gestores dos sistemas de ensino para a melhoria da educação básica do país.

Para o desenvolvimento deste trabalho, utilizamos tanto a definição de avaliação educacional estabelecida por Vieira e Tenório (2010), autores que compreendem a avaliação como uma atividade que envolve diagnóstico, uso de resultados e melhoria do processo com participação dos interessados, quanto a definição de avaliação de sistemas de ensino, defendida por Freitas (2009) e compreendida como um retrato do sistema educacional.

Freitas (2009, p. 47) define as avaliações de sistema ou em larga escala como um

[...] instrumento de acompanhamento global de redes de ensino com o objetivo de traçar séries históricas do desempenho dos sistemas, [...] com a finalidade de reorientar políticas públicas.

Vale dizer que este trabalho está de acordo com essa visão, na medida em que o PISA é considerado um programa que pode gerar um retrato do sistema educacional brasileiro segundo um olhar externo, capaz de fornecer dados comparáveis aos de diversos países, com contextos similares ou díspares. Desse modo, é possível concordar com Ferreira e Coelho (2011) no sentido de que os resultados dessa avaliação e seus usos envolvem tanto o aperfeiçoamento do programa como servem de subsídio para a implementação de políticas educacionais no Brasil.

Metodologia

O objetivo da primeira parte do trabalho consistiu em se conhecer a natureza das pesquisas sobre o PISA no Brasil. Realizamos uma revisão sistemática de literatura (RSL), metodologia frequentemente utilizada em pesquisas da área de saúde, a qual ainda timidamente integra estudos das ciências sociais e humanas. Trata-se

[...] de um tipo de investigação focada em questão bem definida, que visa a identificar, selecionar, avaliar e sintetizar as evidências relevantes disponíveis. (GALVÃO; PEREIRA, 2014, p. 183)

A RSL foi realizada a partir da definição de palavras- -chave, idioma, período e critérios, e, considerando-se a relevância para a área, foram consultados os seguintes periódicos e plataformas: banco de dados da Associação Nacional de Pós-graduação e Pesquisa em Educação (Anped); Banco de Dados de Teses e Dissertações da Coordenação de Aperfeiçoamento de Pessoal de Nível Superior (Capes); e três periódicos de relevância na área de Educação e Avaliação (Cadernos de Pesquisa, Ensaio: Avaliação e Políticas Públicas em Educação e Estudos em Avaliação Educacional). Essa consulta resultou no conhecimento de 22 produções sobre o tema, no período de 2000 a 2015.

A RSL foi útil para mostrar quais aspectos do PISA têm sido investigados no Brasil e em outros países do mundo, como Escócia, Portugal e França. Essa metodologia nos auxiliou na justificativa da importância do tema em função da baixa produção de pesquisas vinculadas ao estudo do PISA enquanto avaliação de larga escala, principalmente porque os trabalhos encontrados tratam mais de questões específicas do programa, ligadas a uma das áreas de conhecimento avaliadas (Linguagem, Matemática ou Ciências).

Elegemos, como fonte de dados, documentos disponíveis nos sites da Organização para a Cooperação e Desenvolvimento Econômico (OCDE), Australian Council for Educational Research (ACER) e Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira (Inep), principalmente os relatórios apresentados por esse instituto, após cada ano de aplicação do PISA (BRASIL, 2001, 2007a, 2010, 2013, 2016), e pela OCDE (ORGANISATION FOR ECONOMIC CO-OPERATION AND DEVELOPMENT − OECD, 1999, 2000, 2003, 2009, 2010, 2013, 2015). Além desses documentos, selecionamos reportagens e publicações em periódicos e livros, a partir das quais foram feitas consultas sistemáticas com a atualização dos documentos do programa, publicados periodicamente. Isso incluiu a gestão sistemática do Inep, de modo a garantir o acesso a documentos não disponíveis publicamente.

Na fase seguinte, por meio de entrevistas semiestruturadas e estruturadas aplicadas aos gestores da educação básica e aos envolvidos com o PISA no Brasil, aliadas à análise de documentos de implementação de políticas públicas para a educação básica no período de 2000 a 2016, mapeamos os usos dos resultados obtidos no PISA em nosso país, de modo que se tornou possível investigar como os gestores dos sistemas de ensino utilizam tais resultados.

Os entrevistados foram selecionados por meio da leitura dos documentos e arquivos referentes ao PISA e devido ao envolvimento com o programa ou com o papel de gestor desempenhado na implementação de políticas públicas federais e estaduais em educação. Foram entrevistados gerentes e ex-gerentes do PISA, do Inep (Gerentes A e B), da coordenação da Superintendência de Acompanhamento e Avaliação do Sistema Educacional e da coordenação da Superintendência de Desenvolvimento da Educação Básica (Coordenação A e B), sendo esses últimos gestores de sistema de ensino.

Professores, diretores e coordenadores foram convidados a indicar, por meio de solicitação enviada eletronicamente, se o PISA havia sido aplicado em sua escola ou em outras unidades. Nenhuma resposta positiva foi recebida, e dois professores enviaram mensagens perguntando sobre o que era o PISA e como poderiam cadastrar seus alunos para participar da referida avaliação. Esse desconhecimento sobre o programa também foi apresentado por participantes de eventos nacionais, cujas plenárias eram constituídas, em grande parte, por professores e gestores da educação básica. Esses profissionais, no início da apresentação de seus trabalhos1 (cerca de 30 a 40 participantes em cada apresentação), foram questionados pelos autores desta pesquisa, e suas respostas foram predominantemente negativas sobre o PISA. Esse dado nos fez repensar e definir que as entrevistas deveriam ser realizadas apenas entre gestores de sistemas de ensino da educação básica.

Todos os entrevistados autorizaram a gravação e a publicação das entrevistas, as quais auxiliaram na busca de outras informações, consideradas irrelevantes para constar dos relatórios, mas que apareceram nos relatos orais dos gestores. Os roteiros das entrevistas consistiram em aspectos de logística de aplicação, conhecimento do PISA enquanto avaliação, divulgação e análise de resultados, influência do PISA em outras avaliações nacionais e, principalmente, em aspectos relacionados com a utilização dos resultados para elaboração de políticas educacionais.

Coletamos também, de modo não sistemático, as reportagens encontradas sobre o PISA no período de 2000 a 2014 em jornais, revistas de circulação nacional e sites (Veja, Isto é, Carta Capital, Caros Amigos, Época, O Globo, Folha de São Paulo, Estadão, UOL Educação e G1), as quais foram organizadas a partir do roteiro específico criado para a pesquisa. Além da leitura de reportagens que tratavam de temas afins, como a situação da educação, escolas, avaliação, professores, realizamos buscas com a palavra-chave PISA nos sites desses órgãos de imprensa. Essas reportagens serviram como evidência do modo como o PISA é mostrado à sociedade brasileira e como se deu sua apresentação ao longo dos anos.

Inicialmente, os dados coletados em relatórios oficiais, sites oficiais das organizações e dos governos federal e estadual, jornais, revistas, nas entrevistas e na revisão de literatura, forneceram elementos para o estabelecimento das categorias a serem analisadas e apresentadas no decorrer do artigo. Assim, foi possível apresentar conclusões e apontar elementos que favoreceriam uma maior disseminação dos resultados e seu uso.

Avaliação educacional, o PISA e os (des)usos de seus resultados

A definição de avaliação atenta mais para o uso que se faz dos resultados que para os resultados propriamente. Esse conceito implica um processo coletivo, com comprometimento dos envolvidos para a tomada de decisão e melhoria do que está sendo avaliado. O papel do avaliador é o de mediador, e a ação avaliativa estende-se para além da tomada de decisão, com vistas ao aperfeiçoamento do processo. Nessa perspectiva, a definição que norteia este trabalho, é que a avaliação é

[...] uma atividade que consiste no levantamento de informações fidedignas e precisas sobre um objeto ou processo, para subsidiar uma tomada de decisão com vistas à melhoria do objeto ou processo. (TENÓRIO; LOPES, 2010, p. 65)

O entendimento dessa nuance oferece a possibilidade de discutir o que se apresenta no PISA para além da divulgação e comparação entre países, sem que se entenda e se reflita sobre seus contextos. A partir da apreciação dos resultados e da análise dos documentos, arquivos e entrevistas realizadas, foi possível perceber que a participação brasileira no PISA gerou, além dos resultados descritivos - obtidos com a aplicação dos instrumentos -, outros de igual importância, a saber: apropriação da metodologia do programa; compatibilização das escalas de proficiência do PISA e da Prova Brasil para estabelecimento da média para o Ideb de 2021; e um parâmetro de definição de áreas prioritárias no Programa de Desenvolvimento Profissional de Professores (PDPP) da Capes.

O uso dos resultados de uma avaliação é um elemento essencial para subsidiar as tomadas de decisões; é o elo entre o diagnóstico, a tomada de decisão e a melhoria do processo. Conforme afirma Diaz (2000, p. 302),

[...] el evaluador no pueda prescindir del análisis y explicación de las relaciones que existen entre los resultados e recomendaciones que emite en sus informes, las decisiones que se toman al respecto y las consecuencias que estas tienen socialmente.

Segundo Dantas (2009), Weiss (1999) e Coelho (2012), é necessário entender o uso para além da aplicação direta dos resultados de uma avaliação, já que existem outros elementos de igual importância em relação aos resultados que também devem ser utilizados por gestores, como o “planejamento, a implementação e finalização de uma experiência avaliativa” (DANTAS, 2009, p. 75).

Diaz (2000, p. 302) aponta para a necessidade de maximizar o uso dos resultados de uma avaliação, por meio de relatórios, a partir de quatro caminhos: (1) qualificar os relatórios da avaliação; (2) identificar os potenciais usuários de seus resultados; (3) tornar os relatórios mais operativos e claros para o público; e (4) difundir adequadamente os resultados. Esses caminhos alertam para a necessidade de que os avaliadores se envolvam em todo o processo de avaliação, principalmente conhecendo o público interessado nos resultados, para que consigam apresentar produtos condizentes com a finalidade daquela avaliação.

Weiss (1999) afirma que são diversos os usos da avaliação e que eles podem ser definidos no início, mas também podem surgir no decorrer e ao final do processo. A utilização dos resultados de uma avaliação não consiste em uma caixa fechada e pré-determinada; o processo e a conclusão podem levantar uma série de usos que não estavam previstos durante a elaboração dessa avaliação. Vale também ressaltar que o público envolvido no processo − seja nas fases de elaboração e execução, seja aquele ligado à temática avaliada, o qual receberá os resultados − pode fazer usos que emergirão desses resultados após reflexões e debates.

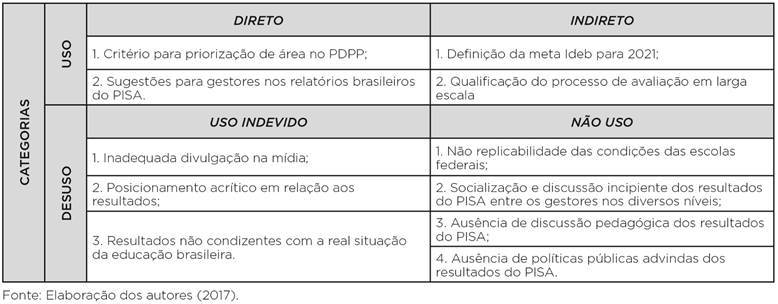

Em relação ao PISA, inicialmente buscamos apenas o uso dos resultados do programa, mas à medida que a investigação avançou, surgiram utilizações relativas à sua concepção, metodologia e execução, para além dos resultados do teste e dos questionários do PISA, gerando, assim, nossa primeira categoria: a de Usos. Esses usos podem ser diretos (a partir dos resultados do diagnóstico) e indiretos (por meio dos elementos que compõem o PISA), e essa categoria congrega os aspectos positivos da utilização dos resultados do PISA no Brasil.

Outra questão proposta na literatura por autores como Coelho (2012) e Worthen, Sanders e Fitzpatrick (2004) é o não uso dos resultados de uma avaliação. Sobrinho (2003, p. 58) chama a atenção para o fato de que “nem sempre os resultados da Avaliação são levados em conta para estabelecer as políticas governamentais”. Essa foi uma questão que nos orientou na busca de diferentes usos dos resultados do PISA, pois permitiu que também olhássemos, além das efetivas ações, para um contexto de possibilidades de ações não implementadas.

Foi no contexto dessas possibilidades que percebemos, em relação ao PISA, uma gama de resultados não utilizados, ou, ainda, resultados utilizados indevidamente. Essa constatação condicionou a criação de outra categoria, a de Desusos, subdivida em Não uso, referente a resultados do programa não utilizados pelos gestores, e Usos indevidos, que consiste na utilização inadequada dos resultados do PISA, assim considerada na perspectiva de avaliação desta pesquisa.

Entendemos que essas duas categorias de análise (Tabela 1) para o uso do PISA e de seus resultados são de grande valor para o campo da pesquisa em Avaliação Educacional, uma vez que elas apresentam resultados que podem ser utilizados de diversas maneiras, pois não são apenas consequências do diagnóstico realizado.

De acordo com essas categorias, apresentaremos um estudo sobre o uso do PISA e seus resultados no Brasil.

Usos dos resultados do PISA no Brasil

A categoria Uso emerge do levantamento, em documentos, do uso dos resultados do PISA para a melhoria da qualidade da educação. Inicialmente buscamos se havia a utilização dos resultados dos instrumentos aplicados pelo PISA, mas a investigação apontou, de forma mais contundente, um uso de aspectos referentes à concepção, metodologia e execução do programa. Isso levou à ampliação dessa categoria para além do uso de resultados diretos, subdividindo-a em Uso direto e Uso indireto.

A categoria Uso direto apresenta a utilização vinculada diretamente aos resultados dos testes e questionários do PISA-Brasil, na qual encontramos dois usos: (1) critério para priorização de área no PDPP e (2) sugestões para gestores nos relatórios brasileiros do PISA. Já a categoria Uso indireto consiste nas utilizações que envolvem elementos constituintes do programa, no que se refere às suas concepções, metodologia e execução. Também encontramos dois resultados: (1) definição da meta do Índice de Desenvolvimento da Educação Básica (Ideb) para 2021 e (2) qualificação do processo de avaliação em larga escala.

Critério para priorização de área no PDPP

Ao fazer a análise dos documentos, como editais, relatórios, portarias e projetos, podemos afirmar que raramente o PISA aparece explicitado nesses textos. Dentre todos os documentos lidos, disponibilizados pela Capes, pelo Conselho Nacional de Desenvolvimento Científico e Tecnológico (CNPq) e Ministério da Educação (MEC), há apenas uma referência ao programa, que foi encontrada no Relatório de Gestão da Diretoria de Educação Básica da Capes − 2009/2013 (BRASIL, 2013). Esse relatório cita o desempenho brasileiro no PISA, na Prova Brasil e no programa Ciências sem Fronteiras como um dos critérios para priorização das áreas de oferta do PDPP:

Análises das candidaturas dos jovens brasileiros ao programa Ciência sem Fronteiras e da situação do domínio de Língua Portuguesa, Matemática e Ciências (pelos dados da Prova Brasil e os do PISA) fizeram a DEB [Diretoria de Educação Básica da Capes] iniciar o processo de cooperação internacional com os professores de línguas estrangeiras, componente curricular do ensino fundamental e médio. Na sequência, seguem ações voltadas para professores de Ciências, Matemática, Educação Infantil e para gestores escolares. (BRASIL, 2013, p. 201)

Uma referência implícita aos resultados de todas as avaliações realizadas pode ser facilmente encontrada nesses documentos quando se coloca, como justificativa para a criação de programas educacionais, o baixo desempenho nas avaliações por parte dos alunos, sem especificação, ou ainda, como objetivo dos programas, a melhoria da qualidade da educação:

Esta Chamada Pública selecionará projetos no âmbito do Pibid a fim de cumprir os seguintes objetivos do Programa: [...] c) promover a melhoria da qualidade da educação básica [...]. (BRASIL, 2007b, p. 2) Ou ainda: Induzir e fomentar a oferta de educação superior, gratuita e de qualidade, para professores em exercício na rede pública de educação básica, para que estes profissionais possam obter a formação exigida pela Lei de Diretrizes e Bases da Educação Nacional - LDB e contribuam para a melhoria da qualidade da educação básica no País. (BRASIL, 2010)

Outra justificativa consiste em fomentar a utilização dos indicadores educacionais produzidos pelo Inep:

§ 1º São objetivos específicos do programa [Programa Observatório da Educação (Obeduc)]: III - estimular a utilização de dados estatísticos educacionais produzidos pelo Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira (INEP) como subsídio ao aprofundamento de estudos sobre a realidade educacional brasileira. (BRASIL, 2012, p. 1)

O que fica latente, a partir dos anos 2000, é a existência de um maior número de investimentos em projetos e programas voltados para a valorização do magistério e para a melhoria da qualidade da educação básica. Isso se reflete, inclusive, na criação de uma diretoria específica na Capes, exclusiva para as demandas da educação básica.

Ao serem questionados quanto ao uso dos resultados do PISA, os gestores entrevistados não conseguiram apontar um uso direto de tais resultados. Eles apenas indicaram, de forma genérica, que utilizam as avaliações como justificativa para a criação de políticas públicas sem, no entanto, conseguir apontar como e onde elas seriam usadas:

O resultado do PISA tem sido utilizado para a definição das estratégias da Secretaria de Educação; então, nós temos os dez compromissos pela educação, onde ali são colocados todas as, os eixos, os dez eixos que a Secretaria de Educação definiu como estratégia de planejamento até 2015, né? Porque, se os... esses dez eixos estão no plano plurianual, no PPA, e esses eixos são definidos a partir de todas as avaliações externas, né, do Ideb, PISA, então ali tem ações definidas, tanto para alfabetização na idade certa, quanto na garantia de permanência, né, nas ações de enfrentamento ao abandono, repetência, distorção idade/série, né? (Coordenação A, 2013)

O que podemos inferir é que, pautados por essas justificativas e objetivos, os resultados do PISA podem ter sido considerados no momento de elaboração de tais propostas, mas de forma genérica, sem que se tenha efetivamente debruçado sobre os resultados e seus significados e sem que isso seja explicitado nos documentos vinculados às políticas públicas.

Uso direto 2: sugestões para gestores nos relatórios brasileiros do PISA

Um dos usos de resultados que consideramos fundamentais são os que emergem dos relatórios, os quais possibilitam, aos interessados na temática avaliada, a disseminação de ações que promovam a melhoria do processo investigado.

Os relatórios do PISA não apontam de forma objetiva ações que podem ser efetivadas a partir dos resultados apresentados. No decorrer de um dos textos, existem sugestões feitas, de forma sutil, pela equipe de elaboração do relatório PISA no Brasil (BRASIL, 2013), tais como: refletir sobre as experiências de gestão estadual e municipal, em que se tem mais autonomia para os gestores das escolas (diretores); observar as experiências dos estados que conseguiram estabelecer políticas bem-sucedidas de correção de fluxo; estabelecer políticas específicas de combate à repetência com foco na aprendizagem e suporte aos estudantes; analisar os resultados em cada área, de modo a dedicar mais atenção aos processos nos quais o desempenho brasileiro foi menor; considerar a implementação de políticas específicas para os municípios pequenos com pior desempenho na média.

Mais uma vez, ressaltamos que essas considerações não estão explícitas no texto do relatório como orientações e determinações, mas apenas como sugestões de ações que poderiam ser realizadas por gestores dos sistemas de ensino.

Uso indireto 1: definição da meta Ideb para 2021

Um dos usos mais evidentes da participação brasileira no PISA consiste no estabelecimento da meta para o Ideb, pois foi uma das únicas utilizações apontadas nas entrevistas e encontradas nos documentos analisados, como podemos observar em uma resposta obtida:

Olha, o [resultado] mais direto que a gente pode apontar é a criação do Ideb. O Ideb é [Índice] Desenvolvimento da Educação Básica e ele foi pensado a partir de um estudo dos níveis de proficiência do PISA. (Gerente A, 2013)

A média 6,0 no Ideb, a ser alcançada até 2021, foi estabelecida após a compatibilização das proficiências do PISA e do Sistema de Avaliação da Educação Básica (Saeb), que equivale a 500 na escala do PISA. Essa compatibilização é atualmente a média dos países membros da OCDE, o que demonstra claramente o interesse brasileiro em estar alinhado com o perfil dos países que fazem parte dessa organização. Cabe aqui salientar que a compatibilização foi realizada a partir da hipótese de que o rendimento dos alunos brasileiros na Prova Brasil e no PISA é equiparável em termos de resultados dos testes. Ou seja, o desempenho de um aluno deve ser aproximadamente o mesmo nos dois testes. Deve-se observar, contudo, que essa é apenas uma hipótese. Se de fato ele não for equiparável, ou seja, caso o desempenho dos alunos seja superior em quaisquer das duas avaliações, essa compatibilização realizada entre as escalas não é válida.

Sendo esse ainda um estudo em aberto, a hipótese é válida e oferece a meta Ideb por meio da escala de proficiência do PISA, a qual as escolas devem alcançar até 2021.

Uso indireto 2: qualificação do processo de avaliação em larga escala

O último uso indireto identificado e considerado o mais importante pelos entrevistados é o ganho brasileiro em termos de know-how em avaliação:

[...] mas a história que eu conheço é que nós entramos para o PISA porque foi assim a primeira avaliação internacional de que o Brasil participou, e trazia a possibilidade de conhecer uma nova metodologia de avaliação em larga escala, enfim, um know-how que nós não tínhamos ainda na época. Na verdade, o Brasil já estava começando, na década de 90, a trabalhar com a Teoria de Resposta ao Item, já estava buscando o conhecimento de ponta nessa área de avaliação, e o PISA era uma oportunidade de aprofundamento desses conhecimentos e de ampliar o nosso know -how nessa área [...] Olha, os ganhos são tantos, mas tão... tem tanto a ver com os trabalhos do dia a dia... (Gerente A, 2013) Esse intercâmbio auxilia no aprimoramento das avaliações nacionais e do corpo técnico do INEP, que podem eventualmente conhecer e incorporar técnicas de avaliação internacionalmente reconhecidas ou mesmo analisá-las e rechaçá-las em virtude da realidade nacional. (Gerente B, 2013)

Essa aprendizagem influenciou a realização das avaliações nacionais com o aprofundamento sobre a Teoria de Resposta ao Item, por exemplo, e a definição de proficiências como parâmetros para as avaliações, como afirma um dos entrevistados:

[...] pois é, mas aí a questão dos níveis de proficiência foi uma coisa que mudou nas nossas avaliações também, a partir do estudo, né, que a gente fez da metodologia usada no PISA. (Gerente A, 2013)

Em relação aos usos diretos apresentados, não houve qualquer análise específica sobre os resultados do PISA para o direcionamento de políticas educacionais. Os usos diretos demonstrados são de fundamental importância principalmente para a aprendizagem de métodos para execução de avaliação em larga escala. Era de se esperar, no entanto, que uma avaliação que tenha tanto a ensinar, em termos técnicos, tivesse seus resultados esmiuçados, os quais poderiam direcionar, de forma mais efetiva, ações para melhoria da educação, ao menos nas áreas avaliadas.

Os poucos pesquisadores que têm se debruçado sobre o trabalho de analisar o PISA e seus resultados (PRAZERES, 2009; AGUIAR, 2008; MACHADO, 2005; WAISELFISZ, 2009) já apontam questões bem específicas que, caso fossem utilizadas para orientação de políticas educacionais, promoveriam melhorias pelo menos nas áreas em que o diagnóstico é realizado. Diante dos quatro usos dos resultados do PISA, salientamos a importância de cada um deles, mas entendemos que há muitas outras utilizações possíveis, vinculadas à implementação de políticas públicas, por exemplo, principalmente se levarmos em conta que o programa tem sido executado há 16 anos.

Desusos dos resultados do PISA no Brasil

Das duas categorias estabelecidas, a que mais apresentou elementos foi a de desusos do PISA no Brasil. Os dados mostram que não são realizadas gestões a partir dos resultados do programa e que, quando esses resultados aparecem no discurso, são apenas em nível de comparação entre países. Inicialmente, ao estabelecer a categoria Desusos, pensávamos em resultados que poderiam ser usados e em modos de utilização dos resultados que não eram efetivados. No decorrer da coleta dos dados para essa fase, percebemos que havia resultados utilizados de forma indevida, segundo nossa concepção de avaliação. Assim, a categoria Desusos também se dividiu em duas subcategorias: Uso indevido, referente à utilização dos resultados do PISA de forma indevida, e Não uso, referente à não utilização de resultados do PISA.

Uso indevido 1: inadequada divulgação na mídia

Desde o início da aplicação do PISA, por meio das reportagens que coletamos nos jornais e revistas de circulação nacional, foi possível perceber que há uma preocupação da mídia em alardear a posição do país no ranking da OCDE, mas não se apresentam, em grande parte, pesquisas ou dados mais aprofundados para fornecer ao leitor subsídios necessários a uma avaliação desses resultados.

No trato da veiculação de reportagens sobre o PISA, encontramos a seguinte afirmação: A mídia realizou um discurso sobre porque nos artigos os jornalistas nomeiam, produzem explicações, tornam objeto aquilo sobre o que falam [...]. Assim, o jornalista divulga um fato, trazendo para seu texto conhecimentos disseminados popularmente, aplicando sua própria experiência e a experiência de outros, procurando convencer. (PRAZERES, 2009, p. 50, grifo do autor)

Concordamos com essa afirmação em relação à divulgação dos resultados do PISA no Brasil. Há um interesse da mídia, principalmente após a veiculação dos resultados, em divulgar a nota brasileira e compará-la com as de outros países. No momento do anúncio, há uma efervescência de notícias veiculadas geralmente com esse perfil mas que, no decorrer dos dias, não são aprofundadas e investigadas; por isso, são rapidamente esquecidas. É possível comprovar esse dado, por exemplo, com o volume de notícias que é publicado no mês de dezembro, período da divulgação dos resultados do PISA, em relação aos outros meses, em que o programa, quando aparece, é apenas citado como exemplo de que a educação do Brasil vai mal.

Não podemos deixar de salientar que os jornalistas que produzem essas matérias utilizam como fonte os dados oficiais divulgados pelo Inep e pela OCDE, fornecendo ao leitor informações confiáveis do ponto de vista da origem destas. Encontramos, na coleta dos dados, diversas notícias dadas pela imprensa no Brasil que exemplificam o caráter meramente informativo e com foco no ranking, sem qualquer reflexão, salvo exceções que se preocupam em informar sobre o PISA e alguns dados do relatório que apontam justificativas para o baixo desempenho. Na maioria das notícias encontradas, no entanto, a mídia não tenta estabelecer relações entre a situação das escolas, em termos de infraestrutura por exemplo, e o desempenho alcançado pelos estudantes.

Uso indevido 2: posicionamento acrítico em relação aos resultados

A subcategoria de que trataremos nesta seção consiste na análise superficial das médias alcançadas pelos países, no PISA, sem discutir o contexto no qual se encontram cada uma delas. No relatório Health at a glance 2013 (OECD, 2013), apresentado pela OECD, a Coreia do Sul, por exemplo, país que apresenta o melhor desempenho no PISA, vive um grave problema social: apresenta o mais alto índice de suicídio no mundo, alcançando uma média de 33,3 mortes a cada 100.000 habitantes; no Brasil, esse índice é de 5,4 suicídios a cada 100.000 habitantes. Isso indica que os resultados devem ser vistos em perspectiva, a partir do contexto de cada país. É preciso questionar que tipo de formação está sendo pensada para os jovens em cada país avaliado e quais fatores influenciam os resultados do PISA.

Temos, nesse desuso, três posições que discutiremos na sequência: a primeira, de postura pessimista, utiliza a classificação do Brasil nas últimas colocações para alardear que a educação brasileira vai mal, mas não procura investigar os fatores que colocam o país naquela classificação no PISA; a segunda posição, de caráter otimista, usa o crescimento que o Brasil obteve na média, no decorrer dos 16 anos de aplicação do PISA (principalmente em Matemática), para veicular o discurso de que a educação no Brasil vai muito bem, pois somos o país que mais cresceu em comparação aos outros; e a terceira posição, crítica, analisa os resultados e os fatores que influenciam essas médias no contexto brasileiro para, a partir dos fatos, propor ações de melhoria.

A classificação dos países em posições não traz benefícios, sequer promove um debate qualificado, seja quando a divulgação é de caráter pessimista, geralmente divulgada pela mídia, seja quando apresenta caráter otimista, comumente difundida pelo governo. O Inep, nesse sentido, tem se colocado numa posição crítica, pelo menos no que diz respeito aos relatórios divulgados após os resultados, os quais apresentam fatores associados, capazes de influenciar esses resultados (BRASIL, 2010, 2013).

Não podemos nos ater a uma análise superficial se olharmos apenas a posição do país numa lista. É preciso entender o que foi levado em consideração no diagnóstico, quais os fatores que podem influenciar positiva ou negativamente aquele resultado e tentar compreender o contexto no qual se situa esse diagnóstico. É importante observar, por exemplo, que o fraco desempenho do Brasil nesse programa é fruto de diversos fatores relevantes, sendo a defasagem idade-série um deles. Na maioria dos países, alunos de 15 anos concluem um ciclo completo do sistema educacional, o que não ocorre no Brasil, onde há estudantes, nessa faixa etária, que ainda estão no início do ensino fundamental II, na modalidade regular, ou cursando programas específicos para a Educação de Jovens e Adultos.

É superficial alardear que somos o país que apresentou maior crescimento nos resultados do PISA, principalmente no que se refere à Matemática, sem divulgar a real situação da educação brasileira mesmo após esse crescimento - ainda no nível 1 da escala de proficiência -, e sem discutir os ajustes feitos no processo de execução do PISA. Um exemplo disso é que passaram a ser considerados apenas alunos a partir da 7ª série/8º ano do ensino fundamental.

Numa análise crítica, pode-se considerar, por exemplo, que o país cresceu na escala de proficiência paralelamente à universalização do ensino fundamental, o que promoveu a inclusão, nas escolas, de uma parcela da população com nível socioeconômico mais baixo e distorção idade-série. Isso traz consequências socialmente positivas, mas elas provocam impacto negativo nos resultados de proficiência.

Não podemos deixar de ressaltar também um aumento do percentual de alunos em quase todos os níveis de proficiência do PISA, mas, ainda assim, nossos estudantes concentram- se, em sua grande maioria, num nível extremamente baixo dessa escala. A situação é preocupante ao percebermos que cerca de 70% dos alunos brasileiros encontram-se nos níveis 0 ou 1 de proficiência em Matemática, e que há um percentual quase nulo de estudantes nos níveis 5 ou 6.

O que se observa é um esforço do governo para divulgar o crescimento brasileiro a cada avaliação realizada, mas não se diz que esse crescimento levou o país, em nove anos, a alcançar apenas o nível 1 de proficiência em Matemática, resultado semelhante ao obtido em Leitura e Ciências. Ainda assim, esse é um crescimento realmente considerável, se pensarmos que em 2000 e 2003 não alcançamos sequer o valor mínimo de proficiência em Matemática.

Sendo assim, os alunos brasileiros, nas três áreas avaliadas,

[...] são capazes apenas de responder perguntas que apresentem contextos familiares na qual toda a informação relevante está presente e as perguntas estão claramente definidas. São capazes de identificar informações e desenvolver procedimentos rotineiros conforme instruções diretas em situações explícitas. Podem realizar ações que sejam óbvias e segui-las imediatamente a partir de um estímulo dado. (BRASIL, 2006, p. 40)

Diferentemente da comparação apenas da média entre um país e outro, é importante a divulgação dos índices de todos os países para que os pesquisadores possam investigar, nos lugares onde houve um desempenho superior, ações que efetivamente contribuíram para o alcance de melhores índices e replicá-las a partir do estudo da realidade de seu próprio país. É preciso que existam pesquisas de Educação Comparada nas quais se analisem os sistemas de ensino, verificando semelhanças e diferenças - fatores que influenciam os índices - e apontando sugestões de continuidade de ações ou de elaboração de políticas que promovam a melhoria da educação.

Enfim, dentre as três posições apresentadas, defendemos a postura crítica de análise dos resultados do PISA, considerando o contexto de cada país, a partir da investigação dos fatores que influenciam os resultados, e realizando pesquisas cujos relatórios norteiem e auxiliem gestores na tomada de decisões.

Uso indevido 3: resultados não condizentes com a real situação da educação brasileira

Nesta seção, apresentaremos também um desuso referente à definição da amostra, cuja alteração de parâmetros foi nociva por buscar um quadro mais próximo das condições ideais - alunos de 15 anos, cursando o 1º ano do ensino médio. Entendemos que as alterações realizadas nos parâmetros da amostra do PISA, no decorrer desses 16 anos de execução do programa, têm produzido resultados que não são um retrato real da educação brasileira.

Mudanças promovidas pelo Inep e autorizadas pela OCDE, como alteração de datas de aplicação, nivelamento da série da amostra, exclusão de grupos específicos como comunidades rurais, por exemplo, promovem a elevação dos índices, o que não é consequência de melhoria da educação. Apresentamos aqui uma crítica no sentido de que o aumento da média dos estudantes deve ser uma consequência da melhoria da qualidade da educação, e não resultado de adequação da amostra para uma condição que favoreça a elevação dos índices.

Klein (2011), ao fazer uma análise do PISA referente à idade de aplicação da avaliação, aponta elementos determinantes para a não comparabilidade dos resultados entre países e, até mesmo, entre os resultados a cada ano de um mesmo país. Concordamos com o autor quando ele afirma que a escolha do mês de aplicação e o tempo de idade escolar, variável em cada país, alteram significativamente as médias em cada área. No caso do Brasil, alunos de 15 anos que estão na idade-série correta teriam oito anos de escolarização; como a prova é aplicada em maio, os alunos ainda estão no 1º semestre do ano letivo, com poucos conhecimentos relativos à série em que se encontram, o oposto do que ocorre nos países do Hemisfério Norte, nos quais os alunos, em maio, encontram-se ao final do ano letivo, tendo garantido, pelo menos hipoteticamente, as competências daquela série.

Esse mesmo estudo foi levado à OCDE pelo Inep, mas não foi aceito pelos especialistas da organização, como afirmou um dos entrevistados:

Eu não sei se você sabe, mas esse trabalho que o Rubem Klein fez não foi... é... tem um trabalho maior que foi discutido com uma comissão de especialistas da qual o Rubem Klein faz parte, mas não era ele sozinho, e essa discussão já foi levada pra OCDE, né? Os especialistas da OCDE acreditam que não, que é possível comparar sim, então... Então, a OCDE, os especialistas da OCDE acham que não, que é possível comparar. (Gerente A, 2013)

Nesse sentido, o Inep, a partir dos resultados, realizou gestões ao lado da OCDE que permitiram um nivelamento dessa amostra, determinando uma série mínima para a participação na avaliação. Foi estabelecido, então, mais um critério: o limite inferior do 8º ano de curso, aceito pelo consórcio responsável, que passou a ser considerado desde 2006.

Para a OCDE, os estudantes devem ter no mínimo seis anos de escolarização completos, o que corresponde, no Brasil, a alunos cursando o 7º ano em termos de nomenclatura, mas não efetivamente, em virtude de a Lei n. 11.274 ter sido implementada em 2006 − o que implica que só tivemos alunos com seis anos de escolarização cursando o 7º ano a partir de 2013. Em 2012, os alunos que cursavam o 7º ano tinham apenas cinco anos de escolarização completos, o que seria equivalente à 6ª série do ensino fundamental. Nesses casos, houve apenas uma mudança de nomenclatura; em 2015, a situação já estava regularizada.

Não se pode deixar de discutir aqui que essa ação, sem dúvida alguma, promove a melhoria dos resultados brasileiros, mas distorce o real quadro da educação no país. Ora, ao se eleger como um dos objetivos fundamentais da avaliação em larga escala a obtenção de um retrato da educação brasileira (FREITAS, 2009), ao longo de um determinado período, com a exclusão desse grupo de alunos de 15 anos, é possível notar que ocorrem distorções. Além disso, a existência de uma amostra que não é fiel ao panorama educacional diminui a possibilidade dessa parcela da população excluída ser alvo de ações efetivas a serem definidas pelos gestores. Ao fazer tal nivelamento, o Brasil melhora seus resultados e sobe posições no ranking PISA, mas perde-se a qualidade dos indicadores, uma vez que eles passam a retratar uma situação mais próxima da ideal, e não a realidade, que tanto carece de intervenções pautadas por diagnósticos bem realizados.

Podemos observar que, no Brasil, em 2012, por exemplo, o universo de estudantes que estavam aptos a fazer parte da amostra PISA era de aproximadamente 73%, com um intervalo considerável entre os estados com menor e maior percentuais − Alagoas (48,3%) e São Paulo (86,4%), respectivamente. Temos, então, em média, 30% da população com a idade adequada, mas que não atinge os critérios mínimos para compor a amostra, seja em função da sua localização geográfica,2 seja em função da série em que se encontra.

Há ainda uma polêmica entre os especialistas (FRANCO, 2002; SOARES, 2013; SOUZA, 2010) de que o crescimento nos resultados ocorreu em virtude de três fatores: melhorias das condições socioeconômicas da população brasileira; mudanças na elaboração dos testes com a inclusão de questões mais fáceis em cada nível de proficiência; e a exclusão dos resultados de alunos da zona rural a partir de 2012. Até o momento, no entanto, não há um estudo publicado sobre esses fatores.

Não uso 1: não replicabilidade das condições das escolas federais

Um outro desuso do PISA no Brasil está relacionado com os resultados divulgados pela esfera administrativa. Segundo os dados apresentados em 2010, por exemplo, os alunos oriundos do ensino público federal têm apresentado melhor desempenho que os estudantes de escolas privadas (variando entre 20 e 40 pontos na escala de proficiência em todas as áreas avaliadas e que se repete em todas as edições do PISA, inclusive na última aplicação, em 2015), as quais, no Brasil, possuem perfil econômico mais favorável que as da rede pública.

Em estudo já realizado, Franco (2002) constatou que os resultados de grupos considerados da elite, no Brasil, no que diz respeito ao perfil socioeconômico, não indicaram melhor desempenho ou desempenho semelhante aos dos alunos de outros países em desenvolvimento. O resultado continuou colocando o país em último lugar no ranking PISA, mostrando que, mesmo nas escolas consideradas de maior qualidade, em termos de ensino, ainda não se alcança o patamar de outros países.

Ao se observarem os resultados, inicialmente alguns fatores podem ser apontados para o bom desempenho das escolas federais, como a seleção para ingresso dos alunos e a superioridade dos recursos recebidos em relação às escolas em outras esferas e gestões. No entanto, uma constatação faz cair por terra essa avaliação superficial: muitas escolas privadas também fazem seleção para a entrada de alunos, além de possuírem recursos financeiros equiparáveis às unidades federais e uma gestão focada principalmente no desempenho.

Em um estudo nacional realizado para o Inep sobre a qualidade na educação e a relação custo-aluno-qualidade da educação básica, Verhine (2006) indica uma série de fatores que fornecem pistas para o bom rendimento escolar dos alunos nas escolas federais em comparação com as escolas públicas municipais e estaduais, a saber: média de alunos por turma; situação funcional; formação dos professores; média salarial e tempo dedicado à escola pelos docentes; média de recursos recebidos por aluno; e custo de cada estudante para a instituição.

Tomando como base as informações apresentadas no Portal Brasileiro de Dados Abertos, a média de alunos por turma na esfera federal é inferior à das escolas estaduais e equipara-se à das escolas particulares, em dados de 2007 a 2010. Comparando-se os dados dessas duas publicações, é possível perceber que as escolas municipais possuíam média inferior de alunos até o ano de 2006 porque foram levadas em consideração as escolas da zona rural e o ensino fundamental I. Ao se observarem os dados mais recentes, constata- -se que essa média é superada pelas escolas federais, que não excedem em cinco alunos por turma em relação às escolas particulares.

A situação dos docentes, analisada em vários aspectos, parece ser determinante para o desempenho superior das escolas federais. Já é senso comum que as escolas públicas brasileiras têm, em seu quadro docente, um grande número de professores com contrato temporário, estagiários remunerados e não remunerados, além de voluntários exercendo trabalho sistemático. No relatório mencionado, verificou-se que uma das escolas não contava sequer com um professor efetivo. Ora, é quase impossível uma escola alcançar benefícios educacionais quando não há um grupo de trabalho que se dedique e a rotatividade de profissionais é constante, os quais, muitas vezes, não têm licenciatura na área em que atuam.

Considerando-se apenas os profissionais efetivos, a média salarial dos professores das escolas federais é muito superior, chegando a uma diferença de quase 600% em alguns casos (VERHINE, 2006). Ao se compararem os salários desses profissionais com a média nacional de ganho dos professores da rede particular, verifica-se uma diferença de aproximadamente 11%, o que, mais uma vez, mostra que as escolas federais saem na frente nesse quesito.

Quando o tema passa a ser a qualificação dos docentes e o percentual desses profissionais que atuam em uma única escola, os dados são ainda mais relevantes: 100% dos professores das escolas federais têm licenciatura e/ou pós-graduação e aproximadamente 95% deles atuam somente em uma escola. Nas redes municipais e estaduais, esses índices caem para cerca de 80% nas duas categorias, sendo que a qualificação dos profissionais da rede municipal com licenciatura e/ ou pós-graduação tem índice próximo a 66%. Segundo o Inep (2010), na rede particular, há um percentual ainda maior de professores que atuam em mais de uma instituição, e é grande o número dos que trabalham nas redes estadual e municipal.

Quanto aos investimentos, os dados mostram que, anualmente, a rede municipal investe, em média, R$ 1.500,00 por aluno; a rede estadual aproximadamente R$ 2.700,00, ao passo que, na esfera particular, há um investimento feito pelas famílias de R$ 10.500,00. Quando se considera a esfera federal, o valor, que era de aproximadamente R$ 12.000,00 em 2008, sofreu uma queda de 15 pontos percentuais em 2010, em função da ampliação das vagas nas redes federais (PINTO; AMARAL; CASTRO, 2011). Assim, mesmo com a constatação de que os alunos brasileiros das escolas federais alcançam melhores índices, não se percebe claramente o que é feito com esses resultados em termos de políticas públicas que visam à melhoria da educação básica nas redes municipal e estadual. Isso não quer dizer que elas não sejam implementadas, mas não se mostra nem se promove a articulação entre os resultados divulgados e as ações de melhoria.

Nesse sentido, é possível afirmar que a não replicabilidade de fatores nas outras esferas públicas, como ocorre nas escolas federais, consiste em um desuso dos resultados do PISA no Brasil.

Não uso 2: socialização e discussão incipiente dos resultados do PISA entre os gestores nos diversos níveis

Outro desuso consiste no fato de a socialização dos resultados do PISA não alcançar os gestores nos diversos níveis do sistema de ensino. E aqui temos duas discussões a fazer: a primeira referente ao papel do Inep no processo da avaliação e a segunda, da função desempenhada pelos gestores na discussão dos resultados e na implementação de ações. Quanto à primeira discussão, uma das questões surgidas nas entrevistas diz respeito ao entendimento do papel de quem executa o PISA no Brasil. Indagados sobre a importância dos resultados do programa e o uso que se faz desses resultados, os gestores entrevistados apontaram que o papel do Inep consiste apenas em executar um diagnóstico:

A execução de políticas públicas é de responsabilidade do MEC e não do Inep, não me sinto habilitado para responder a essa questão [...]. O Inep é responsável pela avaliação; a política educacional é de responsabilidade do MEC. Não cabe a mim responder a esse item. (Gerente B, 2013)

Essa perspectiva coloca o Inep como executor dos diagnósticos, concepção que vai de encontro ao que defendemos neste trabalho, já que nos pautamos por uma definição de avaliação pensada como um processo de participação coletiva, principalmente no que diz respeito ao uso que poderá ser feito com os resultados obtidos. É necessário que haja, mesmo em uma avaliação como o PISA, de caráter internacional, um trabalho conjunto, participativo entre as instâncias de execução de diagnóstico e de execução de políticas educacionais.

Salientamos que o desejo de uma maior participação nas negociações e nas tomadas de decisão, a partir do diagnóstico, ou seja, da avaliação, pode ser percebido nas entrelinhas dos relatórios, de forma sutil, por meio de uma série de sugestões sobre possíveis encaminhamentos dos resultados. Um exemplo disso pode ser observado no relatório do PISA 2012, quando se tratou dos dados de repetência:

Como consequência da repetência, observa-se que aqueles estados com índice mais alto são também os que registram maior concentração de estudantes no Ensino Fundamental [...]. Mesmo com taxas de repetência elevadas, os estados do Acre e de Santa Catarina conseguem manter maior porcentagem de estudantes no Ensino Médio do que outros estados com taxas de repetência semelhantes, como Distrito Federal, Tocantins e Espírito Santo. Talvez seja interessante observar as experiências desses dois estados em relação a políticas de correção de fluxo que conseguem promover o estudante repetente para a série correta de estudo. (Inep, 2013, p. 56, grifo nosso)

Mesmo com relatórios públicos e cópias enviadas a todas as secretarias, segundo afirmam os gestores do Inep nas entrevistas, a análise e a utilização de dados dos relatórios são reconhecidas como dificuldades do programa:

Na verdade, o indicador de utilização maior que a gente tem é o Ideb; então, o PISA entra, mas, enfim, não como uma... como é que pode se dizer? Ele é analisado pela CAV [Coordenação de Avaliação], mas o indicador maior utilizado é o Ideb, né? A gente obviamente utiliza as avaliações como critério de definição de projetos de programas, né, para a melhoria da qualidade, mas, enfim, os indicadores que a gente trabalha com maior... é... digamos assim, no cotidiano das nossas ações nas escolas, é o Ideb e o Avalie.3 (Coordenação A, 2013)

Essa fala sugere a ausência de articulação entre gestores, avaliadores e professores, revelando a fragilidade existente na disseminação e na reflexão dos resultados que se apresentam, além de apontar a questão da forma como os resultados são apresentados. O gestor não consegue articular sua realidade com o conhecimento efetivo das causas e consequências dessa mesma realidade por meio dos dados que lhe são fornecidos pelas avaliações e pesquisas. Como implicação, faltam, para esse gestor, algumas competências capazes de auxiliá-lo na tomada de decisões necessárias para promover a melhoria das condições de sua sala de aula, de sua escola e do sistema de ensino ao qual pertence.

É importante aqui refletir sobre a necessidade de formação que permita aos gestores a apropriação do que está posto nos relatórios, o desenvolvimento de competências para leitura e discussão dos resultados apresentados para que, a partir disso, sugiram ações capazes de promover a melhoria de seu sistema de ensino, de sua escola e de sua sala de aula. Faltam ações mais específicas no sentido de os gestores de ensino se apropriarem dos resultados do PISA e de seus conceitos para avaliar de que maneira essas informações podem e devem ser utilizadas como forma de repensar e refletir sobre a dinâmica escolar.

As sugestões de ações que poderiam ser implementadas por gestores para melhoria da qualidade da educação e de seus índices, indicadas em Uso direto 2, não foram sequer levantadas como passíveis de serem adotadas como estratégia de promoção da qualificação do sistema de ensino. Tais ações podem ser efetivadas pelos gestores em todos os níveis (gestores dos sistemas, das escolas, da sala de aula), considerando, pois, que essas ações são tanto de cunho administrativo quanto pedagógico. Para isso, é necessário que o diagnóstico realizado seja apenas uma parte da avaliação, a que fornece o retrato do sistema. Assim, esses gestores poderiam se apropriar do processo e dos resultados, refletir, trocar experiências e promover o debate que qualificará as decisões tomadas para a melhoria da educação.

Não uso 3: ausência de discussão pedagógica dos resultados do PISA

O desuso que agora apontamos é o não uso dos resultados do PISA para a promoção de reflexões no âmbito pedagógico. Os relatórios nacionais trazem, além dos resultados, uma discussão conceitual sobre as concepções que permeiam o programa e que servem de base para a elaboração e correção dos itens, em todas as áreas de conhecimento avaliadas.

Um exemplo que podemos citar e que está indicado no relatório de 2000 (BRASIL, 2001) é o da dificuldade que o aluno brasileiro tem de responder exclusivamente àquilo que lhe foi perguntado, de forma objetiva. Ele tende a dar respostas pautadas pelo que supõe, e não segundo o que foi questionado. Esse é um problema que reflete dificuldades em leitura e interpretação de textos simples e que resulta no baixo desempenho nas outras áreas avaliadas, principalmente em Linguagem. Isso aponta para um problema que interfere em todas as áreas de conhecimento e que poderia ser temática de projetos de intervenção com os alunos.

As entrevistas realizadas com gestores dos sistemas de ensino indicaram a dificuldade de entendimento dos dados dos relatórios, os quais não chegam aos professores, em função tanto da ausência de profissionais que possam utilizar as informações contidas nos relatórios quanto do desconhecimento dos professores em relação ao PISA. Esses fatos são indicadores suficientes para inferir que não ocorrem discussões pedagógicas a partir dos resultados do PISA no Brasil.

Cabe aos gestores, de posse desses resultados, realizar discussões, utilizando, por exemplo, os espaços destinados a questões pedagógicas, como jornadas pedagógicas e reuniões de coordenação, para auxiliar no planejamento de ensino com o objetivo de melhorar a qualidade da educação. Essa articulação só pode acontecer de forma mais efetiva no nível dos municípios e das escolas, aspecto que constitui um ponto de convergência entre esta pesquisa e os trabalhos de diversos autores (AFONSO, 2001; SCHIMITZ; TENÓRIO; ALMEIDA, 2011; SOUSA, 2000). A avaliação em larga escala é tida como necessária para o fornecimento de uma imagem do sistema (FREITAS, 2009) por meio de indicadores que permitam perceber falhas, excessos e acertos, na tentativa de definir políticas públicas nacionais e estabelecer diretrizes para acompanhamento e alcance de metas. Nesse sentido, as decisões tomadas pelos gestores dos sistemas de ensino refletem-se nas escolas por meio de políticas de formação de professores, organização do sistema, currículo e recursos.

Não uso 4: ausência de políticas públicas advindas dos resultados do PISA

O último desuso que discutiremos consiste no não uso dos resultados do PISA para elaboração de políticas públicas. Ao analisar os documentos oficiais das diversas políticas públicas implementadas por órgãos ligados à educação do governo federal, MEC, Capes e CNPq, nos últimos 16 anos, só foi possível encontrar uma referência aos resultados do PISA no Relatório de Gestão da Diretoria de Educação Básica da Capes, a qual foi discutida na seção Uso direto 1, como um dos usos diretos encontrados.

Analisamos diversos documentos vinculados às políticas públicas: para implantação ou melhoria da alfabetização (Pacto pela Alfabetização na Idade Certa); de formação inicial e continuada de professores − Plano Nacional de Formação de Professores da Educação Básica (Parfor), Programa da Consolidação das Licenciaturas (Prodocencia), Programa Institucional de Bolsas de Iniciação à Docência (Pibid), Programa Observatório da Educação (Obeduc), Programa de Apoio a Laboratórios Interdisciplinares de Formação de Educadores (Life), Programa Novos Talentos -; de educação integral − Mais Educação -; e de ensino médio − Pacto para Fortalecimento do Ensino Médio. Tais documentos foram elaborados para os mais diversos objetivos, como a criação de programas, editais, relatórios, resoluções, mas em nenhum deles foi possível encontrar uma única referência ao PISA ou a seus resultados, ao desempenho brasileiro ou, ainda, à existência de uma avaliação internacional.

A questão principal, segundo essa constatação, é a de que não se percebe claramente como são usados os resultados ou se são minimamente utilizados como justificativa, em termos de políticas públicas, para a melhoria da educação básica, o que não mostra uma gestão responsável, considerando-se o diagnóstico apresentado. Se pensarmos nas políticas já implementadas, temos, por exemplo, o Programa Novos Talentos, que vincula ações de professores e estudantes universitários com alunos da educação básica, cujo objetivo é

Apoiar propostas para realização de atividades extracurriculares para professores e alunos da educação básica, tais como cursos e oficinas, visando à disseminação do conhecimento científico, ao aprimoramento e à atualização do público-alvo e à melhoria do ensino de ciências nas escolas públicas do país. (BRASIL, 2014)

Uma política que trabalha com jovens das escolas públicas tem estreita relação com os resultados de um programa que avalia esses estudantes contemplados nos projetos aprovados. Não podemos afirmar que os resultados do PISA não foram levados em consideração, mas isso não aparece em qualquer texto analisado, sugerindo ausência de articulação entre o diagnóstico e as ações que poderão promover a melhoria da qualidade da educação. Além disso, a não percepção do uso dos resultados do PISA na elaboração de políticas públicas pode indicar, mais uma vez, a ausência de articulação entre aqueles que produzem o diagnóstico e os gestores que elaboram essas políticas. Isso sugere também uma ausência de mobilização desses profissionais em relação ao entendimento dos resultados e dos fatores que neles interferem.

Em suma, temos um programa cuja aplicação acontece há 16 anos, com um custo considerável para os cofres públicos, e cujos resultados são divulgados publicamente. No entanto, eles apresentam uma série de desusos que implicam tornar o PISA um diagnóstico e não uma avaliação, segundo a nossa concepção, por não promover reflexões para as tomadas de decisão que visam à melhoria do processo educacional.

Considerações Finais

As melhorias promovidas na educação nos últimos anos (universalização do ensino fundamental, políticas públicas para a formação docente, aumento de financiamento para a educação) têm sua elaboração justificada, de forma genérica, pelos gestores brasileiros por conta dos resultados de avaliações em larga escala. Mas não há, em qualquer documento pesquisado, uma ligação, uma relação entre os resultados do PISA e a implementação de uma política pública.

A primeira contribuição desta pesquisa é reforçar o conceito de que a avaliação é um processo constituído não apenas por um diagnóstico, mas que envolve mais duas dimensões: tomada de decisão (dimensão política) e melhoria do processo (dimensão social). Outra implicação consiste em afirmar que a avaliação possui usos que são diretos, como consequência dos resultados do diagnóstico, mas também usos indiretos, que emanam da metodologia de trabalho, da execução da pesquisa e do corpo teórico que a embasa. Além disso, ao apontar os desusos, estamos também indicando e sugerindo usos que podem ser feitos dos resultados do PISA no Brasil.

Da perspectiva aqui adotada, nota-se que a dificuldade apresentada pelos gestores brasileiros consiste no uso dos resultados das avaliações. Um dos objetivos principais dos exames em larga escala é fornecer aos gestores um diagnóstico da realidade educacional dos seus sistemas de ensino, de modo que eles utilizem esses resultados para rever e repensar ações em conjunto com a comunidade envolvida.

A avaliação concebida como instrumento de controle ou ferramenta ignorada pela comunidade - gestores, professores, academia - pouco contribui para a melhoria do ensino (SOUZA, 2002). Segundo Becker (2012, p. 3), “a avaliação não é um fim em si mesmo, mas um instrumento que deve ser utilizado para corrigir rumos e pensar o futuro”. Portanto, é necessário pensar os resultados a partir dos contextos social, político e econômico nos quais a população está inserida.

O que se tem visto até o momento, efetivamente, é a responsabilização apenas do professor e do aluno pelos baixos resultados das avaliações. A ideia de responsabilização e mobilização da sociedade, “sobretudo da classe política”, tem sido transferida e retratada como culpabilização, e a forma encontrada pelos gestores de sistemas para minimizar as deficiências consiste na implementação da meritocracia e em políticas de bonificação a partir dos resultados das avaliações, principalmente da elevação do Ideb (ARAÚJO FILHO, s.d.). As questões de estrutura física das escolas, condições de trabalho, salário, gestores nomeados por interesses políticos, ausência de plano de carreira, situações de risco dos estudantes e professores, além dos indicadores econômicos e sociais, parecem estar sempre em segundo plano nos discursos políticos (CALDERANO; BARBACOVI; PEREIRA, 2013).

No Brasil, são necessárias a criação e a efetivação de ações e instrumentos que promovam melhorias na qualidade da educação a partir dos resultados de avaliações na perspectiva de participação e sustentabilidade aqui defendida. Isso tem sido feito, ainda que de forma tímida e individual, por grupos de pesquisa comprometidos com a qualidade de ensino. No caso do PISA, um diagnóstico de qualidade que tem a cada edição um alto custo financeiro para o país (cerca de R$2.000.000,00), é inadmissível que seus resultados sejam vistos apenas como mais uma comprovação de que a educação brasileira vai mal. Um dos problemas relacionados com o desuso dos resultados brasileiros do PISA refere-se à sua implementação, seus objetivos e o interesse do país em participar de tal avaliação. Não podemos deixar de mencionar que a entrada do Brasil no PISA ocorreu dentro de um contexto político em que havia, na época, o interesse brasileiro em ser membro da OCDE. Participar do PISA, então, parece-nos ter sido um meio que justificava os fins.

Mais uma vez, os fatos apresentados sugerem que não há interesse efetivo de transformar o PISA em uma avaliação, mas sim que ele continue a ser um diagnóstico realizado para satisfazer os interesses do país e da OCDE em termos de participação e acesso às políticas da organização, sem a necessidade de seguir seus protocolos por não ser um país membro. Sendo assim, na perspectiva da educação brasileira, o estudo aqui apresentado aponta que o PISA continuará sendo mais um programa, mais um elemento da equação, no qual se afirma que a educação no país vai mal e que, para esse problema, não é possível apresentar solução.

Feitas essas considerações, esperamos que os resultados desta pesquisa possam contribuir para o debate em Avaliação Educacional, fomentando novas pesquisas e, principalmente, colaborando para promover o uso dos resultados do PISA no Brasil, na busca de melhorias para a educação de nosso país.